Test: POV GeForce GTX 280

Grafikkort, NVIDIA d. 22. juni. 2008, skrevet af Goaguy 82 Kommentarer. Vist: 32502 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Point of View

DK distributør: Fourcom

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Point of View

DK distributør: Fourcom

#1

GIEF PRIS NED! 😲

sparker da okay røv det kort der 😉

men prisen er way too high ☹

sparker da okay røv det kort der 😉

men prisen er way too high ☹

#2

#1 Ja, synes heller ikke det er værd, at bruge de penge på det. :no: Ydelsen er der, men prisen er helt forkert. Vente og ser hvad ATI byder på, selvom jeg ikke skal have nyt GFX. 😀

#3

Det er ret vildt at det som et kort med 1 GPU kan slå et fra den gamle serie med 2 GPU'er. Springet til den nye serie er ikke lige så stort som fra 7xxx -> 8xxxx, men jeg synes ikke det er noget at være skuffet over som mange har været.

Man skal jo tænke på at det her kort med bare 1 GPU kan slå et af de gamle med 2 GPU'er, så jeg synes bestemt det er et fint resultat.

Jeg synes det er mærkeligt at nogle er overraskede over prisen. Det er jo normalt at helt nye topkort koster over 4k. Det gjorde 7900gtx og 8800gtx også i sin tid. Det er ikke bang-for-the-buck, men det er top-notch, og det koster desværre.

Man skal jo tænke på at det her kort med bare 1 GPU kan slå et af de gamle med 2 GPU'er, så jeg synes bestemt det er et fint resultat.

Jeg synes det er mærkeligt at nogle er overraskede over prisen. Det er jo normalt at helt nye topkort koster over 4k. Det gjorde 7900gtx og 8800gtx også i sin tid. Det er ikke bang-for-the-buck, men det er top-notch, og det koster desværre.

#4

er det kun mig der undres over crysis resultaterne, medium settings hvorfor ikke very high?? og resultater på 7000 FPS, hmm tror der er en lille fejl i den graf 🙂

#5

#3 Det er også rigtigt fint, men pris forskellen på dette kort og GX2 er omkring 1000kr, og så meget mere yder 280 heller ikke til prisen er retfærdig gjordt. Men fedt kort det er det da. 😎

#4 Er det ikke very high?? Det skal da max testes i det spil!

#4 Er det ikke very high?? Det skal da max testes i det spil!

#6

#5 ifølge grafen er det medium settings

#7

Vi har kun haft kortet i to dage - derfor kun gansk få benchmark, men nVIDIA har lovet vi kan låne det ugen ud og så ser vi om der ikke er en opdatering på vej...

The Boss

The Boss

#8

Som #3 skriver så er prisen uinteressant GF10, bliver først interessant når der kommer afløsere til 8800gt/gts og 9800gtx, mon GF10 260 er det kort?

Iøvrigt imponerende i er kommet så tidligt ud med en test af kortet! Onkel Tom er kun lige kommet med deres test, så videre til næste side..........

Iøvrigt imponerende i er kommet så tidligt ud med en test af kortet! Onkel Tom er kun lige kommet med deres test, så videre til næste side..........

#9

er jeg den eneste der undre mig over en average fps på flere tusinde ? o_O

#10

Det må da vist om nødvendigt være mit nye GFX, altefter hvad AMD præsterer... Mit 8800GTX er snart modent til pension 🙂

MVH.

Toke 🙂

MVH.

Toke 🙂

#11

folk der køber et kort til så mange penge der har altså alt for mange penge. man kan jo købe en middel (stadig god) gamer pc for de penge. 😐

#12

#11 Det kommer simpelthen an på hvad dine krav er til din PC... For mig handler det om, at jeg skal kunne spille nye spil som producenten ville have de skulle spilles, og det kræver altså en vis investering... Derudover vil jeg hellere købe et dyrt GFX hvert andet år, end et middel-dyrt GFX hvert år 😉

(Det har indtil videre virket med mit 8800GTX, jeg dog først købte i september 2007, fordi jeg var langsom 😛 )...

MVH.

Toke 🙂

(Det har indtil videre virket med mit 8800GTX, jeg dog først købte i september 2007, fordi jeg var langsom 😛 )...

MVH.

Toke 🙂

#13

God test, og fedt kort jo 🙂

#14

#4 Ja, det må være en fejl i grafen. Jeg vil tro, at det er det antal frames den nåede at køre igennem over hele testen, men det må vi lige have Goa til at bekræfte.

#15

#12 nu ved jeg jo ikke hvor gammel du er 😛 men jeg synes bare et eller andet sted, at der må være noget andet man kan bruge 4300 på. man kunne bruge 2k på gfx og så 2300 på eksempelvis andre nødvendige ting som udgifter til mad, tøj osv. 🙂

synes bare det er mange penge, men igen, hvis jeg selv havde haft så mange tilovers havde jeg sku os købt sådan et gfx ! 😉

synes bare det er mange penge, men igen, hvis jeg selv havde haft så mange tilovers havde jeg sku os købt sådan et gfx ! 😉

#16

Jeg synes det er en lidt upræcis og biased test hvor det virker som om man gerne vil have 280 GTX til at være hurtigere end det egentlig er. Som Anandtechs væsentligt grundigere test viser, er 9800 GX2 faktisk hurtigere end GTX 280 i stort set alle sammenhænge, hvorfor de også har svært ved at anbefale at man køber kortet. GTX 280 koster jo også omkring 4600, og 9800 GX2 lidt under 3200. For mig at se er spørgsmålet nu mest om man skal tage et 9800 GX2 billigt, eller vente på AMDs Radeon 4870 X2 og se hvad sådan et par kan i CrossFire...

Anandtechs review: http://www.anandtech.com/video...

Anandtechs review: http://www.anandtech.com/video...

#17

#16 Det kan naturligvis også være fordi Anandtech gerne vil pille NVIDIA lidt ned, og derfor ikke har fuld spark på alle heste, for jeg kan GARANTERE at der ikke er gjort noget for at forbedre resultaterne for GTX 280 ifht. de ældre kort... 😉

Det har højst sandsynligvis noget at gøre med, at der er forskel på de to test-setups der er brugt (CPU/RAM/MOBO kan have forskellige indstillinger).

Derudover er der stadig problemerne med hvorvidt en dual-chip løsning er optimal (noget den overhovedet ikke er i mit hoved :sleep: ), og som sagt, hvad kravene til ens HW er (om man f.eks. har plads/PSU til et dual-GPU setup af nogen art)...

#15 Jeg er 19 og nyudnævnt konstabel-elev i forsvaret, så det er ikke fordi jeg svømmer i overskydende indkomst 😉

MVH.

Toke 🙂

Det har højst sandsynligvis noget at gøre med, at der er forskel på de to test-setups der er brugt (CPU/RAM/MOBO kan have forskellige indstillinger).

Derudover er der stadig problemerne med hvorvidt en dual-chip løsning er optimal (noget den overhovedet ikke er i mit hoved :sleep: ), og som sagt, hvad kravene til ens HW er (om man f.eks. har plads/PSU til et dual-GPU setup af nogen art)...

#15 Jeg er 19 og nyudnævnt konstabel-elev i forsvaret, så det er ikke fordi jeg svømmer i overskydende indkomst 😉

MVH.

Toke 🙂

#18

#17 Tomshardware giver også et helt andet blik end her:

http://www.tomshardware.com/re...

jeg blir os 19 her på fredag og er igang med at uddanne mig, lever på su, så derfor synes jeg det er en del penge. 😛

http://www.tomshardware.com/re...

jeg blir os 19 her på fredag og er igang med at uddanne mig, lever på su, så derfor synes jeg det er en del penge. 😛

#19

jeg må indrømme jeg er osse kommet i tvivl har lige nu et 8800 gtx synes i det hele taget det er temmelig forvirrende det her.

en test siget et en andet noget andet o.s.v

en test siget et en andet noget andet o.s.v

#20

#18 "Vores" test her på siden, har 300Mhz mere at rykke rundt med på CPU'en, hvilket godt kan have noget at sige, når resultaterne ligger så tæt som de gør... Samtidig kan forskellige drivere have noget at sige...

I mit hoved ligger GTX 280 side om side med de tidligere dual-løsninger, og det er godt nok til mig 😉

I mit hoved ligger GTX 280 side om side med de tidligere dual-løsninger, og det er godt nok til mig 😉

#21

hehe godt man skal til usa om et par uger og kan smide et GTX280 i kurven til (kun) 600 USD 😎 men det falder nok hurtigt i pris 🙂

#22

#18 Tjek www.kortlink.dk - der er problemer med kommaer i links her på sitet.

EDIT: Linket bliver så til: http://kortlink.dk/tomshardwar...

EDIT: Linket bliver så til: http://kortlink.dk/tomshardwar...

#23

jeg har lige fået et chok så den test på toms hardwareguide hvad sker der lige i fsx et 8800 ultra slår et gtx 280 er det en joke eller hvad.jeg er rystet tror squ jeg beholder mit 8800 gtx

#24

Tror jeg vil snuppe sådan tre til noget SLI 😀

#25

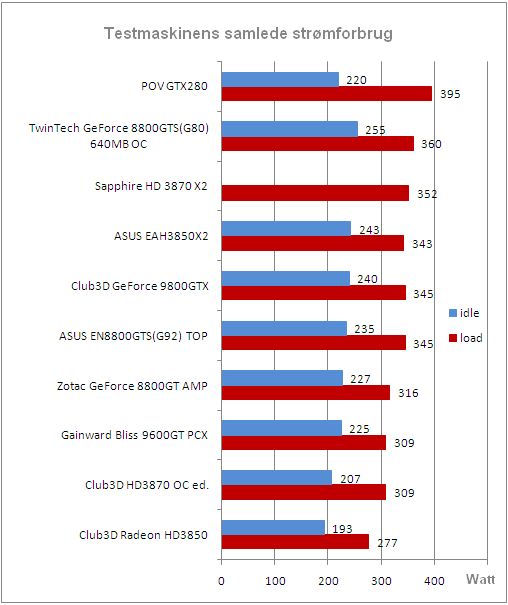

kan være jeg har overset det men hvad bruer det i idle alser ikke i load kan være jeg har overset det 🙂

#26

Holy smackerony! Det holder 100 det kort :) Er dog glad for at se at 9800GTX SLI stadig er godt med 😀 Så behøver jeg ikke smide dem ud lige med det samme hehe...

Mvh. Henrik

Hvis man vil se hvad 3 af de der basser kani SLI på et 790i board, så læs nyheden/tråden om kingpin's LN2 sjov.

Mvh. Henrik

Hvis man vil se hvad 3 af de der basser kani SLI på et 790i board, så læs nyheden/tråden om kingpin's LN2 sjov.

#27

Guru3d er også ude med et rigtigt spændende review af 280: http://www.guru3d.com/article/...

Jeg er ikke varm på strømforbruget, men for dælen hvor er det dog rart at se at Nvidia ENDELIG har taget det lidt alvorligt alligevel, og indført en del forskellige sparefiduser til kortet. About time, men til gengæld tilsyneladende også ganske gennemtænkt.

Egentlig ville man vel ha forventet at et kort der har været så meget hype om, havde givet selv 9800gx2 baghjul så det gjorde noget, men at lige sådan ungefär lige, er nu heller ikke så tosset imo. 280 har 1gb ram og en temmelig stærk kerne, så selv uden dx10.1, skulle man mene at der var grafikkort til et stykke tid der.

Jeg skal ikke ha et. Min økonomi og min foragt for storslugerne forhindrer det. Men indrømmet, det ser spændende ud. Nu mangler vi så at se hvad ATI smider på gaden. Rart at se en reel forskel i ydelse, fremfor de sidste ganges "different name, same shit".

Jeg er ikke varm på strømforbruget, men for dælen hvor er det dog rart at se at Nvidia ENDELIG har taget det lidt alvorligt alligevel, og indført en del forskellige sparefiduser til kortet. About time, men til gengæld tilsyneladende også ganske gennemtænkt.

Egentlig ville man vel ha forventet at et kort der har været så meget hype om, havde givet selv 9800gx2 baghjul så det gjorde noget, men at lige sådan ungefär lige, er nu heller ikke så tosset imo. 280 har 1gb ram og en temmelig stærk kerne, så selv uden dx10.1, skulle man mene at der var grafikkort til et stykke tid der.

Jeg skal ikke ha et. Min økonomi og min foragt for storslugerne forhindrer det. Men indrømmet, det ser spændende ud. Nu mangler vi så at se hvad ATI smider på gaden. Rart at se en reel forskel i ydelse, fremfor de sidste ganges "different name, same shit".

#28

#24

Ja man skulle da være et skarn hvis man ikke lige kunne bruge 3 stk. 😲

Ja man skulle da være et skarn hvis man ikke lige kunne bruge 3 stk. 😲

Grunden til at Crysis viser flere tusinde fps er at når der køres over 3loops flytter programmet komma 2pladser bagud, så hvis der står 5587.2 fps, er det 55.872 fps istedet. Så det er skam bare en lille bug.

*Edit*

Nå jeg er da vist på den forkerte bruger :)

/noxon

*Edit*

Nå jeg er da vist på den forkerte bruger :)

/noxon

#30

#29 Mit 7600Gt kører eller let med 6000 fps i Crysis 🤣

#31

Selvfølgelig er der ikke fusket med noget som helst. Jeg synes ærgelig talt, at man bør tænke sig om, inden man slynger om sig, med så alvorlige påstande.

Tænk på, at der er brugt forskellige testsetups, der er testet i forskellige ting, og så er der sikkert også brugt en anden driver; alt dette medvirker til, at du på ingen måde kan sammenligne 2 tests.

Kortets ydelse stemmer i øvrigt fint overens med hvad jeg har set på TheINQ og andre steder. Og hvis der er nogen der er uafhængige af NVidia, er det da dem. :yes:

->#25

Det bruger 236W under load.

http://hwt.dk/literaturedetail...

Tænk på, at der er brugt forskellige testsetups, der er testet i forskellige ting, og så er der sikkert også brugt en anden driver; alt dette medvirker til, at du på ingen måde kan sammenligne 2 tests.

Kortets ydelse stemmer i øvrigt fint overens med hvad jeg har set på TheINQ og andre steder. Og hvis der er nogen der er uafhængige af NVidia, er det da dem. :yes:

->#25

Det bruger 236W under load.

http://hwt.dk/literaturedetail...

#32

Kan kun konstatere at det ikke kan betale sig at skifte sit 8800GTX/Ultra ud endnu. Havde nok forventet lidt mere her.

#33

Det er lidt skuffende til prisen m.m.

Håber ati får noget medvind p.g.a. det...

Håber ati får noget medvind p.g.a. det...

#34

GeForce 9800GX2 kortet banker gladeligt videre her. Det føler sig langt fra truet 😀

Igen ser man bare at 3Dmark (vantage) intet siger om kortets ydeevne i spil - meget høje scores men intet at have det i.

Igen ser man bare at 3Dmark (vantage) intet siger om kortets ydeevne i spil - meget høje scores men intet at have det i.

#35

31# ja men jeg mente i ild alser når den ikke er i load

#36

Nu har jeg siddet og læst lidt om GTX280 og GTX260 i div. anmeldelser, og magen til ringe selv kritik skal man ikke lede længe efter. Hvor de fleste skriver at 9800GX2 er en konkurrent til GTX280 så betoner alle de "problemer" der er med SLi, f.eks varme, mere strøm forbrug, cloned memory... så 9800GX2 skal man ikke tage.

Men så senere så skriver de, at folk nok vil tage GTX260 da det koster det halve og så kan man køre billig SLi ! - HALLLOOOOO - så er vi jo tilbage til 0. - dvs man sidder og "svinger 9800GX2" løsningen til, men senere henne i anmeldelserne anbefaler man det samme bare med nyere kort - klaphatte til anmeldere.

Men så senere så skriver de, at folk nok vil tage GTX260 da det koster det halve og så kan man køre billig SLi ! - HALLLOOOOO - så er vi jo tilbage til 0. - dvs man sidder og "svinger 9800GX2" løsningen til, men senere henne i anmeldelserne anbefaler man det samme bare med nyere kort - klaphatte til anmeldere.

#37

#32 Jeg tror heller ikke kortet er møntet på at du skal skifte dit kort ud, for det får du vitterligt ikke det store ud af; da får du mere ud af at investere i et ekstra 8800.

Men for den skare der pt. skal ud og investere i fx Nehalem-platformen, der jo lover meget bedre cpu-performance - hvilket i høj grad ligner noget både ATI's og Nvidia's nye grafikløsninger lider af - og for dem der finder det interessant at investere i kortet med henblik på en senere opgradering til SLI (for slet ikke at nævne dem der har godt 8000 kr. at investere i grafik) - må det jo unægteligt have et marked, og en nogenlunde retfærdig pris.

Ydelsen taget i betragtning, synes jeg personligt virker meget cpu-afhængig. I den henseende, er det vel heller ikke tosset af Nvidia, at lave et single-gpu grafikkort, som slår al konkurrencen af vejen... Især ikke hvis de i ærmet formentligt har et dual-gpu kort, som - alle benchs taget i betragtning - vil slå ATI's Crossfire-løsninger af tronen når HD4870X2 kommer. Og det velogmærket UDEN SLI.

At det kan betyde en del for Nvidia at levere et ekstraordinært dominerende single-gpu kort med dual-gpu'en som trumfkort, i en tid hvor netop Intel sprøjter ud med chipsets der understøtter Crossfire, er vel ikke så underligt? Men prisen per CFR (CrysisFrameRate?) er måske en anelse "tosset"..

Men for den skare der pt. skal ud og investere i fx Nehalem-platformen, der jo lover meget bedre cpu-performance - hvilket i høj grad ligner noget både ATI's og Nvidia's nye grafikløsninger lider af - og for dem der finder det interessant at investere i kortet med henblik på en senere opgradering til SLI (for slet ikke at nævne dem der har godt 8000 kr. at investere i grafik) - må det jo unægteligt have et marked, og en nogenlunde retfærdig pris.

Ydelsen taget i betragtning, synes jeg personligt virker meget cpu-afhængig. I den henseende, er det vel heller ikke tosset af Nvidia, at lave et single-gpu grafikkort, som slår al konkurrencen af vejen... Især ikke hvis de i ærmet formentligt har et dual-gpu kort, som - alle benchs taget i betragtning - vil slå ATI's Crossfire-løsninger af tronen når HD4870X2 kommer. Og det velogmærket UDEN SLI.

At det kan betyde en del for Nvidia at levere et ekstraordinært dominerende single-gpu kort med dual-gpu'en som trumfkort, i en tid hvor netop Intel sprøjter ud med chipsets der understøtter Crossfire, er vel ikke så underligt? Men prisen per CFR (CrysisFrameRate?) er måske en anelse "tosset"..

#38

Havde nu forventet mig noget mere af Nvidia´s nye top-kort.

Troede mit gamle 8800 ultra skulle udskiftes, men det bliver hvor det er. I mit PCI-E slot 😀

Troede mit gamle 8800 ultra skulle udskiftes, men det bliver hvor det er. I mit PCI-E slot 😀

#39

tja jeg tror osse mit 8800 gtx godt kan klare det lidt endnu

#40

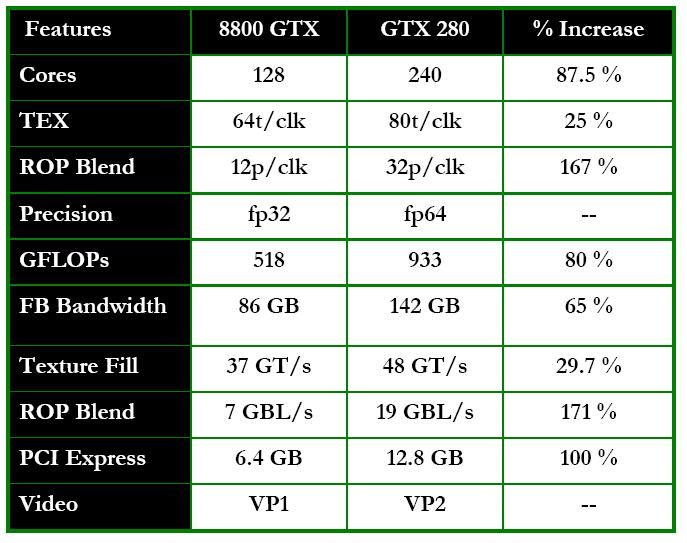

Jeg kan ikke se hvorfor folk er så forhippede på at beholde deres 8x00 kort... Der er en ydelsesforbedring på mellem 75 og 100%... Hvis det ikke kan tilfredsstille, så ved jeg ikke hvad kan 😴

MVH.

Toke 🙂

MVH.

Toke 🙂

#41

40# hvor ser du en forskel på 75-100% 😲

#42

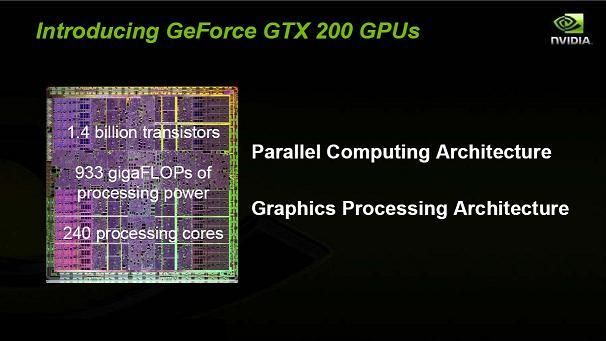

240 kerner i en gpu i forhold til 4 kerner i en C2D cpu - det rykker...

#43

Den der ydelsesforbedring på 75-100% vil jeg også gerne have dokumenteret....

Ingen tvivl om at GTX280 chippen sparker RØV ifht. 8xxx chippen, men så stor forskel tror jeg ikke på.

Ingen tvivl om at GTX280 chippen sparker RØV ifht. 8xxx chippen, men så stor forskel tror jeg ikke på.

#44

bare for halvandet år siden betalte folk gladeligt 4-5000kr for et topkort foreks. gav jeg 3500kr pr stk for mine 7800gtx kort og før det 4200kr for mit ATI 800 et eller andet premium edition(har glemt hvad det hed) så kom 8800 gt kortet til billige penge og nu tror folk de kan få foræret deres topkort 😎 ,de himler over prisen, hvis det er et problem så tag for hel..... da et ATI eller et andet kort der passer til jeres pengepung.

#45

#40 75%-100% den ser jeg så heller ikke lige.

4000-5000kr for et topkort er ok synes jeg. Det giver jeg gerne.

folk er så glade for deres 8800. fordi det nok er det bedste kort Nvidia til dato har lavet. Forstået på den måde at intet kort har været i nærheden af dets ydelse siden det kom på markedet i 2006. Først nu er der kort der er hurtigere, men ikke så markant så det trænger til en udskiftning.

4000-5000kr for et topkort er ok synes jeg. Det giver jeg gerne.

folk er så glade for deres 8800. fordi det nok er det bedste kort Nvidia til dato har lavet. Forstået på den måde at intet kort har været i nærheden af dets ydelse siden det kom på markedet i 2006. Først nu er der kort der er hurtigere, men ikke så markant så det trænger til en udskiftning.

#46

hvad kom gtx 260 til at koste egentlig ?

for jeg regner med at udskifte mit gamle 8800gts 320mb her, hvis ati da disker op med noget til den rette pris.

for jeg regner med at udskifte mit gamle 8800gts 320mb her, hvis ati da disker op med noget til den rette pris.

#47

Først skal I lige vide, at det er gået enormt stærkt med at teste dette kort. Det sketet som last-minute-udvej midt i mit eksamensræs. (Er student om 9 dage).

I mine øjne er kortet stadig en del bedre end fx 9800GX2, da GX2'et i (i mine øjne) med SLi-løsningen bare ikke er tip-top. I skal regne med, at dette er et ENKELTKERNET grafikkort - derfor synes jeg heller ikke med rette, at I kan sætte det op mod de multi-GPU-kort. Og mon ikke Nvidia også kommer med et dobbeltkerne GTX200-kort?

#4 --> Hvis jeg har skrevet average FPS er det vist en fejl :) - Eller også har Noxon ret :D

Jeg tester ikke i very high, da langt fra alle de kort jeg tester kan køre det. Jeg vil gerne kunne sammenligne alle på kryds og tværs - derfor. Desuden skal man da have Vista for very high? Eller er det bare mig?

#9 --> Det er gået MEGET stærkt med at lave den her artikel. Der er muligvis en smutter eller to.

#36 --> Just my point.

I mine øjne er kortet stadig en del bedre end fx 9800GX2, da GX2'et i (i mine øjne) med SLi-løsningen bare ikke er tip-top. I skal regne med, at dette er et ENKELTKERNET grafikkort - derfor synes jeg heller ikke med rette, at I kan sætte det op mod de multi-GPU-kort. Og mon ikke Nvidia også kommer med et dobbeltkerne GTX200-kort?

#4 --> Hvis jeg har skrevet average FPS er det vist en fejl :) - Eller også har Noxon ret :D

Jeg tester ikke i very high, da langt fra alle de kort jeg tester kan køre det. Jeg vil gerne kunne sammenligne alle på kryds og tværs - derfor. Desuden skal man da have Vista for very high? Eller er det bare mig?

#9 --> Det er gået MEGET stærkt med at lave den her artikel. Der er muligvis en smutter eller to.

#36 --> Just my point.

#48

Som de skriver på Guru3D, så ville GTX280 være mere imponerende at se på, hvis ikke 9800GX2 havde været her. Jeg er ganske vist imponeret over GTX280 ud fra et synspunkt om single-core GPU. De tekniske landvindinger mht at give så meget styrke i een chip der matcher og nogen gange overgår 9800GX2, synes jeg er rigtig flot.

Set ud fra et rent perrformancer-gamer perspektiv, mener jeg bare at kortet har det lidt svært på markedet med 9800GX2 som nu er blevet billigere og stadig i en hel del ting virkelig giver GTX280 kamp til stregen. Men man kan nok formode at 9800GX2 hurtigt ryger ad markedet for at holde priserne oppe.

Mit største ankepunkt er bare forsøget på at nedgøre 9800GX2 pga det er et dual GPU kort ! Først forguder man Dual GPU kort men så snart der kommer single chip der matcher det, så skælder man det ud og jeg ved ikke hvad - men det skal ikke undre mig der igen kommer rosende ord når dual GT200 kortet kommer.

SLi fungerer fremragende i mangt og meget.... så at lade det falde på det er et ringe argument - største svaghed er "cloned memory".

Ja GTX280 er et imponerende kort rent ydelses mæssigt - men det falder på det punkt at selv de nuværende kort i SLi næsten matche kortet til billigere penge (9800GX2 kan overmatche det i ca 50/50 tilfælde). Jaja måske koster SLi lidt mere watt, men hvis det virkelig var en reel bekymring i målgruppen her, ja så sad folk ikke konstant og spurgte til råds om nye PSU'er mv.

Set ud fra et rent perrformancer-gamer perspektiv, mener jeg bare at kortet har det lidt svært på markedet med 9800GX2 som nu er blevet billigere og stadig i en hel del ting virkelig giver GTX280 kamp til stregen. Men man kan nok formode at 9800GX2 hurtigt ryger ad markedet for at holde priserne oppe.

Mit største ankepunkt er bare forsøget på at nedgøre 9800GX2 pga det er et dual GPU kort ! Først forguder man Dual GPU kort men så snart der kommer single chip der matcher det, så skælder man det ud og jeg ved ikke hvad - men det skal ikke undre mig der igen kommer rosende ord når dual GT200 kortet kommer.

SLi fungerer fremragende i mangt og meget.... så at lade det falde på det er et ringe argument - største svaghed er "cloned memory".

Ja GTX280 er et imponerende kort rent ydelses mæssigt - men det falder på det punkt at selv de nuværende kort i SLi næsten matche kortet til billigere penge (9800GX2 kan overmatche det i ca 50/50 tilfælde). Jaja måske koster SLi lidt mere watt, men hvis det virkelig var en reel bekymring i målgruppen her, ja så sad folk ikke konstant og spurgte til råds om nye PSU'er mv.

#49

#47, det kunne være dejligt hvis der kom average fps i stedet, da det giver et billede af om det/de pågældende kort kan køre et spil under de givne forudsætninger.

Hvis der er nogen der går ud og bruger 4000kr på et nyt grafikkort i morgen, så er de totale tåber, det er jo ikke lang tid til ATI's svar, og det kunne måske være interessant at se hvad ATI's nye kort faktisk. Gætterier er ikke meget værd. Personligt havde jeg forventet at nVidia's kort var noget hurtigere.

Hvis der er nogen der går ud og bruger 4000kr på et nyt grafikkort i morgen, så er de totale tåber, det er jo ikke lang tid til ATI's svar, og det kunne måske være interessant at se hvad ATI's nye kort faktisk. Gætterier er ikke meget værd. Personligt havde jeg forventet at nVidia's kort var noget hurtigere.

#50

#42

Argh det er ren Nvidia PR BS at kalde det 240 cores. Lige pludselig skal de kalde deres shaders cores, det jo super ømt, når de "cores" ikke kan bruges til x86 arkitekturen som cores i en cpu kan, men skal bruges til CUDA arkitekturen,

Argh det er ren Nvidia PR BS at kalde det 240 cores. Lige pludselig skal de kalde deres shaders cores, det jo super ømt, når de "cores" ikke kan bruges til x86 arkitekturen som cores i en cpu kan, men skal bruges til CUDA arkitekturen,

#51

48# Det jo langt fra alle der sidder med en sli platform. Det er billigere at købe 9800gx2 til sit intel chipset board end at købe et godt sli board og 2 gfxkort til at køre sli.

#52

#46 sig lige til så når du gør det.Så er jeg interesseret i dit nuværende kort.Har et magen til og kunne godt tænke mig at prøve at køre SLI 🙂 Hvis prisen er rigtig selvfølgelig 😉

#53

#51: Det er jo heller ikke det, der er pointen. Kortet blegner stadig iforht. ydelsen når man tager de ældre kort og sætter i SLi. Selvfølgelig sidder ikke alle alle med SLi boards, men med lidt der roterer i toppen, vil man kunne se andre alternativer end GTX280 hvis det skulle være, og har du muligheden for SLi ja så er GTX280 ikke så interessant som enkeltstående kort f.eks hvis du sætter 8800GTS/9800GTX i SLi.

#54

"Kortet blegner stadig iforht. ydelsen når man tager de ældre kort og sætter i SLi."

Hvordan er det lige du kan sammenligne 2 kort med 1?????

Hvordan er det lige du kan sammenligne 2 kort med 1?????

#55

#53 --> Der er ingen tvivl om, at man til prisen kan få et meget bedre pris/ydelse-forhold ved at køre ældre kort i SLi eller vælge et 9800GX2. Imidlertid er det ikke alle spil og programmer der understøtter SLi - og der var da også nogle af de kørte tests, hvor GX2'et får tæsk.

Det er også derfor, at kortet kun får "2" i kategorien "pris". Men at kortet kun er enkeltkernet giver stadig mulighed for med SLi at få en hidtil uset ydelse, som man ikke på samme måde (i mine øjne - ret mig hvis jeg er helt gal på den) kan få ved to GX2'ere i SLi. Som Quad-SLi artiklen her på HWT også viser, er der ikke man spil, hvor det fuld understøttes, så man får slet slet ikke 4xden ydelse, som kort nr. 2 ellers ville give i alm. SLi.

Jeg ved godt, at det var kringlet formuleret. 😛

Det er også derfor, at kortet kun får "2" i kategorien "pris". Men at kortet kun er enkeltkernet giver stadig mulighed for med SLi at få en hidtil uset ydelse, som man ikke på samme måde (i mine øjne - ret mig hvis jeg er helt gal på den) kan få ved to GX2'ere i SLi. Som Quad-SLi artiklen her på HWT også viser, er der ikke man spil, hvor det fuld understøttes, så man får slet slet ikke 4xden ydelse, som kort nr. 2 ellers ville give i alm. SLi.

Jeg ved godt, at det var kringlet formuleret. 😛

#56

mht. ydelsen, tjek evt. ydelse pr. transistor, kortet har 2,3 gange så mange transistorer som et amd 3870, og er en generation nyere, så umiddelbart syntes jeg ikke at dets ydelse er revolutionerende, det virker på mig som om at nvidia har udviklet det her kort lidt lala mens de har koncentreret sig om andre projekter (chipset, mobiltelefoner etc.)

specielt undrer det mig et de ikke har skrumpet kernen, alle andre er skiftet til 45 el. 55 nm

specielt undrer det mig et de ikke har skrumpet kernen, alle andre er skiftet til 45 el. 55 nm

#57

De har brugt så meget tid på at opgradere diverse non-gaming teknologier på deres kort. De forkusere i øjeblikket så meget på, hvad deres gpu kan gøre bedre end intels Quad-cores, og udvikle CUDA og få folk til at bruge det i deres programmer. GPGPU ftw.

#58

er der slet ingen der kan svare på hv ad kortet bruger når computeren bare står i windows det syns jeg pasonligt er en meget vekdi ting med et grafikort som det her

#59

#58 det bliver der svaret på i #31 🙂

#60

59# nej der bliv svaret hvad det brugte i load

og kortet er neppe i load når det bare såtr i windows elelrs bliver det sku dyrt 😛

og kortet er neppe i load når det bare såtr i windows elelrs bliver det sku dyrt 😛

#62

#60 --> Det er opgivet af Nvidia og står i afsnittet "teknologi/innovation":

- Idle/2D power mode (ca. 25W)

- Blu-ray DVD playback mode (ca. 35W)

- Full 3D performance mode (varies - worst case TDP 236W)

- HypridPower mode (effectively 0W)

Læs det afsnit, som du tydeligvis er sprunget over, og du får dine svar. Der står mere, end jeg lige har gengivet ovenfor.

- Idle/2D power mode (ca. 25W)

- Blu-ray DVD playback mode (ca. 35W)

- Full 3D performance mode (varies - worst case TDP 236W)

- HypridPower mode (effectively 0W)

Læs det afsnit, som du tydeligvis er sprunget over, og du får dine svar. Der står mere, end jeg lige har gengivet ovenfor.

#63

avs 236w, der skal sq flyttes noget luft for at de ikke brænder op i sli..

#64

#63 ellers kan nvidia lancere en ny type kølere til deres grafikkort som både kan levere god grafik og en funktion til at varme vandet til kaffen. Problemet er selvfølgligt at når kortet kører under full load så skal der drikkes meget kaffe, hvilket kan forstyre spillet!

#66

Så er der lidt flere benchmarks til jer.

Hope you like. 🙂

Hope you like. 🙂

#67

#47, det der med at dual kort ,håber godt nok de for lavet noget så deres strøm forbtug ryger ned, eller's et dual kort med en tdp på 472 watt, sygt!

#68

En ting der undrer mig...

I Xp er der testet i 3D mark 03 og o6

I Vista er der testet med 05, 06 og Vantage

I mine øjne giver det ingen mening,...

I Xp er der testet i 3D mark 03 og o6

I Vista er der testet med 05, 06 og Vantage

I mine øjne giver det ingen mening,...

#69

->#68

Hvorfor giver det ingen mening for dig?

Der er også testet i helt andre spil. Det er jo på ingen måde meningen, at de 2 benchmark-sektioner skal kunne sammenlignes.

Jeg har droppet 3dmark03, da jeg mener det er forældet. Men hvis du er interesseret i en score, kan du da sagtens få den: 52828 - og så kan du sammenligne her:

:yes:

Hvorfor giver det ingen mening for dig?

Der er også testet i helt andre spil. Det er jo på ingen måde meningen, at de 2 benchmark-sektioner skal kunne sammenlignes.

Jeg har droppet 3dmark03, da jeg mener det er forældet. Men hvis du er interesseret i en score, kan du da sagtens få den: 52828 - og så kan du sammenligne her:

:yes:

#71

jeg har købt et fik det dog med lidt rabat hehe men er enig det rykker virkelig vildt intet jeg har prøvet har endnu tvunget det i knæ i 1920x1200 (har dog ikke testet crysis) så jeg er meget glad for mit nyr gtx 280.

fik så osse 15807 point i 3dmark 2006 med det og og en e8400 clocket til 4ghz ganske pænt synes jeg.

fik så osse 15807 point i 3dmark 2006 med det og og en e8400 clocket til 4ghz ganske pænt synes jeg.

#72

hvor kan BadaBoom Media Converter den prøve udgave prøves fra eller købes eller dure det ikke til 8800gt 🙂

edit ja 8800GT kan bruges og en masse andre 😀 og det er vis ikke udgivet enu http://www.badaboomit.com/blog...

edit ja 8800GT kan bruges og en masse andre 😀 og det er vis ikke udgivet enu http://www.badaboomit.com/blog...

#73

#69

Nogen foretrækker vista andre xp...

KUnne være rart med en så nogenlunde ens benchmark, da den ellers ikke kan bruges til ret meget imo.

Nogen foretrækker vista andre xp...

KUnne være rart med en så nogenlunde ens benchmark, da den ellers ikke kan bruges til ret meget imo.

#74

->#71

Ja det er nu et meget fint kort. Hatten af for at du smider de penge kortet koster. 🙂

->#72

Tror desværre kun det er forbeholdt pressen. Men nVidia har kun uddelt trial-versioner der rent praktisk ikke kan bruges til det store. Og ja, i princippet kan alle nVidia grafikkort fra GeForce8 og opefter bruges. Dog kan det være, at nogle low-end kort ikke vil understøtte det, da de ikke er kraftige nok.

->#73

Det er da en underlig kritik du kommer med. Selvfølgelig kan de bruges - det er jo ikke en XP vs. Vista-artikel, som du øjensynligt efterspørger.

Ydelsen i XP ligger typisk en anelse højere end Vista, men det er ret ubetydeligt: www.kortlink.dk/extremetech/5f...

Ja det er nu et meget fint kort. Hatten af for at du smider de penge kortet koster. 🙂

->#72

Tror desværre kun det er forbeholdt pressen. Men nVidia har kun uddelt trial-versioner der rent praktisk ikke kan bruges til det store. Og ja, i princippet kan alle nVidia grafikkort fra GeForce8 og opefter bruges. Dog kan det være, at nogle low-end kort ikke vil understøtte det, da de ikke er kraftige nok.

->#73

Det er da en underlig kritik du kommer med. Selvfølgelig kan de bruges - det er jo ikke en XP vs. Vista-artikel, som du øjensynligt efterspørger.

Ydelsen i XP ligger typisk en anelse højere end Vista, men det er ret ubetydeligt: www.kortlink.dk/extremetech/5f...

#75

Emillos> Må man nu ikke sige sin mening?????

imo = In My Opinion.

imo = In My Opinion.

#76

#75

Selvfølgelig må man da det?.

Selvfølgelig må man da det?.

#77

#75 --> Du skulle gerne kunne finde alle de resultater du efterspørger i denne nyhed: http://hwt.dk/newsdetails.aspx...

Som jeg ser det er der heller ingen grund til at lave sammenligningsbenchmark. At vi både tester i XP og Vista denne gang er et særsyn, og fordi vi fik en efterspørgsel på benchmarks af CUDA, som ikke understøttes af XP, som jeg bruger. Derfor røg kortet videre til Emil.

.. og selvfølgelig må du gerne have din egen mening. 🙂

Som jeg ser det er der heller ingen grund til at lave sammenligningsbenchmark. At vi både tester i XP og Vista denne gang er et særsyn, og fordi vi fik en efterspørgsel på benchmarks af CUDA, som ikke understøttes af XP, som jeg bruger. Derfor røg kortet videre til Emil.

.. og selvfølgelig må du gerne have din egen mening. 🙂

#78

->#75

Jo. Du siger din mening, mens jeg giver udtryk for min.

Du synes mine benchmarks er ubrugelige, og det kan jeg ærlig talt ikke forstå; var jeg af samme overbevisning, ville jeg ikke have lavet dem. 🙂

Hvis du kunne komme med en uddybende forklaring på, hvorfor du ikke kan bruge benchmarks'ene til noget, ville det være en anden sag. Er det tilfældet, må du da hellere end gerne ytre den. :yes:

Jo. Du siger din mening, mens jeg giver udtryk for min.

Du synes mine benchmarks er ubrugelige, og det kan jeg ærlig talt ikke forstå; var jeg af samme overbevisning, ville jeg ikke have lavet dem. 🙂

Hvis du kunne komme med en uddybende forklaring på, hvorfor du ikke kan bruge benchmarks'ene til noget, ville det være en anden sag. Er det tilfældet, må du da hellere end gerne ytre den. :yes:

#79

#78

i bruger ikke samme hw i xp som i vista og kan der for ikke til at sammen lige

i bruger ikke samme hw i xp som i vista og kan der for ikke til at sammen lige

#80

#79 --> Det er fuldstændig rigtigt 🙂

#81

#79 korrekt men var hardware ens i de 2 maskine så ville det jo være forskellen i software der medførte at man ikke kunne sammeligne benchs lavet på den ene maskine og på den anden. når man tester ting så kan der være så mange småting der gør at man faktisk ikke kan sammenligne 2 tests med hinanden.

#82

udover det, så er der ikke det vilde marked for den rent logisk...for 90% af gamerne derude kan et 8800Gt til 1200kr dække behovet alligevel....derfor virker prisen lidt ude i hampen.

![[G.N.U.]](/images/users/profile/36302.jpg)