Test: MSI 280GTX

Grafikkort, NVIDIA d. 17. juli. 2008, skrevet af Cook 32 Kommentarer. Vist: 18758 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: MSI

DK distributør: InterData

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: MSI

DK distributør: InterData

#1

Fint test. Men hvorfor teste et DX10 kort på et forældet OS med forældet DX? Svarer jo lidt til at prøvekøre en ferrari på en grusvej.

#2

fuldstændig latterlig test!

forældet cpu, skod chipsæt, dårlige ram og et forældet OS der ikke understøtter alle funktioner i grafikkortet!

Dårlig stil HWT!

dette er ikke en brugbar test!

forældet cpu, skod chipsæt, dårlige ram og et forældet OS der ikke understøtter alle funktioner i grafikkortet!

Dårlig stil HWT!

dette er ikke en brugbar test!

#3

#2

hvorfor melder du dig så ikke til crew? De skal jo nok selv betale for deres udstyr som de tester med!

og jo, det er i særdeleshed en brugbar test, da det viser hvordan kortet vil performe sammen med en lidt ældre cpu.

hvorfor melder du dig så ikke til crew? De skal jo nok selv betale for deres udstyr som de tester med!

og jo, det er i særdeleshed en brugbar test, da det viser hvordan kortet vil performe sammen med en lidt ældre cpu.

#4

#1: hvorfor ikke ? der er jo alligevel ikke noget ordenligt DX10 fis ude endnu... den gang DX10 lapning til Bioshock, Crysis, Assassins Creed er jo til at grine af.

Der er mange der stadig kører DX10 kort i winXP.

#2: Dårlig læsning og forståelse af testen,

Der er mange der stadig kører DX10 kort i winXP.

#2: Dårlig læsning og forståelse af testen,

#5

#2 Hvis jeg skal svare en smule konstruktivt på din ukonstruktive kritik så er vi løbende under opgradering af vores testmaskiner så de er nogenlunde tidssvarende, men der er her flere ting man skal tage i betragtning. For det først skal skribenterne som udgangspunkt selv købe deres udstyr, hvilket jo kan være en dyr fornøjelse på SU. Derudover viste sidste rundspørge at 78% af vores læsere stadig kører XP, så der er DX10 ikke aktuelt. Det er da heller ikke alle vores læsere der nødvendigvis kører det nyeste rig, så her viser testen meget godt, hvad de netop kan få ud af at opgradere til det nyeste highend kort. Desuden har jeg brugt ekstra tid på at vise, hvor stor CPU-afhængigheden er for de moderne grafikkort. Det kan du evt. kigge på en ekstra gang.

Ved sidste møde blev det afgjort at vi efterhånden skal konvertere til Vista, når licenserne er på plads og når jeg alligevel skifter til Vista bliver min E6700 nok også skiftet.

Mvh Cook

Ved sidste møde blev det afgjort at vi efterhånden skal konvertere til Vista, når licenserne er på plads og når jeg alligevel skifter til Vista bliver min E6700 nok også skiftet.

Mvh Cook

#6

Fed kort, synd det koster så meget.

#7

#2 slå lige koldt vand i blodet hva´? Der er rigtig mange der har en maskine der ligner den der er blevet brugt i testen, desuden kan man også sammenligne med de andre kort som konkurrerre med testkortet,(jeg går ud fra at de også er blevet testet på same setup) på den måde kan man se hvad der bedst kan betale sig...

#8

#2 Du går hårdt til den!

Er du ikke glad for de mennesker gider at bruge så lang tid på at teste? Personligt synes jeg kritik er iorden men det skal være leveret på en passende måde og understøttet. 😉

Er du ikke glad for de mennesker gider at bruge så lang tid på at teste? Personligt synes jeg kritik er iorden men det skal være leveret på en passende måde og understøttet. 😉

#9

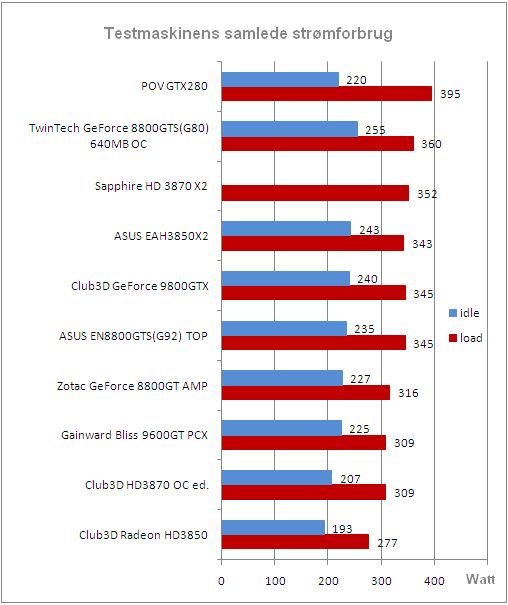

fedt med det størmforbug test syns ild forbruget er godt nok det er så lavt 🙂

#10

En E6700 på 3.33GHz vil tæve en E8400 3.0GHz på de lange stræk, så jeg forstår ikke kritikken fra #2. Det testsystem lever fuldt op til standarden i dag. Og mht til XP vs. Vista så er det bestemt noget vi overvejer, men det kræver et sponsorat fra en villig giver hvis hele vores crew skal have adgang til Vista.

#11

Fedt test.. Og #2 er da helt galt på den..

Super med den dejlige CPU flaskehals ting.. Ville være naice hvis det blev standard. 😉

Super med den dejlige CPU flaskehals ting.. Ville være naice hvis det blev standard. 😉

#12

Det er nok de færreste der har en QX i maskinen... og der er mange andre på nettet der kommer ind og læser hwt.´s artikler, så det er ikke kun os der har en profil herinde der læser dem...

#13

#2 fuldstændig latterlig kommentar!

forældet kommentar, skod kommentar, dårlig kommentar og en forældet kommentar der ikke understøtter alle funktioner i grafikkortet! 🤣

Dårlig stil Lazare!

dette er ikke en brugbar kommentar!

forældet kommentar, skod kommentar, dårlig kommentar og en forældet kommentar der ikke understøtter alle funktioner i grafikkortet! 🤣

Dårlig stil Lazare!

dette er ikke en brugbar kommentar!

#14

#2 profil billede passer vist meget godt hvis det er selv portræt. 🤡

#15

#2 amen brother! kortet skal da få lov til at spille med musklerne.

#17

ukonstruktivt?

jeg fremhæver mine kritikpunkter og giver min mening til kende..

Alle herinde burde da vide som basisviden at der skal være en balance mellem den hardware man putter i sin computer, og dermed er der ingen grund til at smide et hjernedødt kraftigt grafikkort i en computer der bare ikke kan følge med dets ydelse!

sorry hvis jeg fik det til at lyde vrissent, men jeg mener nu engang stadig at det ikke er brugbart!

Og til #3: jeg kan da godt melde mig til crewet - hvis jeg havde tiden :p

og jo jeg er glad for at folk gider teste det, men jeg ved der er mange andre skribenter herinde der har kraftigere maskiner - hvorfor ikke lade dem teste kortet istedet?!?!

jeg fremhæver mine kritikpunkter og giver min mening til kende..

Alle herinde burde da vide som basisviden at der skal være en balance mellem den hardware man putter i sin computer, og dermed er der ingen grund til at smide et hjernedødt kraftigt grafikkort i en computer der bare ikke kan følge med dets ydelse!

sorry hvis jeg fik det til at lyde vrissent, men jeg mener nu engang stadig at det ikke er brugbart!

Og til #3: jeg kan da godt melde mig til crewet - hvis jeg havde tiden :p

og jo jeg er glad for at folk gider teste det, men jeg ved der er mange andre skribenter herinde der har kraftigere maskiner - hvorfor ikke lade dem teste kortet istedet?!?!

#18

#17 Nu vil jeg ikke ud i noget mudderkastning, men det passer simpelthen ikke. Vi er 4 faste grafikkort skribenter: JacobHL, Emillos, Goaguy og mig. Hvis du kigger på, hvilken processor vi har er de mere eller mindre identiske. De 3 af os har E6XXX og Emil har Q6XXX, men det ligger stadig i samme område, især når man tester grafikkort.

#19

#18

Hvor lang tid tager det i gennemsnit at teste et grafikkort? - bare for at få et ca. tal :)

Hvor lang tid tager det i gennemsnit at teste et grafikkort? - bare for at få et ca. tal :)

#20

Det tager ca. 2-3 timer og kører tests igennem, overclocke, måle temps og strømforbrug. Og så tager det 2-3 timer at skrive artiklen.

#21

#20

Det er da ikke alverdens.. mon ikke der skulle være nogle, der gerne ville ligge de 4-6 timer i HWT en gang hver hver anden måned?

jeg kunne da godt finde på at tilmelde mig crew -så snart jeg bare har fået fat på CPU og HDD 😳 hehe

Det er da ikke alverdens.. mon ikke der skulle være nogle, der gerne ville ligge de 4-6 timer i HWT en gang hver hver anden måned?

jeg kunne da godt finde på at tilmelde mig crew -så snart jeg bare har fået fat på CPU og HDD 😳 hehe

#22

#21 Det lyder yderst fornuftigt 🙂

#23

Modsat #2, så synes jeg godt om testen. langt de fleste af os kører stadig XP, og langt de fleste af os har en PC der minder om den der er testet med, hvilket vil sige at langt de fleste af os nu ved, hvad vi vil kunne forvente af ekstra ydelse ved at investere i dette kort (eller et af de andre i testen selvf.) Da der endnu ikke her ca 1½ år efter DX10's fremkomst er kommet noget "super-dx10" grafik, er det jo alligevel ikke rigtig noget at teste i, men måske kommer det? Det gør det jo nok, og vi skal (sandsynligvis) alligevel have nyt grafikkort til næste år når DX11 kommer, og _hvis_ DX11 ikke bliver "Vista only", så vil XP sikkert leve til Windows 7 kommer på banen. Så fra min side en tak til Cook for at bruge tid og energi på at teste kort i en "almindelig" PC. 🙂

Hvad glæde ville vi have af at få at vide, hvordan 280-kortet opfører sig i en top-PC, som meget få alligevel har, men som mange naturligvis drømmer om. Der er jo en grund til, at det er en toyota der holder i garagen og en ferrari er på billedet på væggen 😎

Hvad glæde ville vi have af at få at vide, hvordan 280-kortet opfører sig i en top-PC, som meget få alligevel har, men som mange naturligvis drømmer om. Der er jo en grund til, at det er en toyota der holder i garagen og en ferrari er på billedet på væggen 😎

#24

#23 hvorfor skulle dx 11 understøtte xp når dx10 ikke gør?

det er stadig synd at tage et så sygt kort og ikke vise dets fulde potentiale.

det er stadig synd at tage et så sygt kort og ikke vise dets fulde potentiale.

#25

jeg kan sagtens se det ud fra synspunktet om at det kører i en mid-end maskine og at der er rart for folk at vide hvordan det yder i en sådan maskine.. men hvis man har råd til at købe et gtx280 skulle man måske overveje at bruge pengene lidt mere fornuftigt fordelt i ens computer..

synes bare det giver et ærgerligt indtryk af kortet når der er så meget mere potentiale i det end hvad testen viser her..

som nummer 1 siger (uden at blive flamet ;) ) så er det som at teste en ferrari på en grusvej :s

synes bare det giver et ærgerligt indtryk af kortet når der er så meget mere potentiale i det end hvad testen viser her..

som nummer 1 siger (uden at blive flamet ;) ) så er det som at teste en ferrari på en grusvej :s

#26

altså nu vil jeg ikke blandes ind i noget, men synes ikke at ALLE skal smidde en kommentar om at de er uenige med Lazare. det er fint at der er en eller to der skriver det, men kom dog videre så. tror han har fattet det 🙂

#27

#26 jeg synes at vi skal have alle brugere på hwt til at give deres mening til kende :D så kan vi få en laaaaaaang tråd :P

#28

#27 hehe. ku være humor 😀 men har selv prøvet at sidde på et forum og lufte min mening, hvor alle gik imod mig. selvom jeg havde fat i noget. og det fik mig til at forlade det forum. men det var godt det samme 🤣

#29

#28 sandheden er ofte ildehørt 🤣

#30

#25: Og nej. Hvis du sidder men en 24TFT og vil spille i native opløsningen på f.eks 1920x1200 så kræver det GFX power, og med et hurtigt GFX er det mulig at køre i den opløsning og med FSAA/AF aktiveret. Som der jo også vises i testen, så er CPU'en en sekundær rolle når vi allerede er oppe i 1600x1200 og med FSAA/AF- her er det grafikkortet der er vigtigt. Så længe CPU'en er rimelig aktuel kan ethvert grafikkort give et boost til højere opløsninger og FSAA/AF:

#31

#29

Det skulle vel ikke være jubii debatten? der er de alle så indspiste, at enten er man enig, eller også er man den der er smuttet.

Det skulle vel ikke være jubii debatten? der er de alle så indspiste, at enten er man enig, eller også er man den der er smuttet.

#32

#30 det var jo præcist det jeg mente, CPU'en HAR vitterlig ikke meget at sige i høje opløsninger og med masser af FSAA og ani. slået til. 🙂

#24, fordi det var en Microsoft beslutning (for at få solgt nogle flere Vista-licenser) at DX10 skulle være Vista-only, men det problem har MS jo ikke når DX11 udkommer, idet de ikke sælger XP mere. Programmeringsmæssigt er der INTET til hinder for, at DX10 skulle kunne køre på XP.

Men vi mangler jo stadig et DX10 spil som kan retfærdiggøre at DX10 er et _must have_ her 1½ år efter fremkomsten af DX10/Vista.

#24, fordi det var en Microsoft beslutning (for at få solgt nogle flere Vista-licenser) at DX10 skulle være Vista-only, men det problem har MS jo ikke når DX11 udkommer, idet de ikke sælger XP mere. Programmeringsmæssigt er der INTET til hinder for, at DX10 skulle kunne køre på XP.

Men vi mangler jo stadig et DX10 spil som kan retfærdiggøre at DX10 er et _must have_ her 1½ år efter fremkomsten af DX10/Vista.