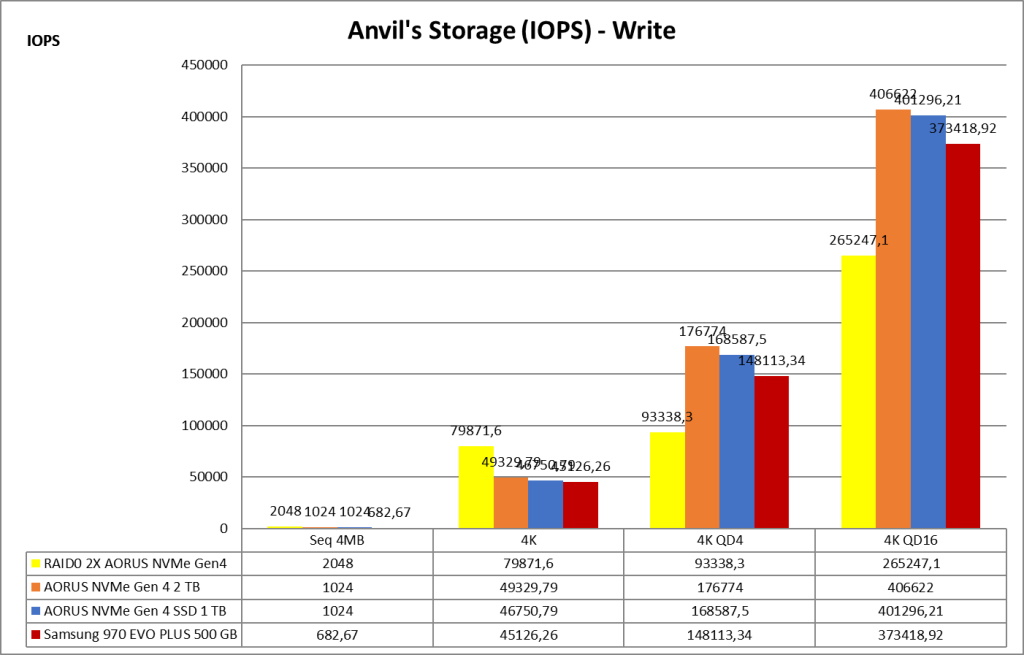

Test: Aorus NVMe Gen4 SSD X2 i RAID0

Solid state disk d. 31. december. 2019, skrevet af Renissen2 9 Kommentarer. Vist: 11410 gange.

En yderst interessant test, Renissen. Har dog lige et opfølgende spm, da der tilsyneladende er problemer med (især read) 4k filer.

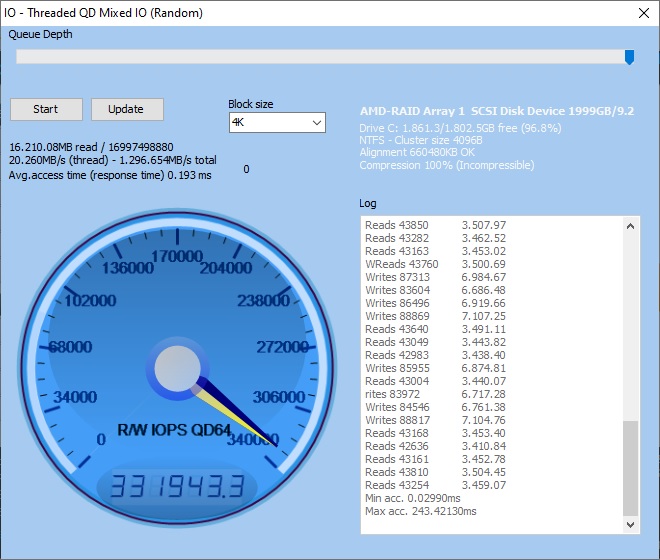

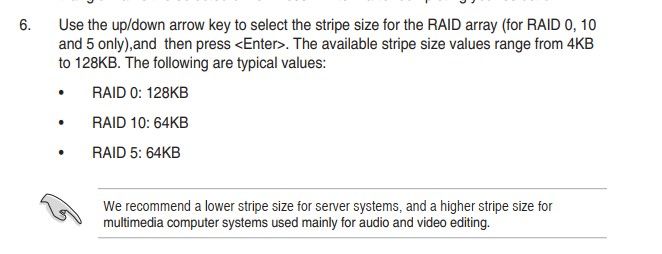

Da du oprettede dette RAID0 array, hvad størrelse valgte du så til stripe size? Dette valg kan give ret forskellige resultater i div testprogrammer.

Man kan jo så undre sig over, at Intel stadig ikke er kommet med på PCIe4 vognen, ikke engang på det kommende Z470 chipsæt

Svaret blev redigeret 1 gang, sidst af Burgurne d. 31-12-2019 11:42:25.

#1

Hmmm godt spørgsmål. Jeg mener ikke der var mulighed for at vælge dette, men jeg kan have overset det. Jeg husker det kun som opret array RAID0, med måske en mulighed for forskellig cache size.

Ja utroligt at intel ikke straks hoppede med på Gen4 PCIe. 🙂

Svaret blev redigeret 2 gange, sidst af Renissen2 d. 31-12-2019 12:49:17.

Har du tænkt på om dine problemer stammer fra mangel af PCI-E lanes? - jeg har selv rodet med det (dog kun på pci-e 3.0) og endt med samme problemer og mærkelige hastigheder i visse sammenhæng.

Uanset om du køber vilde bundkort med 3 stk x16 sokler og 4 stk x1 sokler har du reelt kun 20 lanes og give af. Cpu'en er en 24lane chip - de 4 er afsat til chipset. Tag for givet at dit grafikkort får de 16 af de 20 tilgængelige lanes - så beder du om at få 2*4 lanes mere til dit NVMe storage - for slet ikke at snakke om at du skal have lanes til dine sata controllere, usb porte, network osv osv osv (hvor det meste givetvis deles via de 4x til chipset).

https://en.wikichip.org/wiki/a...

ExpansionsIn addition to the x4 lanes that are reserved for the chipset, the Ryzen 5 3600X has x16 for a

https://en.wikichip.org/w/inde...

and x4 for storage (NVMe or 2 ports SATA Express).

Syntes ikke jeg personligt har haft held med at finde review sider der er gået tilpas i dybden med hvordan AMD vælger og fordeler disse PCI-E lanes. Min situation stod jeg også og skulle have et x8 10gbps netkort i maskinen samtidig. Alm matematik sagde jo vi var løbet tør for lanes længe forinden - men tingene virkede - blot ikke med håbede hastigheder.

Prøvede selv at løse problemet med en 3200G/3400G chip og tænkte - onboard gfx måtte da løse det - men så går de x16 lanes blot til onboard.

Back on topic - god artikel ... 🙂

Jeg tror, at #3 er inde på noget.

Du skal også være opmærksom på, at 1 af M.2 ”stikkene” kommunikerer direkte med CPU`en mens det andet M.2 stik kommunikerer via chipsettet. Det kan også have betydning. Dette stik deler ofte samtidigt sine PCI-baner med SATA portene. Så hvis du også har dem i brug, kan det reducere den båndbredde, du har til rådighed.

#4 Ikke helt korrekt (på Intels chipsæt i hvert fald). De PCIe lanes der deles mellem NVMe og SATA kan KUN bruges til enten det ene eller det andet, man kan altså ikke have en SATA og en NVMe der hver får det halve antal baner. Det er enten eller.

Jeg har selv 2 NVMe drev i min (intel) PC, Samsung 970 EVO, og jeg har testet på kryds og tværs mellem det NVMe stik der kører direkte til CPU'en og det der kører gennem chipsættet. Der er INGEN forskel. Den teoretiske hastighedsforskel der måtte være kommer ikke til udtryk da begrænsningen i hastighed åbenbart ligger et andet sted. Jeg tabte et væddemål på dette, så tro mig ... jeg gjorde alt hvad jeg kunne for at modbevise at dette ville blive resultatet 😉.

Men da det kun er PCIe 3 jeg har, så giver det ingen mening i at teste i RAID 0, da drevene hver især er meget tæt på max. ydelse i.forb.m PCIe 3.

På RAID0 med alm. harddiske kan stripe size have en hel del at sige, men jeg har aldrig prøvet med SATA SSD i RAID0, så derfor mit oprindelige spm i #1

Rigtig spændende læsning, tak for en fin artikel.

Jeg undrer mig over nedenstående:

"Jeg har opbygget RAID0 ARRAYET med en 1TB AORUS NVMe Gen4 SSD på 1TB og endnu en på 2TB hvilket giver et ARRAY på 1TB samlet."

Bør det ikke ende med at være 3TB samlet, når du kører 0?

Nå jo det kan da egentlig godt tænkes. :) Jeg var i min egen lille RAID verden da min NAS kører RAID 1 og der giver det samlede af 2 stk.2TB hd'er 2 TB samlet. My bad :)

Jo det var de vist... hvorfor? 🙂