B@NG

#0

Brugeren Mentos3 syntes lige vi skulle kigge lidt på de gamle dage, og har derfor skrevet lidt om hvad der er sket i perioden 1980-2000.

Link til litteratur: http://www.overclocking.dk/lit...

Link til litteratur: http://www.overclocking.dk/lit...

#1

Det var en lækker gang læsning...

#2

Ja, synes også det var helt vildt spændende :e

Selvom man pludselig føler sig lidt gammel :o

Syntes specielt afsnittet med WWW var sjovt at læse :)

Selvom man pludselig føler sig lidt gammel :o

Syntes specielt afsnittet med WWW var sjovt at læse :)

#3

Helt bestemt en god artikel...

Sætter mange af de ting man har idag i en god relief, det hele er jo næsten lige sket :)

Da Mentos først kontaktede mig, kunne jeg faktisk ikke vente med at læse den artikel :)

Sætter mange af de ting man har idag i en god relief, det hele er jo næsten lige sket :)

Da Mentos først kontaktede mig, kunne jeg faktisk ikke vente med at læse den artikel :)

#4

en lille rettelse til artiklen. :e

Microsoft har ikke lavet wordperfect. der har en anden tekstbehandler der hedder word.

http://en.wikipedia.org/wiki/W...

http://en.wikipedia.org/wiki/M...

på cpu fronten var cyrix også med i en årrække

Microsoft har ikke lavet wordperfect. der har en anden tekstbehandler der hedder word.

http://en.wikipedia.org/wiki/W...

http://en.wikipedia.org/wiki/M...

på cpu fronten var cyrix også med i en årrække

#5

Det var nu en rar artikel at læse, godt arbejde makker. Selv om der nu er nogen ting jeg husker anderledes ( tror jeg )

#4

C*rix?!! SHHHH det navn må under ingen omstændigheder nævnes!

Jeg mindes mangen en kold vinteraften hvor jeg sad og bad min PR200+ om at køre stabilt for en enkelt gangs skyld.

Tåben her havde jo valgt at bruge alle pengene på gfx, ram og hdd :00

#4

C*rix?!! SHHHH det navn må under ingen omstændigheder nævnes!

Jeg mindes mangen en kold vinteraften hvor jeg sad og bad min PR200+ om at køre stabilt for en enkelt gangs skyld.

Tåben her havde jo valgt at bruge alle pengene på gfx, ram og hdd :00

#6

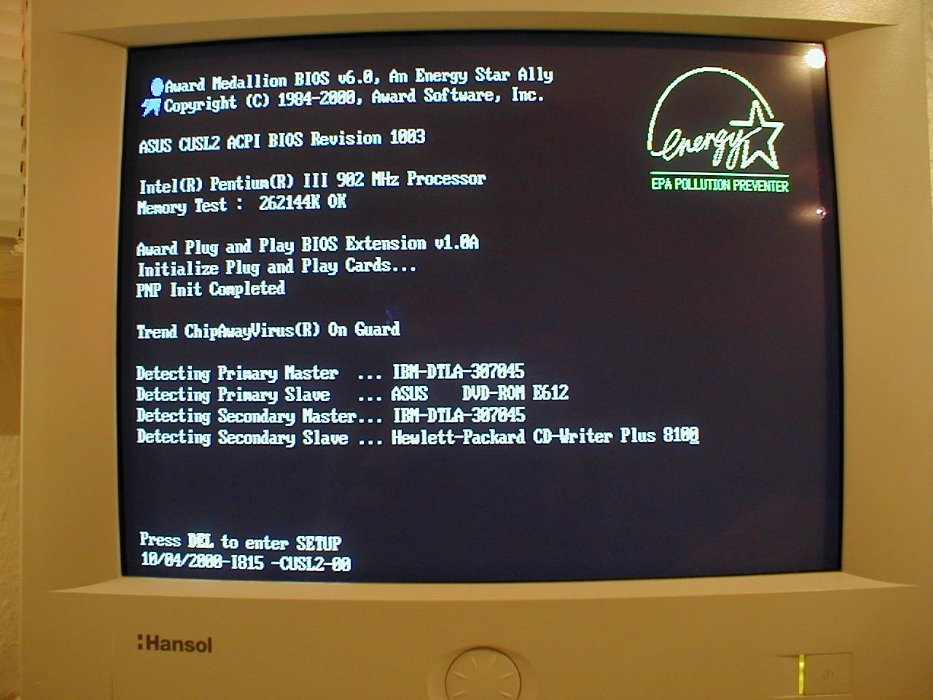

Jeg begymder kun at kunne huske deronkring Slutningen af PIII og starten af AMD Palmino, siden kan jeg faktisk huske tilbage til..

kan huske da der var stor tvivl om hvad der ville blive fremtidens styresystem..os2 eller windows.....alle havde faktisk ret, for microsoft stjal de fleste af ideerne fra os2 og brugte til win95 :D

#8

#7 faktisk så var os/2 et styresystem der skulle laves af ibm og microsoft i samarbejde, med microsoft træk sig ud af det samarbejde inde de var færdige og deres del vidre udviklede de til Windows NT

#9

noget helt andet det billede der er i artiklen af opstart af Wordperfect der er wordperfect for MAC ikke for pc'ere

#10

:) Meget sjov læsning tilbage fra da jeg også startede (ca. 1984).

men der er nogle små unøjagtigheder. 3S hedder S3 modemet var Haynes, og Linux er ikke ejet af nogle. jeg er også sikker på at folkene bag WP ville rotere i deres grave. Dette skal ikke tages negativt, men artiklen ville vinde ved at verificere facts.

men der er nogle små unøjagtigheder. 3S hedder S3 modemet var Haynes, og Linux er ikke ejet af nogle. jeg er også sikker på at folkene bag WP ville rotere i deres grave. Dette skal ikke tages negativt, men artiklen ville vinde ved at verificere facts.

#11

Først vil jeg da rose dig mentos, det var også på tide med en ny gæste artikel, det er for længe siden vi har fået nogen af dem (og det var så også en opfordring til andre, vi vil meget gerne have dem)

Og sige at det er en ganske fin artikel, dog er der et par småting, som at du giver MS æren for Wordperfect, det er wordperfect vist ked af. MS havde faktisk temmeligt store problemer med at slå igennem, Wordperfect var nok de største, men Lotus og DSI system havde også pæne markedsandele. Men det var jo også den gang vi havde nåleprintere, "RRRRR RR RRRRRRR RRR" top najs... :00

Jeg fortryder stadigt den dag jeg smed min 16mhz intel væk, den var dog vist først købt i 1989-90 det var den gang hardware var moderne længe. Det var jo også en syg computer med hele 40mb harddisk, og vist ikke ret meget ram, den blev senere opgraderet med en hel mb og så fik den windows 3.1. Nu var den faktisk heller ikke en dyr maskine, med det hele og nåleprinter kostede den 8000-10000.

Jeg glemte helt den matematiske CO-processor, det var dengang det var noget man købte ved siden af, har faktisk stadigt manualer til den.

Det var også den gang min far kunne bruge sådan en maskine, AutoCAD og det hele, han fik så aldrig rigtigt brugt den, så nu er han nybegynder.

Tror faktisk først det var i 1991 for det var vist der han blev færdig som byggeteknikker, og så var det muligt for ham at få arbejde som tømre igen, derfor fik han aldrig rigtigt brugt hans ekstra uddannelse til noget.

Men wtf. jeg fik min første computer ud af det, og jeg blev hurtigt nørd.

Har også haft en 40mhz AMD men den fik jeg først noget senere da min onkel skiftede den ud med en 200mhz pentium pro.

#10 jo linux er ejet af Linus Torvalds han tjener faktisk også ganske gode penge på det, han kan da leve af navnet.

Og sige at det er en ganske fin artikel, dog er der et par småting, som at du giver MS æren for Wordperfect, det er wordperfect vist ked af. MS havde faktisk temmeligt store problemer med at slå igennem, Wordperfect var nok de største, men Lotus og DSI system havde også pæne markedsandele. Men det var jo også den gang vi havde nåleprintere, "RRRRR RR RRRRRRR RRR" top najs... :00

Jeg fortryder stadigt den dag jeg smed min 16mhz intel væk, den var dog vist først købt i 1989-90 det var den gang hardware var moderne længe. Det var jo også en syg computer med hele 40mb harddisk, og vist ikke ret meget ram, den blev senere opgraderet med en hel mb og så fik den windows 3.1. Nu var den faktisk heller ikke en dyr maskine, med det hele og nåleprinter kostede den 8000-10000.

Jeg glemte helt den matematiske CO-processor, det var dengang det var noget man købte ved siden af, har faktisk stadigt manualer til den.

Det var også den gang min far kunne bruge sådan en maskine, AutoCAD og det hele, han fik så aldrig rigtigt brugt den, så nu er han nybegynder.

Tror faktisk først det var i 1991 for det var vist der han blev færdig som byggeteknikker, og så var det muligt for ham at få arbejde som tømre igen, derfor fik han aldrig rigtigt brugt hans ekstra uddannelse til noget.

Men wtf. jeg fik min første computer ud af det, og jeg blev hurtigt nørd.

Har også haft en 40mhz AMD men den fik jeg først noget senere da min onkel skiftede den ud med en 200mhz pentium pro.

#10 jo linux er ejet af Linus Torvalds han tjener faktisk også ganske gode penge på det, han kan da leve af navnet.

#12

#8 Jeg tror måske også at Apple skal have deres kredit, for ikke at tale om Xerox. Det undre mig også at apple ikke er nævnt mere. De har trods alt haft stor indflydelse, selvom de mistede store markedsandele allerede i 80'erne.

#13

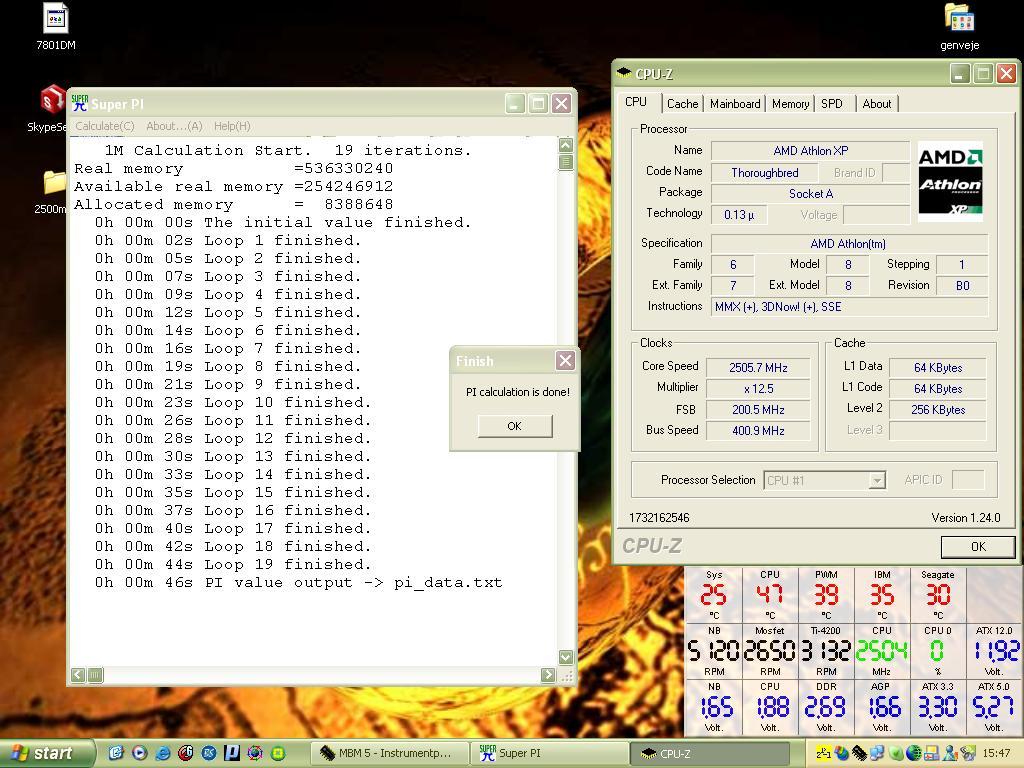

Spændende læsning.. Nu glæder jeg mig bare til der en der skrive noget om de foreskillige CPU procenter AMD vs. Intel osv :D

#14

Det er ikke for at hakke på dit arbejde, for det var godt, men bliver altså lige nød til at presse en lille rettelse til ind.

3dfx var konkurrent til nvidia, og udviklede voodoo kortet som var tæt på revolutionært på spilmarkedet, som et af de første rigtige 3d accelerator kort. At de senere blev opkøbt af nvidia er en anden historie :).

3dfx var konkurrent til nvidia, og udviklede voodoo kortet som var tæt på revolutionært på spilmarkedet, som et af de første rigtige 3d accelerator kort. At de senere blev opkøbt af nvidia er en anden historie :).

#15

(kunne ikke lige finde nogen edit funktion, beklager hvis jeg overså den)

Oh havde lige læst en linje forkert, du skriver det helt korrekt jo, at 3dfx og nvidia var med til at udvikle 3d grafiken. Voodoo fortjener dog stadig at blive nævnt syntes jeg, kan ihvertfald huske den totale facination da jeg første gang startede et 3dfx spil op, det var jo helt vildt så godt det så ud, når man var vandt til software-opløsning :).

Oh havde lige læst en linje forkert, du skriver det helt korrekt jo, at 3dfx og nvidia var med til at udvikle 3d grafiken. Voodoo fortjener dog stadig at blive nævnt syntes jeg, kan ihvertfald huske den totale facination da jeg første gang startede et 3dfx spil op, det var jo helt vildt så godt det så ud, når man var vandt til software-opløsning :).

#16

hehe min første pc blev købt i hmmm 1994 mener jeg....en 66mhz dx2-66 4mb ram, 345mb hdd!!!, 1mb grafikkort 1 3½" floppy og 14" skærm m 800*600 SVGA skærm!...9400kr fra århus pclager eller hvad det hed....det var noget af det vildeste dengang og den holdt i mange år...men blev til sidst smidt på lossepladsen for min athlon k7 500mhz med 12mb 3d gfx kort, 8mb 2d gfx, 128mb ram 6,4gb hdd og SB live lydkort og 10mbit netkort..........som også holdt i 2½-3 år, inden den døde på mystisk vis ved at sætte netstik i???? inden da var den dog blevet opgraderet med 10/100 netkort 128 mb ram yderligere og gf2 mx kort i.....og en 17" skærm!

#17

Sikke dog en gang simplificeret gang ævl. F. eks er WordPerfect ikke lavet af Microsoft, og CERN er ikke et privat firma, men et fælleseuropæisk forskningsproject. Det er godt når folk vil delagtiggøre andre i deres viden, men så check dog det du skriver!

Det er en ommer!

Det er en ommer!

#18

kan huske at mac mente M$ havde stjålet derer idéer.

Har en helt musikvideo der beskriver fænomenet :e

Kan bare ikke lige finde den, men den indeholder massere af klasikkere :e

Har en helt musikvideo der beskriver fænomenet :e

Kan bare ikke lige finde den, men den indeholder massere af klasikkere :e

#19

#18 mac mente at ms havde kikket lidt for meget efter deres system, men faktisk var deres system også en kopi af et Xerox interface fra kopimaskiner

#20

#19: Så lærte man også noget idag :p

#21

Uha uha. Den var jeg SLET ikke glad for at læse.

Han nævner Apple 1 gang, Apple er store idag også. Husk det. Tiger 10.4 er kanont OS. Og hehe, findes til x86 PC'ere.

Han nævner 1 Motorola CPU og siger at der skete ikke mere, men glemmer Amiga/Atari/Mac brugte Motorola som fortsatte med meget stærkere PPC CPU'er. 68000/68010/68020/68030/68040/68060, og coprocesser 68881/68882 (Indbygget i 040 og op). Coltfire som godt nok er lidt glemt. Og PPC op til G4. (G5 er vist IBM's)

(Rettelse, Atari kom vist aldrig til at bruge PPC, men Coltfire fik de til MintOS/TOS)

En lille Vic-20 bliver nævnt i starten. (Dejlig maskine). Ikke mere om det.

HVAD MED COMMODORE C64. Verdens MEST solgte computer. Simpelthen dejlig. Og laves stadig idag, i form af CommodoreOne ATX Bundkort med PCI og jeg skal komme efter dig :)

Til C64 interesserede, hvis nogle er gamle nok til at huske :P, laves Go64! bladet stadig, 12 numre om året. :)

Commodore 16, C+4, Commodore 128, 128D. :)

Alle os der startede på Vic20 og gik til C128/64 og senere Amiga :P hehe. Vi VED hvad computere var. Og PC var absolut ikke værd at tænke på. Spil og programmer for ikke at tale om OS var ringe og bagud. Der blev altid grint af PC'ere i den lokale computer club, den de kunne sgu' ikke engang køre et spil flydende. Og M$ kopierede mere og mere af AmigaOS. Men de kopierer jo stadig som en gal af alt. Og betaler bøder hele tiden for det. (Og så brokker de sig over at vi laver en kopi af windows :P)

Hvor meget jeg gerne ville nævne Pegasos, Pegasos II, AmigaOne og Troika'05 og AmigaOS 4 og Amithlon AmigaOS til Athlon. Ja, så er det desværre nyere end 2000 :) Til Amiga interesserede : AmigaBlade Engelsk Total Amiga 4 numre om året, Tysk AmigaFuture 6 numre om året. Find dem hvis det var noget at lære/læse.

De andre maskiner her, de har faktisk i mine øjne en noget federe historie end de skaldede PC CPU'er og ringe bagudscompatibilitet der skader dem hele tiden. Og Windows som er noget værre skidt, og det bliver absolut ikke bedre i Vista.

Han nævner Apple 1 gang, Apple er store idag også. Husk det. Tiger 10.4 er kanont OS. Og hehe, findes til x86 PC'ere.

Han nævner 1 Motorola CPU og siger at der skete ikke mere, men glemmer Amiga/Atari/Mac brugte Motorola som fortsatte med meget stærkere PPC CPU'er. 68000/68010/68020/68030/68040/68060, og coprocesser 68881/68882 (Indbygget i 040 og op). Coltfire som godt nok er lidt glemt. Og PPC op til G4. (G5 er vist IBM's)

(Rettelse, Atari kom vist aldrig til at bruge PPC, men Coltfire fik de til MintOS/TOS)

En lille Vic-20 bliver nævnt i starten. (Dejlig maskine). Ikke mere om det.

HVAD MED COMMODORE C64. Verdens MEST solgte computer. Simpelthen dejlig. Og laves stadig idag, i form af CommodoreOne ATX Bundkort med PCI og jeg skal komme efter dig :)

Til C64 interesserede, hvis nogle er gamle nok til at huske :P, laves Go64! bladet stadig, 12 numre om året. :)

Commodore 16, C+4, Commodore 128, 128D. :)

Alle os der startede på Vic20 og gik til C128/64 og senere Amiga :P hehe. Vi VED hvad computere var. Og PC var absolut ikke værd at tænke på. Spil og programmer for ikke at tale om OS var ringe og bagud. Der blev altid grint af PC'ere i den lokale computer club, den de kunne sgu' ikke engang køre et spil flydende. Og M$ kopierede mere og mere af AmigaOS. Men de kopierer jo stadig som en gal af alt. Og betaler bøder hele tiden for det. (Og så brokker de sig over at vi laver en kopi af windows :P)

Hvor meget jeg gerne ville nævne Pegasos, Pegasos II, AmigaOne og Troika'05 og AmigaOS 4 og Amithlon AmigaOS til Athlon. Ja, så er det desværre nyere end 2000 :) Til Amiga interesserede : AmigaBlade Engelsk Total Amiga 4 numre om året, Tysk AmigaFuture 6 numre om året. Find dem hvis det var noget at lære/læse.

De andre maskiner her, de har faktisk i mine øjne en noget federe historie end de skaldede PC CPU'er og ringe bagudscompatibilitet der skader dem hele tiden. Og Windows som er noget værre skidt, og det bliver absolut ikke bedre i Vista.

#22

#21 jeg er tilbøjlig til at give dig ret langt hen af vejen, men et sted skulle forfatteren jo stoppe, ellers skal man jo også ha computere som dask med, og hvad med de mere moderne supercomputere.

#23

Hehe. SparcStation :P SGI :P Dejlige maskiner btw. har en SGI kørende her.

#24

Ja, ret skal også være ret - den er altså ikke kun på en halv A4 side.

Der er skam rigeligt med plads på serveren, hvis nogen ønsker om komme med en detaljeret udgave af den :)

Der er skam rigeligt med plads på serveren, hvis nogen ønsker om komme med en detaljeret udgave af den :)

#25

Da jeg læste den var jeg ved at tænke om den skulle laves som en viki, så alle kunne rette og tilføje, så vi kunne få en lang og helt korrekt version af computerens historie.

#26

#5

Hehe, good old days... 😉

Lidt grotest, så lever den gamle Cyrix under navnet Geode, og produceres nu af AMD (men den er absolut ikke blevet bedre... Trust me!)

Endnu mere grotesk, så har VIA stjålet navnet, og ligger stadig til grund for deres Cx cpuer... Som dog er kvalitets medsigt bedre, men performancen ligner måske lidt...

Hehe, good old days... 😉

Lidt grotest, så lever den gamle Cyrix under navnet Geode, og produceres nu af AMD (men den er absolut ikke blevet bedre... Trust me!)

Endnu mere grotesk, så har VIA stjålet navnet, og ligger stadig til grund for deres Cx cpuer... Som dog er kvalitets medsigt bedre, men performancen ligner måske lidt...

#27

Nu har jeg jo haft fornøjelsen af at gennemleve den pågældende periode som bruger af diverse produkter selv.

Gik på gymnasiet fra 81-84 og der havde vi fornøjelsen af at kunne bruge hele 4 terminaler med en arbejdskapacitet på op til 8 kB på den største. Der blev kodet i COMAL. Og vi havde en tilhørende TTY printer (way before matrix printer....LOL).

Synes også der mangler rigtigt meget om Commodore C64 og Amiga serierne. Især fordi de var så store, og fordi de var så geniale.

Jeg boede i USA fra 1984-1986 og der stod der stort set Apple på alt i universitetsmiljøerne. Og der var de nok ~10 år foran Microsoft især mht. GUI

Wordperfect var meget anvendt, men det havde som flere andre også har bemærket intet med MS at gøre.

Men mon ikke mange af os danskere husker DSI-SYS? Både mht. tekstbehandling, regneark, databaser og overordnede menusystemer i DOS?

Jeg kan huske da den første Netscape browser så dagens lys, og hvor vildt det var at kunne gå online på den måde. Hvad med lidt historie om browsere og evt. søgemaskiner på nettet? Der var mere end nok til 2 store artikler.

I det store og hele er det et spændende emne at skrive en artikel om, men det er så omfattende et emne at det nærmest er umuligt at få bare alle de vigtige ting med.

Gik på gymnasiet fra 81-84 og der havde vi fornøjelsen af at kunne bruge hele 4 terminaler med en arbejdskapacitet på op til 8 kB på den største. Der blev kodet i COMAL. Og vi havde en tilhørende TTY printer (way before matrix printer....LOL).

Synes også der mangler rigtigt meget om Commodore C64 og Amiga serierne. Især fordi de var så store, og fordi de var så geniale.

Jeg boede i USA fra 1984-1986 og der stod der stort set Apple på alt i universitetsmiljøerne. Og der var de nok ~10 år foran Microsoft især mht. GUI

Wordperfect var meget anvendt, men det havde som flere andre også har bemærket intet med MS at gøre.

Men mon ikke mange af os danskere husker DSI-SYS? Både mht. tekstbehandling, regneark, databaser og overordnede menusystemer i DOS?

Jeg kan huske da den første Netscape browser så dagens lys, og hvor vildt det var at kunne gå online på den måde. Hvad med lidt historie om browsere og evt. søgemaskiner på nettet? Der var mere end nok til 2 store artikler.

I det store og hele er det et spændende emne at skrive en artikel om, men det er så omfattende et emne at det nærmest er umuligt at få bare alle de vigtige ting med.

#28

#27 og andre hvad med at vi går sammen om en del historie artikler, man kunne jo også tage lydkort, officepakker, spil, chipsæt og meget andet. så hvis steen ikke har noget i mod det kunne vi jo nok skrive 10-20 artikler med historik og etv få dem lagt i en afdeling for sig selv.

#29

I skal være mere end velkommen da :P

Et total nostalgisk "area" 8)

Et total nostalgisk "area" 8)

#30

#28 > Ja det kunne faktisk være meget sjovt, men for pokker det kommer til at tage noget tid... :e

#31

Enhver historie ville nok blive rettet/redigeret. Så den skal kunne diskuteres og rettes i :)

Hvis man vil have en spændende historie skal man virkelig tage Amiga.

Jay Miner som var father of the Amiga. Han lavede Amigaen fordi han havde set bl.a. Fly Simulatorer. Og det mente han bare, at den slags ville han fandme have hjemme i stuen.

Han pantsatte sit hus op til begge ører, og lavede Amiga som var top hemmeligt. Den blev rygtet som gamecomputer men ideen var langt større.

Da den skulle have et OS, og programmøren spurgte hvilket OS den skulle have. Det måtte han helt selv bestemme....... så blev han helt vild. Og lavede AmigaOS som kunne multitaske (Det tog vist 10-15år før PC'en nogenlunde kunne det :P, ja den forsøger stadig :D).

Da koderen sat og ventede på udspillet af Ram i maskinen. Og håbede inderligt på 128kb, eller bare 64kb. Så kom han hjem og sagde 512 kb. Det var hel vildt :) Og så var han stadig stædig nok til at sige at der skulle en udvidelses port i. Selv om det kostede.

Amiga blev lavet til at konkurrere med IBM, og de ville virkelig kunne gøre det. Hvis ikke de havde så meget gæld.

Atari havde budt dem en dårlig pris af $1 pr.aktie, men så var det Commodore ringede dem op og tilbød en bedre pris.

Commodore som ikke engang gad at reklamere for Amiga'en kørte det hele i sænk stille og roligt, de havde kun 1 ting i tankerne. Game Computer. Synd.

Manglende reklame og for mange fejltagelser. Der skulle de have fulgt Macintosh der straks førte systemet over på 601 PowerPC CPU'en og emulerede derfra 68k. (Motorola 68000 serien)

Men jeg er da glad for at de startede. Også selv om det er gået noget ned af bakke. Så er der stadig Amiga folk derude. Og AmigaOS udvikles stadig.

Idag har jeg set Windows 2003 R2 har en dejlig menu i processes hvor du kan vælge hvilken CPU der skal køre en task.

Men i 1996 sad jeg på Amiga og gjorde det samme. Det er nu 10 år siden. Og den valgte virkelig at knokle på 1 CPU, så hele systemet var frit til den anden CPU.

Det var sgu' lidt synd at Microsoft ikke havde udviklet til Amiga istedet, deres Amiga Basic de lavede engang blev senere fjernet, der var 100000 fejl i. En af dem var, du flyttede vinduet og maskinen frøs. :D

Maskinen er ca.14 år nyere. Fra PC Hardware 1971 ?. Det havde været en fordel at arbejde ovenpå og videre.

PS. Jeg har ikke Amiga idag. Men får det :) (Laver en Tablet Amiga snart og skifter nok derfra til en AmigaOS 4 Amiga, nye bundkort er ved at blive lavet.)

Hvis man vil have en spændende historie skal man virkelig tage Amiga.

Jay Miner som var father of the Amiga. Han lavede Amigaen fordi han havde set bl.a. Fly Simulatorer. Og det mente han bare, at den slags ville han fandme have hjemme i stuen.

Han pantsatte sit hus op til begge ører, og lavede Amiga som var top hemmeligt. Den blev rygtet som gamecomputer men ideen var langt større.

Da den skulle have et OS, og programmøren spurgte hvilket OS den skulle have. Det måtte han helt selv bestemme....... så blev han helt vild. Og lavede AmigaOS som kunne multitaske (Det tog vist 10-15år før PC'en nogenlunde kunne det :P, ja den forsøger stadig :D).

Da koderen sat og ventede på udspillet af Ram i maskinen. Og håbede inderligt på 128kb, eller bare 64kb. Så kom han hjem og sagde 512 kb. Det var hel vildt :) Og så var han stadig stædig nok til at sige at der skulle en udvidelses port i. Selv om det kostede.

Amiga blev lavet til at konkurrere med IBM, og de ville virkelig kunne gøre det. Hvis ikke de havde så meget gæld.

Atari havde budt dem en dårlig pris af $1 pr.aktie, men så var det Commodore ringede dem op og tilbød en bedre pris.

Commodore som ikke engang gad at reklamere for Amiga'en kørte det hele i sænk stille og roligt, de havde kun 1 ting i tankerne. Game Computer. Synd.

Manglende reklame og for mange fejltagelser. Der skulle de have fulgt Macintosh der straks førte systemet over på 601 PowerPC CPU'en og emulerede derfra 68k. (Motorola 68000 serien)

Men jeg er da glad for at de startede. Også selv om det er gået noget ned af bakke. Så er der stadig Amiga folk derude. Og AmigaOS udvikles stadig.

Idag har jeg set Windows 2003 R2 har en dejlig menu i processes hvor du kan vælge hvilken CPU der skal køre en task.

Men i 1996 sad jeg på Amiga og gjorde det samme. Det er nu 10 år siden. Og den valgte virkelig at knokle på 1 CPU, så hele systemet var frit til den anden CPU.

Det var sgu' lidt synd at Microsoft ikke havde udviklet til Amiga istedet, deres Amiga Basic de lavede engang blev senere fjernet, der var 100000 fejl i. En af dem var, du flyttede vinduet og maskinen frøs. :D

Maskinen er ca.14 år nyere. Fra PC Hardware 1971 ?. Det havde været en fordel at arbejde ovenpå og videre.

PS. Jeg har ikke Amiga idag. Men får det :) (Laver en Tablet Amiga snart og skifter nok derfra til en AmigaOS 4 Amiga, nye bundkort er ved at blive lavet.)

#32

hvis folk er intresseret skal jeg nok stå for kordineringen og lign af opgave, så hvis i er intresseret i at deltage kan i jo lige smide mig en mail.

#33

hej.

Synes det er fedt at du vil bruge tid på at skrive en forholdsvis lang artikel, thumps up! :)

Men, må dog pointe nogle ting ud :/ :

Processordelen i artiklen er jeg lidt ked af. Du starter egentlig med 386 hvilket jeg synes er synd. 8086 (og 8087 som var CO-processor til flydende tal) dannede grundlag (på et andet grundlag - som altid) til 286 som introducerede "protected mode" som gør at XP, Linux osv. er sikrere end fx DOS. 286 dannede grundlag for 386 som introducerede 32 bit og siden da er der kommet forskellige instruction set til, som for eksempel MMX. Men egentlig, er det først med vores dejlige 64 bit processorer at der er sket en, hhm, evolution :)

Du skriver også at man ikke kunne vælge andre styresystemer. Dette er falsk, der var mange - nogle billige og andre dyre. Der var fx Minix som kostede 69 $. Da Linus Thorvald skrev Linux havde han Minix på sin computer, og mange idéer i Linux kommer fra Minix. Minix er skrevet af Andrew Tanenbaum og han har udgivet flere bøger om sit Minix styresystem (har lige købt den seneste men desværre ikke fået den endnu) og om OS-design. Den egentlig grund til at skrive Linux og ikke bruge Minix, var at Minix havde for få programmer osv. Andrew Tanenbaum ville ikke gøre det større da han så ikke kunne undervise sine "students" i Minix og OS programmering. Så altså, idéen om Linux kommer fra Minix og Andrew Tanenbaums bøger.

"Sammen med Nvidia bragte de igen en ny standart til grafik sektoren, dette var bla muligt pga. Windows 95 som kunne håndtere 3D." <- DOS kan håndtere 3D? alle processorer kan sådanset rendere 3D hvis de bare har styrke nok og det har en 16,7 mhz ARM processor også :)

"Få måneder efter udkommer Win98, som egentlig bare er en stor opdatering af Win95, men med mange store huller i bla. sikkerhed der var blevet lappet!" <- Forstår ikke helt sætningen? Men ja, Windows 98 var ikke nogen stor opdatering arkitekturmæssigt, og det var Windows ME bestemt heller ikke.

"Heldigvis skete der intet! Det eksperterne frygtede, var at alle computere kun kunne håndtere "19xx tal", så når året skiftede til 2000, ville de to sidste tal "00" blive fortolket af computeren som om det var 1900. der kom nogle få reaktioner, men intet af betydning!" <- Dette er ikke helt korrekt. Der skete ikke det store ved det, men faren var reel. Grunden til at der ikke skete noget, var at man kendte til problemet. Hvis ikke man havde forberedt sig, ville fx mange banksystemer bryde sammen. I virkeligheden har man kendt problemet i meget lang tid. Det var et sted i 70'erne det virkelig begyndt at blive et problem. Dengang havde mange programmer kun gemt datoer som måned/dag, og når man så kom ind i et nyt år blev det resat til 1. Jan samme år. Så lagrede man det som Måned/dag/et-cifre-år men det blev igen et problem når man kom i et nyt årti. Og så var der jo årtusindårsskiftet. Før i tiden regnede man slet ikke med at software kunne holde så lang tid.

Lidt comments... ikke tag det som negativ kritik men som konstruktiv kritik :) Igen, synes det er fedt med gæsteartikler.

Synes det er fedt at du vil bruge tid på at skrive en forholdsvis lang artikel, thumps up! :)

Men, må dog pointe nogle ting ud :/ :

Processordelen i artiklen er jeg lidt ked af. Du starter egentlig med 386 hvilket jeg synes er synd. 8086 (og 8087 som var CO-processor til flydende tal) dannede grundlag (på et andet grundlag - som altid) til 286 som introducerede "protected mode" som gør at XP, Linux osv. er sikrere end fx DOS. 286 dannede grundlag for 386 som introducerede 32 bit og siden da er der kommet forskellige instruction set til, som for eksempel MMX. Men egentlig, er det først med vores dejlige 64 bit processorer at der er sket en, hhm, evolution :)

Du skriver også at man ikke kunne vælge andre styresystemer. Dette er falsk, der var mange - nogle billige og andre dyre. Der var fx Minix som kostede 69 $. Da Linus Thorvald skrev Linux havde han Minix på sin computer, og mange idéer i Linux kommer fra Minix. Minix er skrevet af Andrew Tanenbaum og han har udgivet flere bøger om sit Minix styresystem (har lige købt den seneste men desværre ikke fået den endnu) og om OS-design. Den egentlig grund til at skrive Linux og ikke bruge Minix, var at Minix havde for få programmer osv. Andrew Tanenbaum ville ikke gøre det større da han så ikke kunne undervise sine "students" i Minix og OS programmering. Så altså, idéen om Linux kommer fra Minix og Andrew Tanenbaums bøger.

"Sammen med Nvidia bragte de igen en ny standart til grafik sektoren, dette var bla muligt pga. Windows 95 som kunne håndtere 3D." <- DOS kan håndtere 3D? alle processorer kan sådanset rendere 3D hvis de bare har styrke nok og det har en 16,7 mhz ARM processor også :)

"Få måneder efter udkommer Win98, som egentlig bare er en stor opdatering af Win95, men med mange store huller i bla. sikkerhed der var blevet lappet!" <- Forstår ikke helt sætningen? Men ja, Windows 98 var ikke nogen stor opdatering arkitekturmæssigt, og det var Windows ME bestemt heller ikke.

"Heldigvis skete der intet! Det eksperterne frygtede, var at alle computere kun kunne håndtere "19xx tal", så når året skiftede til 2000, ville de to sidste tal "00" blive fortolket af computeren som om det var 1900. der kom nogle få reaktioner, men intet af betydning!" <- Dette er ikke helt korrekt. Der skete ikke det store ved det, men faren var reel. Grunden til at der ikke skete noget, var at man kendte til problemet. Hvis ikke man havde forberedt sig, ville fx mange banksystemer bryde sammen. I virkeligheden har man kendt problemet i meget lang tid. Det var et sted i 70'erne det virkelig begyndt at blive et problem. Dengang havde mange programmer kun gemt datoer som måned/dag, og når man så kom ind i et nyt år blev det resat til 1. Jan samme år. Så lagrede man det som Måned/dag/et-cifre-år men det blev igen et problem når man kom i et nyt årti. Og så var der jo årtusindårsskiftet. Før i tiden regnede man slet ikke med at software kunne holde så lang tid.

Lidt comments... ikke tag det som negativ kritik men som konstruktiv kritik :) Igen, synes det er fedt med gæsteartikler.

#34

All hail lerbech!

May his reign be prosperous

May his reign be prosperous

#35

mindre fejl med den første processor.

Der bliver skrevet 80386 - den første var en 8088 derefter en 8086 på hele 4 Mhz

Der bliver skrevet 80386 - den første var en 8088 derefter en 8086 på hele 4 Mhz

#36

Jeg mener nu at Windows 2000 udkom i 1999 - står også "Copyright 1985-1999" i "Win2k opstart"...

#37

Der er altid småfejl - for faen vi er jo kun mennesker. :P

Men i det store hele, er det pisse interessant læsning.

Jeg kan kun personligt og på vegne af hwt, opfordre andre til at gøre det samme som Mentos.

Men i det store hele, er det pisse interessant læsning.

Jeg kan kun personligt og på vegne af hwt, opfordre andre til at gøre det samme som Mentos.

#38

i tar allesammen fejl

i den udemærkede artikel er der kun en fejl og det er titlen :))

sjov læsning men lever ovehovedet ikke op til den....

i den udemærkede artikel er der kun en fejl og det er titlen :))

sjov læsning men lever ovehovedet ikke op til den....

#39

fint, så kan du tage turen tilbage til ligegyldige hol.dk .......

der er meget guf, og self kan 1 mand ikke have det hele på de få sider...og der kan da opstå nogle fejl undervejs....men ideen og input fra alle mulige her i denne tråd gør den da ekstrem hyggelig....længe siden jeg har brugt så meget tid på at læse folks indlæg til en tråd.

der er meget guf, og self kan 1 mand ikke have det hele på de få sider...og der kan da opstå nogle fejl undervejs....men ideen og input fra alle mulige her i denne tråd gør den da ekstrem hyggelig....længe siden jeg har brugt så meget tid på at læse folks indlæg til en tråd.

#40

OK artikel - de faktuelle fejl er vist påpeget, men thumbs up for initiativet! Ros til det - et JFK citat forude: "Don't ask what your country can do for you - ask yourself what you can do for your country" * Altså, flere gæsteartikler er særdeles velkomne!

Tomgun

* Efter fri erindring.

Tomgun

* Efter fri erindring.

#41

Revolution OS - gandske god dokumentar, med en masse historire.. primært om linux's oprindelse såvidt jeg husker :)

#42

Nostalgi.... får helt lyst til at støve min c64 af!!

#43

jeg ved godt der kan være lidt fejl :r

men er da glad for at artiklen kunne bruges til noget...

hvis ikke informativt, så til lidt debat ;)

(har først kunne svare nu, er lige kommet hjem fra ferie :D )

men er da glad for at artiklen kunne bruges til noget...

hvis ikke informativt, så til lidt debat ;)

(har først kunne svare nu, er lige kommet hjem fra ferie :D )

#44

kan stadig huske min commodore 128D, den spillede jeg sku mange timer på i sin tid........

#45

#33 Det er rigtigt at Linux, har lånt en del af Tannenbaums Minix (MiniUnix) , som jo egentlig bare er hans version af noget meget større der hedder UNIX...... men så er vi vist mere ovre i server miljø.

#46

Flot stykke arbejde, god læsning men check lige digibarn computer museum, så de sidste sten falder på plads.

digibarn.com -

digibarn.com -

#47

Fed læsning... og nu kommer det pinlige spørgsmål så:

Det var i 2001 Win XP udkom ikke? kunne ikke finde det på google? ?:(

Det var i 2001 Win XP udkom ikke? kunne ikke finde det på google? ?:(

![[G.N.U.]](/images/users/profile/36302.jpg)