GeForce 9800GTX ydelses spekulationer.

Grafikkort d. 26. februar. 2008, skrevet af Gripen90

Vist: 1174 gange.

Gripen90

#0

Hvis følgende passer ser det ud som om GeForce 9800GTX bare er endnu et kort i stakken af grafikkort, der næppe bliver afsat - dvs muligvis dele 8800Ultra's skæbne.

http://www.fudzilla.com/index....

Utrolige 14'014point i 3Dmark06 på en Intel C2D X9650 Extreme 3GHz.

http://en.expreview.com/2008/0...

Som sædvanlig er der ingen kommentarer fra nVidia... men come on, kan det virkelig passe at det voldsomme 9800GTX bare er 8800GT på steroider... og endda meget lidt. 😕

http://www.fudzilla.com/index....

Utrolige 14'014point i 3Dmark06 på en Intel C2D X9650 Extreme 3GHz.

http://en.expreview.com/2008/0...

Som sædvanlig er der ingen kommentarer fra nVidia... men come on, kan det virkelig passe at det voldsomme 9800GTX bare er 8800GT på steroider... og endda meget lidt. 😕

#1

Det skulle være ca 10-20% hurtigere end et 8800Ultra

#2

#1: Jeps det var også hvad jeg har hørt... men jeg ville se et par resultater før jeg ville tro på det... nu tror jeg så på det 😩

#3

Hej Gripen

super info, takker - jeg har nemlig en kammi, som måske ville vente på det 9800GTX men det kan jeg så fortælle ham, at han IKKE skal 🙂

og så gør det jo ikke ens riska-moddede 3870 dårligere synes jeg hehe

det kan man jo fint klare sig med indtil juni hvor 4870 lander... det ser da ud til at ATI/AMD har skudt papegøjen og har lavet en "intel C2D anno 2006" opmærksomhed?

men nu bliver nvidia jo også snart opslugt af intel? 😲

super info, takker - jeg har nemlig en kammi, som måske ville vente på det 9800GTX men det kan jeg så fortælle ham, at han IKKE skal 🙂

og så gør det jo ikke ens riska-moddede 3870 dårligere synes jeg hehe

det kan man jo fint klare sig med indtil juni hvor 4870 lander... det ser da ud til at ATI/AMD har skudt papegøjen og har lavet en "intel C2D anno 2006" opmærksomhed?

men nu bliver nvidia jo også snart opslugt af intel? 😲

#4

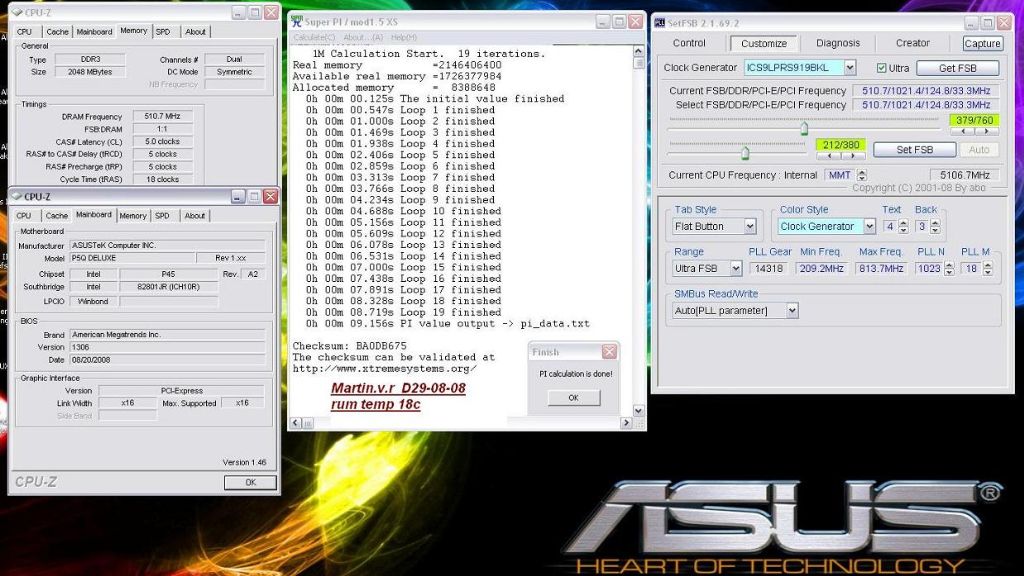

Intel Core 2 Quad QX9650, 2 mb ram = 14.014 i 3dmark 06 i en første test

#5

Måske begynder det at vende til ATI's fordel. Med alle de kort de smider på markedet får de skabt godt med opmærksomhed.

#6

#5 ja og så til de priser 🙂 et 4870 kommer heller ikk til at koste mere end et 3870 gør i dag 😎

#7

Så tror jeg bare jeg vmodder mit BFG8800GTX WC-E som jeg købte til 3k i sommers og venter til næste generation....

#8

http://www.octeamdenmark.com/f...

Tjek her. der er ikke meget power i det kort hvis disse data er ægte

Tjek her. der er ikke meget power i det kort hvis disse data er ægte

#9

Nu heller ikke fordi jeg ville købe et HD4870 eller 9800GTX. Kan ikke betale sig. 🙂

#10

vis det kun bliver et 8800GT på steroider tyder det jo ikke godt 😕 nå hvad fanden ejg skal havde mig et HD4870 X2 alige vil men altid godt vis det var noget til FPS toserne 😉 (det var venligt ment 😛 ) 🙂

#11

9# og hvorfor kan det ikke det fårstå ikke lige hvad du mener vis du emner du ikke vile købe det fordi du ikke har brog for det er det jo en ting men du andre jo ikke hvad ydelsen vil blive så vidt jeg ved er der da ikke komet nolge test af HD4870 ellers link 😉 så du ved jo ikke om det fekmpel banker et 8800ultre totalt bare et eksempel så vil det jo fitn kune betale sig ifor hol det 8800GT 🙂

#12

Det er skuffende fra Nvidias side hvis de ikke laver noget nyt... Men har på fornemmelsen af at de har noget i baghånden. Der var også denne artikel for et stykke tid siden herinde hvor det blev sat at Nvidia ville udnytte sin førerposition og vente med deres "monster" til der var brug for det.

hvis dette passer har de bare prakket os 9800 Serien på os bare for at trække tiden ud. Dog vil 9800GX2 jo stadig krølle Ati´s 3870X2 fuldstændig sammen, men synes da ærlig talt vi har set nok til G80/92... Nu må de da videre! Shame on you nvidia

hvis dette passer har de bare prakket os 9800 Serien på os bare for at trække tiden ud. Dog vil 9800GX2 jo stadig krølle Ati´s 3870X2 fuldstændig sammen, men synes da ærlig talt vi har set nok til G80/92... Nu må de da videre! Shame on you nvidia

#13

12# jo men er det ikke mest fær at samene ligne det med ders 48 sere når den komer for mig iverfal høre HD3870 serie VS 8800 serie sån har jeg det iverfal 🙂

og jeg tro så at HD4870X2 krøler 8800GX2 samen gleder mig til det kort 😀

og jeg tro så at HD4870X2 krøler 8800GX2 samen gleder mig til det kort 😀

#14

Jep lige mine ord.. men de skal jo tjene penge lige som alle andre

#15

14# hviket nr raferare du til ?

#16

#11 Jeg har lige opgraderet og har ikke brug for nyt GFX, og så tror jeg ikke ydelsen bliver så sindsyg vild at jeg ville betale for den. 🙂

#17

#13

mest fær at samene ligne det med ders 48 sere når den komer for mig iverfal høre HD3870 serie VS 8800 serie

Saiot... Det er da en gang gas at lukke ud! 8800 kom i 2006

mest fær at samene ligne det med ders 48 sere når den komer for mig iverfal høre HD3870 serie VS 8800 serie

Saiot... Det er da en gang gas at lukke ud! 8800 kom i 2006

#18

17# nå ja det er mig der ikke kan ringe 8800GT se hvor tiden går 😉

#19

17# men mener stri at ATI lavet det som et mod svar til 8800 serien men gider ikke at diskoetre med dig Webnik fordi du ikke gider se på fakta og holder stri fat fordi du er fan boy 🙂

#20

#18

nå ja det er mig der ikke kan ringe 8800GT se hvor tiden går

Ringe? Regne?

De trækker tiden, latterligt at gøre dette, men det kan vi jo ikke gøre noget ved ☹

Dog er en ting sikkert:

Som tingene er nu yder nvidia stadig bedst i de fleste spil... Så må vel en tur på GX2 vogen og se hvad det kan præstere... Hvis Ati kommer med deres nye serie og det ellers virker pænt godt i andet end benchmarks skal jeg sku da også prøve det. Hvis der ikke sker noget i den anden lejr 😎

nå ja det er mig der ikke kan ringe 8800GT se hvor tiden går

Ringe? Regne?

De trækker tiden, latterligt at gøre dette, men det kan vi jo ikke gøre noget ved ☹

Dog er en ting sikkert:

Som tingene er nu yder nvidia stadig bedst i de fleste spil... Så må vel en tur på GX2 vogen og se hvad det kan præstere... Hvis Ati kommer med deres nye serie og det ellers virker pænt godt i andet end benchmarks skal jeg sku da også prøve det. Hvis der ikke sker noget i den anden lejr 😎

#21

20# Regne vis det betyder det med + og - ved ikke hvorfor men min øverste del er lige gådet i dvale så kan ikke helt tænke er mega trat soory 😳

#22

#19

men gider ikke at diskoetre med dig Webnik fordi du er sådan en Nvida fan boy

Hvad skulle det nu til for? Du fatter da hat

men min øverste del er lige gådet i dvale

Det behøver du ikke undskylde, my bad, har jo vidst dette i flere måneder 😉

men gider ikke at diskoetre med dig Webnik fordi du er sådan en Nvida fan boy

Hvad skulle det nu til for? Du fatter da hat

men min øverste del er lige gådet i dvale

Det behøver du ikke undskylde, my bad, har jo vidst dette i flere måneder 😉

#23

22# gør jeg det var sku da ikke mig der sage at ATI ikke havde bedre billket kvalitet og alt det psi selv om det er lavet flere test der viser det jeg siger jo hiller ikke at Nvida har dåliger FPS ind ATI vil :no:

edit

22# du er sjov var så tager du det her ud af konteks

men min øverste del er lige gådet i dvale så akn ikke helt tænke er mega trat soory

Det behøver du ikke undskylde, my bad, har jo vidst dette i flere måneder

edit

22# du er sjov var så tager du det her ud af konteks

men min øverste del er lige gådet i dvale så akn ikke helt tænke er mega trat soory

Det behøver du ikke undskylde, my bad, har jo vidst dette i flere måneder

#24

Jeg tror at Nvidia venter, til 10xxx med at unleashe deres killer.

Det lyder også vildere med 10000 serien.

Det lyder også vildere med 10000 serien.

#25

24# for mig virker det dumt så kan man jo altid siger jamen de venter bare syns sku man skal kome med hvad man har så vi kan køre crysis på hørjste opløsning med 100 FPS :yes:

#26

#25

syns sku man skal kome med hvad man har så vi kan køre crysis på hørjste opløsning med 100 FPS

Hvis du nu læser #20 igen er det nøjagtig hvad jeg siger... Ellers kan nvidia sku kysse mig der hvor jeg er højst når jeg plukker jordbær! Jeg vil nøjagtig det samme som andre! Have noget der rykker! Så er jeg ligeglad med hvad der står på det så længe det virker!

At du så kalder mig fan-boy kan jeg kun grine af! For hvad jeg siger passer sku! Jeg spiller selv crysis! Har prøvet det på Ati´s nuværende kort og det er bare ikke så hurtigt som nvidia! Dette gør mig vel ikke til fan-boy?

Om der er bedre billede på en CRT kan jeg ikke bruge til noget på min TFT vel 😉 Har haft 3870 på prøve og det var hverken bedre eller ringere end 8800GT mht billede...

Edit: kan se du har redigeret din billedkvalitet snak væk igen fra #21

syns sku man skal kome med hvad man har så vi kan køre crysis på hørjste opløsning med 100 FPS

Hvis du nu læser #20 igen er det nøjagtig hvad jeg siger... Ellers kan nvidia sku kysse mig der hvor jeg er højst når jeg plukker jordbær! Jeg vil nøjagtig det samme som andre! Have noget der rykker! Så er jeg ligeglad med hvad der står på det så længe det virker!

At du så kalder mig fan-boy kan jeg kun grine af! For hvad jeg siger passer sku! Jeg spiller selv crysis! Har prøvet det på Ati´s nuværende kort og det er bare ikke så hurtigt som nvidia! Dette gør mig vel ikke til fan-boy?

Om der er bedre billede på en CRT kan jeg ikke bruge til noget på min TFT vel 😉 Har haft 3870 på prøve og det var hverken bedre eller ringere end 8800GT mht billede...

Edit: kan se du har redigeret din billedkvalitet snak væk igen fra #21

#27

#25 det er ikke dumt, det er smart og snedigt af Nvidia, og mega kedeligt for os forbrugere.....

Det er ligesom olie/benzin selskaberne, de har allerede teknologien til billigere og renere brændstof, men de giver ikke folk lov til at lave motorere, eller maskiner der kan køre på det, da de skal malke den til sidste råoliedråbe der er tilbage...

Det er ligesom olie/benzin selskaberne, de har allerede teknologien til billigere og renere brændstof, men de giver ikke folk lov til at lave motorere, eller maskiner der kan køre på det, da de skal malke den til sidste råoliedråbe der er tilbage...

#28

26# jamen jeg er da lige glad om du ikke kan se det bedre billdet de har det og det er jo bevist bare fordi du køre med tft gør jo ikke at de ikke har det jeg kørete med 1 GB ram på et tidspunkt der vile jeg vove at påstå at det var lige fedt om jeg haveHD3870 eller 8800GT for FPS stank og var langt under hvad jeg har nu så det var mangle på ram så siger jeg jo hiler ikke at 8800GT ikke har flere FPS så gruden til jeg kaler dig en fan boy er du ikke ser på fakta om du så ikke kan se det på din skærm er jeg jo lidt lige glad med 😉 men godt vi er enige med at de skal lose et godt kort ud

edit har ikke pilet ved 21# tro du sover 😉

edit har ikke pilet ved 21# tro du sover 😉

#29

Der var en grund til at nVidia "dræbte" T-Bufferen, som ellers var noget af en brugbar feature udviklet af 3DFx...Hvis T-Bufferen fik en god HW revival så ville FPS debatten være næsten en saga blot.

#31

#30: 3DFx geniale svar på naturlige blur-effekt som man har på TV og film mv, hvilket bevirkede at man kunne få en flydende spil oplevelse selv med lavere FPS, og samtidig fik man en TV-lignende fornemmelse ved at spille. Det havde også en positiv indflydelse på antialiasing effekten.

The T-buffer's primary task is to solve the aliasing problem in 3d graphics. In a nutshell, aliasing is under-sampling of an image, which causes graphical artifacts on screen. Examples of aliasing artifacts include jagged edges on polygons, and pixel popping or "sparkling" while approaching complex or finely detailed objects. The T-buffer will allow for full screen antialiasing in real time. So what you say? Other cards have bragged about antialiasing for a while now, but 3dfx dismisses those implementations are hacks which are not practical for use in games. 3dfx's implementation will work without compatibility problems or speed hit.

The T-buffer does a lot more than full scene antialiasing, but the other features are ones that have to be specifically implemented by game developers. Keeping in tune with the goal of "Hollywood on a desktop," the four other features were: real time motion blur, depth of field blur, soft shadows, and soft reflections. These tools will enable game developers to create the same kinds of effects that Hollywood directors use all the time when making films.

http://www.firingsquad.com/fea...

Der er stadig en arv fra T-Bufferen på nVidia kortene... men de kunne have blevet meget bedre og mere effektivt hvis 3DFx havde stået for det - uden tvivl !

The T-buffer's primary task is to solve the aliasing problem in 3d graphics. In a nutshell, aliasing is under-sampling of an image, which causes graphical artifacts on screen. Examples of aliasing artifacts include jagged edges on polygons, and pixel popping or "sparkling" while approaching complex or finely detailed objects. The T-buffer will allow for full screen antialiasing in real time. So what you say? Other cards have bragged about antialiasing for a while now, but 3dfx dismisses those implementations are hacks which are not practical for use in games. 3dfx's implementation will work without compatibility problems or speed hit.

The T-buffer does a lot more than full scene antialiasing, but the other features are ones that have to be specifically implemented by game developers. Keeping in tune with the goal of "Hollywood on a desktop," the four other features were: real time motion blur, depth of field blur, soft shadows, and soft reflections. These tools will enable game developers to create the same kinds of effects that Hollywood directors use all the time when making films.

http://www.firingsquad.com/fea...

Der er stadig en arv fra T-Bufferen på nVidia kortene... men de kunne have blevet meget bedre og mere effektivt hvis 3DFx havde stået for det - uden tvivl !

#32

#28

jamen jeg er da lige glad om du ikke kan se det bedre billdet de har det og det er jo bevist bare fordi du køre med tft gør jo ikke at de ikke har det

så gruden til jeg kaler dig en fan boy er du ikke ser på fakta om du så ikke kan se det på din skærm er jeg jo lidt lige glad med

Kom med det bevis! Link?

edit har ikke pilet ved 21# tro du sover

Næh! Hint: Husk nu det med den dvalen..

jamen jeg er da lige glad om du ikke kan se det bedre billdet de har det og det er jo bevist bare fordi du køre med tft gør jo ikke at de ikke har det

så gruden til jeg kaler dig en fan boy er du ikke ser på fakta om du så ikke kan se det på din skærm er jeg jo lidt lige glad med

Kom med det bevis! Link?

edit har ikke pilet ved 21# tro du sover

Næh! Hint: Husk nu det med den dvalen..

#33

#32: http://www.maximumpc.com/artic...

THE BOTTOM LINE

The good news for anyone shopping for a new videocard is that you don't need to sacrifice image quality for performance. Based on our blind tests, the GPUs from both AMD and Nvidia deliver similar visual quality with games, high-definition video, and digital photos.

Burde vise at forskellen er ubetydeligt.

THE BOTTOM LINE

The good news for anyone shopping for a new videocard is that you don't need to sacrifice image quality for performance. Based on our blind tests, the GPUs from both AMD and Nvidia deliver similar visual quality with games, high-definition video, and digital photos.

Burde vise at forskellen er ubetydeligt.

#34

32# sente jeg dig sidste gnag gider alser ikke til at finde det igen har være poste i en i den sidste tård + en adne før gider ikke bruge ½time på at søge her i forumet efter det

#35

#33

Læser det lige efter jeg har luret film, takker! Jeg kan ihvertfald ikke se forskel!

#34

hvorfor vidste jeg du ville sige det? 😲

Læser det lige efter jeg har luret film, takker! Jeg kan ihvertfald ikke se forskel!

#34

hvorfor vidste jeg du ville sige det? 😲

#36

35# her smarte fnadt det http://www.computerbase.de/art...

men det er der for jeg ikke gider diskotere med dig

og kan godt være forsklen ikke kan ses på TFT men den er der jo som flere gange er blive bevist og om den er lille er jo lidt ligegyldi

edit her er den støreste forskel

http://www.computerbase.de/art...

men det er der for jeg ikke gider diskotere med dig

og kan godt være forsklen ikke kan ses på TFT men den er der jo som flere gange er blive bevist og om den er lille er jo lidt ligegyldi

edit her er den støreste forskel

http://www.computerbase.de/art...

#37

#36: Jeg har læst den test igennem 4 gange for at finde noget der konkret beskriver billedkvalitets forskelle på ÁTi/nVidia, men jeg finder intet 😐

#38

#36

og kan godt være forsklen ikke kan ses på TFT

Godt så! Så husk det til næste gang den plade spiller og du skal råde folk til nyt grafikkort... Især hvis de skal bruge det til andet end bench 😉

Kig i folks profil og bliv overrasket over hvor mange der har en TFT

og kan godt være forsklen ikke kan ses på TFT

Godt så! Så husk det til næste gang den plade spiller og du skal råde folk til nyt grafikkort... Især hvis de skal bruge det til andet end bench 😉

Kig i folks profil og bliv overrasket over hvor mange der har en TFT

#39

38# 1 jeg ved ikke om det ikke kan ses det er jo dig der siger det 😉 og du skal ikke bestme hvad jeg råder folk til har også tit rådet folk til et 8800GT for jeg er ikke fanadisk som andre host host

#40

#39

jeg ved ikke om det ikke kan ses det er jo dig der siger det

Hvorfor siger du det så 🤡 Jeg har i det midste selv prøvet det!

Om jeg er fanatisk eller bare ser morskaben i at nedlægge din uvidenhed og øregas kan jo så diskuteres og hvor slemt det i virkeligheden er... pick one, dont care 😉

jeg ved ikke om det ikke kan ses det er jo dig der siger det

Hvorfor siger du det så 🤡 Jeg har i det midste selv prøvet det!

Om jeg er fanatisk eller bare ser morskaben i at nedlægge din uvidenhed og øregas kan jo så diskuteres og hvor slemt det i virkeligheden er... pick one, dont care 😉

#41

40# hvad har jeg sagt der er uviden de bilder der viser der er forksel om man så ikke kan se det på en TFT som det tyder på " fat det " er jeg pise lige glad med for det er ikke det det hanler om det hanler om der ren faktis er en forskel og det er der iverfal på CRT om så de felste TFT skærme er få dålige fave mesige tila t vise det ja det er jo bare noget lort :yes:

men ftater ikke hvor jeg diskotere med dig du er jo mega barnlig du ikke kan klare at der er noget der et bedre bilet ind nvida kort 😲

men ftater ikke hvor jeg diskotere med dig du er jo mega barnlig du ikke kan klare at der er noget der et bedre bilet ind nvida kort 😲

#42

Jeg kunne intet se til forskel i Crysis, men i den der der bliver linket til med call of juarez, kan jeg godt begynde at ane en forskel, mest i solstrålerne, og buskenes blade og græsset.

Men det er ikke den STORE forskel der ligefrem ødelægger oplevelsen.

PS. kan i ikke tage den her diskution over et par øller, og aldrig mere kaste med mudder herinde ang. hvad der ser bedst ud på en tft eller hvad det er i diskutere om?

Men det er ikke den STORE forskel der ligefrem ødelægger oplevelsen.

PS. kan i ikke tage den her diskution over et par øller, og aldrig mere kaste med mudder herinde ang. hvad der ser bedst ud på en tft eller hvad det er i diskutere om?

#43

42# er der nolge der har sagt det 😛 det er bare Webnik der ikke kan klare der er en forksle jeg har prasonlig aldri sagt jeg kan se kempe forskel men det er jo fakta der er en om den så ikke er så store ja det er en anden snakr men den er der 😉 det vil Webnik bare ikke aksemtere

#44

#43

nu skal du vist heller ikke sidde der og blive for hellig knægt. Der skal to til en diskussion(mindst) og du holder dig sgu heller ikke tilbage. Så stop det pis med at give Webnik skylden.

nu skal du vist heller ikke sidde der og blive for hellig knægt. Der skal to til en diskussion(mindst) og du holder dig sgu heller ikke tilbage. Så stop det pis med at give Webnik skylden.

#45

saiot prøv at læse testen i #33.

#46

44# hvad er jeg helig med vis du læser op af den her tråd har jeg flere gange sagt at der er forskel men om man om man så kun kune se den på en cRT er en anden sag har flere gange givet det udtyht mens Webnik siger flere gange at der ingen forksle er over hovet og komer med en kormentat som i 35# så syns sån set ikke jeg har gjort noget glat jeg har flere gange sagt jeg inte havde mod nvida og de har da bedre FPS men det er bare fakta ATI har bedre billet hvor han bliver ved så kan ikke se jeg har gjort noget så skyder sku ikke skyling på ham siger bare hvad der er sket garmelfar 😉

ps og jeg er sku ingen knægt

ps og jeg er sku ingen knægt

#47

45# har læst din opsomeren er det ikke nok orker ærligt talt ikke læse så meget har ikke sovet nok i nat 😳 men jeg holder mig bare til hvad jeg kan se på den test jeg linket til i de billder og hvad Riska har sagt mener også har sagt det Martin v.r men de har jo også CRT

#48

#46

Ikke for at være et dumt svin eller noget, men jeg gider ikke nærlæse hele tråden igennem for jeg fatter ikke ca halvdelen af hvad der står.

Ikke for at være et dumt svin eller noget, men jeg gider ikke nærlæse hele tråden igennem for jeg fatter ikke ca halvdelen af hvad der står.

#49

48# ikke for at være flabet men er det ikke dum at kome med sådan en udtaelse så når du ikke har læst hvad jeg byger den på 😕

#50

#49

du bliver ved hvad.. Der er ingen der gider diskutere med dig. Kan du ikke forstå det, og endnu færre der gider læse det. jo jeg har læst den i store træk.

du bliver ved hvad.. Der er ingen der gider diskutere med dig. Kan du ikke forstå det, og endnu færre der gider læse det. jo jeg har læst den i store træk.

#51

50# det er sku dig der blive ved med at tale ned til mig :no: jeg kan ikke se jeg diskotere det enste jeg konste tere er du komer med en udtalese du byger på nolge l'st læsning i tråden men gider ikke det her det sker jo vær gang Webnik og undertagnet komer op og diskotere 😀 men hyg dig garmle far kan jeg jo akle dig når du kaler mig knægt selv om du ikke ander hvor mange år jeg er 🤣

#53

52# hvor fanden ved du det fra 😐 du gør mig sku bange 😲 kender du også min adrase, 😐

#54

#53

du skrev engang en tråd hvor i du fortalte lidt om dig selv og hvorfor du skriver som du gør. og der skrev du din alder.

#55

54# damm du husker godt 😀 🙂

#56

#47: Jeg har nu både TFT og CRT skærm, ganske vist en ældre 20" crt og 20kg tung Iiyama sag med god billedkvalitet, den var blandt toppen i sin tid. Jeg har "leget" med grafikkort siden 1996, og hvad der ikke har været af kort igennem mine hænder ja det vil du ikke vide. Jeg tror, at jeg fra sidste optælling har haft 106 grafikkort i hænderne siden 97 - vanvittigt, ja jeg ved det, men NoNig har også haft sådan en mani 😉

Jeg vil sige, at vi skal langt tilbage i tiden før der er markante forskelle på ATi og nVidia's billedkvalitet (og her snakker vi ikke FSAA og AA mv.). Tilbage i 2001 var der faktisk forskel at se især på de daværende topkort GeForce3 og Radeon 8500.

Radeon kortet gengav meget lyse og lette billeder mens GeForce kortet gengav mere mørke og mættede farver. Da var der tale om en ren faktuel forskel.

Da vi så kom op i Radeon9x00 serien og den tilsvarende GF4 serien var forskellen markant mindre, og jeg vil vove at påstå at selv ved blind tests ville chancen være 50/50 for at gætte hvilken grafikchip der var i brug.

Selvfølgelig har der været mindre variationer, men det har været i det små - og faktisk så små at det i længere tid har været absurd at debattere om kvalitetsforskellen for det reelle billede. I stedet har debatten så været overført til billede-decoding mv, hvor der har været forskelle i teknikken og hvilken der har være bedst og mest effektivt har været diskuteret.

Forskellen er ikke blevet større i dag for den generelle billedgengivelse i 2 og 3D, faktisk er det blevet endnu mere absurd at tale om forskelle. Der kan være minimale forskelle på lysstyrke eller f.eks beregning af skygge/lyseffekter, men dette er snarer beregningsforskelle end det er decideret forskel i billedkvalitet.

Sidste punkt er at man skal huske på at billedkvalitet varierer fra producent til producent selv med samme grafikchip - kortet er ikke bedre end det svageste komponent det bliver monteret med !

Jeg vil sige, at vi skal langt tilbage i tiden før der er markante forskelle på ATi og nVidia's billedkvalitet (og her snakker vi ikke FSAA og AA mv.). Tilbage i 2001 var der faktisk forskel at se især på de daværende topkort GeForce3 og Radeon 8500.

Radeon kortet gengav meget lyse og lette billeder mens GeForce kortet gengav mere mørke og mættede farver. Da var der tale om en ren faktuel forskel.

Da vi så kom op i Radeon9x00 serien og den tilsvarende GF4 serien var forskellen markant mindre, og jeg vil vove at påstå at selv ved blind tests ville chancen være 50/50 for at gætte hvilken grafikchip der var i brug.

Selvfølgelig har der været mindre variationer, men det har været i det små - og faktisk så små at det i længere tid har været absurd at debattere om kvalitetsforskellen for det reelle billede. I stedet har debatten så været overført til billede-decoding mv, hvor der har været forskelle i teknikken og hvilken der har være bedst og mest effektivt har været diskuteret.

Forskellen er ikke blevet større i dag for den generelle billedgengivelse i 2 og 3D, faktisk er det blevet endnu mere absurd at tale om forskelle. Der kan være minimale forskelle på lysstyrke eller f.eks beregning af skygge/lyseffekter, men dette er snarer beregningsforskelle end det er decideret forskel i billedkvalitet.

Sidste punkt er at man skal huske på at billedkvalitet varierer fra producent til producent selv med samme grafikchip - kortet er ikke bedre end det svageste komponent det bliver monteret med !

#57

#56

Se så blev vi da lidt klogere 😀

#58

56# godt imput til debaten 🙂

#59

Alle: lyt til Gripen - han har bukserne på når det kommer til GFX - det er Guru-status det der 😎

dejligt med noget bekræftende info

og ja webnik med blindtest, så er der ikke forskel som du siger... men ved sammenligning frame for frame er der forskel. Spørgsmålet er så om det ikke er mere driverbestemt end hardware bestem? og om forskellen ikke er så minimal at vi kan sige: det er ens... kommer nok også an på hvem man er, om man går op i det, eller bare glad for det man har 🙂

dejligt med noget bekræftende info

og ja webnik med blindtest, så er der ikke forskel som du siger... men ved sammenligning frame for frame er der forskel. Spørgsmålet er så om det ikke er mere driverbestemt end hardware bestem? og om forskellen ikke er så minimal at vi kan sige: det er ens... kommer nok også an på hvem man er, om man går op i det, eller bare glad for det man har 🙂

#60

#59

Jeg er i hvertfald glad for det jeg har 🙂 hihi..

Jeg er i hvertfald glad for det jeg har 🙂 hihi..

#62

#59: Njarh Guru status ved jeg ikke, men når man har haft over 100stk gfx mellem fingrerne og rodet med dem siden 3D acceleratorens spæde skridt så ryger der lidt ind på lystavlen efterhånden. 😉

Jeg ved ikke alt om alle grafikort ned til mindste detalje mht de enkelte processer, da har jeg mere interesseret mig for helheden som sådan. Jeg har glemt nogle dele efterhånden da jeg ikke har holdt min "viden" vedlige i lidt over et år, men jeg kan da mærke at efterhånden jeg læser om de nye kort, så dukker der noget frem i hukommelsen igen.

Jeg kan huske, at jeg sammen med en god ven af familien (der var elektronik-mekaniker) i 2000 lavede signalkvalitets test på en række GeForce 256 kort fra forskellige producenter, og der var knagme kvalitets forskelle der ville noget. Top 3 var (dengang) Guillemot/Hercules,Elsa,Creative.

Jeg ved ikke alt om alle grafikort ned til mindste detalje mht de enkelte processer, da har jeg mere interesseret mig for helheden som sådan. Jeg har glemt nogle dele efterhånden da jeg ikke har holdt min "viden" vedlige i lidt over et år, men jeg kan da mærke at efterhånden jeg læser om de nye kort, så dukker der noget frem i hukommelsen igen.

Jeg kan huske, at jeg sammen med en god ven af familien (der var elektronik-mekaniker) i 2000 lavede signalkvalitets test på en række GeForce 256 kort fra forskellige producenter, og der var knagme kvalitets forskelle der ville noget. Top 3 var (dengang) Guillemot/Hercules,Elsa,Creative.

#63

#62 jeg havde et hercules FX5900 med 256mb ram.. totalt uber 😛

#64

Jeg var virkelig i tvivl om jeg skulle købe et Riva TNT eller et geforce 2 MX.

Det blev et Geforce 2 MX 😉

Det blev et Geforce 2 MX 😉

#65

#64: Hehe ja jeg har stadig mit Creative 3D Blaster Riva TNT2 Ultra Gamer 32MB AGPx2 med original embal., manual, driver cd og spillene Rollcage og Expendable liggende. Jeg sælger aldrig det kort ❤

#66

At gå fra Voodoo1 til GeForce 4 MX var også ret vildt for mig 🙂 ❤ (inkl. pentium 233MMX til Duron 800mhz!!!)

edit: og endnu vildere: gik fra 486DX80mhz og PCI 32i grafikbus til Pentium 233MMZ og Voodoo1/Tseng6000 linked 😲

edit: og endnu vildere: gik fra 486DX80mhz og PCI 32i grafikbus til Pentium 233MMZ og Voodoo1/Tseng6000 linked 😲

#67

#54 Jeg vil bare gerne lige høre, om det er fordi Saiot skriver så vanvittigt hurtigt på sit tastatur uden at kigge, der kommer så mange stave-/tastefejl? Nu har jeg ikke selv læst den tråd du omtaler..

#68

#67: Mener det er ordblindhed, men også lidt generel taste-galoppering :yes:

#69

Det virker bare tit som om et bogstav lige hopper foran eller bagved et andet, og det gør jeg da også af og til, når det går lidt for stærkt på knapperne ^^ .. De prøver jo at prakke det der ti-finger-system på os alle steder >_< ..

#70

Jeg så ind på tomshardware for ikke så længe siden, at nVidia ville komme med et kort der kommer til at hedde 9850GX2, eller også var det 9950GX2? Det skulle vidst blive ca. 30% bedre end et 8800 ultra, men ved ikke helt om det er sandt?

#71

#72

#65 Du mener, "Jeg kan vidst aldrig få solgt det kort" 😛 , Vil da ikke håbe folk vil købe det 😐

#73

67# det er hele 3 ting 😀 dålig lys hvor jeg sider og galoperne taste tryk 😳

og srkiver dåligt men er ikke ordblin men har ikke fåget så meget ud af skolen på grund af mit andikap 🙂

og srkiver dåligt men er ikke ordblin men har ikke fåget så meget ud af skolen på grund af mit andikap 🙂

#74

#72: Nej jeg sælger det ikke, til forskel for i dag af hvad der findes på markedet var dette kort grafikkortet for mig da de indebar at man nu kunne spille i 32bit uden at midste større ydelse (3x32bit revolutionen)... ja der var faktisk et tidspunkt hvor 32bit vs 16bit var ønske tænkning, men dengang var du jo stadig mindre end bare knejt.

Side note... Voodoo5 kort komplette med æsker sælger for omkring 550kr på ebay. Mange ældre kort er blevet samleobjekter. E.g det sjældne Voodoo5 6000 128MB kort blev vist solgt for lige omkring 8000kr for 1år siden.

Side note... Voodoo5 kort komplette med æsker sælger for omkring 550kr på ebay. Mange ældre kort er blevet samleobjekter. E.g det sjældne Voodoo5 6000 128MB kort blev vist solgt for lige omkring 8000kr for 1år siden.

#75

#65

Kan godt forstå du ikke vil af med det, det var satme et lækkert kort. Skiftede selv til det i sin tid, fra Voodoo2. Det var top nice at kunne køre Unreal Tournement i 1280 x 1024 med lige så mange FPS som Voodoo2 kunnne i 800 x 600. Det var dengang vi kørte med Celeron300a@450. Nøj det sparkede røv.

Det der Rollcage er i øvrigt også et mega fedt spil. Det spiller gutterne og jeg stadig af og til, over lan.

Kan godt forstå du ikke vil af med det, det var satme et lækkert kort. Skiftede selv til det i sin tid, fra Voodoo2. Det var top nice at kunne køre Unreal Tournement i 1280 x 1024 med lige så mange FPS som Voodoo2 kunnne i 800 x 600. Det var dengang vi kørte med Celeron300a@450. Nøj det sparkede røv.

Det der Rollcage er i øvrigt også et mega fedt spil. Det spiller gutterne og jeg stadig af og til, over lan.