NoNig

#0

ATi har barberet røven på nVidia, brændt den af med lightergas og smidt videoen på Youtube...

Læs hele nyheden her: http://www.hwt.dk/newsdetails....

Læs hele nyheden her: http://www.hwt.dk/newsdetails....

#1

#0 hvad mener du med de har lagt filmen på youtube ?

NB. det er jo nat 😛

NB. det er jo nat 😛

#2

Kan det passe at Nvidia Geforce GTX 280 kun yder 933 GigaFLOPS. Hvor ATI x4870 yder 1.2 TeraFLOPS.

Det får da en til at tænke at de penge Nvidia bruger på at spil udviklerne skal optimere deres spil til Nvidia kort er godt givet ud. Da de med laver beregnings power kan overgå ATI's kort i ydelse i flere test. For det ses tydeligt på talende at ATI har mest beregningskraft. Gad vide om dette vil kunne ses i f.eks. Nvidia PhysX afviklet på et ATI x4870 kort i fremtiden. Vis altså det nogen siden når at komme til at virke på ATI kort.

Det får da en til at tænke at de penge Nvidia bruger på at spil udviklerne skal optimere deres spil til Nvidia kort er godt givet ud. Da de med laver beregnings power kan overgå ATI's kort i ydelse i flere test. For det ses tydeligt på talende at ATI har mest beregningskraft. Gad vide om dette vil kunne ses i f.eks. Nvidia PhysX afviklet på et ATI x4870 kort i fremtiden. Vis altså det nogen siden når at komme til at virke på ATI kort.

#3

Super godt skrevet NoNig :yes:

Teksten siger jo det hele, så . . .

Teksten siger jo det hele, så . . .

#4

-> #1

"What happens in D.C. stays on Yotube" 😛

-> #2

Det er ganske korrekt. Det er ikke så meget hvilket kort der har flest FLOPS (Floatingpoint Operations), men hvordan kortet håndterer dem. Det er ganske korrekt, at ATi's kort (både HD 3870 X2 og HD 4850) ser ganske gode ud på papiret. Men hvad nytter det, hvis ATi-kortet skal udregne to operationer, hvor hver enkelt nVidia-kortet skal udregne?

Det er et simpelt spørgsmål om matematik og programmering.

Det sørgelige er jo blot, at både HD 38xx- og 48xx serien ser rigtig gode ud på papiret. I hvert fald i forhold til nVidias alternativer, men de yder ikke bedre. Er det så ATi der har "floppet" eller er det programmørerne?

Der er ingen tvivl om, at en stor del af skylden ligger hos programmørerne og API'en. Hvis nVidia så samtidig går ud og siger (og det skal absolut ikke tages som konspiratoriske idéer det her): "Hvis vi får vores logo på jeres spil, så får I en pose penge af os" - så vil de måske lægge lidt flere kræfter i udviklingen til nVidia? Hvem ved?

Jeg ved blot, at nVidias CUDA (deres programmerings-platform)... nej, lad mig omformulere. Jeg ved blot, at nVidia m e g e t gerne vil udbrede deres CUDA. Intel lurer også i skyggen med Larrabee (som jeg personligt tror flopper lidt), så de bliver udfordret på alle kanter. De har lært af fadæsen med FX-serien (hvor de blev røvrendt af Microsoft, der ikke ville dele DX API'en med dem) og holder nu kortene tæt til kroppen. Måske lidt for tæt? Kan der være en sammenhæng mellem presset fra ATi, markedsanalysen og udbredelsen af SLI? Nu hvor nVidia, langt om længe, officielt, vil understøtte SLI på Intel chipsæt? Det er jo ikke en umulighed (via hackede drivere), men det er nok ikke noget menigmand vil forsøge sig med.

nVidia står med ryggen mod muren, og selvom de har den største maskine bag sig. Jamen. Hvad nytter det, hvis et lille pisfirma som AMD/ATi kan presse dem?

General Purpose GPU bliver fremtiden. Af hensyn til udvikling og afvikling. Det er dyrt for ATi og nVidia at udvikle nye chips og teknologier. Så derfor er der en vis interesse i, at få en teknologi til at holde så længe som overhovedet muligt.

Når man har en GPU, der er fuldt ud skalérbar og programmérbar, så lever den længere, end en GPU med fastsatte instruktionssæt (hvilket også er en af grundene til, at jeg tror Larrabee flopper). Ser man på alternativet, nemlig nye launches hver måned, så dræner det firmaerne og innovationen er nærmest ikke-eksisterende og den ene af dem afgår ved døden.

Det er sket med mange, der sidenhen er blevet opkøbt af større fisk. Sådan fungerer maskinen.

Derfor er det dejligt, når der kommer et frisk pust ind i et rum, der i forvejen lugter lidt for meget af prut - so to speak.

Derfor er det også meget interessant, at nVidia "officielt" har sagt til ATi, at de blot kan anvende deres PhysX-engine. Jamen... Har de noget andet valg? ATi vil, uden problemer, kunne afvikle PhysX på en ATi-chip, og det åbner muligheder for udviklerne. De skal ikke tænke "ATi eller nVidia?" og vi burde dermed får spil der skalerer bedre, uanset om vi kører med den ene producent eller den anden.

I "gamle dage", så var der en vis fornuft i at sige: "Det her spil kører bedst på ATi" eller "Det her spil kører bedst på nVidia" - jamen. Når nu begge GPU'er kan det samme, så kan det være ligemeget hvad vi bruger. De skal finde alternativer, for at vi skal vælge den ene frem for den anden.

Bevares. Fanboys vil altid eksisterer. Ligesom der findes fjolser, der partout vil køre i VW frem for Mazda. Faktum er, at majoriteten af folk der kører bil, bare skal fra A til B. Og det er hér slaget skal stå.

Du kan få alt til at køre på et grafikkort i disse dage. Bare søg på Google. Jeg er sikker på, at du vil kunne finde masser af information om grafikkort der på mystisk vis bliver brugt til fysikberegninger (vi snakker forskning, eksempelvis), som lydkort eller noget helt andet. Det kan bruges til real-time video-encoding (hvilket Intel ikke er så tilfredse med - Enters; Larrabee), du kan lave vilde backdrops, aktive elementer og lækre brugerflader. The Sky's the limit.

-> #3

Jotak, mange tak 🙂

"What happens in D.C. stays on Yotube" 😛

-> #2

Det er ganske korrekt. Det er ikke så meget hvilket kort der har flest FLOPS (Floatingpoint Operations), men hvordan kortet håndterer dem. Det er ganske korrekt, at ATi's kort (både HD 3870 X2 og HD 4850) ser ganske gode ud på papiret. Men hvad nytter det, hvis ATi-kortet skal udregne to operationer, hvor hver enkelt nVidia-kortet skal udregne?

Det er et simpelt spørgsmål om matematik og programmering.

Det sørgelige er jo blot, at både HD 38xx- og 48xx serien ser rigtig gode ud på papiret. I hvert fald i forhold til nVidias alternativer, men de yder ikke bedre. Er det så ATi der har "floppet" eller er det programmørerne?

Der er ingen tvivl om, at en stor del af skylden ligger hos programmørerne og API'en. Hvis nVidia så samtidig går ud og siger (og det skal absolut ikke tages som konspiratoriske idéer det her): "Hvis vi får vores logo på jeres spil, så får I en pose penge af os" - så vil de måske lægge lidt flere kræfter i udviklingen til nVidia? Hvem ved?

Jeg ved blot, at nVidias CUDA (deres programmerings-platform)... nej, lad mig omformulere. Jeg ved blot, at nVidia m e g e t gerne vil udbrede deres CUDA. Intel lurer også i skyggen med Larrabee (som jeg personligt tror flopper lidt), så de bliver udfordret på alle kanter. De har lært af fadæsen med FX-serien (hvor de blev røvrendt af Microsoft, der ikke ville dele DX API'en med dem) og holder nu kortene tæt til kroppen. Måske lidt for tæt? Kan der være en sammenhæng mellem presset fra ATi, markedsanalysen og udbredelsen af SLI? Nu hvor nVidia, langt om længe, officielt, vil understøtte SLI på Intel chipsæt? Det er jo ikke en umulighed (via hackede drivere), men det er nok ikke noget menigmand vil forsøge sig med.

nVidia står med ryggen mod muren, og selvom de har den største maskine bag sig. Jamen. Hvad nytter det, hvis et lille pisfirma som AMD/ATi kan presse dem?

General Purpose GPU bliver fremtiden. Af hensyn til udvikling og afvikling. Det er dyrt for ATi og nVidia at udvikle nye chips og teknologier. Så derfor er der en vis interesse i, at få en teknologi til at holde så længe som overhovedet muligt.

Når man har en GPU, der er fuldt ud skalérbar og programmérbar, så lever den længere, end en GPU med fastsatte instruktionssæt (hvilket også er en af grundene til, at jeg tror Larrabee flopper). Ser man på alternativet, nemlig nye launches hver måned, så dræner det firmaerne og innovationen er nærmest ikke-eksisterende og den ene af dem afgår ved døden.

Det er sket med mange, der sidenhen er blevet opkøbt af større fisk. Sådan fungerer maskinen.

Derfor er det dejligt, når der kommer et frisk pust ind i et rum, der i forvejen lugter lidt for meget af prut - so to speak.

Derfor er det også meget interessant, at nVidia "officielt" har sagt til ATi, at de blot kan anvende deres PhysX-engine. Jamen... Har de noget andet valg? ATi vil, uden problemer, kunne afvikle PhysX på en ATi-chip, og det åbner muligheder for udviklerne. De skal ikke tænke "ATi eller nVidia?" og vi burde dermed får spil der skalerer bedre, uanset om vi kører med den ene producent eller den anden.

I "gamle dage", så var der en vis fornuft i at sige: "Det her spil kører bedst på ATi" eller "Det her spil kører bedst på nVidia" - jamen. Når nu begge GPU'er kan det samme, så kan det være ligemeget hvad vi bruger. De skal finde alternativer, for at vi skal vælge den ene frem for den anden.

Bevares. Fanboys vil altid eksisterer. Ligesom der findes fjolser, der partout vil køre i VW frem for Mazda. Faktum er, at majoriteten af folk der kører bil, bare skal fra A til B. Og det er hér slaget skal stå.

Du kan få alt til at køre på et grafikkort i disse dage. Bare søg på Google. Jeg er sikker på, at du vil kunne finde masser af information om grafikkort der på mystisk vis bliver brugt til fysikberegninger (vi snakker forskning, eksempelvis), som lydkort eller noget helt andet. Det kan bruges til real-time video-encoding (hvilket Intel ikke er så tilfredse med - Enters; Larrabee), du kan lave vilde backdrops, aktive elementer og lækre brugerflader. The Sky's the limit.

-> #3

Jotak, mange tak 🙂

#5

god artikel og godt med priskrig jeg ringer også med mit gamle 8800Gt skal ud af døren og et nyt i maskien men bliver godt nok først til september for så har priserne på HD4870X2 nok stabiliseret sig vis det skulle være sådan et og GTX 280 ultra skulle komme så må man se hvem der vinder og evt pris fal om ikke andet på GTX 280 måske 😀

#6

Jeg kan sku godt lide når du skriver artikler. Du har en måde at skrive tingene på, der både gør det spændende og sjovt.

Det er utroligt hvor meget grafikkort man får for pengene i øjeblikket, men som du skriver, så må man håbe det ikke bliver for hårdt for en af dem.

Det er utroligt hvor meget grafikkort man får for pengene i øjeblikket, men som du skriver, så må man håbe det ikke bliver for hårdt for en af dem.

#7

ja den slags artikler gider jeg også at læse 🙂

der burde næsten være en fredags klumme.... :yes:

der burde næsten være en fredags klumme.... :yes:

#8

#4 hvis et lille pisfirma som AMD/ATi????

Er det ikke lige over grænsen at svine til. Hvis det ikke havde været for ATI/AMD så havde der kun været dyre gfx, da nvidia ville stå alene på markedet 😕

#0 Godt skrevet 😉

Er det ikke lige over grænsen at svine til. Hvis det ikke havde været for ATI/AMD så havde der kun været dyre gfx, da nvidia ville stå alene på markedet 😕

#0 Godt skrevet 😉

#9

#0 Det jo lige før du kunne være skribent hos Ekstra Bladet 😛

godt skrevet 😀

godt skrevet 😀

#10

#9 Lige mine Tanker lol, Dog vil jeg mene at NoNig har mere hjerne hele EB tilsammen :yes:

#11

#8 Jeg tror, NoNig prøver at beskrive, hvordan holdningen til AMD er hos nVidia og Intel 😉

#12

Vil sq snart heller læse biblen end nonig`s inlæg 😛 . Status pt: Ati har barberet røven på nVidia 😕 Damit hvor klamt!!.

Skal dog siges jeg vil læse hele artiklen senere på dagen, Kan ikke finde ro til det lige nu.

Hurtig lille sjov en. Gav 6500 kr. for mit 7800 gtx 512 mb. I dag kan et 280GTX købes for sølle 3300 kr .

Edit og hvad fanden sker der, er nvidia brændt ned til grunden eller hvad 😕 😛

Skal dog siges jeg vil læse hele artiklen senere på dagen, Kan ikke finde ro til det lige nu.

Hurtig lille sjov en. Gav 6500 kr. for mit 7800 gtx 512 mb. I dag kan et 280GTX købes for sølle 3300 kr .

Edit og hvad fanden sker der, er nvidia brændt ned til grunden eller hvad 😕 😛

#13

Enig i det med GFX fronten... 😛 men det er bare et spørgsmål om tid igen igen, hvilket det jo altid er.

Men stærkt uenig med:

Bevares. Fanboys vil altid eksisterer. Ligesom der findes fjolser, der partout vil køre i VW frem for Mazda. Faktum er, at majoriteten af folk der kører bil, bare skal fra A til B. Og det er hér slaget skal stå.

Du betaler ikke vægtafgift, forsikring, benzin, service & eftersyn på et GFX og i sidste ende står dit liv heller ikke på spil med et GFX.

Vi kan også vende dem om. Der findes også fjolser der partout skal gå i mærketøj og andet dyrt kluns, selv om det i sidste instants gælder om at holde varmen og beskytte kroppen.

Hvad folk bruger penge på er deres egen sag, og hvad man foretrækker baseres jo altid på lærte erfaringer, men det er ikke fanboyisme... fanboyisme er at fokusere sig blind på noget der er eet og alt.

At være fanboy behøver ikke være nogen dårlig ting såfremt, at man kan se ud over sin egen næsetip.

Men stærkt uenig med:

Bevares. Fanboys vil altid eksisterer. Ligesom der findes fjolser, der partout vil køre i VW frem for Mazda. Faktum er, at majoriteten af folk der kører bil, bare skal fra A til B. Og det er hér slaget skal stå.

Du betaler ikke vægtafgift, forsikring, benzin, service & eftersyn på et GFX og i sidste ende står dit liv heller ikke på spil med et GFX.

Vi kan også vende dem om. Der findes også fjolser der partout skal gå i mærketøj og andet dyrt kluns, selv om det i sidste instants gælder om at holde varmen og beskytte kroppen.

Hvad folk bruger penge på er deres egen sag, og hvad man foretrækker baseres jo altid på lærte erfaringer, men det er ikke fanboyisme... fanboyisme er at fokusere sig blind på noget der er eet og alt.

At være fanboy behøver ikke være nogen dårlig ting såfremt, at man kan se ud over sin egen næsetip.

#14

NoNig: Suverænt skrevet og formuleret. Du må meget meget gerne stå for grafikkort tests m.m. 😀

#15

#4 Omkring din Mazda og VW. Min firmabil er en Passat stationcar fra 2006 TDI 1.9 og min private er en Mazda6 Touring 2.0 benzin fra 2007. Kom og se, kør og oplev.... du vælger Mazdaen, tro mig!

#16

#15: Sålænge du er glad for det du kører så er det vel det.

Jeg er glad for min Nazi-karet 1.4 Tsi.

Jeg er glad for min Nazi-karet 1.4 Tsi.

#17

NoNig du har kraften med dig og som jeg har sagt tidligere har du ordet i din magt. Jeg nyder dine indsigtsrige indslag i store drag hver gang 😉

#18

#15 - Mazda 6 er helt sikkert en rigtig flot bil og kører også rigtigt godt, men hvad angår rustreklamation/rustproblemer så har du da ramt den absolut værste bil du overhovedet kan finde, desværre - Undskyld for OT !!

--------CB

--------CB

#19

Tak for roserne 😳

-> Til jer med fanboisme/WV vs. Mazda

Det var nu mere for at anvende et malerisk sprog. Jeg har selv kørt VW (også på daglig basis) og Mazda. Jeg synes nu, at begge to er gode køretøjer. Som der bliver sagt. Så er pointen jo som sådan blot at have et transportmiddel. For andre handler det jo nærmest om religion.

-> Til jer med fanboisme/WV vs. Mazda

Det var nu mere for at anvende et malerisk sprog. Jeg har selv kørt VW (også på daglig basis) og Mazda. Jeg synes nu, at begge to er gode køretøjer. Som der bliver sagt. Så er pointen jo som sådan blot at have et transportmiddel. For andre handler det jo nærmest om religion.

#20

jeg er ikke fan boy 😉 😀 men jeg vil helst havde et stykke HTW man kan trylle lidt med,så derfor blev mit vald et ATI,har haft NIVDIA i 10år,og gik over til ATI med 2900PRO.

ATI laver en masse nyt,hvor Nivdia har genbrugt ders GPUer i lang tid :no: .

Jeg vil havde ydelse for mine penge,og ikke et vare mærke.

Godt skrevet 🙂

ATI laver en masse nyt,hvor Nivdia har genbrugt ders GPUer i lang tid :no: .

Jeg vil havde ydelse for mine penge,og ikke et vare mærke.

Godt skrevet 🙂

#21

#18: Ja det er lidt noget skidt... min genbo har en sølvfarvet Mazda 6, den er 2år gammel og købt fra ny. Den har han lige været på værksted med for at få lavet rust på 😕

Nonig: forstod godt din hensigt, men der er dog lidt andre kritere der engang gælder i den henseende.

Mht grafikkort ja da er det jo pris/ydelse man går efter... sjældent hvor langt det går på literen eller om det kun kan tåle strygning og tørretumbler mv. 😀

Nonig: forstod godt din hensigt, men der er dog lidt andre kritere der engang gælder i den henseende.

Mht grafikkort ja da er det jo pris/ydelse man går efter... sjældent hvor langt det går på literen eller om det kun kan tåle strygning og tørretumbler mv. 😀

#22

At nVidia står med ryggen mod muren, er måske lidt en overdrivelse. Det betyder altså noget, at man har den største pengekasse. De kort der bliver snakket om her, er jo langt overkill til mainstream-brugeren, og jeg tror skam stadig der vil blive solgt mange færdige pc'ere med nVidia GFX. Nvidia overtager "tronen" fra ATI igen på et tidspunkt, og vice versa.

Men det er skam godt med noget ordentligt konkurrence, så os dødelige ikke skal give 4000,- hvert halve år for, at få et topkort. Det er vel lidt, som med alt andet elektronik. Det bliver billigere for hvert år, (bare se på fladskærme). Hvem ved...måske bliver der plads til et par andre firmaer med tiden?

Måske tager jeg bare fejl? 😛

Men det er skam godt med noget ordentligt konkurrence, så os dødelige ikke skal give 4000,- hvert halve år for, at få et topkort. Det er vel lidt, som med alt andet elektronik. Det bliver billigere for hvert år, (bare se på fladskærme). Hvem ved...måske bliver der plads til et par andre firmaer med tiden?

Måske tager jeg bare fejl? 😛

#23

#1 Det er pulp fiction han mener...

håber virkelig ikke jeg og nonig er de eneste der har set den..

pisse fed tekst... at få hardware til at lyde levende istedet for kolde tal og benchmarks er suverænt

håber virkelig ikke jeg og nonig er de eneste der har set den..

pisse fed tekst... at få hardware til at lyde levende istedet for kolde tal og benchmarks er suverænt

#24

#4

Nu skriver du, at ATI har mere regnekraft end Nvidia (og på papiret er det jo rigtig nok). Hvis så det bliver sådan i fremtiden (langt ude i fremtiden??) at både ATI og Nvidia vil kunne afvikle PhysX, vil ATI så der have en fordel, eller er PhysX "omskrevet" så meget, at det i sidste ende vil køre bedst på Nvidia (taler her selvf. om kort i samme klasse fra begge).

Jeg sidder selv med et 8800GTS 320MB og overvejer kraftigt at skifte til et HD4870 efter sommerferien, men er lidt usikker på alt det med PhysX integreret i grafikkort. Mon der vil blive en stor vinder pga dette?

Edit: Jeg er også en af dem der synes dine nyhedsartikler er gode og humoristiske skrevet. 😀

Nu skriver du, at ATI har mere regnekraft end Nvidia (og på papiret er det jo rigtig nok). Hvis så det bliver sådan i fremtiden (langt ude i fremtiden??) at både ATI og Nvidia vil kunne afvikle PhysX, vil ATI så der have en fordel, eller er PhysX "omskrevet" så meget, at det i sidste ende vil køre bedst på Nvidia (taler her selvf. om kort i samme klasse fra begge).

Jeg sidder selv med et 8800GTS 320MB og overvejer kraftigt at skifte til et HD4870 efter sommerferien, men er lidt usikker på alt det med PhysX integreret i grafikkort. Mon der vil blive en stor vinder pga dette?

Edit: Jeg er også en af dem der synes dine nyhedsartikler er gode og humoristiske skrevet. 😀

#25

Ja, super skrevet NoNig 🙂

#26

nVidia får vel bare tilbage af samme skuffe. Ati blev virkelig overrasket med Geforce6800Ultra, og ikke mindst Geforce8800 Der faktisk havde unified shader, hvilket alle kilder påstod at det ikke havde.

Jeg synes måske det er fair nok!! 🙂

Gi'r man slag, skal man også kunne tåle at få nogle igen.

Jeg synes måske det er fair nok!! 🙂

Gi'r man slag, skal man også kunne tåle at få nogle igen.

#27

#24

Såvidt jeg har forstået det bliver der slet ikke noget PhysX på ATi kort, da de kører på Havok systemet? PhysX blev da vidst købt af nvidia og er igang med at blive intergreret i CUDA, som allerede er understøttet af 8000 serien af GPU'er.

Såvidt jeg har forstået det bliver der slet ikke noget PhysX på ATi kort, da de kører på Havok systemet? PhysX blev da vidst købt af nvidia og er igang med at blive intergreret i CUDA, som allerede er understøttet af 8000 serien af GPU'er.

#28

-> #27

Det er ikke til at sige. Havok blev jo opkøbt af Intel, som jo netop også gerne vil bevæge sig ind på markedet for diskrete løsninger (se blot på Larrabee og deres fokus på 'raytracing'). Når nu PhysX engang bliver en del af CUDA'en - hvilket den i regelen er nu - vil der ikke være det store problem i at implementere det på et ATi-grafikkort.

Både nVidia og ATi har, med deres nye kort, satset stort på "General Purpose GPU" eller også blot kaldet GPGPU. Det betyder i alt sin enkelthed, at det er programmøren der sætter begrænsningen. Vælger et udviklerfirma eksempelvis at anvende PhysX, jamen så er der ikke det store problem i det for ATI at køre den samme kerne på deres grafikkort. Det kunne især være interessant, hvis ATi og nVidia blev "enige" om, at PhysX er vejen frem, og dermed jorde Intels planer om CPU-baseret fysikberegninger.

De har allesammen lige meget ret og tager allesammen lige meget fejl.

nVidia har - så vidt jeg ved - udmeldt, at de ikke ser problemer i, at ATi anvender PhysX. Det giver jo også ret god mening. Hvis de får ATi til at bruge PhysX, så kan ATi "risikere", at skulle betale licens til nVidia. Hvorimod de skulle betale licens til Intel for at bruge Havok.

Det er ren kællingesnak, sådan som jeg ser på det...

Det er ikke til at sige. Havok blev jo opkøbt af Intel, som jo netop også gerne vil bevæge sig ind på markedet for diskrete løsninger (se blot på Larrabee og deres fokus på 'raytracing'). Når nu PhysX engang bliver en del af CUDA'en - hvilket den i regelen er nu - vil der ikke være det store problem i at implementere det på et ATi-grafikkort.

Både nVidia og ATi har, med deres nye kort, satset stort på "General Purpose GPU" eller også blot kaldet GPGPU. Det betyder i alt sin enkelthed, at det er programmøren der sætter begrænsningen. Vælger et udviklerfirma eksempelvis at anvende PhysX, jamen så er der ikke det store problem i det for ATI at køre den samme kerne på deres grafikkort. Det kunne især være interessant, hvis ATi og nVidia blev "enige" om, at PhysX er vejen frem, og dermed jorde Intels planer om CPU-baseret fysikberegninger.

De har allesammen lige meget ret og tager allesammen lige meget fejl.

nVidia har - så vidt jeg ved - udmeldt, at de ikke ser problemer i, at ATi anvender PhysX. Det giver jo også ret god mening. Hvis de får ATi til at bruge PhysX, så kan ATi "risikere", at skulle betale licens til nVidia. Hvorimod de skulle betale licens til Intel for at bruge Havok.

Det er ren kællingesnak, sådan som jeg ser på det...

#29

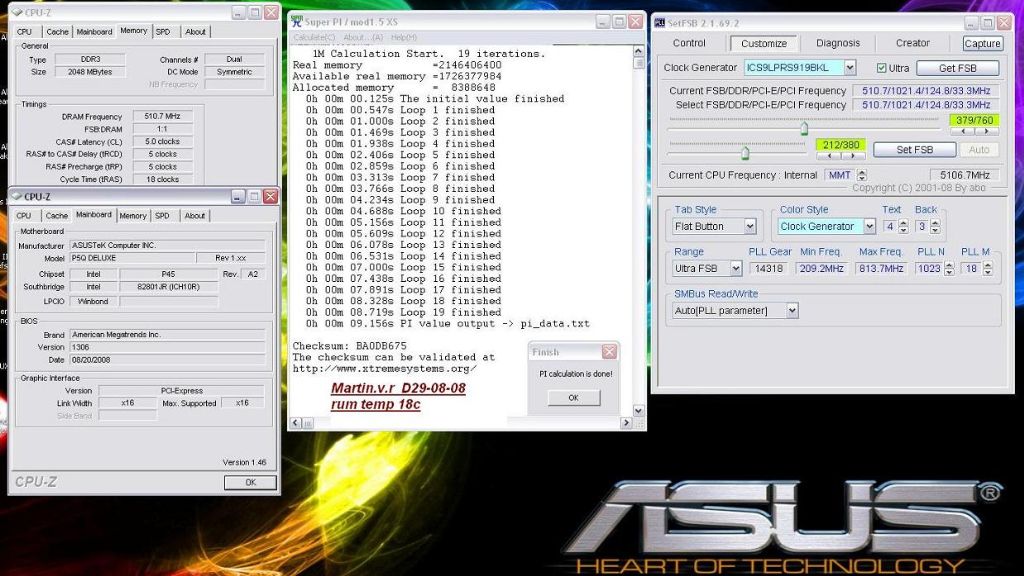

Yields på GTX200-serie chipsne er langt bedre end hvad man forventede derfor kan NVIDIA sagtens skrue langt ned for prisen uden at tabe penge. Det at de bliver nødt til at sætte prisen ned er dog noget nyt.

Det er rigtig interessant det der sker lige nu, NVIDIA holder sig på måtten og venter med at skifte til 55nm pga. af usikkerhed omkring hvor mange brugbare chips man vil få per wafer, hvorimod ATI statser hårdt på at kunne presse flest kerne per wafer. NVIDIA får rigtig mange brugbare high-end chips per wafer lige nu pga. at de holder sig til den langt mere modne 65nm fabrikationsteknologi, hvorimod ATI allerede bruger 55nm.

Det bliver nice med nogle billige kort, så kan det vær ens 8800GTS skal pensioneres.

Det er rigtig interessant det der sker lige nu, NVIDIA holder sig på måtten og venter med at skifte til 55nm pga. af usikkerhed omkring hvor mange brugbare chips man vil få per wafer, hvorimod ATI statser hårdt på at kunne presse flest kerne per wafer. NVIDIA får rigtig mange brugbare high-end chips per wafer lige nu pga. at de holder sig til den langt mere modne 65nm fabrikationsteknologi, hvorimod ATI allerede bruger 55nm.

Det bliver nice med nogle billige kort, så kan det vær ens 8800GTS skal pensioneres.

#30

Argh! Start dog en Blog, og hold disse semantikudbrud væk fra nyhedssektionen.

Misforstå mig ikke, jeg synes det er charmerende, og du skriver godt, NoNig - nyhedsværdien forsvinder bare fuldstændigt, i den store, lunke suppe af "jeg-kan-flotte-gloser"-gloser.

Misforstå mig ikke, jeg synes det er charmerende, og du skriver godt, NoNig - nyhedsværdien forsvinder bare fuldstændigt, i den store, lunke suppe af "jeg-kan-flotte-gloser"-gloser.

#31

#4 / NONIG

"Men hvad nytter det, hvis ATi-kortet skal udregne to operationer, hvor hver enkelt nVidia-kortet skal udregne?"

Kan du uddybe det?

"Men hvad nytter det, hvis ATi-kortet skal udregne to operationer, hvor hver enkelt nVidia-kortet skal udregne?"

Kan du uddybe det?