NVIDIA G80 - Endelige specs ? *UPDATE*

Diverse d. 05. oktober. 2006, skrevet af Emillos 31 Kommentarer. Vist: 535 gange.

#1

Lyder vildt, men er enig med #0 at 640mb ram virker ret underligt?

Og hvorfor ikke GDDR4......

Lige en ting til... Er det bare mig, eller er det ikke lidt skræmmende med de to "juice" stik ?

Og hvorfor ikke GDDR4......

Lige en ting til... Er det bare mig, eller er det ikke lidt skræmmende med de to "juice" stik ?

#2

->#1

"Er det bare mig, eller er det ikke lidt skræmmende med de to "juice" stik ?"

Både ja og nej..:)

Geforce6800Ultra, i hvert fald nogle modeller, havde også 2 molexstik, mens dets strømforbrug alligevel ikke var så vildt igen. Jeg tror egentlig ikke at 2 stik er så nødvendigt endda, men at nVidia gør det for at sikre en stabil drift.

Men lad os nu se.. rygterne går i hvert fald omkring et enormt strømforbrug. Dog er det begrænset hvor meget varme det kan fyre af, hvis det virkelig er standardkøleren der sidder på den viste sample.

Mange sagde også, at NV40 ville komme til at bruge vildt meget strøm, og på et tidspunkt florerede der et billede af et NV40 med termiske skader. Men når alt kom til alt, var Geforce6800Ultra faktisk en anelse koldere end gf5950U :)

"Er det bare mig, eller er det ikke lidt skræmmende med de to "juice" stik ?"

Både ja og nej..:)

Geforce6800Ultra, i hvert fald nogle modeller, havde også 2 molexstik, mens dets strømforbrug alligevel ikke var så vildt igen. Jeg tror egentlig ikke at 2 stik er så nødvendigt endda, men at nVidia gør det for at sikre en stabil drift.

Men lad os nu se.. rygterne går i hvert fald omkring et enormt strømforbrug. Dog er det begrænset hvor meget varme det kan fyre af, hvis det virkelig er standardkøleren der sidder på den viste sample.

Mange sagde også, at NV40 ville komme til at bruge vildt meget strøm, og på et tidspunkt florerede der et billede af et NV40 med termiske skader. Men når alt kom til alt, var Geforce6800Ultra faktisk en anelse koldere end gf5950U :)

#3

Æv den her nyhed indsendte jeg i morges ved 8 tiden, men jeg var nok for langsom. Det vigtigste er dog at vi her på OC.dk har noget at savle over 😉

Mvh

Holmer

Mvh

Holmer

#4

De første billeder af G80 viste, at kortet skulle have vandkøling på fra fabrikken af!

Mængden af RAM stammer nok fra rygterne om, at der er en kerne med tilhørende hukommelse til DX9 og et sæt til DX10, hvilket jo passer fint med 128MB og 512MB.

LOL, så skal man have en PSU der er Quad-SLI certificeret, for at kunne køre SLI med de her mobbedrenge!!! :o

Bliver sjovt at se, hvad der bliver de rigtige specifikationer for G80, men endnu mere for R600, da R580 jo sluger meget power i forvejen, så tør jeg ikke tænke på hvor meget R600 kommer til at sluge! :o:o:o:o

Mængden af RAM stammer nok fra rygterne om, at der er en kerne med tilhørende hukommelse til DX9 og et sæt til DX10, hvilket jo passer fint med 128MB og 512MB.

LOL, så skal man have en PSU der er Quad-SLI certificeret, for at kunne køre SLI med de her mobbedrenge!!! :o

Bliver sjovt at se, hvad der bliver de rigtige specifikationer for G80, men endnu mere for R600, da R580 jo sluger meget power i forvejen, så tør jeg ikke tænke på hvor meget R600 kommer til at sluge! :o:o:o:o

#5

->#3

Ja jeg så den godt efter jeg havde skrevet nyheden..sorry :r

->#4

Ja dualcore-teorierne med DX9/Dx10 opdeling lyder mere og mere sandsynlig..

>Edit

Kunne det egenlig ikke tænkes at G80 kommer til at skodde i DX9?.. for de prioriterer vel dx10?..

Ja jeg så den godt efter jeg havde skrevet nyheden..sorry :r

->#4

Ja dualcore-teorierne med DX9/Dx10 opdeling lyder mere og mere sandsynlig..

>Edit

Kunne det egenlig ikke tænkes at G80 kommer til at skodde i DX9?.. for de prioriterer vel dx10?..

#6

#4 Ved ikke om dette er "rigtige" facts men du kan da læse lidt http://www.cooltechzone.com/Sp...

Og ja det bliver meget spændene at "se" de endelige facts på G80/R600

Og ja det bliver meget spændene at "se" de endelige facts på G80/R600

#7

Det er fandenedeme for vildt hvis man skal til at have sig en 800 watt PSU, hvis man vil køre SLI. 8) 8) 8)

#8

I skal da ikke pive sådan over de to strømstik bare vent til der kommer et 8800GX2 kort og så skal man da have et par stykker af dem i SLi :p :e

Aj det bliver virkelig spændede at høre noget mere om det 8800GTX kort. Jeg bliver nok en af de første der ligger en bestilling på sådan et kort ;) 8)

Aj det bliver virkelig spændede at høre noget mere om det 8800GTX kort. Jeg bliver nok en af de første der ligger en bestilling på sådan et kort ;) 8)

#9

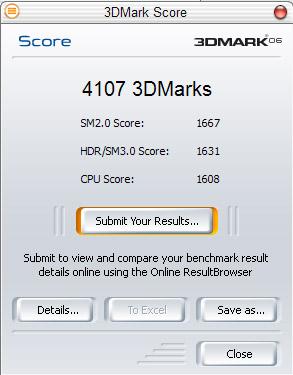

Overdrevne nice specs, men jeg tror faktisk, at 8800 serien bliver et flop. Ligesom FX serien blev det. Det er typisk Nvidia, når de begynder på ny teknologi. Dog er 96 shaders ret vildt.

#10

Rammene er helt sikkert god nok... Der findes også billeder af kortets bagside... Og her er det meget tydeligt, at der sidder 12 ramblokke parallelt.

1 ramblok er på 32bit dvs. 12styks gange 32bit = 384bit i alt.

Noget andet sjovt er, at godt nok er der 2 6pin-stik... men tjek lige en gang til... Der er faktisk huller og lodeklatter til et 8pin på den enes plads.. Se det synes jeg er interassant :o :o

Måske får vi allerede nye strømstik, og løsningen med to stik er måske kun midlertidigt :00

1 ramblok er på 32bit dvs. 12styks gange 32bit = 384bit i alt.

Noget andet sjovt er, at godt nok er der 2 6pin-stik... men tjek lige en gang til... Der er faktisk huller og lodeklatter til et 8pin på den enes plads.. Se det synes jeg er interassant :o :o

Måske får vi allerede nye strømstik, og løsningen med to stik er måske kun midlertidigt :00

#11

Bare rolig drenge! Rygterne er altid lidt mere vilde end det er i virkeligheden angående strømforbrug.

Og så skal der nok komme en flottere køleløsning end den der er på billedet...

Og så skal der nok komme en flottere køleløsning end den der er på billedet...

#12

Nu er jeg i tvivl angående det der med 2 strømstik. Der er os 2 strømtyve på mit 7900gt men bruger kun det ene, skal jeg bruge begge 2?

#13

#10 Måske får vi allerede nye strømstik, og løsningen med to stik er måske kun midlertidigt / hvem ved ? , det kan godt være ?:( , men jeg venter til Nvidia kommer med oplysninger

#14

haha den der vandkøling, er bare et loop der lige går ind og røre ved køleribberne.

Ikke særlig effektiv hvis du spørger mig :l

Ikke særlig effektiv hvis du spørger mig :l

#15

Jeg syns de specs ser klamme ud? Det er jo ikke noget man ikke kan clocke sig fra? Jeg Venter sq lidt når de kommer... ska ikks mide penge efter noget nytteløst.. har de forresten DX10 de nye kort eller hvordan? Jeg er lidt tabt bag den vogn :r

#16

#15, læs første sætning i nyheden igen...

#17

Jeg tror at ATi's kort bliver langt mere juicy.

#18

#17. Tror jeg også. Jeg havde planlagt at investere i et 8800 kort, men det kan jeg se nu at det udsætter jeg lige... Den der med GDDR3 rammere lyder squ ikke for godt... ATI here I come 🤡

Forresten nogen der ved hvornår ATI lancerer deres kommende dx10 kort?

Forresten nogen der ved hvornår ATI lancerer deres kommende dx10 kort?

#19

Jeg skal da have en Wii til jul :)

Mit 7800gt kører stadig fint :p

Mit 7800gt kører stadig fint :p

#20

#18 http://www.cooltechzone.com/Sp... , jeg ved ikke hvor rigtige disse oplysninger er , men det ser ikke "forkert" ud i den forstand ,

#21

Jeg er egentlig mest skuffet (hvis man kan være det allerede ud fra spy specs) over brugen af GDDR3.. :l

#22

Nu må ike sgu styre jer... nogle der kan fortælle mig forskellen på GDDR3 og GDDR4..

Den eneste er hastigheden GDDR3 kan ikke runde 1Ghz, det kan man med GDDR4. Ydelse per Mhz kan meget vel være lavere på GDDR4 pga. højere lantency.

Jeg synes at 384bit ram-kredse er langt bedre guf end GDDR4.

Det giver nemlig 50% højere båndbredde per Mhz.

Den eneste er hastigheden GDDR3 kan ikke runde 1Ghz, det kan man med GDDR4. Ydelse per Mhz kan meget vel være lavere på GDDR4 pga. højere lantency.

Jeg synes at 384bit ram-kredse er langt bedre guf end GDDR4.

Det giver nemlig 50% højere båndbredde per Mhz.

#23

32xSLi kan opnåes med GX2-kort i SLi :p og 16x i single.

#24

#22 Enig. DDR3 virker som fint nok til mig. Nææh gi os DDR4 ram når deres ydelse kan refærdiggøres med deres ydelse. Det er klart mere interessant med 384-bit ram kredse som red_martians nævner. Det må siges at være et skridt i den rigtige ret.

#25

#22 Du kan have fat i noget ;) , IMO glæder jeg mig til at se reviews af Nvidia kontra ATI R600

#26

Fedt med alle disse nye kort, men er der slet ingen der undre sig over den monopol magt Microsoft udøver ved at force alle over i Windows Vista bare for at kunne blive ved med at spille de nyeste spil sammen med sit nye Nvidia eller ATI GFX kort? Det er da fuldstendig latterligt at man skal ud og bruge 1000 kr til 2000 kr bare for få lov til at få DirectX 10. Da det ikke vil komme til windows XP. Fuldstendigt latterligt efter min mening. Fatter slet ikke hvorfor Nvidia og ATI lader sig dikter på den måde og ikke bare laver en fælles standard og får alle spil udvikler over på den frem for DirectX. Lidt lige som 3dfx gjorde i sin tid ved at havde glide API som deres egen standard.

#27

#26 Der er jo ingen der tvinger dig til at købe det :i , og hvis man så gerne vil "have" det og kunne spille de "nye" spil må man betale prisen , eks. jeg kan ikke sige at jeg vil have en billig bil der skal kunne køre som en Mercedes

#28

Gad vide om GTS kortet kan unlockes.

#29

#26 enig...det eneste det kræver er at openGL 2 kommer hurtigt ud og spiludviklerne bliver enige om at det er der man vil satse istedet for dx....så kommer resten af sig selv.

#27 det er princippet i at valget af OS osv ikke skal hænge sammen med valget af spil fx......hæmninger af de frie markedskræfter fører kun til højere priser for forbrugerne. at der næppe kommer nogle spil som kræver dx10 i laaaaang tid er nok ret sandsyneligt.

#27 det er princippet i at valget af OS osv ikke skal hænge sammen med valget af spil fx......hæmninger af de frie markedskræfter fører kun til højere priser for forbrugerne. at der næppe kommer nogle spil som kræver dx10 i laaaaang tid er nok ret sandsyneligt.

#30

#27 og #29

Microsoft prøvede det samme med Windows 2000 i sin tid. De sagde at der ikke ville komme Dx 8.1 til Windows 9x, men fordi Windows 2000 ente med at blive et flop for gamers så kom DX 8.1 og DX 9.0 til Windows 9x serien alligvel. Regner selv med at det samme kommer til at ske med Windows Vista vs Windows XP/Windows 2000. Vis bare folk lader være med at skifte over til det nye OS og bliver ved med at bruge windows xp. Så er Microsoft presset til at udgive DX 10 til Windows XP for at få støre markedes andel hvad angår DX 10 API. For spilproducenterne skal nok holde sig fra lortet vis ikke der er nogen vilje til at bruge det.

Microsoft prøvede det samme med Windows 2000 i sin tid. De sagde at der ikke ville komme Dx 8.1 til Windows 9x, men fordi Windows 2000 ente med at blive et flop for gamers så kom DX 8.1 og DX 9.0 til Windows 9x serien alligvel. Regner selv med at det samme kommer til at ske med Windows Vista vs Windows XP/Windows 2000. Vis bare folk lader være med at skifte over til det nye OS og bliver ved med at bruge windows xp. Så er Microsoft presset til at udgive DX 10 til Windows XP for at få støre markedes andel hvad angår DX 10 API. For spilproducenterne skal nok holde sig fra lortet vis ikke der er nogen vilje til at bruge det.

#31

#30 Jeg er ret overbevist om at der kommer DX10 til WinXP... jeg kan mærke det! :00

![[G.N.U.]](/images/users/profile/36302.jpg)