AMD Radeon R9 Fury X / R9 Fury / R9 Nano

Grafikkort, AMD/ATI d. 16. juni. 2015, skrevet af morra19 94 Kommentarer. Vist: 2526 gange.

http://wccftech.com/amd-offici...

tænker, om det er nu man skal sælge sit ellers nye Gtx 970 strix sli setup (den ene bliver først sat i i morgen tidlig) hvor det andet kort ellers har kørt lige over 2 uger i maskinen..

for at opgradere til et single kort (amd's self :D) eller om det kan betale sig at beholde kortene, for at afvente Nvidia's "Pascal", hvis den selvfølgelig kommer inden for rimelig tid. 🤣

MRSP på 650$, præcis som 980 ti.

Jeg ingen forventninger om, at de bliver dyrere end det.

Få antal? Hvor få? Hvad er din kilde på dette?

Prøv så at tænk endnu længere ud i fremtiden! Hvor meget ballade kan AMD så lave med HBM2! NEJ HBM9!! NEJ!! NEEJ!! 😎

Lad os lige forholde os til first gen. HBO 😀

Så Fury X bliver så hjernedødt varmt at det ikke kan klares med luft ? :no:

Jeg synes det er premium og det må åbne op for gode OC muligheder!

Man må gå ud fra at både ram og gpu er kølet af blokken! Det ville pakke ganske fint i mit mITX setup.

Er jeg den eneste, der synes at Nano kortet lyder spændende ?

begrænset størrelse og langt lavere strømforbrug end vi længe har set fra AMD ?

Er selv voldsomt spændt :D

Men glæder mig endnu mere til at se priser, performance og udseende

Tror det ligger fast.... Farvel igen Nvidia, Hello Amd :D

Men er de nye ram, med den højere overførsel rate, ikke langt bedre end et gddr5 kort med flere ram ?

Tænker eks fury x vs titan x

4 Hbm vs 12 gddr5

Hvis du fulgte med i aftenens udsendelse ville du se det kørte både 4k og 5k uden problemer

4k 60fps

5k 45fps

Et GTX 980Ti downclocker først ved 93*c og i hvertfald ikke 70*c. Om eet af mine kører 60*c eller 85*c så har det stadig en boost clock på 1454Mhz.

#15: Teoretisk set måske, men det er langt fra sikkert i praksis. Godt nok skulle HBM gøre således at teksturer kan streames hurtigere igennem rammene og derved behøves en større Vram buffer ikke. Men det skal tages med et gran salt. Du kan se at forskelling ml. DDR og DDR4 til PC'er trods den massive fremgang i ydelse ikke har givet anledning til mindre brug af kapacitet.

Nogle spil sammen med GFX driveren gør det, at de bevarer nogle teksturer fra det pågældende sceneri i Vram bufferen, således at teksturerne faktisk ligger klar i bufferen til at smide på skærmen uden forsinkelse (dvs lav latency). Jo mere der kan lagres af en scene i Vram uden at der skal ske en tekstur "fornyelse" des mere flydende kan en scene forekomme. Dvs at der faktisk caches på Vram fremadrettet.

HBM 1 er i sin form limiteret til 4GB og i en ideel verden vil 4GB samt den hurtigere datastrøm ml. GPU og Vram gøre at teksturer mere eller mindre kan streames direkte ind og ud af Vram uden forsinkelse (latency) - men om 4GB er nok til at kunne gøre det 100% effektivt er stadig spørgsmålet. Dertil kan kun de kommende reviews fortælle.

HBM 2 hvor der kan bruges langt større mængder end 4GB ligger klar til næste generation af nVidia og AMD kort.

#17: Jeps men desværre sagde hun aldrig hvilke settings. Kun "ultra high speed", hvilket jo ikke rigtig siger noget.

Svaret blev redigeret 2 gange, sidst af Gripen90 d. 17-06-2015 00:51:15.

Har ikke fritid til at stene udsendelse... Har en ny opereret knægt at se til.

Der ud over svarede du egentlig ikke på spørgsmålet om hvorvidt at 4HBM ram med høj hastighed yder kontra gddr 5 med lav hastighed men med de flere ram.

Ved ikke om de har kørt et titan x på samme system og smidt det i 5k... Hvordan klarede det sig?

Og 45 fps?? Personligt ville jeg ikke acceptere under 60.. Men ok det jo i 5k

Men at påstå at 45fps bare køre,er som at påstå et integreret grafikkort køre bf4 flydende i 1080p.....

Svaret blev redigeret 1 gang, sidst af ek91 d. 17-06-2015 00:52:33.

TAK! Endelig et kvalificeret svar :)

Mht varme osv, har der været et par reviews, der har nævnt gtx 980ti havde problemer med varme ved spil, at det blev 8x grader og clokkede ned.

Hmm men næste gode spørgsmål, er man med HBM ram ikke ved at ramme Max overførsel til pci.ex16, eller ved xfire x8,x8?

Før eller senere må ens bundkort vel lave en flaskehals?

AMD's main points so far

R7 360 - Entry level aimed at online games priced at $109 with 2 GB GDDR5

R7 370 - Offers more performance and comes with 4GB GDDR5 at $149

Both Cards DX12 compatible

R9 380 - $199

R9 390 - $329 with 8GB GDDR5

R9 390X - $429 also 8GB GDDR

All cards available above available on Thursday 18th June. No word on fury yet. Now they are talking about DX12

Footage of the new fable talking about the new features of Directx 12 with Lionhead.

Fable beta coming soon to windows 10. Can sign up on the fable website.

Stardock + Oxide studios talking about Ashes of the Singularity and about how DX12 allows bigger battles.

Talking about VR now.

Oculus and CCP guests on stage are now talking about the technical side of VR.

Multiple GPUs with LiquidVR doesn't add latency to rendering.

Specs req for VR is important. R9 290 and above is their recommendations.

Talking about EVE: Valkyrie and how it works with VR. Releasing Q1 2016.

GE guest on stage talking about non gaming implications of VR.

Chris Hook on stage about to announce something

Showing project Quantum which is a very small pc and has two Fiji processors.

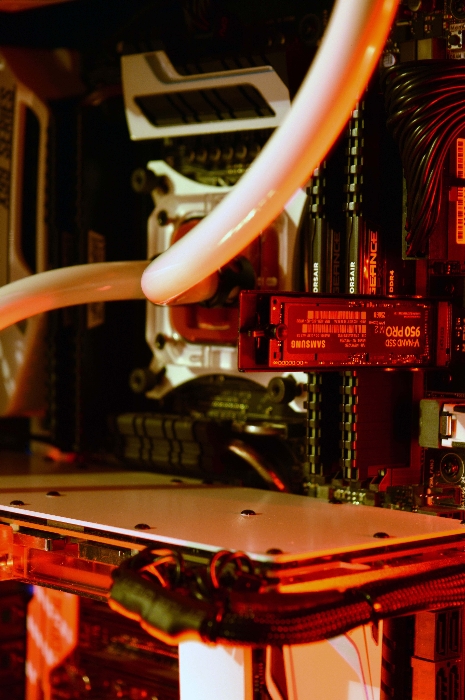

Video showing development of Fiji and HBM. Talking about liquid cooling with high performance and memory bandwidth.

Dr. Lisa su on stage "to introduce the worlds fastest GPU"

R9 Fury X. Watercooled and showing it running sniper elite and tomb raider at 5k.

1.5x pref to watt of r9 290x.

R9 Fury none watercooled version in stores shortly.

R9 Nano just announced too. 6" GPU with fiji chip with 2 x preformance per watt of 290x. "double the power of r9 290x"

R9 Nano available this summer with other cards in the family.

Bringing AMD staff on stage to talk about the new GPUs

Fury x - 4096 stream processors, 8.6 Tflops and 8.9 billion transistors

Talking about how they offer they will offer the best 4k Experience

Now talking about HBM and making the card more power efficient. 3x the performance per watt of GDDR5. 94% less PCB surface.

Talking about how the future of VR and the massive power requirements it has. 16k resolution per eye, 120-240hz refresh rate and GPU engine requires 1 Peta flop.

Talking about fury series again and about the build quality.

VU meter showing GPU load in real time.

24th June fury X $649. July 14th Fury $549 and R9 nano later in summer and dual fiji gpu in the fall.

#18

TAK! Endelig et kvalificeret svar :)

Mht varme osv, har der været et par reviews, der har nævnt gtx 980ti havde problemer med varme ved spil, at det blev 8x grader og clokkede ned.

Hmm men næste gode spørgsmål, er man med HBM ram ikke ved at ramme Max overførsel til pci.ex16, eller ved xfire x8,x8?

Før eller senere må ens bundkort vel lave en flaskehals?

Det er også "korrekt", men jeg vil vove den påstand at de er fordi de aldrig helt har forstået GPU Boost 1.0 eller 2.0, for det samme gjorde sig gældende med hele Kepler serien.

GPU Boost er en balance mellem strømforbruget på kortet på GPU, Vram, Aktiv køling - til hver af tingene afstås en vis mængde watt. Det sted hvor alle 3 elementer samlet giver den bedste ydelse er med en dedikeret target temp. som er forud defineret i GPU'en.

F.eks hvis man tillader at GPU'en bliver lidt varmere så kan GPU boost på MHz faktisk forøges, men hvis man vil have max køling så RPM hastigheden er i top så booster kortet faktisk lidt mindre men er køligere, det er fordi watt forbruget tildeles kølingen istedet istedet for watt til højere GPU boost clock.

Så jo hvis et GTX 980Ti når 83*c og f.eks clocker ned fra 1240MHz til 1220MHz, så skyldes det for ikke at høje RPM niveauet til at køle GPU'en og så faktisk måske opnå en lavere boost clock end oprindeligt. Så derfor clocker GPU'en blot let ned så den kan opretholde den optimale ydelse i forhold til GPU temperatur.

Det er derfor når firmaer laver custom PCB og med andre kølere, så kan de smide nogle voldsommere kølere på der kan køle bedre med stadig holder sig inden for rammerne hvor hvad køleren kan bruge i watt. Des bedre køler des mindre wattforbrug til kølingen tildeles og bruges derfor på højere GPU boost.

Håber det gav lidt mening 🙂

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 17-06-2015 01:04:37.

Bukker og takker, :)

Men, er bare sikker på kortet er blevet hakket ned i de 2 tests jeg læste, og der efter mistede jeg al interesse for det.

Lad os se når der kommer reviews på bordet... Jeg syntes bare det er synd at folk som dig og Kvist køber 3stk Gtx 980 ti uden i aner hvad amd kommer med og alle de 970 du havde før.. Når amd virkelig har brug for støtten og de har haft 295x2 som køre genialt jeg fatter bare ikke i er så ligeglad med konkurrencen når amd virkelig har brug for noget omsætning. Jeg har købt 5stk 290x samt 1stk 295x2 og mere til på under 1 år... Hvis vi skal holde amd kørende må vi sku hjælpes ad.. Jeg er selvstændig og sælger udelukkende amd maskiner da jeg virkelig kæmper for deres sag for ellers ender vi sku med nvidia tager 10000kr for deres næste flagskib. Førhen hed det sku maks 5000kr for det største higend vi kunne købe.

Det tyder jo på uanset hastighed på det nye fury kort køber du åbenlyst flere 980 ti med glæde så der er da ingen tvivl om du følge den grønne vej uanset hvad.

Gripen

Lad os se når der kommer reviews på bordet... Jeg syntes bare det er synd at folk som dig og Kvist køber 3stk Gtx 980 ti uden i aner hvad amd kommer med og alle de 970 du havde før.. Når amd virkelig har brug for støtten og de har haft 295x2 som køre genialt jeg fatter bare ikke i er så ligeglad med konkurrencen når amd virkelig har brug for noget omsætning. Jeg har købt 5stk 290x samt 1stk 295x2 og mere til på under 1 år... Hvis vi skal holde amd kørende må vi sku hjælpes ad.. Jeg er selvstændig og sælger udelukkende amd maskiner da jeg virkelig kæmper for deres sag for ellers ender vi sku med nvidia tager 10000kr for deres næste flagskib. Førhen hed det sku maks 5000kr for det største higend vi kunne købe.

Det tyder jo på uanset hastighed på det nye fury kort køber du åbenlyst flere 980 ti med glæde så der er da ingen tvivl om du følge den grønne vej uanset hvad.

Grunden til jeg i de senere par år har fulgt den grønne vej har faktisk været meget lige til på et par vigtige punkter. Det er fordi, at det jeg bruger min primære PC til, der har der fra AMD side ikke været noget alternativ til.

1) Jeg har brug for CUDA cores til min redigering, også selv om det ikke er så meget som tidligere.

2) SLi profiler som jeg har mulighed for selv at lave i Nvidia Inspector. AMD har desværre ikke tilbudt dette i nogen tools til deres CrossFire løsninger. ATi Tray Tools havde tilbød en gang muligheden, men efter ATi HD5800 serien stoppede det med AMD navnets officielle overtagelse.

3) Jeg er enormt glad for at spille Falcon 4.0 fra 1998 som stadig holdes i live af et stort fan community, men desværre kører spillet ikke ret godt på AMD kortene.

4) R9 290X var ellers ved at overtale mig, men den ringe reference løsning som jeg vidste jeg ville bruge til 3 kort ville blive et varme orgie uden lige. Så fokus faldt tilbage på the green team.

5) Jeg er altså bidt at PhysX når det er muligt at bruge. Det må jeg indrømme.

Og allersidst, nu hvor alle mine resterende nVidia 970 kort bliver afsat så har jeg en maskine uden grafikkort... der kunne meget vel blive plads til enten R9 Nano, Fury eller Fury X.

Faktisk så har jeg indtil 2011 altid haft to PC'er med ben i hvert hold. En maskine med AMD GPU og en anden med NVidia GPU.

Jeg har absolut intet imod AMD og ønsker, at det går dem godt... men jeg kan altså bare ikke smide de ting ud af vinduet jeg efterspørger til eget brug blot for at støtte dem.

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 17-06-2015 01:45:47.

Det syntes jeg sku er fair nok du har nogle grunde jeg kan bruge til noget dog ikke lige det med kølingen på 290x der kunne du bare vælge en med aftenstjernen køler

Prisen er underordnet, det handler helt for mig om hvilket kort der kommer først i butikkerne herhjemme.

rumored

Posted: 5 days, 12 hours ago

Det er desuden afkræftet af mindst ligeså mange rygte-børser. Dog ikke noget officielt på nogen sider af den sag.

Lad os tolke det som om der ikke er hold i noget af det.

Hvis AMD kun solgte 30.000 eksemplarer af Fiji ville de gå konkurs på stedet. Det svarer til et samlet MRSP på lige under 20.000.000$, og da AMD tjener langt under MRSP, er det ulogisk med et oplag på kun 30.000 😎

Svaret blev redigeret 1 gang, sidst af Shutdown d. 17-06-2015 10:24:02.

Men føler mig nu også ret fristet af Fury. Glæder mig til at se hvad det kan.

Deres video med 5K i Sniper Elite 3 med 45FPS sagde de intet om i hvilken kvalitet de kørte, men over på forums.overclockers.co.uk er der flere der selvfølgelig ville prøve at emulere resultatet på GTX Titan X og 980Ti. Der blev testet ved stock clocks i 4K + DSR 1 = 5K i Ultra details med 4xMSAA og der lå FPS i average på 47FPS. Så hvis det er de samme indstillinger AMD har brugt, så kan Fury X meget vel være lig Titan X/980Ti i ydelse 🙂

Så vidt jeg ved er/var der op til release i går ikke engang sendt Fury kort ud til anmeldere til tests... Så der bliver da virkeligt travlt d.24 i næste uge hvis alt skal falde i hak 🙂

såfremt de kan få deres FIJI release ordenligt ud.

desuden er et rebrand af sidste års modeller heller ikke helt tosset, da de jo kommer til at være super billige med latterlig performance :)

Jeg syntes personligt det ser ud til AMD kommer lidt på banen igen.

såfremt de kan få deres FIJI release ordenligt ud.

desuden er et rebrand af sidste års modeller heller ikke helt tosset, da de jo kommer til at være super billige med latterlig performance :)

Ja de 8gb ram lokker også lidt. Mit 780 TI kommer fx til kort i GTA V :)

det ser rigtig godt ud så kan man godt sætte sit 980 ti i sin secundær maskine.

jeg har pengepungen klar amd så bare smid dem på gaden

36# Nu ved jeg ikke om du så hele deres "launch" men han sagde flere gange at de havde verdens hurtigste grafikkort (Det tror jeg simpelthen ikke de ville gøre hvis ikke der var en smule sandhed i det, det ville da være at grave sin egen grav). Om det så er 2-5% er imo ligemeget, bare de er "med igen", og deres ydelse pr watt ser jo også ganske fornuftigt ud, ligesom de har flere interessante kort (mini itx, vandkølede modeller osv, "billige" finpudsede 8gb 390-390x kort osv) Nu skal vi bare se hvor meget de har tænkt sig at presse Nvidia med pris/ydelse som egentlig er det jeg syntes er interessant, altså de har jo allerede en vinder med deres 295x2 som til prisen vel stadig er det kort der pumper flest fps ud i til prisen i de helt høje opløsninger.

Jeg det bed jeg mærke i og det gjorde de også på overclockers.co.uk og der er en hæftige debat.

Det er muligt at de har det hurtigste grafikkort netop da de jo annoncerede at have et Dual GPU kort med 2x Fury X, og det vil naturligt blive det hurtigste grafikkort der er pt, men spørgsmålet er så på single GPU plan om de også har det hurtigste der ?. Det vil reviews'ne vise og jeg er sikker på at d.24/6 der har nVidia smidt en ny WHQL driver på banen til at presse alt det de kan ud af deres seneste line up 🙂 Men spændende det er det i hvert fald.

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 17-06-2015 15:05:06.

Interessant - hvis det holder så kommer Fury X med 4GB HBM til kort overfor sin R9 390X 8GB bror i 8K... selv om det alligevel ikke er spilbart, men det giver da en mulig prognose for HBM 1 vram.

Ja, prognosen må være at Fury X ser ud til at være kongen til og med 4k gaming.

I 5k taber den pusten, til de kort der har flere GDDR5 ram.

Så er pøblen også ligesom skåret væk 😲

Tror sgu der går mange år før 4k bliver mainstream. Indtil nu er der ikke rigtig DEN fede skærm der gør man har lyst til at skifte, uden det koster spidsen af en jetjager. HDMI 2.0 er ikke engang ordentligt på plads endnu og grafikkort understøtter det ikke.

På sigt kan jeg godt se et 40" 4K TV være sjovt at smide på skrivebordet til PC'en. Det må da være noget af en opgradering. 😲

Jeg er fornyligt skiftet fra 24'' 1080p til 25'' 1440p, og kan se en tydelig forskel.

Indrømmet, den er ikke stor, og under heftig gaming er det glemt.

Købte tilgengæld heller ikke skærmen udelukkende på grund af opløsningen, men også for at få et nyere IPS panel.

Bliver spændende at se hvordan win10 håndterer super opløsninger. Og også Dx12 skalering af gfx ram på CF og SLI setups.

CDON har for nyligt haft en anmelderrost BenQ 27'' IPS på tilbud til 2600. 😎

Så man kan være heldig

Jeg har selv lige købt en 25'' 1440p skærm og er godt tilfreds med en rigtig fed ppi og flot ips panel 😲 . En U2515H til ca 2400, hvis det skulle have interesse.

Svaret blev redigeret 1 gang, sidst af kasperlarsen9670 d. 17-06-2015 19:28:00.

Men stadig, hvis Fiji med sine 4gb hbm er rigeligt til 4k er der jo ingen problemer. Og måske forsvinder problemet af sig selv hvis man kommer til at udnytte ALLE sine grafikram i dx12. Hvad koster en fornuftig 27/30" 2560x1440 skærm i dag.?

Ml. 2500-3000kr hvis det skal være en rimelig en også til spilbrug 🙂

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Dx12 skulle da netop lade dig lægge dine ram sammen i sli/cf kontra dx11/11.1 hvor kun gpu power bliver lagt sammen, og ram forbliver "passiv"

Ser frem til at se rigtige spil benchmarks istedet for 3dmark..

Det sandt, men dx12 ville jo samtidig gavne 3d redigering mv. Så tror bestemt det bliver en succes

#59

er det en smule had og fordomme omkring amd's komponent valg ;)?

Kan da være den rent faktisk er helt ok, og ikke siger synderlig meget :)?

Svaret blev redigeret 1 gang, sidst af ek91 d. 17-06-2015 20:36:52.

Men det var nu alligevel noget af en beskyldning nu når ingen faktisk kender til pumpen på kortet :)?

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Dx12 skulle da netop lade dig lægge dine ram sammen i sli/cf kontra dx11/11.1 hvor kun gpu power bliver lagt sammen, og ram forbliver "passiv"

Nej, indholdet af rammen behøves bare ikke være spejlede ved de to GPU'er (som det gør ved DX11), men det betyder ikke at GPU'erne kan bruge hinandens ram.

Svaret blev redigeret 1 gang, sidst af Biostud d. 17-06-2015 21:27:37.

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Dx12 skulle da netop lade dig lægge dine ram sammen i sli/cf kontra dx11/11.1 hvor kun gpu power bliver lagt sammen, og ram forbliver "passiv"

Nej, indholdet af rammen behøves bare ikke være spejlede ved de to GPU'er (som det gør ved DX11), men det betyder ikke at GPU'erne kan bruge hinandens ram.

Så tror jeg desværre vi er mange som kommer til at føle os dumme, og ikke mindst "snydt"

Eks se #58.

Syntes bare alle siger at dx12 vil kunne ligge vrm sammen når de kommer i sli/cf

Så det er vist mere alm. sund fornuft end fordomme..

#64 Snydt? Nej, man har muligheden i DX12, hvis udviklerne koder spillene decideret til det, det gør de næsten med garanti bare ikke, da spil i dag bliver udviklet med kæmpe fokus på konsollerne, som ikke har multi GPU. Derfor er det en utroligt lille del af gamere der vil få nytte af den feature, så de fleste udviklere vil bare spilde deres tid og tid er penge.

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Dx12 skulle da netop lade dig lægge dine ram sammen i sli/cf kontra dx11/11.1 hvor kun gpu power bliver lagt sammen, og ram forbliver "passiv"

Nej, indholdet af rammen behøves bare ikke være spejlede ved de to GPU'er (som det gør ved DX11), men det betyder ikke at GPU'erne kan bruge hinandens ram.

Så tror jeg desværre vi er mange som kommer til at føle os dumme, og ikke mindst "snydt"

Eks se #58.

Syntes bare alle siger at dx12 vil kunne ligge vrm sammen når de kommer i sli/cf

Tjho, men hvordan skulle en GPU kunne hente med andet end PCIe hastighed på tværs af kortene, det er jo en 20-30 GBps mod 512Gbps....

Svaret blev redigeret 1 gang, sidst af Shutdown d. 17-06-2015 22:24:21.

Nej, reviews/benchmarks bliver frigivet d. 24 når kortet har officiel launch. 😎

Noget helt andet slår mig...

Kan man med dx12 køre crossfire med eks 2x furyx kort?

I det tilfælde må den da gå ind og udnytte 8 Gb ram??

Også har man vel noget nær verdens videste grafik,?

Ved dog ikke om HBM ram vil scale på samme måde som Gddr5

Du får stadigt kun 4Gb pr. GPU

Man har aldrig fordoblet den effektive ram mængde i SLI/CF

Dx12 skulle da netop lade dig lægge dine ram sammen i sli/cf kontra dx11/11.1 hvor kun gpu power bliver lagt sammen, og ram forbliver "passiv"

Nej, indholdet af rammen behøves bare ikke være spejlede ved de to GPU'er (som det gør ved DX11), men det betyder ikke at GPU'erne kan bruge hinandens ram.

Så tror jeg desværre vi er mange som kommer til at føle os dumme, og ikke mindst "snydt"

Eks se #58.

Syntes bare alle siger at dx12 vil kunne ligge vrm sammen når de kommer i sli/cf

Tjho, men hvordan skulle en GPU kunne hente med andet end PCIe hastighed på tværs af kortene, det er jo en 20-30 GBps mod 512Gbps....

Det behøver de heller ikke. Hvis det beregnede billede deles op imellem kortene f.eks således at 1 kort tager øverste halvdel og nr 2 tager nederste halvdel (eller hvordan man vælger det f.eks også checkerboard metoden, der findes en del i AFR 1/2 mv)) og de samtidig lagre hver de tegnede teksturer i hver deres rambuffer, så det sådan set at "problemet" er løst for så sker der ikke parallel lagring mere. Dvs at hver korts ram bliver brugt til forskellige teksturer og selv om Vrammene som så ikke "lægges" sammen, så betyder det dog at den samlede Vram mængde bliver brugt fuldt ud på forskellige teksturer. Så effektivt vil 2+2GB vram blive 4GB samlet buffer til teksturlagrig.

Problemet har i og for sig været hvordan man får to eller flere GPU'er til effektivt at lagre forskellige teksturer og hvordan man API mæssigt kommanderer dem til at gøre det på effektiv vis.

Jeg håber i hvert fald at dette snart 17år gamle "problem" bliver løst med DX12 API'env 🙂

Svaret blev redigeret 2 gange, sidst af Gripen90 d. 18-06-2015 01:20:00.

Så fik vi dx12 på plads

Tror ikke der skal meget kodning til, for at fortælle gpu 2 eks klare bund, imens gpu1 klare top.

Og muligvis er det slet ikke nødvendigt at gøre "pr spil" men simpelthen lave det i en driver?

Tak #70

Så fik vi dx12 på plads

Tror ikke der skal meget kodning til, for at fortælle gpu 2 eks klare bund, imens gpu1 klare top.

Og muligvis er det slet ikke nødvendigt at gøre "pr spil" men simpelthen lave det i en driver?

Det er sådan set også sådan det fungerer i dag med multi GPU'er, men det er igen kun på selve GPU plan, hvor det handler om det at beregne og tegne et billede ligeligt mellem GPU'erne til maksimal udnyttelse, men det at kunne gøre det sammen med teksturlagringen til Vram er en helt anden problematik hvor det ikke blot er at lagre men også pre-fetche mv. Det har været hovedbrud i som sagt knap 17år.

3Dfx havde dog i sin tid med deres planlagte Rampage og Spectre grafikprocessorer en teknologi oppe omkring shadow memory som på software plan skulle lave en bro mellem to korts Vram mængde. Men inden de kom så langt bankede konkursen på døren.

Lige i forhold til AMD så har jeg lidt en ambivalent forhold til hvordan de lige pludselig "embracer" DX12 og forhøjer det til "gudestatus" i deres promotions.

Tænker vi blot tilbage til R9 200 lanceringen så var Mantle jo the thing for AMD og de gik direkte i API kamp mod Microsoft... men nu hvor de mere eller mindre har ladt Mantle dø i stilhed, så løber man over i anden grøft og prøver at ophøje det til next level når man for blot 2år siden var i direkte konkurrence mod det.... altså den ko-vending har jeg lidt svært ved at sluge.

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 18-06-2015 02:23:47.

https://www.youtube.com/watch?...

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 18-06-2015 01:39:01.

Det tror jeg undre os alle lidt.

Men de så vel hvor hårdt det var, når nu de skulle stå på egne ben, og samtidig kæmpe en kamp mod 2større penge magter.

Så tror måske, at de bare har valgt at følge med, for at bidrage lidt, men i særdeleshed høste goderne ved at kunne se præcis hvad der sker på tegne bordet :)

Og det er det, de vinder penge på nu

En anden ting er at det Mantle gjorde så fantastisk godt (udnyttelse af flere CPU kerner) er nu blevet en del af DirectX 12, så på en måde kan man sige at kernen i Mantle tankegangen er blevet indopereret i Dx12. Dette vil specielt give sig udslag i forskellen mellem Intel og AMD CPU'er som vi så med Mantle hvor AMD CPU'er pludselig kom meget tæt på Intel. Så på den måde er kampen jo ikke tabt, og AMD kan også se fordelen ved at få spiludviklere til at udnytte Dx12.

Tror nu vi skal prise os lykkelige for at Mantle satte en standard , som de "store" drenge ikke kunne kigge hen over.

Og uanset om dit spil bruger DX12 eller OpenGL Vulkan så er vi som brugere bedre stillet; efter så mange år har spil nu muligheden for at udnytte den hardware vi har stående.

På den anden side, bruger kun div-d til min skærm, men hdmi til hjemmebio

Er hdmi ikke ved at blive skubbet af banen af dp port?

:)

Bare der der er skrald på grafikken.

Man kan få adaptere til mange ting.

Det er i hvertfald i småtings afdelingen af brok ;)

Så skal man jo ud og have fat i en aktiv adapter og den er jo ikke helt billig.

Så er vi sat tilbage til monitors som har DP. Ikke noget med at bygge 4k HTPC eller smide computeren til et UHD TV.... 😐

Hvad med dp til hdmi 2.0?

Det må kunne skaffes

Hvis man vil smide sin computer til et UHD TV og køre 4k 60hz skal det gøres med HDMI 2.0 og det er pt. kun 9xx serien fra nVidia der kan det nogenlunde (men vist ikke i fuld spec har jeg læst).

Jeg sidder også og venter meget utålmodigt på at Intel og AMD får opdateret deres CPU/APU til at håndtere HDMI 2.0 så jeg kan få skiftet mit mediecenter med et der kan køre 4k. Men ak... ingen HDMI 2.0 endnu. Måske når Skylake kommer...

Læste bare et forum hvor folk talte om dp til hdmi

Nogle mente man kunne skaffe til 2.0 andre mente dog kun til 1.4 MEN at ved at gå fra dp, til hdmi burde det kunne køre som 2.0

Da 2.0 eftersigende kun skulle være ændret i transfer rate, og umiddelbart intet i selve kablet.

Se det er faktisk lidt spændende, nåede dog ikke at få læst hele forummet igennem før jeg igen skulle smide alt jeg havde i hænderne.... Kids wohoo