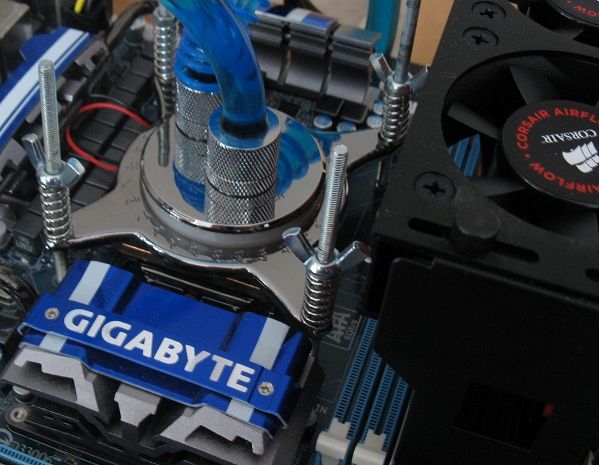

Test: Gigabyte GV-N26SO-896I

Grafikkort, NVIDIA d. 22. november. 2009, skrevet af vanovich 17 Kommentarer. Vist: 11670 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Gigabyte

DK distributør: Gigabyte

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Gigabyte

DK distributør: Gigabyte

#1

Undskyld men er det ikke et lidt gammelt grafikkort at have til test ?

#2

Det skulle tilfældigvis ikke være mine gamle kort ivan? 😀

Ellers en fint test de er virkelig gang i de kort lavede selv 28K resultater med to af dem i sli 🙂

Svaret blev redigeret 1 gang, sidst af Rasmus66 d. 22-11-2009 13:13:23.

Ellers en fint test de er virkelig gang i de kort lavede selv 28K resultater med to af dem i sli 🙂

Svaret blev redigeret 1 gang, sidst af Rasmus66 d. 22-11-2009 13:13:23.

#3

Fin og flot test af gamle kort. Faktisk rigtig flot ydelse af et så forholdsvis aldrende kort.

Er absolut ikke enig i at kortet burde have 4 i pris/køb. Koster i omegnen af kr. 1.300,- kroner eller mere. Alt for tæt på HD 5850 til at give denne fine bedømmelse medmindre man efterfølgende giver HD 5850 7 eller 8 😛

Mvh.

Ezi

Er absolut ikke enig i at kortet burde have 4 i pris/køb. Koster i omegnen af kr. 1.300,- kroner eller mere. Alt for tæt på HD 5850 til at give denne fine bedømmelse medmindre man efterfølgende giver HD 5850 7 eller 8 😛

Mvh.

Ezi

God wankermarkanmeldelse. 😐

Jeg havde dog set at du har testet kortet i nogle spil i stedet for wankermark. :no: 🤡

Svaret blev redigeret 1 gang, sidst af Anonym20219355916 d. 22-11-2009 13:11:09.

Jeg havde dog set at du har testet kortet i nogle spil i stedet for wankermark. :no: 🤡

Svaret blev redigeret 1 gang, sidst af Anonym20219355916 d. 22-11-2009 13:11:09.

#5

Måske lidt ældre kort, men ikke alle har 4k til det nyste kort, 😉

Derfor skal de stædig sammelignes. #3 kan godt være jeg var lidt gavnlige der, men iforhold til fx 275 kort ligger den godt.

#4 jo, men nu er det mest wankermark jeg spiller 😉

Mener det er tweaktown der har en gode sammeligne i spil, og den kort yder lidt bedre end 275 i mest af testne.

#2 Den en er ja, til sli test.

Derfor skal de stædig sammelignes. #3 kan godt være jeg var lidt gavnlige der, men iforhold til fx 275 kort ligger den godt.

#4 jo, men nu er det mest wankermark jeg spiller 😉

Mener det er tweaktown der har en gode sammeligne i spil, og den kort yder lidt bedre end 275 i mest af testne.

#2 Den en er ja, til sli test.

#6

Enig med #3 hvorfor bruge 1300kr på et kort som er ved at være forældet, når jeg for 400kr ekstra kan få 5850 som er langt hurtigere.

Prisen er ikke komplet urimelig, men 3 ville nok være en mere rimelig karakter.

Prisen er ikke komplet urimelig, men 3 ville nok være en mere rimelig karakter.

#7

Jo, enige . men langt hurtiger, ved jeg ikke helt :) og 400kr er også en slags peng.

#8

Bemærk, jeg mener ikke at kortet fortjener 1 eller 2, for det er ikke et langsomt kort og det er heller ikke dårligt tilbud, men havde det været mine penge ville jeg ofre de ekstra 400kr og blive teknisk helt opdateret og hastighedsmæsigt næsten i top.

#9

#8 400,- er godt nok mange penge hvis man er på SU, så jeg ville nok også taget GTX260 i stedet...

#10

Jeg ser GTX260 kort ligge i 1000-1100kr, og HD5850 ligger som det billigste på 1700. Det er trodsalt 600-700kr til forskel og det kan godt være nogen ikke mener det er ret meget, men det er trodsalt tæt på prisen for to af kortene.

Selv om GTX 260 ikke er det nyeste i båsen længere, så er ydelsen altså ikke blevet ringere og den ligger over HD5770. Om man så vil have ydelse el. DX11 er så op til en selv.

Sidst... HD5850 er jo pt. umuligt at støve op nogensteder, så jeg ser kun HD5770 som muligt alternativ.

Selv om GTX 260 ikke er det nyeste i båsen længere, så er ydelsen altså ikke blevet ringere og den ligger over HD5770. Om man så vil have ydelse el. DX11 er så op til en selv.

Sidst... HD5850 er jo pt. umuligt at støve op nogensteder, så jeg ser kun HD5770 som muligt alternativ.

#11

Hey Vano du vil kunne score lidt hQjre i 3D06 i cpu testen ved at slaa HT til 🙂

Svaret blev redigeret 1 gang, sidst af Nanok d. 23-11-2009 13:12:41.

Svaret blev redigeret 1 gang, sidst af Nanok d. 23-11-2009 13:12:41.

#12

John, jeg har prøvet at overtale ham 😛

Jeg mener årsagen var CPU var ustabil med HT... Jeg skulle udminbart mene det bør give helt op til 1500-2000 marks...

CPUmark2006 😀

Prøvede iøvrigt kortet kort, synes det var lækkert, helt vildt så meget bedre end std. udgaven det clocker, det er som at have et pre-voltmoded kort, og er nok også hvad det reelt set er, bare hvor garantien altså forbliver..... ;)

Jeg mener årsagen var CPU var ustabil med HT... Jeg skulle udminbart mene det bør give helt op til 1500-2000 marks...

CPUmark2006 😀

Prøvede iøvrigt kortet kort, synes det var lækkert, helt vildt så meget bedre end std. udgaven det clocker, det er som at have et pre-voltmoded kort, og er nok også hvad det reelt set er, bare hvor garantien altså forbliver..... ;)

#13

Godt med lidt debat :) ,#11 ved det godt, #12 de var en helt andet setup vi snakked om :) hvis cpu scorer stiger de 1500-2000! giver det så, hvor meget i total score? så skal man jo overvej om man vil kører med ht til, eller 200mhz mere og uden. Grippen , du har fuldstændige ret, men folk tror fordi de køber nyer generationer kort, at de for bedre yldser. jeg tænker mest på, hvad for man for pengne. De er det hele overclocking drejer sig om, selv om det er jo en dyr hobby. Når man skifter ud hele tiden.

#14

#6

Du trænger vist til at læse lidt reviews 😉

Denne overklokkede version af 260gtx vil være noget nær lige så hurtigt som et 5850 og når den så kan overklokkes så meget ekstra, er der vist ingen tvivl om hvilket kort der løber med sejren pris/performancemæssigt. I den kategori er der intet bedre pt.

Og så interessant er DX11 vist ikke endnu, eller er det?

Du trænger vist til at læse lidt reviews 😉

Denne overklokkede version af 260gtx vil være noget nær lige så hurtigt som et 5850 og når den så kan overklokkes så meget ekstra, er der vist ingen tvivl om hvilket kort der løber med sejren pris/performancemæssigt. I den kategori er der intet bedre pt.

Og så interessant er DX11 vist ikke endnu, eller er det?

#15

#14

Der er ingen DX11 spil endnu men de skulle komme engang hen i 2010.

Men performence vs. pris så er det GTX260 bedre end HD5850 men jeg havde nu alligevel taget et HD5850 da man også kan hente en del ekstra performence ved at overclocke det.

Problemet er så bare at HD5800 serien er komplet umulig at få fat på grunden alle de chip problemer der er lige pt ☹

Der er ingen DX11 spil endnu men de skulle komme engang hen i 2010.

Men performence vs. pris så er det GTX260 bedre end HD5850 men jeg havde nu alligevel taget et HD5850 da man også kan hente en del ekstra performence ved at overclocke det.

Problemet er så bare at HD5800 serien er komplet umulig at få fat på grunden alle de chip problemer der er lige pt ☹

#16

#15

Nej, der mente jeg heller ikke.

Hvis jeg stod for at skulle købe nyt gfx er jeg ikke i tvivl om hvad jeg ville gøre: Købe to af de anmeldte kort for at køre dem i SLI og så sælge dem efter 6-12 måneder. Til den tid vil de stadig kunne indbringe det halve på qxl og

- der vil være dx11 spil på markedet

- ATI's kort vil være faldet i pris

- de ny Nvidia kort vil være på markedet og måske et bedre køb end ATI

Nej, der mente jeg heller ikke.

Hvis jeg stod for at skulle købe nyt gfx er jeg ikke i tvivl om hvad jeg ville gøre: Købe to af de anmeldte kort for at køre dem i SLI og så sælge dem efter 6-12 måneder. Til den tid vil de stadig kunne indbringe det halve på qxl og

- der vil være dx11 spil på markedet

- ATI's kort vil være faldet i pris

- de ny Nvidia kort vil være på markedet og måske et bedre køb end ATI

#17

#16

Tvivler nu godt nok på du kan få så meget for dem på qxl om 6-12 måneder, men kan se din pointe 😎

Tvivler nu godt nok på du kan få så meget for dem på qxl om 6-12 måneder, men kan se din pointe 😎