Test

Lad os se hvordan den yder. Dette er også en chance for at se hvordan et AMD system yder mod diverse Intel systemer. De systemer jeg sammenligner med, er nemlig Intel baserede systemer.

Test system:

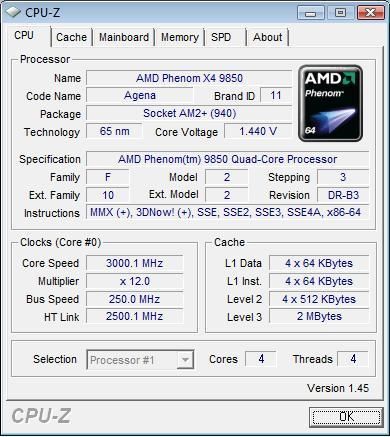

Gigabyte GA-MA78G-DS3H

AMD Phenom 9850 Black Edition - 2,5 GHz Quad Core

XFX 8800GTS 320 MB og HD3200 onboard grafikkort

2x 1 GB Team Group PC2-8500 @ 1066 MHz cas 5

Tagan I-Xeye 420 watt

Windows Vista Ultimate 64-bit

CPU kølet med:

NQ-3340WLA Extreme Cooler - luft køler med 120 mm blæser

Først vil jeg bare have frekvensen op, så jeg lader bundkortet stå med standardindstillinger, og ved hjælp af AMD's OverDrive program, begynder jeg at hæve multiplier'en.

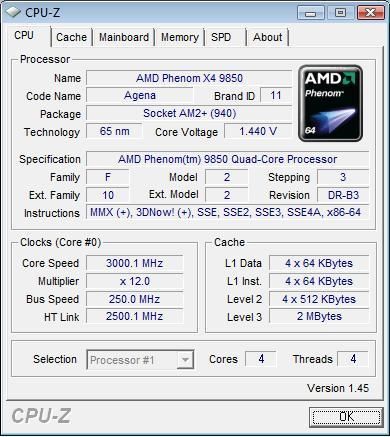

Det var jo ikke så svært. 3 GHz var hurtigt hentet. 3,1 GHz var jeg også oppe på, men kun kortvarigt. Min senere erfaring fortæller mig, at den pludselige sorte skærm efterfuldt af genstart, opstår hver gang mosfets bliver MEGET varme. Det var hvad der skete når jeg satte den til 3,1 GHz, eller hvis jeg belastede CPU'en ved 3 GHz.

Jeg får hurtigt hævet FSB frekvensen fra 200 til 250 MHz. Den vil ikke boote ved 255 MHz. Det er meget svært for mig at sige, om den er stabil ved de 250 MHz, da den stadig væk bliver meget varm og jeg er ikke glad for at presse den mere. Jeg vil helst ikke have et brændt bundkort på samvittigheden, som ikke er mit eget.

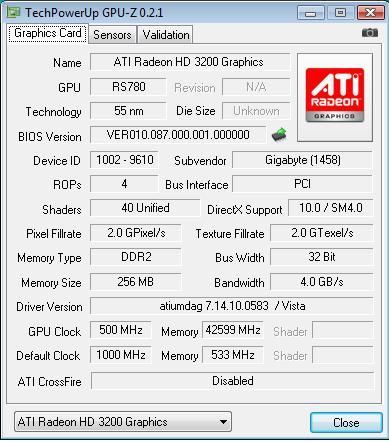

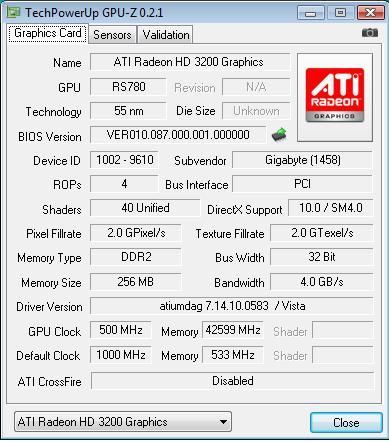

Det var da godt nok et kedeligt overclocking-afsnit. Heldigvis er det ikke helt slut. Det kan være vi kan nå at rette lidt op på det. Den opmærksomme læser, har nemlig set at man kan hæve GPU frekvensen i BIOS'en. This should be fun! Lad os overclocke et onboard grafikkort. Hvorfor er det kun GPU'en (Graphics Processing Unit) man kan clocke? Hvad med grafikrammene? Grafikkortet bruger jo systemrammene, så derfor er denne indstilling der ikke.

GPU'en blev bare ved, og ved, og ved. 500 MHz blev til 1000 MHz. Den ville dog ikke boote med en frekvens over de 1000 MHz, men et overclock på 100 % er da også ret pænt. Crysis kunne jeg dog ikke køre ved 1000 MHz. 900 MHz skulle jeg ned på. 3DMark var lidt hårdere ved GPU'en, og her skulle jeg helt ned på 800 MHz. Et stabilt overclock på 60 % er stadig rigtigt pænt.

Lige et par tips: Det hjælper IKKE at hæve spændingen til hverken nordbroen eller sydbroen når man overclocker GPU'en. Det har jeg testet. Når man overclocker GPU'en, bliver nordbroen temmelig varm, så hvis man vil beholde sit bundkort, skal man lige smide en blæser på. Her kan vi så hurtigt konkludere, at det er fint med passivt køling, men vil man lege, skal man montere blæsere på både nordbroen og mosfets.

CPU overclocking var en fiasko, men overclocking af GPU'en var bestemt ikke. I de grafik benchmarks i skal se om lidt, har jeg sat resultater ind både ved standardindstillinger, og med GPU'en overclocket til 800 MHz.

Testen

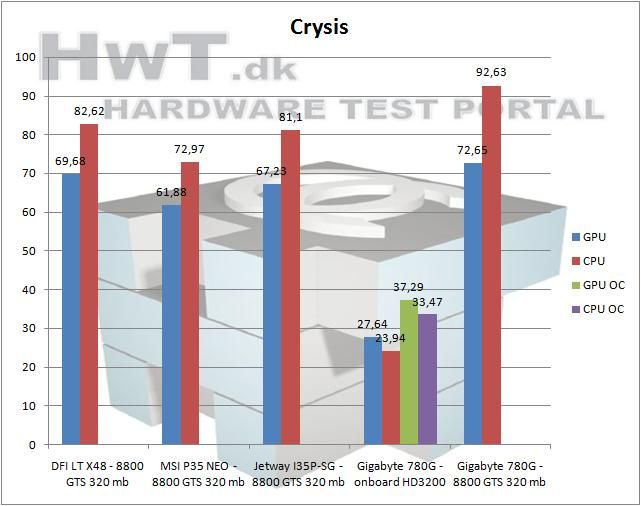

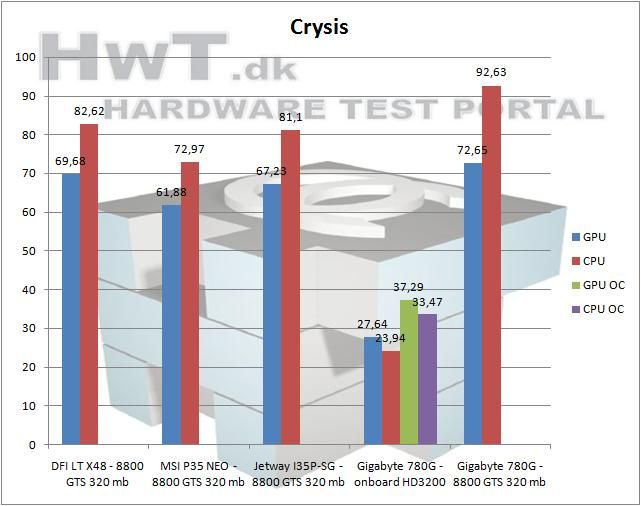

Lad os lige starte med noget Crysis. Denne test er med DirectX10 og 64-bit support.

På trods af at Q6600 CPU'en i de andre systemer yder bedre, er det alligevel på mystisk vis, lykkedes dette setup med mit 8800 i, at overhale og sparke fra. Meget imponerende.

Med hensyn til onboard grafikkort... Man kan jo rent faktisk spille Crysis med det! Jeg viste godt at dette grafikkort sikkert er det bedste onboard på markedet, men jeg havde alligevel en fordom, som ganske vidst lige er blevet fjernet. Tak for det. Her kan man også se hvordan overclocking af GPU'en giver et fint boost.

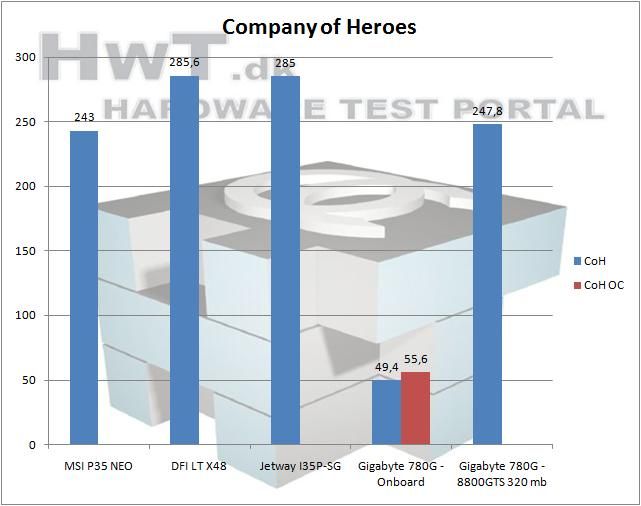

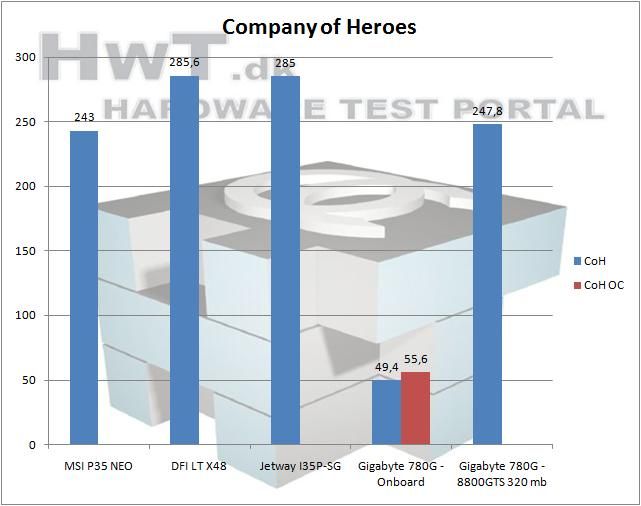

Company of Heroes

Et strategispil med flot grafik.

Dette resultat stemmer mere overens med mine forventninger i forhold til Q6600 vs. Phenom. Igen viser det onboard HD3200, at det faktisk godt kan brugers til gaming. Personligt finder jeg det dog mere relevant at bruge det i CrossFire sammen med et highend eller midend grafikkort. Desværre har jeg ikke sådan et til rådighed.

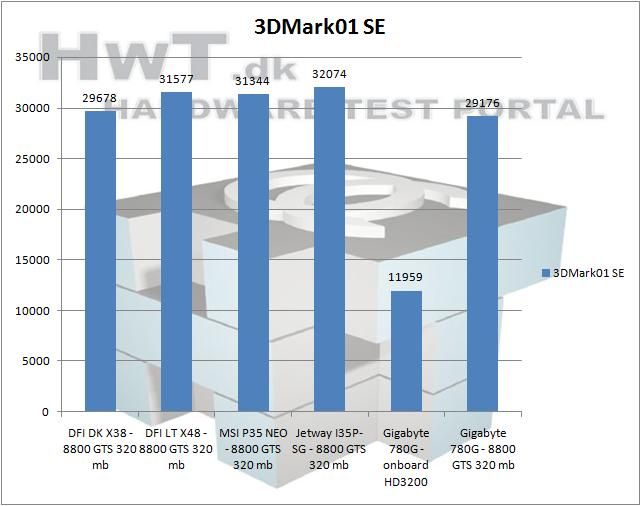

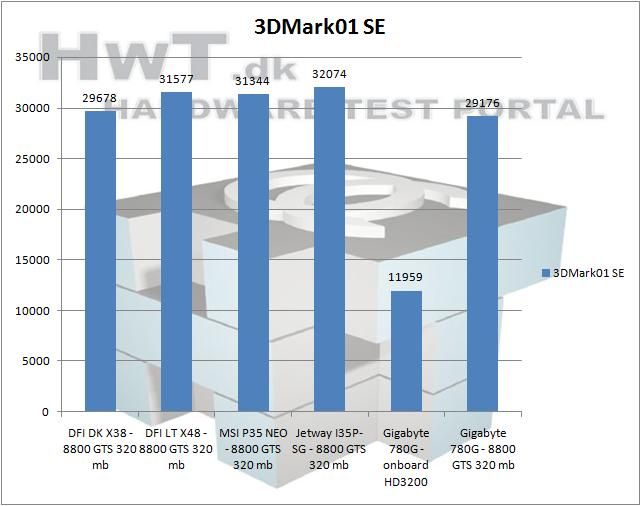

3DMark01 SE

3DMark01 er en ældre benchmark. Det betyder at den kun kan udnytte én af de fire kerner i cpu'en. En anden speciel ting ved 3DMark01 er at den, ironiskt nok, er utroligt cpu-krævende. Derfor vil man kunne se en drastisk stigning i scoren, når man begynder at overclocke på cpu'en, men lige netop det kigger vi ikke på i dag.

Som i kan se, står der et fint "0" som resultat med overclocket GPU. Der er kun en måde at sige det på: 3DMark01 crashede. Det tog mig mange forsøg at få et resultat uden overclock, men til sidst lykkedes det dog. Meget mærkeligt at programmet gik ned med fejl. Så snart jeg installerede mit 8800GTS, virkede det uden problemer.

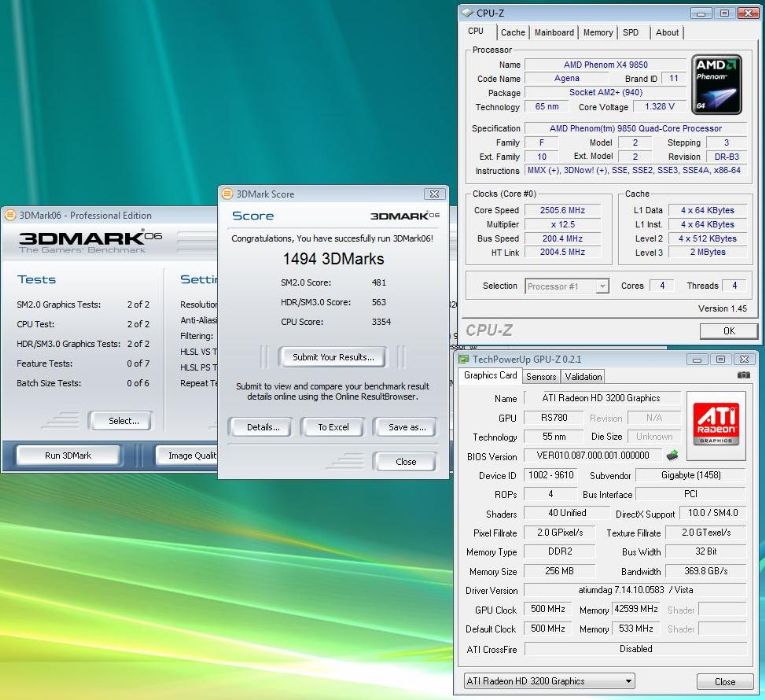

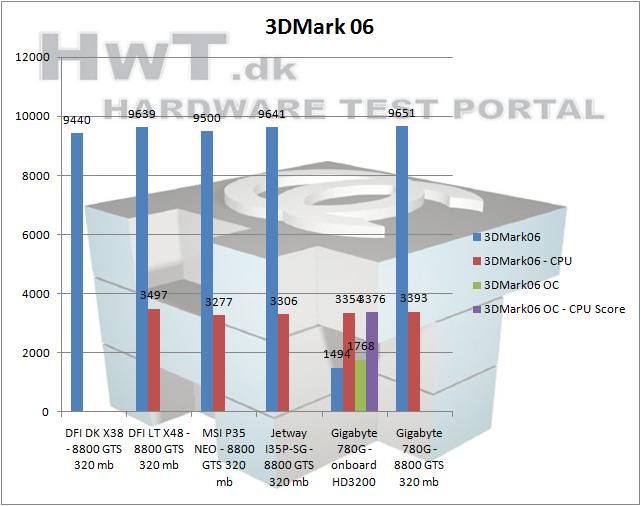

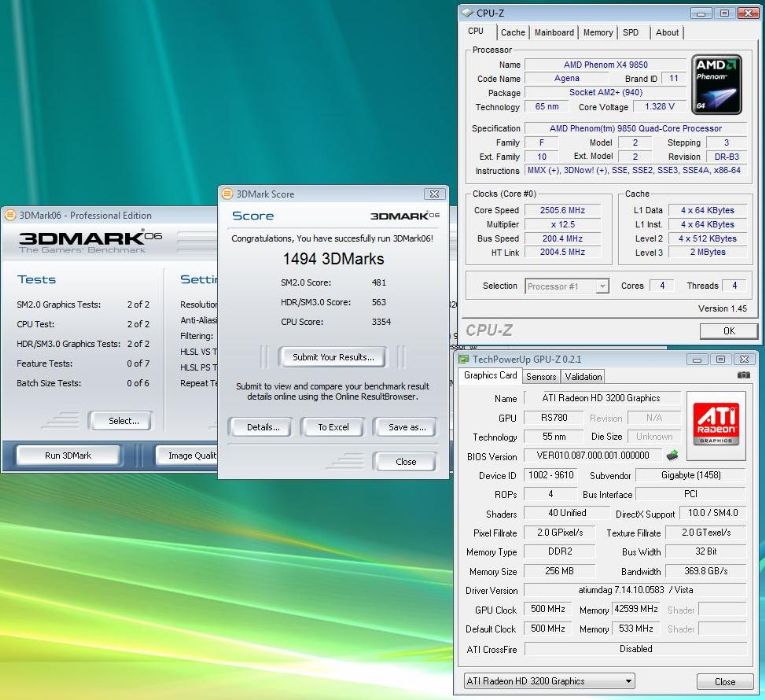

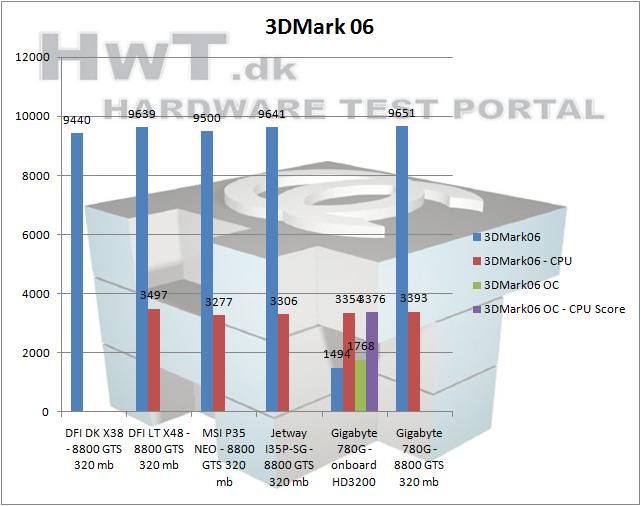

3DMark06

Det er en benchmark de fleste med lidt hardwareinteresse kender. Den hiver alt hvad den kan ud af cpu og grafikkort. Alle fire kerner i cpu'en bliver brugt.

Det ser ud til at det kræver det nyeste Intel chipsæt, for at skubbe AMD af vejen. Både i CPU scoren og den generelle score giver dette bundkort et meget flot resultat. Godt gået af AMD og Gigabyte.

Onboard grafikkortet halter en del bagefter i denne test. Vi er alt for tit nede i nærheden af 5-10 FPS.

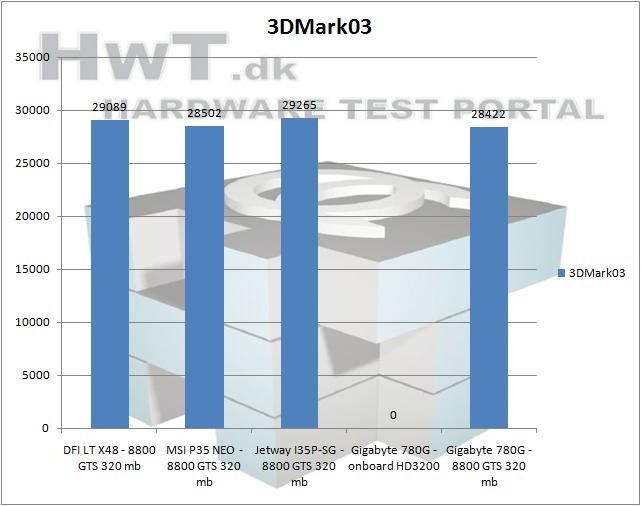

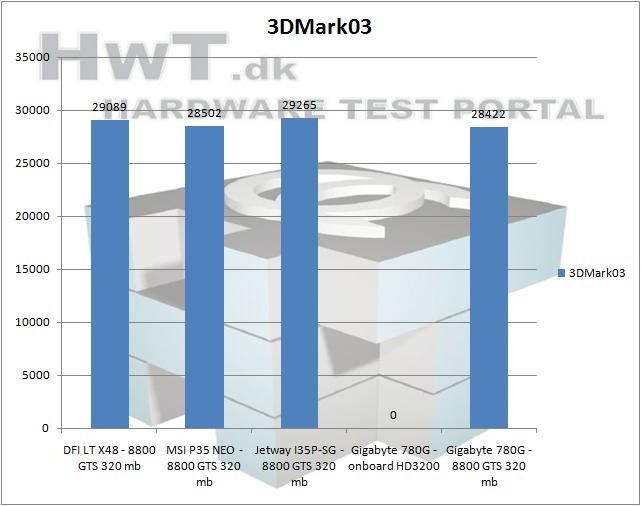

3DMark03

Endnu et glimrende benchprogram fra Futuremark's serie.

Yep, der var igen et stort 0 til onboard grafikkortet. Igen går benchmarken ned halvejs igennem. Programmet holder op med at svare.

Ydelsen med 8800GTS er pæn. Det ligger tæt, men Gigabyte bundkortet ligger til sidst.

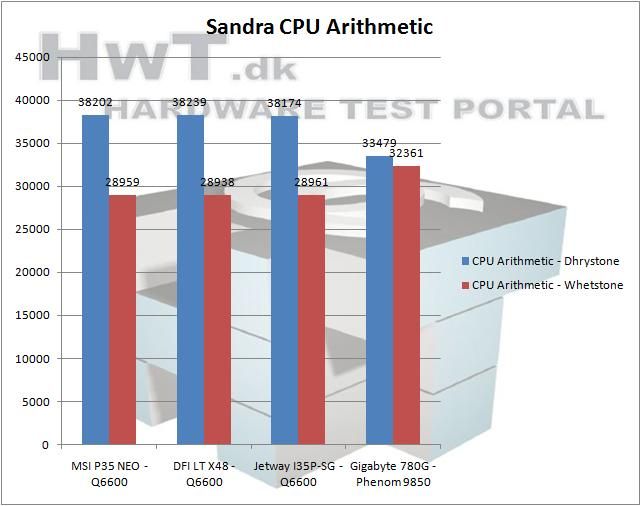

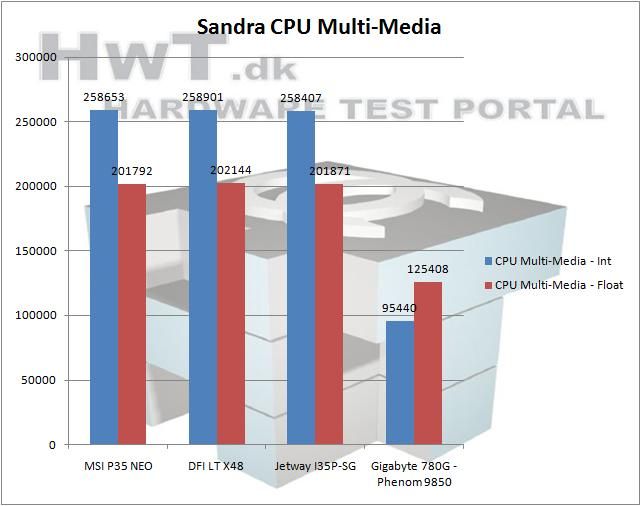

CPU Benchmarks

SiSoftware har lavet et allround benchprogram som bl.a. kan teste cpu'ens ydelse, og senere skal vi også kigge på rammenes ydelse med selvsamme program.

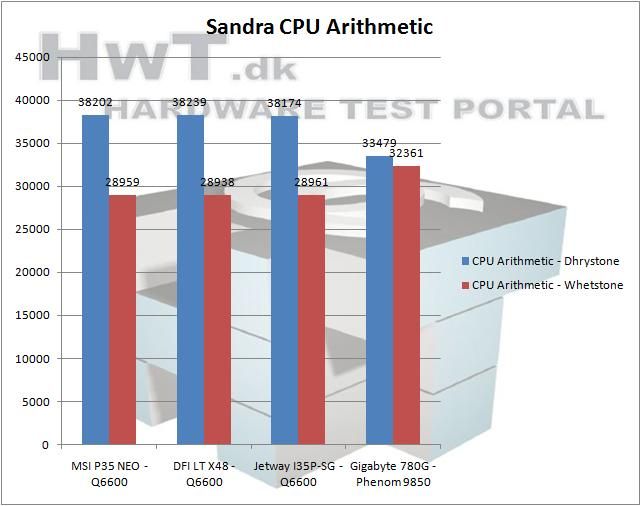

Arithmetic: Svært at sige om det er god eller middelmådig ydelse. Kigger man på Dhrystone kan den jo ikke følge med. Men kigger man over mod Whetstone, er den hurtigst.

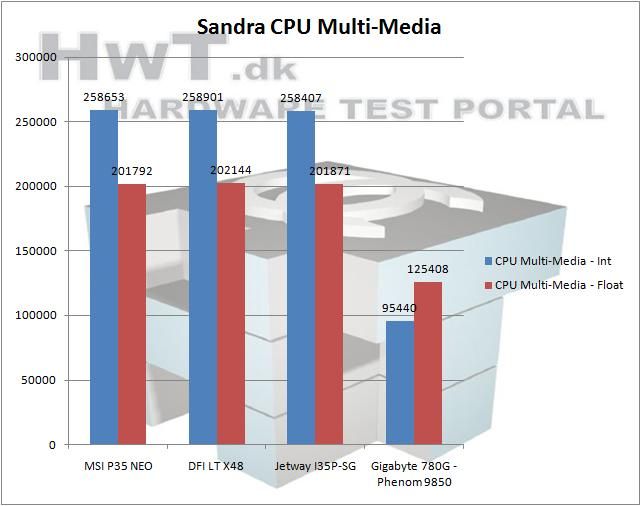

Multimedia: Multimedia er vist et no-go med dette system.

Ram Benchmarks

Lad os lige tage noget ram benchmark inden vi går videre til SuperPi.

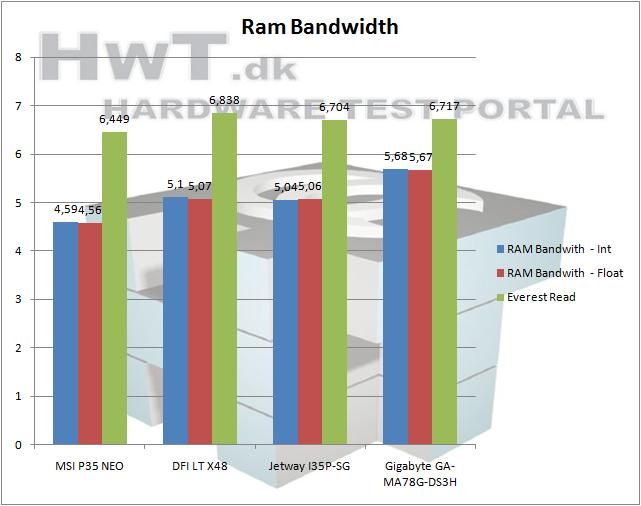

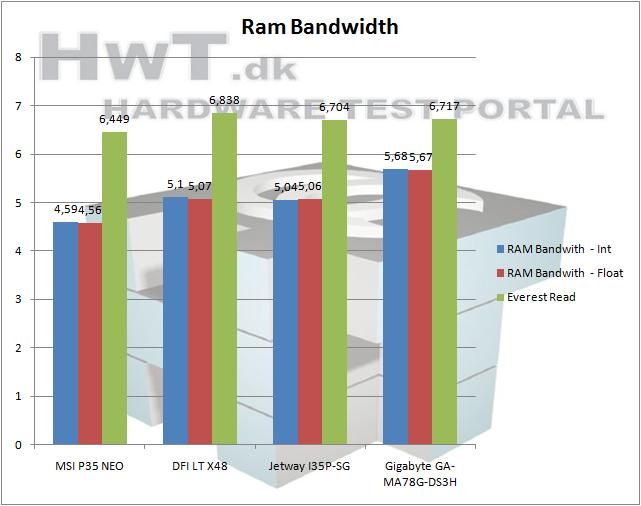

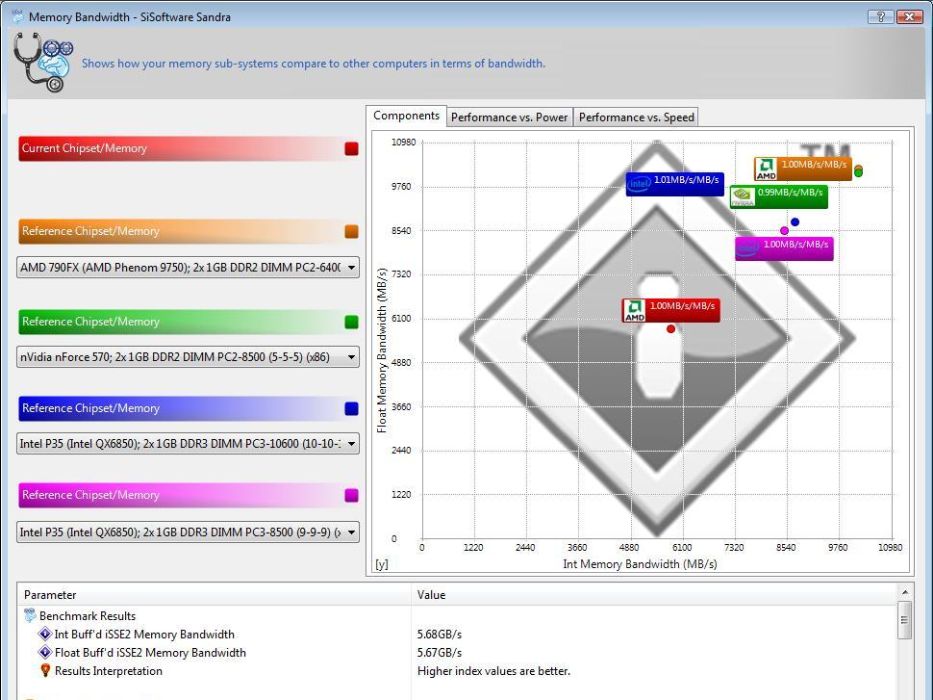

Bandwidth viser rammenes båndbredde i GB/s.

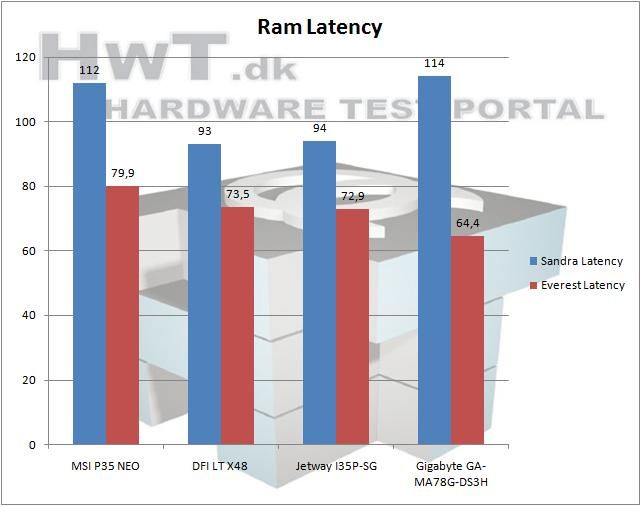

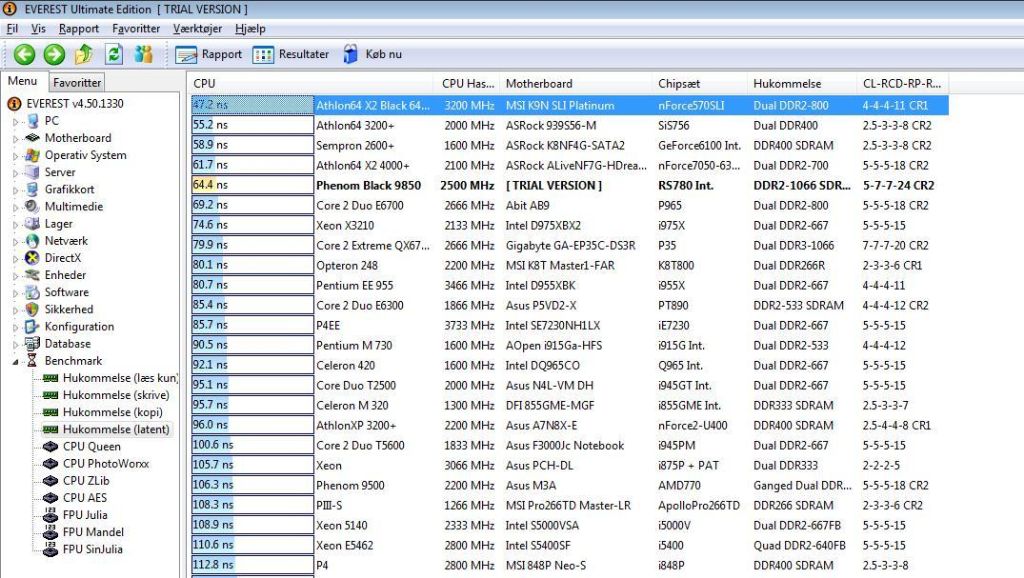

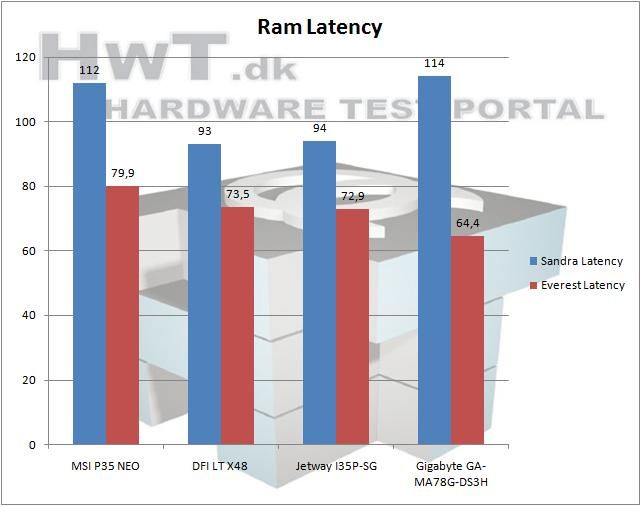

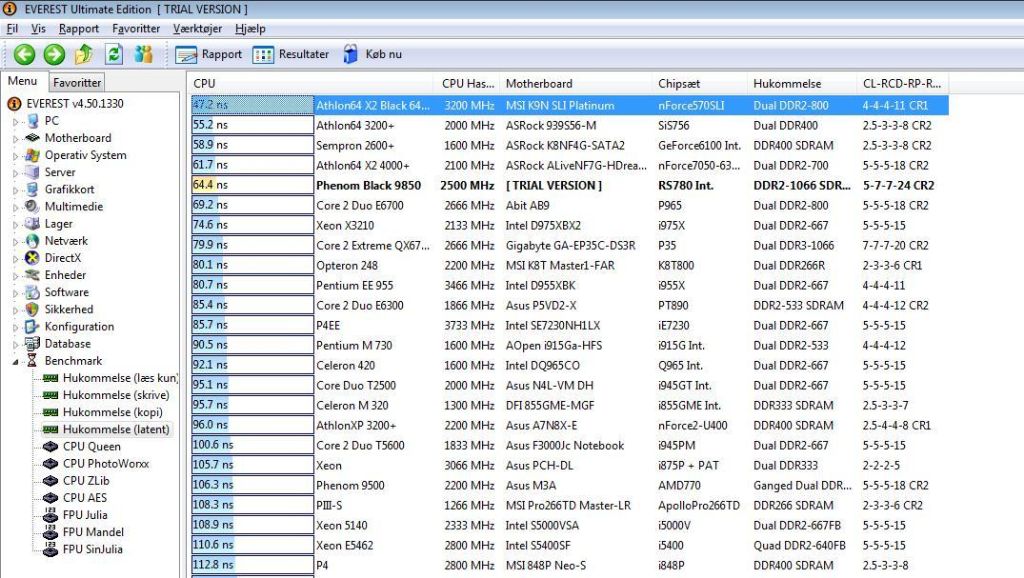

Latency viser rammenes responstid i ns (lavere er bedre).

Bandwidth: Som forventet er det her der vises tænder. AMD har deres ram-controller bygget ind i CPU'en, hvor Intel har deres monteret på bundkortet. Det giver tydeligvis en bedre ydelse at have den bygget ind i CPU'en.

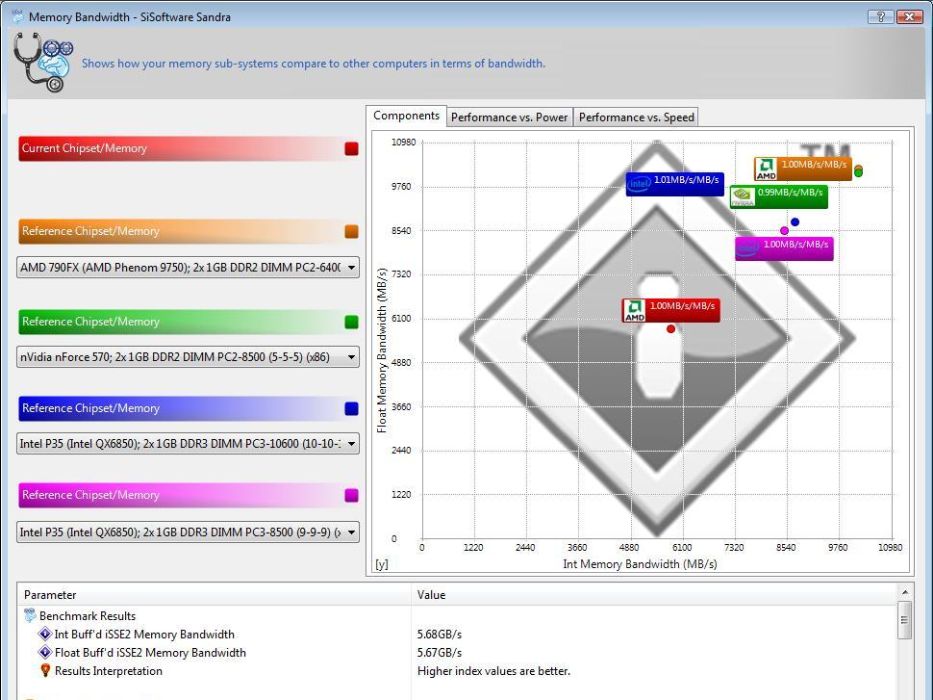

Latency: Jeg vil tro, at den langsomme responstid Sandra viser, er en fejl. Jeg prøvede at hæve ram hastigheden, og den viste stadig 114 ns.

SuperPi

Et stk. gammel benchmark som kun udnytter én kerne. Med andre ord: En tur i parken for en moderne quad core.

Skulle man tro... Jeg har prøvet andre ram, anden PSU, mere vcore, mindre vcore, lavere clockfrekvenser, højere clockfrekvenser og sågar en anden CPU (Phenom 9600), men SuperPi crasher. Den kommer ikke med fejl, den gør lige som de 3DMark programmer, som går ned ved brug af onboard grafikkort; SuperPi svarer ikke. Jeg vil derfor konkludere, at det bundkort jeg er blevet udstyret med er defekt.

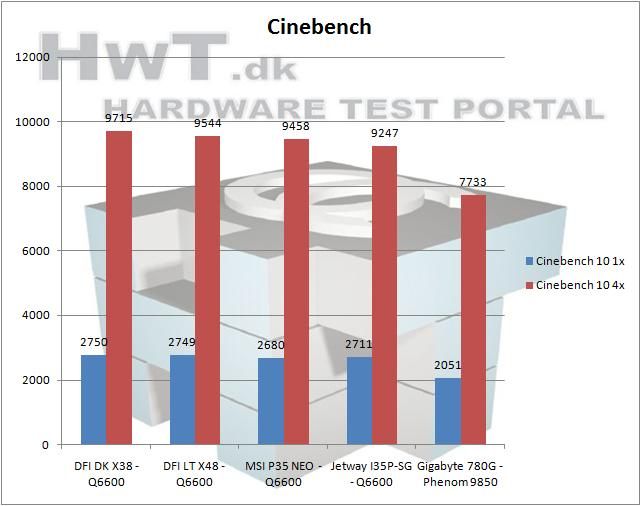

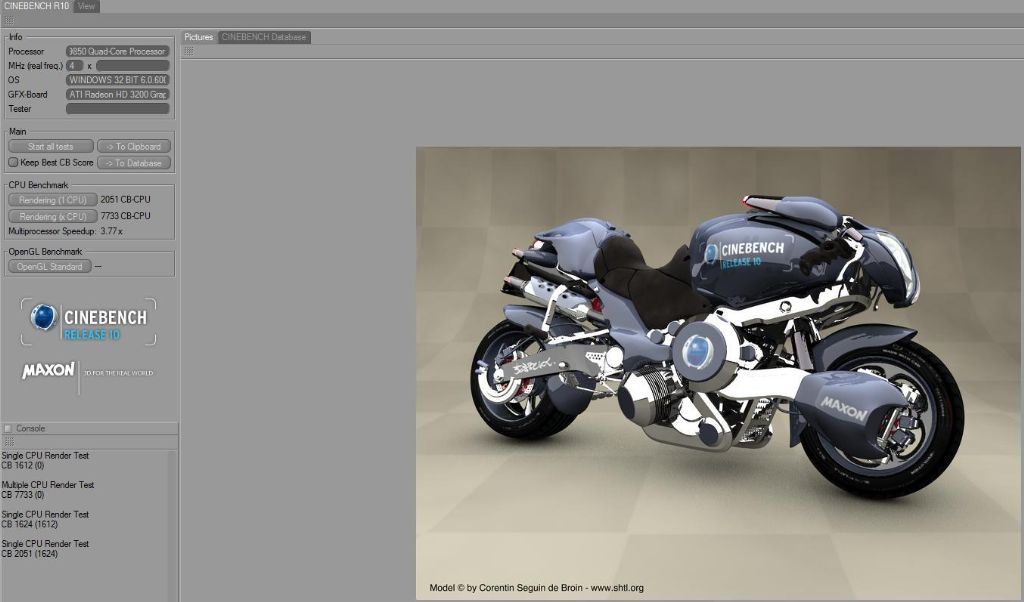

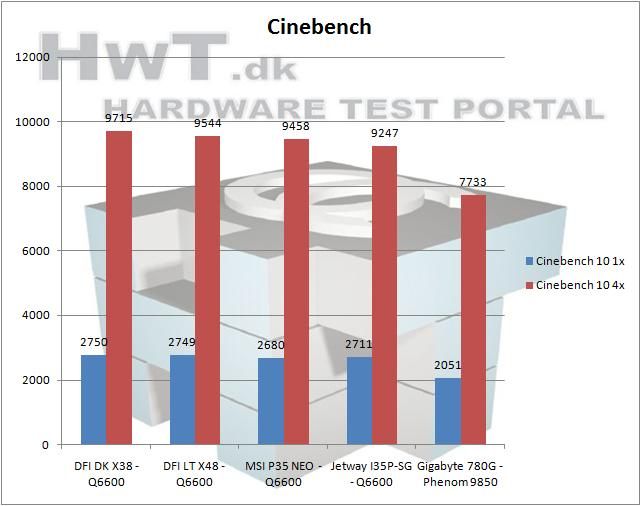

Cinebench

Benchmark der både kan udnytte én eller flere kerner.

Som forventet kan Phenom 9850 ikke følge med Intel's Q6600.

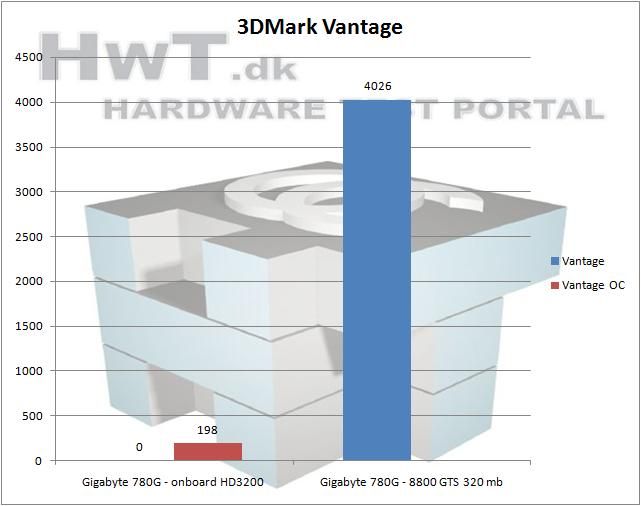

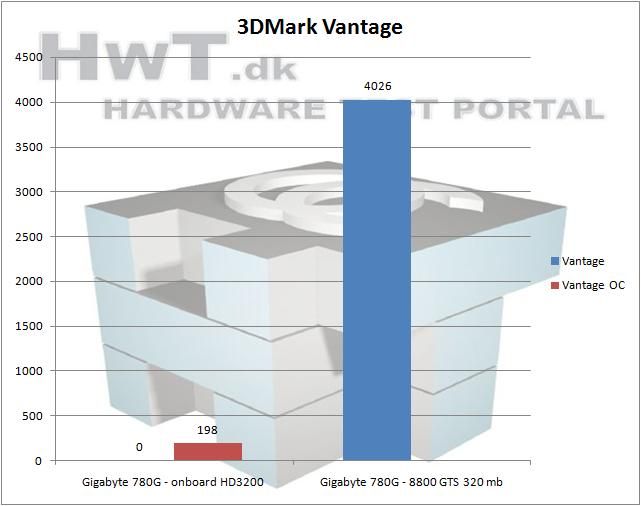

3DMark Vantage

Vi runder af med det nyeste fra Futuremark. 3DMark Vantage er splinternyt og utroligt krævende. 3DMark Vantage fungerer kun med Direct X 10.

Som sagt er det helt nyt, så jeg har ikke noget at sammenligne med. Vi kan bare konkludere, at det onboard HD3200 altså IKKE kan følge med et 8800GTS, selvom det er overclocket.

Årh ja, igen et resultat som er "0". Men sjovt nok crashede benchmarken ikke når jeg havde overclocket GPU'en. Meget mærkeligt.

Generelt

Tja, det yder fint og i nogle 3D applikationer meget fint. Her tænker jeg f.eks. på Crysis, hvor den langsommere Phenom 9850 overhaler Core 2 Quad Q6600.

Desværre ser lige netop dette bundkort ud til at være defekt. Af uforklarlig årsag, er der flere benchmark programmer der går ned. Det hændte da også flere gange, at jeg fik BSOD. Meget ærgerligt.

Hvis dette bundkort var af størrelsen micro-ATX, ville jeg sige at dette bundkort er det perfekte mediacenter bundkort.

Sammenlignet med:

Intel Q6600 B3 - 2,4 GHz quad core

XFX 8800GTS 320 MB

2x 1 GB Team Group PC2-8500 @ 1066 MHz cas 5

Tagan I-Xeye 420 watt

Windows Vista Ultimate 64-bit

CPU kølet med vandkøling.

Programmer:

3DMark Vantage

3DMark06

3DMark03

3DMark01 SE

SiSoft Sandra

Everest

Company of Heroes

Crysis - DX10

Cinebench 10

SuperPi MOD 1.5

Førstehåndsindtryk:

Mit første indtryk af Phenom cpu'en er klart positivt. CPU forbruget er aldrig højt når du hopper rundt i Windows, og der er en rigtig god respons. En anden ting jeg lagde mærke til var at CPU'en var meget kold, men mere om det senere.

Mit første indtryk af dette Gigabyte bundkort var også positivt. Det fungerer bare og kører derudaf. Men så kom jeg til at tænke på den manglende køling på mosfets.... jeg satte en finger på, og brændte den! På det tidspunkt havde jeg endnu ikke prøvet at sætte maks. load på CPU'en, og det er vidst kun meget godt. Jeg satte en 80 mm blæser over, og så faldt temperaturen til "lun". Jeg ville meget gerne have givet jer en temperatur, men mit digitale termometer viste pludselig at rumtemperaturen var 7,5 grader, så jeg føler ikke at jeg kan komme med en korrekt temperatur. De meget varme mosfets ødelægger desværre idéen om den passivt kølede, 4 kernede CPU.

Jeg kontaktede Gigabyte, da jeg var nervøs for de meget varme mosfets. For da jeg begyndte at overclocke, blev de igen ekstremt varme, selv med en hidsig blæser over. Gigabyte skriver venligt tilbage, at deres nye bundkort ikke er dimensioneret til AMD's 9850 CPU, som er AMD's bedste CPU. Er det bare mig, eller er det ikke en anelse dumt? Nå, men de siger også at den kan klare fuld load i et døgns tid med den CPU, så jeg fortsætter med overclocking, da jeg jo oven i købet har en blæser på - så er det vel ok?

Overclocking

CPU'en er tidligere blevet testet her på siden, så jeg ved den kan klare 3,1 GHz ved 1,45 volt. Så jeg sætter spændingen op til 1,4, til at starte med. Da jeg så kommer ind i windows, kan jeg se at bundkortet overvolter til 1,45 volt.