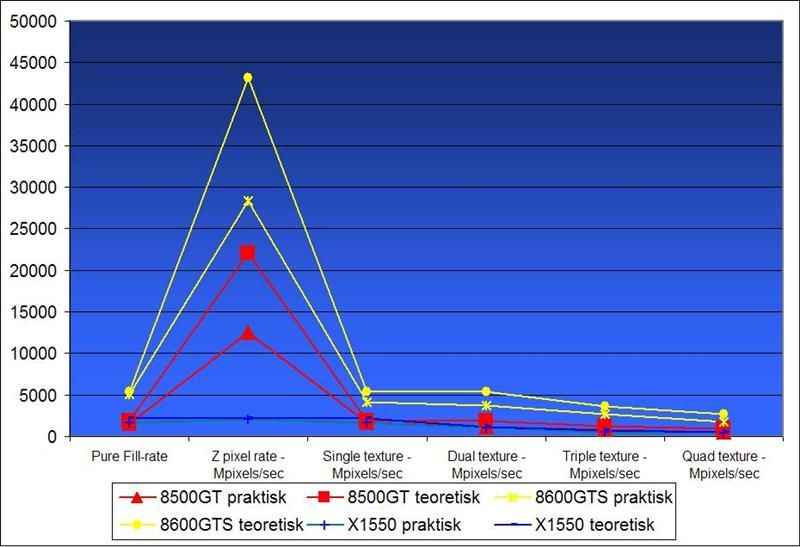

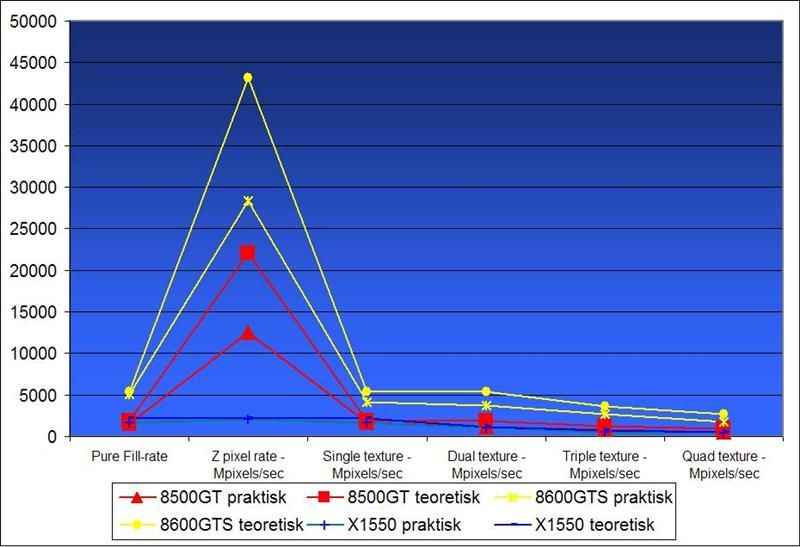

G84-chippens råydelse testes herover. Det kaldes Fillrate, og beskriver hvor mange pixels den kan lave i sekundet. Vi har indtil videre ikke hørt noget om antal af pipelines endnu, men vores måling herover siger at chippen har 16pipelines (16pixels per hz) og 8ROPs (max 8 færdige pixels ad gangen), derudover kunne alt tyde på, at den kan beregne filtrering på 32pixels ad gangen. Det lyder som spildte kræfter, men mange effekter bruger flere pipelines ad gangen, og derfor vil det være spild af transistorer at sætte flere ROPs på. Da effekterne er flyttet over på den nye Unified Shader, er pipelines vigtigste opgave at filtrere overflader og lave skarpere billeder. Vi tester kun kortets evne til at lave overflader, og så har det ”kun” 16 pipelines. Det vi ser er, at kortet faktisk får mere og mere råydelse, jo mere det bliver presset. Nu er det ikke sammenlignet med 8800GTS, men under pres er dette 8600GTS pixelydelse faktisk den samme som 8800GTS.

I shadertesten kommer der noget mere gang på kortet. Og med 32shaderunits ved 1450Mhz burde der også ske ting og sager.

Ser man især på de tunge-test er 8600GTS de andre kort overlegne, faktisk næsten 100% hurtigere end X1800XL. Hvis kortet får nogle mindre tunge effekter som oftest vil være repræsenteret i spil som Doom3, har X1800XL pludselig en fordel.

Men der kan være rigtig mange grunde til at ydelse kun ligger omkring X1800XL. Programmet er ved at være halvgammelt, og Geforce 8600 fungerer muligvis bedre med nyere effekter baseret på shadermodel 3.0 og DirectX10’s kommende shadermodel 4. På den anden side er det måske virkelighed. Det vigtigste at bemærke er at grafikkortet faktisk sparker ret godt fra sig jo tungere effekterne bliver. Et godt tegn på at det vil klarer sig godt i fremtiden.

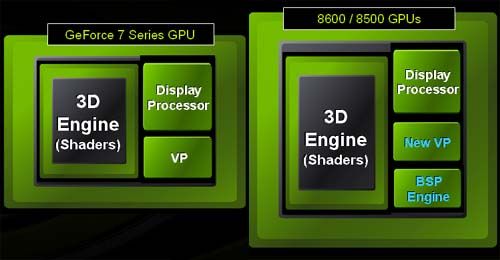

Yderlige egenskaber

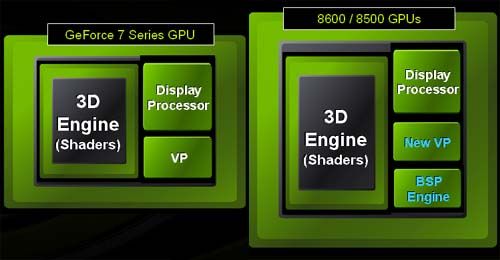

PureVideo HD er Nvidia’s ord for video-dekodning. Geforce 8-serien har selvfølgelig Pure-video-egenskaber,der nu er blev udvidet med en HD-betegnelse . Pure-video HD udvider de gamle PureVideo-egenskaber med forbedret støjreduktion(HD noise reduction) og skarpere kanter (HD edge enhancement)

8600/8500-serien er også det første grafikkort der kan sende beskyttet indhold over dual-link-DVI. Kort forklaret betyder det at man kan se HD-materialle i full-HD med de nye 8500/8600grafikkort. Tidligere var det kun muligt at se 720P (720liniers opløsning) pga. at kodningen var begrænset til single-link(et halvt DVI-stik) http://www.nvidia.com/page/pur...

SLI De nyere Nvidia grafikkort understøtter SLI, og det gør 8600 og 8600 selvfølgelig også. Kort fortalt betyder det, at hvis man har et bundkort der er SLI-mærket kan man bruge to ens Nvidia-grafikkort, og udnytte deres samlede kræfter på en skærm. Vi snakker om Geforce 7100GS og større.

FSAA står for Full Scene Anti Aliasing, og er med til at give en fiktiv højere opløsning end det ellers ville være muligt. En egenskab der især er en fordel på fladskærme der kun har en til to ægte-opløsninger. 4x, står for 4 gange så mange pixels, og det giver sig til syne på skærmen som få eller ingen blinkende pixels, og ingen ujævne og hakkede kanter. Geforce8-serien har derudover flere typer. Den nyeste er CVAA, der udvider den gamle form til 8 og 16x uden at gå på kompromis med billedekvaliteten, og stadig med fornuftig ydelse.

Texture-Filtrering Er en egenskab der er på næsten alle grafikkort. Idéen er at man oprindeligt har opbygget computerspillene for den bedste ydelse. For at grafikkortet får mindst muligt at lave, er detaljerne ikke så fine dybt i billedet som forrest. Det gør at overgangene mellem de dele med færre detaljer op til dem med mange, bliver meget tydelig. Og problemet løses med filtrering. Det nyeste hedder Anisotrofisk Filtrering og kan bruges af praktisktaget alle grafikkort efter år 2000. nVidia skulle til at bruge en ny løsning der giver meget høj kvalitet.

Quantum Effects En ny egenskab der kan lave Fysik-effekter sideløbende med grafikken, takket være den unified shader. Det gør at man reelt ikke behøver et Fysik-kort længere, men det vil også betyde at Fysik’en vil kunne sænke ydelsen på grafikkortet. Men klart et spændende tiltag.

Strømforbrug

Strømforbruget med Geforce 8600GTS er sat til max 71watt. Dette er faktisk utroligt lavt, set i forhold til bl.a. 8800GTS der ligger omkring 150watt og 8800GTX der har et max på 185watt. 71watt gør at kortet ikke behøver at have strømstik. Nvidia har dog valgt at tilføje dette alligevel, til os strømhungrende mennesker der ønsker at overclocke. PCI-E 16x-slottet kan udfra specifikationerne understøtte op til 75watt, derudover har man brug for ekstra strømstik. 8600GT bruger derudover max 43 watt og lillebroderen 8500GT 41watt.