X1900XT & G71 benchmark

Diverse d. 12. januar. 2006, skrevet af Illuminati 33 Kommentarer. Vist: 487 gange.

#1

sikkert mig men hvad menes der her?

#2

1#

Du kan se hvad Hexus mener de nye kort kommer til at score i 3DMark 2005.

Jeg vil nødigt se 7900 i SLI, det sparker godt nok fra sig det kort, hvis de resultater passer.

Du kan se hvad Hexus mener de nye kort kommer til at score i 3DMark 2005.

Jeg vil nødigt se 7900 i SLI, det sparker godt nok fra sig det kort, hvis de resultater passer.

#3

Og hvor mange spil understøtter så lige SLI endnu - her godt 6 mdr efter at det blev fysisk muligt at køre det nogenlunde fejlfrit...?

:00 :00

:00 :00

#4

ATI vil virkelig være på røven hvis de resultater passer... Av hvor 7900 viser tænder!

#5

Mmmmm... Me savle!

Glæder mig sgu til de kommer. Hvis der er hold i de resultater, så bliver de godt nok heftige!

Glæder mig sgu til de kommer. Hvis der er hold i de resultater, så bliver de godt nok heftige!

#6

#3 good point ;)

SLI er seriøst ikke andet end blær, og penge ud af vinduet. Der hvor jeg mente SLI måske kunne have sin force var hvis de kunne forhindre pluselige fps drops (det der er kilde til irritation hvis man sidder med det bedste af det bedste og har over 60fps 98% af tiden), men ak, det er de endnu værre til end med non-SLI opsætninger :l

Man burde IMO satse mere på at lave gfx der kan lave FSAA og AF uden betydelige tab og bedre gfx-engine programmering - uden at kunne agumentere for det, så tør jeg godt påstå at de grafikkort vi har idag kan levere langt bedre grafik hvis bare programørene bag grafiken ikke var presset af deadlines osv...

SLI er seriøst ikke andet end blær, og penge ud af vinduet. Der hvor jeg mente SLI måske kunne have sin force var hvis de kunne forhindre pluselige fps drops (det der er kilde til irritation hvis man sidder med det bedste af det bedste og har over 60fps 98% af tiden), men ak, det er de endnu værre til end med non-SLI opsætninger :l

Man burde IMO satse mere på at lave gfx der kan lave FSAA og AF uden betydelige tab og bedre gfx-engine programmering - uden at kunne agumentere for det, så tør jeg godt påstå at de grafikkort vi har idag kan levere langt bedre grafik hvis bare programørene bag grafiken ikke var presset af deadlines osv...

SLI er kun godt hvis man sidder klistret til skærmen og kigger 3d mark dagen lang, ellers er det noget hø som man INTET vinder på i spil..

#8

Helt enig, #6. Vi mangler bedre engines der udnytter vores dyrt indkøbte hardwarekræs. I fremtiden håber jeg flere udviklere vælger at købe licenser til engines der er gennemtestet og optimerede. Det bliver vel sværere og sværere at kode til stadig mere kompliceret gfx-hardware og dual-core, tænker jeg.

#9

stik det lige et PPU-kort først... De bliver mega CPU-begrænsede ligemeget hvad... :00

#10

#9, cpu begrænsning er lidt overvurderet..

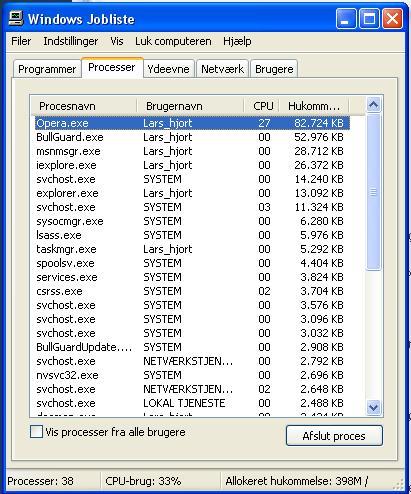

kig her:

http://www.hardware-test.dk/ht...

HL2, Farcry og Doom3. (doom3 kun delvist)

Altså i COD2, BF2, FEAR kunne vi sagtens bruge mere grafik-kraft. Og det er sjovt nok tre nye spil. De nye spil knækker jo gfx'erne under AA/AF. Det kunne man jo undgå med mere gfx-power.

kig her:

http://www.hardware-test.dk/ht...

HL2, Farcry og Doom3. (doom3 kun delvist)

Altså i COD2, BF2, FEAR kunne vi sagtens bruge mere grafik-kraft. Og det er sjovt nok tre nye spil. De nye spil knækker jo gfx'erne under AA/AF. Det kunne man jo undgå med mere gfx-power.

#11

Uden at have læst testen, men kun resumeet, så tænker jeg bare "Bah"

De tester 7900 på en dual-core, og de andre på en single?

Er det bare mig, eller er det usammenlignlige resultater..

De tester 7900 på en dual-core, og de andre på en single?

Er det bare mig, eller er det usammenlignlige resultater..

#12

#13

hmm FX-60 kører da kun 2,6 Mhz på hver kerne ikke 2,8 som der skrives.. for så er det da clocket..

#14

Så vidt jeg ved er 3Dmark05 efterhånden vertex begrænset når man snakker high end kort, det passer også udemærket med at SLI / XF ikke giver det store (geometri kan ikke rigtig deles ud over flere kort). Det at 25mhz (4%) mere på kernen og 100mhz mere på mem (6.8%) af X1900 giver 1100 (11.5%) ekstra, taler også for vertex begrænsning Smid X1900 op på samme kerne hastighed som 7900, så vil de sikkert ligge lige i 3Dmark05.

Som #6 er inde på bliver det mere spændede at se hvordan de nye kort klarer minimums FPS, hvilket 3Dmark05 tallene jo langt fra viser. 3Dmark fans må så vente på den nye benchmark før de vil kunne se rigtig forskel på kortene (forudsat at 7900 og 1900 kan clockes ens).

Som #6 er inde på bliver det mere spændede at se hvordan de nye kort klarer minimums FPS, hvilket 3Dmark05 tallene jo langt fra viser. 3Dmark fans må så vente på den nye benchmark før de vil kunne se rigtig forskel på kortene (forudsat at 7900 og 1900 kan clockes ens).

#15

Jeg vi almindelige dødelige har først lige fået penge til "sidste generations forældede 3D kort", mens de nye allerede er kommet !....

Noget siger mig at tempoet er gået over gevind. Der kommer garanteret RX2000 og GF8000 når lige X1900 og GF7900 er sat på butiks hylderne.

Noget siger mig at tempoet er gået over gevind. Der kommer garanteret RX2000 og GF8000 når lige X1900 og GF7900 er sat på butiks hylderne.

#16

"Smid X1900 op på samme kerne hastighed som 7900, så vil de sikkert ligge lige i 3Dmark05."

tja det passer vel meget godt, man skal nok også lige have rammene med op. Men det ændrer ikke noget på at iflg de benchmarks så yder 7900 bedre, for faktum er at X1900 ikke kører samme hastighed.... ;)

tja det passer vel meget godt, man skal nok også lige have rammene med op. Men det ændrer ikke noget på at iflg de benchmarks så yder 7900 bedre, for faktum er at X1900 ikke kører samme hastighed.... ;)

#17

og endu et faktum er fandme at som 15# siger så går det AAAALLLTTTT for hurtigt nu om dage. nje dengang Gefrice 4 var et hit der kunne vi snakke :e

det går fandme alt for langsomt i sommers var et 6800GT vildt for mig nu,6 måneder senere så er det 7800GTX vildt...forhelvede...det er dobbelt så hurtigt på kun et halvt år...man har jo ikk en chance for at følge med!

det går fandme alt for langsomt i sommers var et 6800GT vildt for mig nu,6 måneder senere så er det 7800GTX vildt...forhelvede...det er dobbelt så hurtigt på kun et halvt år...man har jo ikk en chance for at følge med!

#18

Hmm.. det ser ud til at ATi er ~12-1500 points bagude (taget i betragtning af at der er brugt FX-60 i nVIdia-maskinen).

Men med de syge frekvenser nVidia har smækket på bordet kan det vel heller ikke være anderledes..

Hvad har nVidia i ærmet.. en 90nm´s produktionsteknologi måske ?

Men med de syge frekvenser nVidia har smækket på bordet kan det vel heller ikke være anderledes..

Hvad har nVidia i ærmet.. en 90nm´s produktionsteknologi måske ?

#19

#16 det jeg siger er at 3Dmark05 resultatet på disse kort i høj grad bestemmes af vertex ydelsen. Når 3Dmark05 er begrænset af vertex og spil som FEAR, COD2 m.fl. virker til at være begrænset af pixel, kan du ikke bruge ovenstående til ret meget andet end at sige nVidia vil vinde en benchmark. Men vi spiller ikke benchmarks vel?

#15 og 17 mon ikke det snart begynder at stilne af? G71 og R580 er jo efterhånden oppe omkring de 400 millioner transistorer, det kan jo generelt ikke være en god forretning at komme så højt op. Men måske er det os brugere der skal sige stop 😉 På den anden side skulle R600 og G80 komme til sommer, men da nVidia forventer at deres nye low end 7xxx skal have en levetid på 1 til 1½ år tror jeg nu ikke vi kommer til at opleve noget hastigheds boost. Måske vil de endda være langsommere til DX9 end nuværende high end kort pga. wraperen.

Men lad os nu lige se nogle spil der har brug for alle de kræfter, indtil nu er det jo faktisk kun FEAR der kunne bruge lidt mere power. Jeg ser personligt frem til Oblivion. Det er godt nok stadig "kun" et SM2.0 spil, men der skulle være brugt en del seje effekter + branching og looping for at få det til at køre med en rimelig hastighed.

#15 og 17 mon ikke det snart begynder at stilne af? G71 og R580 er jo efterhånden oppe omkring de 400 millioner transistorer, det kan jo generelt ikke være en god forretning at komme så højt op. Men måske er det os brugere der skal sige stop 😉 På den anden side skulle R600 og G80 komme til sommer, men da nVidia forventer at deres nye low end 7xxx skal have en levetid på 1 til 1½ år tror jeg nu ikke vi kommer til at opleve noget hastigheds boost. Måske vil de endda være langsommere til DX9 end nuværende high end kort pga. wraperen.

Men lad os nu lige se nogle spil der har brug for alle de kræfter, indtil nu er det jo faktisk kun FEAR der kunne bruge lidt mere power. Jeg ser personligt frem til Oblivion. Det er godt nok stadig "kun" et SM2.0 spil, men der skulle være brugt en del seje effekter + branching og looping for at få det til at køre med en rimelig hastighed.

#20

#18 jo de skulle være igang med at gå over til 90nm, alle de "små" modeller af Go serien er jo allerede overført. Det der så bliver spændende er om de kan holde de 700mhz, eller om det bliver endnu en 7800GTX 512mb PSE edition (Publicity Stunt Edition).

Faktum er stadig at der ikke er klare beviser på at deres overgang til 90nm er gået fejlfrit. Ved sidste conference call var hverken RSX eller G71 taped out så vidt jeg ved, og man har heller ikke hørt rygter om at de er blevet det siden. Men måske holder nVidia bare kortene meget tæt til kroppen.

Under alle omstændigheder er det jo fed timing at nVidia kommer med rygter om et kort der topper R580 i 3Dmark05 og frekvenser, lige 14 dage før sidstnævnte efter rygterne vil blive udgivet 😉

Faktum er stadig at der ikke er klare beviser på at deres overgang til 90nm er gået fejlfrit. Ved sidste conference call var hverken RSX eller G71 taped out så vidt jeg ved, og man har heller ikke hørt rygter om at de er blevet det siden. Men måske holder nVidia bare kortene meget tæt til kroppen.

Under alle omstændigheder er det jo fed timing at nVidia kommer med rygter om et kort der topper R580 i 3Dmark05 og frekvenser, lige 14 dage før sidstnævnte efter rygterne vil blive udgivet 😉

#21

Helt enig, man spiller ikke 3dmark.. ATI's x1800 tævede gf7800 i 3dmark05, men den var ikke lige så god til at trække fra i spil..

Kiwi, det du siger i #19, betyder jo så at nvidia vil have en fordel i spil som FEAR, COD2 m.fl eftersom den har flere pixelpipes. Det tyder dog endnu engang til at ATI's kort vil være bedre til at tegne AA/AF..

Kiwi, det du siger i #19, betyder jo så at nvidia vil have en fordel i spil som FEAR, COD2 m.fl eftersom den har flere pixelpipes. Det tyder dog endnu engang til at ATI's kort vil være bedre til at tegne AA/AF..

#22

#21 det er et kæmpe område at bevæge sig ud i, men generelt vil jeg personligt gætte på nogenlunde samme shader power, ihvertfald i teorien (ATI har 48 shader units som hver har "1.5" ALU, nVidia har 32 med hver 2 ALU (deres mini ALU's virker til at være begrænset til PS1.1/1.3 instruktioner)). Til det skal så lægges at ATI virker til at være mere effektiv med længere avancerede shadere (det der gør at X1800XT trækker fra 7800GTX i 3Dmark05) , sikkert pga. lavere latency grundet deres enklere pipeline. Til gengæld vil R580 sutte i spil som D3 og Q4 der har en TEX/ALU ratio på 1:1, pga. de kun har 16 TMU'er til de 48 shader cores, hvis andre spil har perioder med samme ratio vil det måske have negativ influrering på minimums FPS.

Som man nok kan ane er jeg mest tilhænger af ATI's arkitektur, mest fordi der virker til at være gjort mere ud af effektiviteten når det gælder længere shadere og tilhørende optimeringer. Men der er f.eks. benchmarks af FEAR som skulle stamme fra R580, de viser ikke den store hastigheds forbedring. Da FEAR skulle have et tex/ALU forhold på 1:7 i de fleste tilfælde, og dermed være et af de mest pixel shader intensive spil pt., kunne det skyldes de 16 ROP's, men så vil nVidia højst sandsynligt heller ikke vise den store forbedring. Derfor bliver det spændende at få kortene ud, indtil da er alt kun meningsløst gætteri. Ovenstående 3Dmark05 tal giver ikke ligefrem nogen pointer, netop pga. de virker til at være vertex begrænsede.

En ting er sikkert: Det bliver ikke nemmere at vælge kort. Tag f.eks. benchmarks af SC: CT, det er nok det spil der pt. er mest SM3.0 kode i: http://www.xbitlabs.com/articl... det virker jo lidt sjovt at et sølle X1800XL kan have samme minimums FPS som 7800GTX 512mb. Et spil som Oblivion kunne vise om det er et enkelt stående tilfælde eller en reel tendens.

Som man nok kan ane er jeg mest tilhænger af ATI's arkitektur, mest fordi der virker til at være gjort mere ud af effektiviteten når det gælder længere shadere og tilhørende optimeringer. Men der er f.eks. benchmarks af FEAR som skulle stamme fra R580, de viser ikke den store hastigheds forbedring. Da FEAR skulle have et tex/ALU forhold på 1:7 i de fleste tilfælde, og dermed være et af de mest pixel shader intensive spil pt., kunne det skyldes de 16 ROP's, men så vil nVidia højst sandsynligt heller ikke vise den store forbedring. Derfor bliver det spændende at få kortene ud, indtil da er alt kun meningsløst gætteri. Ovenstående 3Dmark05 tal giver ikke ligefrem nogen pointer, netop pga. de virker til at være vertex begrænsede.

En ting er sikkert: Det bliver ikke nemmere at vælge kort. Tag f.eks. benchmarks af SC: CT, det er nok det spil der pt. er mest SM3.0 kode i: http://www.xbitlabs.com/articl... det virker jo lidt sjovt at et sølle X1800XL kan have samme minimums FPS som 7800GTX 512mb. Et spil som Oblivion kunne vise om det er et enkelt stående tilfælde eller en reel tendens.

#23

#22, som du så nok har luret så er driverheaven.net et ati biased sted. Alligevel har de fremtryllet en test som ser sådan ud:

http://www.driverheaven.net/ar...

7800gtx @ 16 pipes

X1800XT @ 7800 speeds.

Så er der lidt at tygge på mht "effektiviteten når det gælder længere shadere og tilhørende optimeringer" ;)

http://www.driverheaven.net/ar...

7800gtx @ 16 pipes

X1800XT @ 7800 speeds.

Så er der lidt at tygge på mht "effektiviteten når det gælder længere shadere og tilhørende optimeringer" ;)

#24

#23 Synes ikke rigtig man jan sammenligne dem på den måde! Man kan se den mest effektive core!

Men ATI's chip er bygget til at køre ved flere mhz end nvidias, derfor er det unfair i ydelsesmæssig øjemed at sammenligne dem på dn måde!

/Lars

Men ATI's chip er bygget til at køre ved flere mhz end nvidias, derfor er det unfair i ydelsesmæssig øjemed at sammenligne dem på dn måde!

/Lars

#25

jeps præcis.. men G70 er jo også bygget med 24 pipes... og da vi sammenligner arkitektur og ikke "faktuel ydelse" så er det vel en fair måde at gøre det på.

#26

#23 som du selv er inde på er DH nok næppe "kilden" når man leder efter analyser af arkitekturer, men ok.

Først og fremmest, som allerede nævnt, er nVidia's pipelines "tykkere" end ATI's. Hvor ATI har 1.5 ALU pr. pipe har nVidia 2 ALU, altså minimum 25% mere ALU power. Hvis programmet / spillet bruger mange korte shadere, det er optimeret kraftigt i driverne, eller det bruger den samme shader konstant, så vil nVidia's pipeline altid "vinde". Det er logik for burhøns.

Som nævnt i en tidligere post har D3 ikke ret mange shadere, alle effekter kunne nemt laves med meget korte shadere i PS1.3. Du kan jo også se at FX serien klarer sig fint i D3, det er IKKE fordi Carmack har svunget en tryllestav, men fordi der simpelthen ikke er ret mange shadere.

CS: VST har masser af shadere, men så vidt jeg ved er de ikke særlig lange, og der er ikke brugt optimeringer i stil med branching og looping (heller ikke brug for det med korte shadere). Her kommer driver optimeringer også ind i billedet, I husker vel nok hvor meget der blev vundet på nye drivere.

"Game tests" i 3Dmark05 er fyldt med lange SM2.0 shadere, hvilket gør disse lidt mere interessante når man skal vudere effektiviteten af arkitekturen. Her har både ATI og nVidia optimeret bagdelen ud af bukserne, og da sidstnævne har minimum 25% mere ALU power pr. pipe er der noget mere at arbejde med der. Alligevel ligger de to arkitekturer meget tættere end de gjorde i spil tests, hvilket jo skulle bevise at jo mere avancerede shaderne bliver jo mere vinder ATI's "tynde" pipeline ind på nVidia's "tykke". 3Dmark05 bruger heller ikke hverken branching, flow control eller looping.

Hvordan mon billedet vil se ud i et spil med SM3.0 længde på shaderne og branching / looping? Det er det der bliver spændende... Første forsmag vil nok blive Oblivion, så lad os snuppe denne diskussion igen når det er kommet ud.

Først og fremmest, som allerede nævnt, er nVidia's pipelines "tykkere" end ATI's. Hvor ATI har 1.5 ALU pr. pipe har nVidia 2 ALU, altså minimum 25% mere ALU power. Hvis programmet / spillet bruger mange korte shadere, det er optimeret kraftigt i driverne, eller det bruger den samme shader konstant, så vil nVidia's pipeline altid "vinde". Det er logik for burhøns.

Som nævnt i en tidligere post har D3 ikke ret mange shadere, alle effekter kunne nemt laves med meget korte shadere i PS1.3. Du kan jo også se at FX serien klarer sig fint i D3, det er IKKE fordi Carmack har svunget en tryllestav, men fordi der simpelthen ikke er ret mange shadere.

CS: VST har masser af shadere, men så vidt jeg ved er de ikke særlig lange, og der er ikke brugt optimeringer i stil med branching og looping (heller ikke brug for det med korte shadere). Her kommer driver optimeringer også ind i billedet, I husker vel nok hvor meget der blev vundet på nye drivere.

"Game tests" i 3Dmark05 er fyldt med lange SM2.0 shadere, hvilket gør disse lidt mere interessante når man skal vudere effektiviteten af arkitekturen. Her har både ATI og nVidia optimeret bagdelen ud af bukserne, og da sidstnævne har minimum 25% mere ALU power pr. pipe er der noget mere at arbejde med der. Alligevel ligger de to arkitekturer meget tættere end de gjorde i spil tests, hvilket jo skulle bevise at jo mere avancerede shaderne bliver jo mere vinder ATI's "tynde" pipeline ind på nVidia's "tykke". 3Dmark05 bruger heller ikke hverken branching, flow control eller looping.

Hvordan mon billedet vil se ud i et spil med SM3.0 længde på shaderne og branching / looping? Det er det der bliver spændende... Første forsmag vil nok blive Oblivion, så lad os snuppe denne diskussion igen når det er kommet ud.

#27

Andre end mig der undrer sig over HVOR Hexus har de tal fra? De skriver selv at kun nogle få udviklere har Nvidia kortet, og de er under NDA..

#28

The validity of this idle gossip was later confirmed after I pumped a humble partner for a little a bit of meat to go with my beans - the money-shot is that a 700MHz NVIDIA GeForce 7900 is currently coming in at circa 13,000 3DM2K5's on an AMD Athlon 64 FX 60 system.

Author: Fanny Deeplung

Så hvis man stoler på personen fra hexus....

Author: Fanny Deeplung

Så hvis man stoler på personen fra hexus....

#29

#28

Så vi sidder her og kigge på nogle ca. tal fra en unavngiven kilde.. fra en samtale der ikke bliver refereret fra.. og med The money-shot menes vel at man pt. regner med..

Så vi sidder her og kigge på nogle ca. tal fra en unavngiven kilde.. fra en samtale der ikke bliver refereret fra.. og med The money-shot menes vel at man pt. regner med..

#30

Jeg tror nu at 13000 ved 700mhz er et meget sandsynligt tal, og det er højst sandsynligt leaked med nVidia's "velsignelse". Det er jo i deres interesse at lede folks opmærksomhed væk fra R580 😉

Spørgsmålet er så om de kan opnå gode yeilds ved 700mhz, og hvornår den kommer.

Btw. den nye 3Dmark virker til at være ret så heftig, bliver spændende at se den 🙂

Spørgsmålet er så om de kan opnå gode yeilds ved 700mhz, og hvornår den kommer.

Btw. den nye 3Dmark virker til at være ret så heftig, bliver spændende at se den 🙂

#31

#30

Ja hvis Nvidia gik ud og hviskede et tal der var under hvad konkurrenten lover, så var de jo dummere end gennemsnittet!

Men kendsgerningerne er at X1900 kan bestilles nu, og forventes fremme om ca. 30 dage. Nvidia har lavet enkelte test samples.. og resten er mere eller mindre sansynlige regnestykker..

Når de så endda har så udokumenterede rygter at de ikke engang kan sætte på hvor de hører det.. tjaee..

JEG forventer at X2100 Bliver med 256 pipes, 2 gb ram og en 4 gb hd onboard.. den yder ca. 9721 i 3dmark 07.. :e et lige så konkret bud som resten 😉

Ja hvis Nvidia gik ud og hviskede et tal der var under hvad konkurrenten lover, så var de jo dummere end gennemsnittet!

Men kendsgerningerne er at X1900 kan bestilles nu, og forventes fremme om ca. 30 dage. Nvidia har lavet enkelte test samples.. og resten er mere eller mindre sansynlige regnestykker..

Når de så endda har så udokumenterede rygter at de ikke engang kan sætte på hvor de hører det.. tjaee..

JEG forventer at X2100 Bliver med 256 pipes, 2 gb ram og en 4 gb hd onboard.. den yder ca. 9721 i 3dmark 07.. :e et lige så konkret bud som resten 😉

#32

#29, nej.... et hexus-crew sætter sitets og sin egen trodværdighed over styr. læs dog..

#33

Nogen der sagde noget om mere gfx-power til COD2?

seriøst, mit 9600 pro klarer det squ fint :e

Ingen SLI eller crossfire (hva det nu hedder) til mig tak.

seriøst, mit 9600 pro klarer det squ fint :e

Ingen SLI eller crossfire (hva det nu hedder) til mig tak.

![Morten-[TB]-](/content/gfx/profile.png)