Test: AMD Radeon HD5970 2GB

Grafikkort, AMD/ATI d. 03. december. 2009, skrevet af WinterSilence 44 Kommentarer. Vist: 15550 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: AMD

DK distributør: AMD

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: AMD

DK distributør: AMD

fin test og et lækkert kort..

dog undrer det mig at der ikke er blevet brugt win7 i andet end med heaven test

battleforge og dirt 2 demo som evt test?

dog ikke et kort jeg ville gå ud og bruge penge på pt, ikke før det falder en god 1000 kr i pris.

og syntes det er latterligt at i usa koster det 3k ca og det koster 1000 kr mere herhjemme, det er helt fucked efter min mening.

udover det så virker det ikke nær så voldsomt som det er blevet hyped til? eller er det bare mig?

og det "volsomme" oc giver jo heller ikke det vilde mer ydelser?

dog undrer det mig at der ikke er blevet brugt win7 i andet end med heaven test

battleforge og dirt 2 demo som evt test?

dog ikke et kort jeg ville gå ud og bruge penge på pt, ikke før det falder en god 1000 kr i pris.

og syntes det er latterligt at i usa koster det 3k ca og det koster 1000 kr mere herhjemme, det er helt fucked efter min mening.

udover det så virker det ikke nær så voldsomt som det er blevet hyped til? eller er det bare mig?

og det "volsomme" oc giver jo heller ikke det vilde mer ydelser?

#2

#1 For at mærk om oc giver noget, skal der alstå cpu krafter til.

#2 det kom jeg også i tanke om efter jeg havde skrevet det.

du mener noget vildt ala en godt oc'et i7?

du mener noget vildt ala en godt oc'et i7?

#4

Eller bare smaske en høj nok opløsning på 2560x1200 og fyre op for 16xFSAA/16xAF - mindre ville være spild med sådan et kort - eller for den sags skyld bare med 2x HD5850.

Glæder mig til at få mit op og køre med Ci5 750 2.66GHz'ern.

Overclocking er en sport ikke en nødvendighed 🙂

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 03-12-2009 08:45:21.

Glæder mig til at få mit op og køre med Ci5 750 2.66GHz'ern.

Overclocking er en sport ikke en nødvendighed 🙂

Svaret blev redigeret 1 gang, sidst af Gripen90 d. 03-12-2009 08:45:21.

#5

Hej,

Lækker test og pisse snyd det er dig der får lov at teste disse kort.

Kan du ikke skrive Grafik scoren til 3Dmark Vantage i stedet for den samlede score. Det er svært at se hvad det kan det kort når man med et i7 system får omkring 5000 mere med et enkelt HD5870. Så tror jeg der et lettere at sammenligne for alle uafhængig af CPU konfiguration.

Lækker test og pisse snyd det er dig der får lov at teste disse kort.

Kan du ikke skrive Grafik scoren til 3Dmark Vantage i stedet for den samlede score. Det er svært at se hvad det kan det kort når man med et i7 system får omkring 5000 mere med et enkelt HD5870. Så tror jeg der et lettere at sammenligne for alle uafhængig af CPU konfiguration.

#6

Når man har læst denne test, kan jeg ikke lade være med at tænke, at du selv hælder mest til ATI kort! Ikke dermed sagt at du er fanboy, men du er liiiiidt for ATI partisk i mine øjne. Selv, ja der er jeg nok Nvidia tilhænger, men jeg synes bare ikke at du giver nok credit til Nvidia kortene. Desuden er hovedparten af dit sammenligningsgrundlag jo ATI kort! Havde i ikke andre Nvidia kort at holde op imod. Og så er dit GTX295 ikke et Single PCB?? det er vel næsten det der skal sammenlignes med, er det ikke?

Og til sidst, hvorfor er der ikke testet i de mega aktuelle spil som COD MW2 og Left4Dead 2 ?

Ellers god test, men med lidt ris 🙂

Og til sidst, hvorfor er der ikke testet i de mega aktuelle spil som COD MW2 og Left4Dead 2 ?

Ellers god test, men med lidt ris 🙂

#7

Øhm altså. HD5700/5800 serien understøtter OpenGL 3.2

Vi venter bare på driveren til 3.2 kommer.

http://www.amd.com/us/products...

Svaret blev redigeret 2 gange, sidst af Reverb d. 03-12-2009 10:33:29.

Vi venter bare på driveren til 3.2 kommer.

http://www.amd.com/us/products...

Svaret blev redigeret 2 gange, sidst af Reverb d. 03-12-2009 10:33:29.

#8

#6 ATI har leveret de bedste produkter i meget lang tid nu(især pga. prisen), faktisk siden de kom med 4850/4870, den eneste forskel er at de nu også er hurtigst. Hvis jeg skulle have et nyt kort i morgen, så ville jeg enten gå efter et 5850 eller et 5870.

#4 og mellem linjerne skriver deu vel også at et 5970 kun giver mening hvis man har en skærm der kan tage de opløsninger og en computer som på de andre punkter er tæt på topklasse.

#4 og mellem linjerne skriver deu vel også at et 5970 kun giver mening hvis man har en skærm der kan tage de opløsninger og en computer som på de andre punkter er tæt på topklasse.

#9

#6

Kan kun være enig med dig, synes også der mangler lidt nyere spil til tests. 3 af spillene er fra forrige århundrede - sådan ca. Nu er du jo inkarneret Nvidia fanboy 😛 , men er nu også enig i at der godt kunne bruges lidt flere kort til sammenligning fra nvidia 🙂

Kan kun være enig med dig, synes også der mangler lidt nyere spil til tests. 3 af spillene er fra forrige århundrede - sådan ca. Nu er du jo inkarneret Nvidia fanboy 😛 , men er nu også enig i at der godt kunne bruges lidt flere kort til sammenligning fra nvidia 🙂

#11

#7 OpenGL er programmerbart via driveren og ikke via hardwaren "fused in silicon", som DirectX er det. Derfor skriver jeg som det er, at kortet ikke støtter dette - endnu. Win Vista er brugt, da mine referenceresulater er derfra - de blev lavet før Win 7 udkom. De nævnte spil har jeg desværre ikke haft til rådighed - når de kommer som selvstændige benchmarks så overvejer vi selvfølgelig, at benytte dem. Da jeg bruger hele to DirectX tests, så synes jeg udemærket belyser kortets evner inden for DX11, med disse to tests, der er vidt forskellige. Og slutteligt så var der et par ting der ikke ville køre, eller ikke kørte optimalt på Win 7 af de test der bruges.

Grafikscoren jeg ikke nævnte kommer hér, da den er lidt irrelevant for dette testsetup. Det forholder sig således hér:

3DM Vantage Extreme:

X11303 GPU: 11367 CPU: 10217 - altså 64 points mere, end selve hovedscoren.

Svaret blev redigeret 1 gang, sidst af WinterSilence d. 03-12-2009 15:57:44.

Grafikscoren jeg ikke nævnte kommer hér, da den er lidt irrelevant for dette testsetup. Det forholder sig således hér:

3DM Vantage Extreme:

X11303 GPU: 11367 CPU: 10217 - altså 64 points mere, end selve hovedscoren.

Svaret blev redigeret 1 gang, sidst af WinterSilence d. 03-12-2009 15:57:44.

#12

tak for et fint review Winter 🙂

dog er der noget der skærer lidt i hjernen når jeg læser; du skriver :

på siden software:

Og ATI OverVolt ER STÆRKT nødvendigt - for benytter man det IKKE, så crasher driver, kort og evt. hele maskinen med et enormt brag, hvis man overclocker kortet 100 MHz over normalen - og det med et kæmpe brag

på siden test & overclocking skriver du så :

Kortet overclocker UDEN problemer og det i helt ekstrem grad endda!

der kunne jeg godt have tænkt mig en henvisning til, at den ekstreme OC-grad kun kunne opnås ved hjælp af en spændingsforøgelse.

ellers et fint stykke arbejde 😉

dog er der noget der skærer lidt i hjernen når jeg læser; du skriver :

på siden software:

Og ATI OverVolt ER STÆRKT nødvendigt - for benytter man det IKKE, så crasher driver, kort og evt. hele maskinen med et enormt brag, hvis man overclocker kortet 100 MHz over normalen - og det med et kæmpe brag

på siden test & overclocking skriver du så :

Kortet overclocker UDEN problemer og det i helt ekstrem grad endda!

der kunne jeg godt have tænkt mig en henvisning til, at den ekstreme OC-grad kun kunne opnås ved hjælp af en spændingsforøgelse.

ellers et fint stykke arbejde 😉

#13

#12:

Forglemmelse i OC-sektionen. Tak for det - har indsat følgende:

"Man skal dog overvolte kortet med AMD/ATI's ATI OverVolt tool, da kortet ellers slet ikke får strøm nok og så vil crashe enten driveren, eller hele maskinen med et megabrag ved højere frekvenser, end 820 på GPU og 1200 på RAM. Jeg vil derfor voldsomt meget gøre opmærksom på, at dette kort er specialdesignet med henblik på overvoltning og toolet er da også lavet af AMD/ATi's ingeniører til denne opgave. Af samme grund har kortet helt nydesignede strømkredsløb og overspændingsbeskyttelse via hardwaremonitorering af spændinger, frekvenser og strømforbrug, via kredsløb fra Texas Instruments og håndplukkede komponenter over hele kortets PCB."

Forglemmelse i OC-sektionen. Tak for det - har indsat følgende:

"Man skal dog overvolte kortet med AMD/ATI's ATI OverVolt tool, da kortet ellers slet ikke får strøm nok og så vil crashe enten driveren, eller hele maskinen med et megabrag ved højere frekvenser, end 820 på GPU og 1200 på RAM. Jeg vil derfor voldsomt meget gøre opmærksom på, at dette kort er specialdesignet med henblik på overvoltning og toolet er da også lavet af AMD/ATi's ingeniører til denne opgave. Af samme grund har kortet helt nydesignede strømkredsløb og overspændingsbeskyttelse via hardwaremonitorering af spændinger, frekvenser og strømforbrug, via kredsløb fra Texas Instruments og håndplukkede komponenter over hele kortets PCB."

#14

#0

Flot test, men jeg synes i skal begynde at lave flere benchmarks med de lidt mere krævende spil som f. eks. Crysis Warhead, MW2 mm. 🙂

Det giver ikke så meget mening at lave en WoW benchmark, da man ikke kan se kortets potentielle ydeevne. 🙂

Flot test, men jeg synes i skal begynde at lave flere benchmarks med de lidt mere krævende spil som f. eks. Crysis Warhead, MW2 mm. 🙂

Det giver ikke så meget mening at lave en WoW benchmark, da man ikke kan se kortets potentielle ydeevne. 🙂

#15

Synes godt du kunne have haft et 4870x2 med i testen, så man kunne se sidste generations topkort mod det nye. Slet ikke fordi jeg selv har et 😳

#16

Jeg har desværre ikke HD4870x2 i referencepoolen over kort til rådighed - beklager. Mht. spil der koster det ret meget og alle testere skal så have en kopi hver. Derfor foretrækker vi spil der her en fri benhcmarker til rådighed. Jeg kan pt. kun få Crysis Warhead i Crysis Maximum-pakken til 299,-/200,- DKK og det er jeg ikke parat til, at betlae for at teste grafikkort for "Jeres skyld", hvis I forstår hacvd jeg mener? 🙂 Firmaet bag Crysis skulle have forsat med, at lave de næste to versioner som selvstændigt benchmarktool nu de satte standarden for dette tidl. Grunden til jeg ikke bruger den gamle Crysis-benhcmarker er,a t den ofte går ned på Win Vista x64 SP2 - og det er herrebelastende som tester, at se en test gå ned i run 14 og crashe, da det tager mig ca. mellem 12-20 timer per kort kun, at benchmarke dem. OC-testen tager ca. 3-5 timer med fintuning og artikelen derpå mellem 3.5-8 timer, at skrive. derfor foretrækker jeg at bruge automatiske benchmarkers. Og jeg bander STALKER langt ind i helvede for, at den skal manuelt startes hver eneste gang, fremfor at kunne en batchliste, som den gamle Crysis kan det... Grunden til jeg har WoW med er, at jeg selv spiller det og er den eneste i DK der tester grafikkort med WoW og da det er verdens mest spillede spil, udover SIMS og CS så synes jeg det fotjener, at komme med - i øvrigt tager denne test kun meget kort tid at udføre (10 min maks).

Og rent faktisk så har jeg data liggende fra en CrossFire-test af HD4890 1GB, men problemet med, at bruge den er at den blev lavet langt før de nye benchmarks kom ud, som sætter standarden pt.

Svaret blev redigeret 2 gange, sidst af WinterSilence d. 03-12-2009 17:43:05.

Og rent faktisk så har jeg data liggende fra en CrossFire-test af HD4890 1GB, men problemet med, at bruge den er at den blev lavet langt før de nye benchmarks kom ud, som sætter standarden pt.

Svaret blev redigeret 2 gange, sidst af WinterSilence d. 03-12-2009 17:43:05.

#17

Uhhh. Jeg er kommet til at bestille et HD5970. Ikke fordi jeg skal overclocke det, for det har jeg ikke forstand på. Jeg ville sikkert brænde det af i forsøget, og så tror jeg ikke garantien dækker. Nej grunden er, at jeg alligevel skal have helt nu computer..... og så vil jeg gerne lave et TOTALT overkill denne her gang 🙂

Jeg er ret imponeret over dit arbejde Winter. Men jeg er jo heller ikke en "nørd"(I positiv mening), så jeg stiller ikke så mange krav. 😳

Jeg er ret imponeret over dit arbejde Winter. Men jeg er jo heller ikke en "nørd"(I positiv mening), så jeg stiller ikke så mange krav. 😳

#18

allerførst vil jeg sige at testen af grafikkortene er der ikke noget galt med.

Jeg vil som #6 også sige at jeg sad med samme følelse at at du bare "reklamerer for rød stue" det er den måde teksten er skrevet på samt at de spil du bruger til testen jo favoriserer ATI kort ,det kan man jo nemt læse ud af graferne.

ud fra andre test på nettet er der forskel på GTX 295 og 5970 men ikke så stor forskel som du vil gøre det til i denne test.

Jeg vil som #6 også sige at jeg sad med samme følelse at at du bare "reklamerer for rød stue" det er den måde teksten er skrevet på samt at de spil du bruger til testen jo favoriserer ATI kort ,det kan man jo nemt læse ud af graferne.

ud fra andre test på nettet er der forskel på GTX 295 og 5970 men ikke så stor forskel som du vil gøre det til i denne test.

#19

#18

Interessant. Jeg er hverken ATI eller Nvidia fan. Jeg vælger det, som jeg selv mener er bedst, når jeg skal købe ny computer. Umiddelbart syntes jeg faktisk at i Nvidia "fans" spiller pigefornærmet. Det klæder jer ikke.

Jeg undrer mig over disse Nvidia fans udbrud. Især når jeg har kigget rundt på nettet, da GTX 295 blev udgivet. Der blev ATI fans hånet for at forsvare, at ATI var et bedre køb til pengene. Nu bliver en artikel mistænkeligt gjort fordi den "favoritiserer ATI kort". Er Nvidias "fans" nogle hyklere? Lidt ligesom MAC folket? Man anerkender ikke konkurrenten. Selv nogen af de Nvidia folk, der har testet kortene siger, at ATI er pænt foran for øjeblikket. For 1 år siden var det omvendt. Det kan det også være igen om bare 3-4 mdr. Skal vi så hører ATI folket klage også? Det her er sgu da ikke en strikkeklub med kvinde "øffen".... er det?

Nu har jeg begge hold i vennekredsen, og der er der ingen klager fra nogen af siderne. Hvorfor ikke bare glæde sig over et af firmaerne har skubbet til udviklingen igen?

Svaret blev redigeret 1 gang, sidst af rebslager d. 03-12-2009 21:14:01.

Interessant. Jeg er hverken ATI eller Nvidia fan. Jeg vælger det, som jeg selv mener er bedst, når jeg skal købe ny computer. Umiddelbart syntes jeg faktisk at i Nvidia "fans" spiller pigefornærmet. Det klæder jer ikke.

Jeg undrer mig over disse Nvidia fans udbrud. Især når jeg har kigget rundt på nettet, da GTX 295 blev udgivet. Der blev ATI fans hånet for at forsvare, at ATI var et bedre køb til pengene. Nu bliver en artikel mistænkeligt gjort fordi den "favoritiserer ATI kort". Er Nvidias "fans" nogle hyklere? Lidt ligesom MAC folket? Man anerkender ikke konkurrenten. Selv nogen af de Nvidia folk, der har testet kortene siger, at ATI er pænt foran for øjeblikket. For 1 år siden var det omvendt. Det kan det også være igen om bare 3-4 mdr. Skal vi så hører ATI folket klage også? Det her er sgu da ikke en strikkeklub med kvinde "øffen".... er det?

Nu har jeg begge hold i vennekredsen, og der er der ingen klager fra nogen af siderne. Hvorfor ikke bare glæde sig over et af firmaerne har skubbet til udviklingen igen?

Svaret blev redigeret 1 gang, sidst af rebslager d. 03-12-2009 21:14:01.

#20

#19

uha nej jeg er ikke pigesur på nogen måde,syntes bare at når man laver en test skulle man gerne holde sig upartisk ,og jeg syntes denne test er gennemsyret med hvad parti testeren er på.

rigtigt jeg har nvidia kort og har haft rigtig mange af dem efterhånden,men jeg har altså også haft ATI kort.

men det er bare min mening ,folk er i sin gode ret til at være uenige med mig 🙂

uha nej jeg er ikke pigesur på nogen måde,syntes bare at når man laver en test skulle man gerne holde sig upartisk ,og jeg syntes denne test er gennemsyret med hvad parti testeren er på.

rigtigt jeg har nvidia kort og har haft rigtig mange af dem efterhånden,men jeg har altså også haft ATI kort.

men det er bare min mening ,folk er i sin gode ret til at være uenige med mig 🙂

#21

->#20

Aha.

...for 3Dmark Vantage med PhysX, er ikke "favoriseret" af nVidia grafikkort.?

...for Devil May Cry 4, er ikke the-way-its-meant-to-be-played, altså nVidia-sponsoreret?

Det er en højest besynderlig konklusion, du drager, på baggrund af hvad? Det kunne være, at vi kunne blive klogere. Så fortæl fortæl, hvis du har noget at dele. :yes:

Faktum er, at der testes med de nyeste teknologier.

Hvis du mener, at DirectX 10,1 og DirectX 11, som er Microsoft-udviklede API'er uden direkte tilknytning til hverken nVidia/ATi, er en AMD/ATi-favorisering, er jeg stærkt uenig.

Hvad skulle vi teste i - Directx9, så alverdens grafikkortproducenter kan være med? 😲

Kigger man nøgternt på det, er testen faktisk nVidia-favoriseret, da PhysX er slået til i 3dmark Vantage; en teknologi der er nVidias egen, og som AMD/ATi derfor ikke har mulighed for, at benytte sig af. At nVidia pt. er hulens langsomme med API-understøttelse, er jo bare ærgeligt for dem.

Summa summarum er altså, at vi tester med de tilgængelige teknologier og features på kortene, med de benchmarks der nu engang benytter disse teknologier. 🙂

I øvrigt - konkrete forslag til benchmarks, er MEGET velkomne.

Svaret blev redigeret 1 gang, sidst af Emillos d. 03-12-2009 22:32:27.

Aha.

...for 3Dmark Vantage med PhysX, er ikke "favoriseret" af nVidia grafikkort.?

...for Devil May Cry 4, er ikke the-way-its-meant-to-be-played, altså nVidia-sponsoreret?

Det er en højest besynderlig konklusion, du drager, på baggrund af hvad? Det kunne være, at vi kunne blive klogere. Så fortæl fortæl, hvis du har noget at dele. :yes:

Faktum er, at der testes med de nyeste teknologier.

Hvis du mener, at DirectX 10,1 og DirectX 11, som er Microsoft-udviklede API'er uden direkte tilknytning til hverken nVidia/ATi, er en AMD/ATi-favorisering, er jeg stærkt uenig.

Hvad skulle vi teste i - Directx9, så alverdens grafikkortproducenter kan være med? 😲

Kigger man nøgternt på det, er testen faktisk nVidia-favoriseret, da PhysX er slået til i 3dmark Vantage; en teknologi der er nVidias egen, og som AMD/ATi derfor ikke har mulighed for, at benytte sig af. At nVidia pt. er hulens langsomme med API-understøttelse, er jo bare ærgeligt for dem.

Summa summarum er altså, at vi tester med de tilgængelige teknologier og features på kortene, med de benchmarks der nu engang benytter disse teknologier. 🙂

I øvrigt - konkrete forslag til benchmarks, er MEGET velkomne.

Svaret blev redigeret 1 gang, sidst af Emillos d. 03-12-2009 22:32:27.

#22

#21

...for 3Dmark Vantage med PhysX, er ikke "favoriseret" af nVidia grafikkort.?

Hvorfor tester i så med phys-X når i sammenligner med ATI kort,det kan slås fra 😉

for Devil May Cry 4, er ikke the-way-its-meant-to-be-played, altså nVidia-sponsoreret

ja det er colinmcrae rally 05 også og det spil ydede bedst med ATI kort så den konklusion kan jeg ikke bruge til noget

og jeg kan ikke se min konklusion skulle være mere besynderlig end din,jeg mener testeren ikke er upartisk sådan som jeg læser testen og det har jeg ret til at mene.

...for 3Dmark Vantage med PhysX, er ikke "favoriseret" af nVidia grafikkort.?

Hvorfor tester i så med phys-X når i sammenligner med ATI kort,det kan slås fra 😉

for Devil May Cry 4, er ikke the-way-its-meant-to-be-played, altså nVidia-sponsoreret

ja det er colinmcrae rally 05 også og det spil ydede bedst med ATI kort så den konklusion kan jeg ikke bruge til noget

og jeg kan ikke se min konklusion skulle være mere besynderlig end din,jeg mener testeren ikke er upartisk sådan som jeg læser testen og det har jeg ret til at mene.

#23

er det ikke ligefør at vi ændre vores opfattelse af en PC så et gfx kort ikke er et addon men hovedkomponenten for fuck det er stort, så kunne vi lave et pci-1 slot til en cpu og de andre nødvendige ting som en SSD og lidt ram, det ville samtidog gøre det muligt at få lavet en bedre køler som ikke larmer så meget. :yes:, og der er jo aldirg nogle der ved lov har bestemt at det er Cpu'en der er hovedkomponenten, det burde da være den chip med mest power der bestemte.

#24

#21 Konkrete test af kortene må da være med de mest aktuelle og nyeste spil ! Og de mest krævende til disse store kort. Det siger næsten sig selv jo...

Og just for the record, så er jeg heller ikke pigesur på nogen måde. Ja, jeg holder mest af Nvidia kortene, men holder det som regel også for mig selv (Du skal ikke sige noget nu Tom81 😀 )

Men at jeg føler at testen er lidt partisk, har INTET med at gøre, at jeg ikke kan anerkende at ATI kort er hurtigere og bedre prisat. Det kunne jo være, at jeg ønskede en bredere test, med nyere spil og ligeligt fordelte kort.

Og grunden til at jeg hæftede mig ved det var, at der var flest ATI kort, og så at testeren også selv kører med ATI kort.

Tilfældigt, måske! Fakta, bestemt !

Og så lige til sidst....Det var IKKE for at fremhæve Nvidia fremfor ATI... Blot et juleønske om en mere lige test.

Nok om det, sov godt... og igen, god test, men med ris 🙂

Svaret blev redigeret 1 gang, sidst af OdysseDK d. 03-12-2009 22:55:45.

Og just for the record, så er jeg heller ikke pigesur på nogen måde. Ja, jeg holder mest af Nvidia kortene, men holder det som regel også for mig selv (Du skal ikke sige noget nu Tom81 😀 )

Men at jeg føler at testen er lidt partisk, har INTET med at gøre, at jeg ikke kan anerkende at ATI kort er hurtigere og bedre prisat. Det kunne jo være, at jeg ønskede en bredere test, med nyere spil og ligeligt fordelte kort.

Og grunden til at jeg hæftede mig ved det var, at der var flest ATI kort, og så at testeren også selv kører med ATI kort.

Tilfældigt, måske! Fakta, bestemt !

Og så lige til sidst....Det var IKKE for at fremhæve Nvidia fremfor ATI... Blot et juleønske om en mere lige test.

Nok om det, sov godt... og igen, god test, men med ris 🙂

Svaret blev redigeret 1 gang, sidst af OdysseDK d. 03-12-2009 22:55:45.

#25

Nu er det sådan at "testeren" der er "testeren" hér altid har brugt NVIDIA, bortset fra da han var spildemonstrator for spil på Linux under SSLUG og LinuxIn.dk og fik sponseret et ATI 9800 Pro fra Sapphire. Der viste ATI overlegenhed, med lidt mere stabile drivere, end NVIDIA. Senere har NVIDIA "rulet" AMD/ATi på Linux, efter jeg stoppede med dette i 2003.

Det jeg gengiver i mine artikler er den "rene sandhed", set udfra en teknisk uddannet grafikkorttesters synspunkt. Og det er derfor jeg som Emillos (min supervisor og chef) siger det, tester AMD/ATI med PPU/PhysX=On. For NVIDIA er foran med denne teknologi, hvor AMD/ATi støtter deres egen OpenCL.

Jeg tester et kort i alle de forbandede mange tests jeg kan finde og jeg udvælger ALENE som den der er testeren hér, min testsuite, i samarbejde med min supervisor Emillos.

Med denne testsuite der kører jeg alle de kort jeg tester gennem helvede og tortur på både OC og med benchmarks.

Faktum for mine tests resultater er følgende:

AMD/ATI HD5970 ruler/owner/overgår ALLE andre producenter pt. i OpenGL, DirectX 10 - og mest nødvendigt - DirectX 11.

For skal vi se fremad så må vi se på fakta. Og fakta er, at AMD/ATI pt. er ude med teknologi der langt overgår NVIDIA's.

Hvis ellers "I" gad, at se tilbage på mine tidligere tests/reviews/anmeldelser af NVIDIA-kort så ville I se,a t jeg netop har anført, bl.a. følgende citeret fra mine tests:

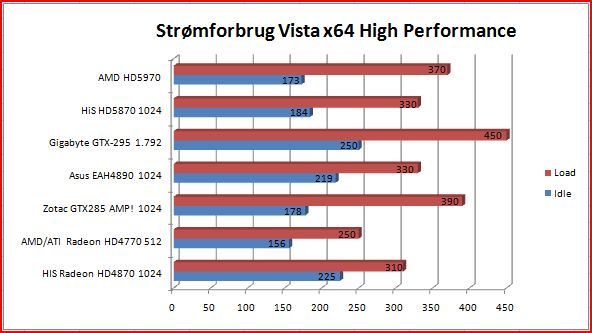

Palit GTX-275:

Kortets strømforbrug idle i Windows er særdeles acceptabelt. I 2-D-brug er forbruget ikke meget større end på eksempelvis det lille AMD/ATI Radeon HD 4770. Med 3 applikationer åbne og et Explorer-vindue sluger testsystemet omkring 173-200 watt totalt (her bruger det lille Radeon HD 4770 512MB 156-185 watt.). De grafiske hoved-API'er kortet understøtter, er som vanligt for helt nyere kort i denne klasse, Microsoft DirectX 10 og OpenGL 3.0. Da ingen grafikkort pt. understøtter DirectX 11 der kommer med Windows 7 og i Windows Vista's SP2, bør man overveje om man skal opgradere lige pt., eller vente til sidst på året. Talende imod en opgradering til DirectX 11 er det faktum, at ingen spil på markedet pt. understøtter DX11. Det der taler for en opgradering er, at der er mange spil under udvikling pt., som benytter DirectX 11.

Dog imponerer kortet rent overclocking-mæssigt - der er her ret meget at hente og jeg vil vurdere, at dette kort er noget for entusiasten der nyder, at overclocke og tweake sin hardware. Her lever Palit virkelig op til sit rygte, som en producent af højkvalitetsgrafikkort der er teknologisk overlegne. Overclocking og tweaking-mæssigt fungerer kortet virkelig glimrende! Der er derfor masser af tweaking, vandkøling/ekstremkøling og overclocking-potentiale, at hente i Palit GTX-275 896. Her er kortet lige noget for "tweakeren". Ydelsesmæssigt fungerer kortet helt upåklageligt i spil. Jeg har testet kortet med flere forskellige typer spil - gamle som nye - af alle slags og typer. Og der er intet at udsætte på Palit GTX-275 896 under IRL-spilning. Kortet yder fremragende til prisen og leverer stabile framerates og rigtig meget "bang-for-the-buck". Kortets ydelse set i forhold til dettes pris må siges, at stå helt rimeligt i forhold til hinanden.

Gigabyte GTX-285:

Gigabyte GTX-285 er et kort der indfrier ens forventninger til ydelse og brillierer indenfor overclockning og strømforbrug idle, i Windows Vista. Kortet overclocker uden problemer ved brug af NVIDIA's referencedriver helt op til 14.66%. Og det er ganske meget OC, at kunne udføre på et standard referencekort. Ydelsen ligger over AMD/ATI's produkter i visse tests, men i en hel del tests er ydelsen ca. det samme, hvilket er værd at notere sig, set i lyset af prisforkellen på GTX-285 1 GB og Radeon HD 4890 1GB, der er på næsten 1.000,- DKK. Har man brug for PhysX, godt OC-potentiale eller stærk OpenGL ydelse (dog kun i version 2.1 hos NVIDIA) er dette kortet man bør købe.

Gigabyte GTX-285 1 GB koster pt. 2.485,- DKK. Man kan få en version med to gigabyte RAM på for 2.962,- DKK, hvilket er en merpris på sølle 477,- DKK. Derfor får kortet kun 3 i pris, da den større model må siges, at være absolut mere fordelagtig til prisen. I øvrigt kan man få et AMD/ATI-grafikkort med næsten samme ydelse for ca. 1.000,- DKK mindre. Så har man ikke brug for NVIDIA's specifikke funktioner, bør man overveje, om man skal vente på næste generation fra NVIDIA, eller købe et AMD/ATi-baseret grafikkort. Til gengæld sparer man mere strøm, idle med power save i Windows Vista og Windows 7, end man gør med AMD/ATi's HD 4890 GPU. Til sammenligning koster Zotac GTX-285 AMP! Edition 1 GB der er fabriksoverclocket 5,- DKK mindre, end Gigabyte GTX-285, hvor der er spil og 3DMark Vantage med. Men med det flotte OC-potentiale i Gigabyte GTX-285, er det måske lige kortet for dig.

Gigabyte GTX-295:

Gigabyte GTX-295 er et kort der til fulde indfrier ens forventninger til ydelse og har et stort potentiale indenfor overclockning. Kortet overclocker uden problemer ved brug af NVIDIA's referencedriver og tools helt op til 16.5% i merydelse på GPU'en. Og det er ganske meget OC, at kunne udføre på et dobbelt-GPU grafikkort lavet på referencedesign. Ydelsen ligger langt over AMD/ATI's produkter i flere af vore tests. Men alt godt kommer ikke uden en omkostning. Og her skal man notere sig, at Gigabyte GTX-295 1.792 MB koster en hel del. Men det er værd at notere sig prisforskellen på GTX-285 1 GB og Radeon HD 4890 1GB, der er på ca. 2.000,- DKK. Ønsker man, at bruge voldsom PhysX, samt investere i et godt OC-potentiale og har behov for stærk OpenGL-ydelse (der særligt gør sig gældende på Linux eller BSD) bør man helt klart købe sig et Gigabytes GTX-295, da det hos os har vist et meget flot potentiale og virkelig god brugsværdi - og særligt excellerer indenfor OpenGL.

Gigabyte GTX-295 1 GB koster som sagt en hel del, sådan som markedet er pt. Men man får hvad man betaler for - rå og brutal ydelse, uden kompromisser. Kortet viser flot potentiale indenfor DirectX og særligt OpenGL, samt OC-området. Da AMD's nye serie lige er landet, er det dog klart, at kortet ikke er det bedste pris/ydelsesmæssigt. Men GTX295 ser fortsat ud til, at være lidt i front - og så er HD5870 fortsat svært at få fat på.

Så gå liiige hjem og "dæk" folkens, dér tak med de fanbooiii postulater I kommer med - og læs og forhold Jer til testens udførelse, som den rent teknisk er - og her lyver hardware jo ikke - eller gør det?... 😉

Faktum er, at jeg har testet 7 AMD/ATi grafikkort siden jeg startede på HwT.dk og 3 NVIDIA kort. Og hvorfor 7 AMD/ATi og 3 NVIDIA? Simpelthen fordi NVIDIA IKKE har noget nyt på tapetet pt. De støtter end ikke DirectX 10.1, som AMD har gjort længe, siden HD4000-serien. Men STADIG kører jeg end på DE ALLERNYSTE KORT FRA NVIDIA AF DirectX 10-tests for at sammenligne med AMD/ATI.

Og for at "pisse" på NVIDIA's helt store "kronjuvel" - OpenGL - så kører jeg sgu også de samme OpenGL-tests på AMD/ATI-kortene.

Ret citeret fra MSI AMD/ATI HD4890-artiklen:

Vi kan her kun hæfte os ved én enkelt ting - og det er, at i OpenGL-testen får alle AMD/ATI-kortene fuldstændigt baghjul af det NVIDIA-baserede Zotac GTX-285 AMP!. Og det i voldsom grad endda. Dette kan selvfølgelig, som altid, have en del at gøre med drivere og pågældende benchmark benyttet. Jeg konkluderer, at dette kan have haft en vis indspil i denne test. Da det er testens eneste OpenGL benchmark har vi desværre intet, at sammenligne med. Men jeg finder stadig FurMark kommer til sin ret i denne test. Den fandt i hvertfald ret hurtigt smertegrænserne for kortets overclockningsevner.

Vi ser her, at MSI R4890 ligger i toppen af AMD/ATi-kortene med meget flotte resultater - men er langt fra Zotac GTX-285 AMP! Bare i Entry-testen er der hele 20.000 points til forskel. Men dette skyldes alene, at Zotac GTX-285 kan gennemføre 3Dmarks PhysX deltest. Og denne teknologi understøtter AMD/ATI altså ikke (endnu).

Så hvem dér er det lige der vil påstå, at jeg som specialtester af grafikkort ikke er journalistisk uafhængig? Fordi dem af jer - som jeg kan høre/læse det - ikke kan komme Jer over, at AMD/ATi for en gangs skyld ligger helt oppe i front og siger "baghjul" til NVIDIA skal vel for helvede ikke være ensbetydende med, at jeg er AMD/ATi fanboooiii???, eller hvad?

For så havde jeg NOK IKKE SIDDET HER badet i min røvsved og bedt Steen -The Boss-, om at sende mig ALLE NVIDIA-kortene til GENTEST til refernce med de HEAVEN og STALKER:COp DX 11 så det kunne komme med i min baseline for grafikkortestene, vel?

Det tager ca. 20 timers koncetretet arbejde, at OC og benhcmarkteste bare ET grafikkort.

og tror I selv jeg gad sidde her og voldteste hele lortet, imellem mine deadlines og releasedatoer på NVIDIA HVIS IKKE det var fordi jeg RESERVERER MIG min uforbeholdne JOURNALISTISKE FRIHED til, at skrive følgende:

X kort fra Y producent scorer "røv" i forhold til Z producents model af X's nye GPU.

Og da jeg er helt ubetalt, frivillig tester så er der absolut INGEN grund til, at tro jeg fucker med konklusioner eller benchmarkers for den sags skyld for de lyver ikke, fordi jeg har et forbehold for en given producent.

Jeg glæder mig rent faktisk til, at få et Fermikort fra NVIDIA af når de releaser dette så jeg kan "rape" det of hoved og røv og så fortælle JER LÆSERE, hvad der skubber mest i front pt. - AMD/ATi eller NVIDIA.

For personligt er jeg dybt ligeglad. Den mest effektive, højstydende og evt. miljømæssigt korrekte teknologi er den der for mig er den anden konkurrents overlegen. Om denne så hedder NVIDIA, AMT/ATI eller YffenGnyf GPU Technologies er jeg dybt ligeglad med.

Jeg formidler til Jer af egen vilje og hjerte de korrekte fakta for de kort jeg tester - uanset disses labels/navne/mærker/producenter. Og hvis ikke jeg ville oprigtigt gøre dette, så havde jeg sgu nok ikke brugt så faens meget tid, på re.baseline af NVIDIA på Heaven og STALKER:COP, vel?

Her er svaret meget enkelt - pt. "ruler" AMD/ATI over NVIDIA - og jeg håber og ser frem til, at NVIDIA snart kommer frem med deres nye teknologi - for som mig at se som tester, så drejer det sig, om at have et valg. Og pt. er der INTET andet valg, end AMD/ATI og derved ingen konkurrence. Og med ingen konkurrence så ved VI ikke som forbrugere, hvad der er bedst, eller får tilbudt de bedste og nyeste og BILLIGSTE teknologier til OS som brugere...

WinterSilence out...

Svaret blev redigeret 1 gang, sidst af WinterSilence d. 04-12-2009 07:58:49.

Det jeg gengiver i mine artikler er den "rene sandhed", set udfra en teknisk uddannet grafikkorttesters synspunkt. Og det er derfor jeg som Emillos (min supervisor og chef) siger det, tester AMD/ATI med PPU/PhysX=On. For NVIDIA er foran med denne teknologi, hvor AMD/ATi støtter deres egen OpenCL.

Jeg tester et kort i alle de forbandede mange tests jeg kan finde og jeg udvælger ALENE som den der er testeren hér, min testsuite, i samarbejde med min supervisor Emillos.

Med denne testsuite der kører jeg alle de kort jeg tester gennem helvede og tortur på både OC og med benchmarks.

Faktum for mine tests resultater er følgende:

AMD/ATI HD5970 ruler/owner/overgår ALLE andre producenter pt. i OpenGL, DirectX 10 - og mest nødvendigt - DirectX 11.

For skal vi se fremad så må vi se på fakta. Og fakta er, at AMD/ATI pt. er ude med teknologi der langt overgår NVIDIA's.

Hvis ellers "I" gad, at se tilbage på mine tidligere tests/reviews/anmeldelser af NVIDIA-kort så ville I se,a t jeg netop har anført, bl.a. følgende citeret fra mine tests:

Palit GTX-275:

Kortets strømforbrug idle i Windows er særdeles acceptabelt. I 2-D-brug er forbruget ikke meget større end på eksempelvis det lille AMD/ATI Radeon HD 4770. Med 3 applikationer åbne og et Explorer-vindue sluger testsystemet omkring 173-200 watt totalt (her bruger det lille Radeon HD 4770 512MB 156-185 watt.). De grafiske hoved-API'er kortet understøtter, er som vanligt for helt nyere kort i denne klasse, Microsoft DirectX 10 og OpenGL 3.0. Da ingen grafikkort pt. understøtter DirectX 11 der kommer med Windows 7 og i Windows Vista's SP2, bør man overveje om man skal opgradere lige pt., eller vente til sidst på året. Talende imod en opgradering til DirectX 11 er det faktum, at ingen spil på markedet pt. understøtter DX11. Det der taler for en opgradering er, at der er mange spil under udvikling pt., som benytter DirectX 11.

Dog imponerer kortet rent overclocking-mæssigt - der er her ret meget at hente og jeg vil vurdere, at dette kort er noget for entusiasten der nyder, at overclocke og tweake sin hardware. Her lever Palit virkelig op til sit rygte, som en producent af højkvalitetsgrafikkort der er teknologisk overlegne. Overclocking og tweaking-mæssigt fungerer kortet virkelig glimrende! Der er derfor masser af tweaking, vandkøling/ekstremkøling og overclocking-potentiale, at hente i Palit GTX-275 896. Her er kortet lige noget for "tweakeren". Ydelsesmæssigt fungerer kortet helt upåklageligt i spil. Jeg har testet kortet med flere forskellige typer spil - gamle som nye - af alle slags og typer. Og der er intet at udsætte på Palit GTX-275 896 under IRL-spilning. Kortet yder fremragende til prisen og leverer stabile framerates og rigtig meget "bang-for-the-buck". Kortets ydelse set i forhold til dettes pris må siges, at stå helt rimeligt i forhold til hinanden.

Gigabyte GTX-285:

Gigabyte GTX-285 er et kort der indfrier ens forventninger til ydelse og brillierer indenfor overclockning og strømforbrug idle, i Windows Vista. Kortet overclocker uden problemer ved brug af NVIDIA's referencedriver helt op til 14.66%. Og det er ganske meget OC, at kunne udføre på et standard referencekort. Ydelsen ligger over AMD/ATI's produkter i visse tests, men i en hel del tests er ydelsen ca. det samme, hvilket er værd at notere sig, set i lyset af prisforkellen på GTX-285 1 GB og Radeon HD 4890 1GB, der er på næsten 1.000,- DKK. Har man brug for PhysX, godt OC-potentiale eller stærk OpenGL ydelse (dog kun i version 2.1 hos NVIDIA) er dette kortet man bør købe.

Gigabyte GTX-285 1 GB koster pt. 2.485,- DKK. Man kan få en version med to gigabyte RAM på for 2.962,- DKK, hvilket er en merpris på sølle 477,- DKK. Derfor får kortet kun 3 i pris, da den større model må siges, at være absolut mere fordelagtig til prisen. I øvrigt kan man få et AMD/ATI-grafikkort med næsten samme ydelse for ca. 1.000,- DKK mindre. Så har man ikke brug for NVIDIA's specifikke funktioner, bør man overveje, om man skal vente på næste generation fra NVIDIA, eller købe et AMD/ATi-baseret grafikkort. Til gengæld sparer man mere strøm, idle med power save i Windows Vista og Windows 7, end man gør med AMD/ATi's HD 4890 GPU. Til sammenligning koster Zotac GTX-285 AMP! Edition 1 GB der er fabriksoverclocket 5,- DKK mindre, end Gigabyte GTX-285, hvor der er spil og 3DMark Vantage med. Men med det flotte OC-potentiale i Gigabyte GTX-285, er det måske lige kortet for dig.

Gigabyte GTX-295:

Gigabyte GTX-295 er et kort der til fulde indfrier ens forventninger til ydelse og har et stort potentiale indenfor overclockning. Kortet overclocker uden problemer ved brug af NVIDIA's referencedriver og tools helt op til 16.5% i merydelse på GPU'en. Og det er ganske meget OC, at kunne udføre på et dobbelt-GPU grafikkort lavet på referencedesign. Ydelsen ligger langt over AMD/ATI's produkter i flere af vore tests. Men alt godt kommer ikke uden en omkostning. Og her skal man notere sig, at Gigabyte GTX-295 1.792 MB koster en hel del. Men det er værd at notere sig prisforskellen på GTX-285 1 GB og Radeon HD 4890 1GB, der er på ca. 2.000,- DKK. Ønsker man, at bruge voldsom PhysX, samt investere i et godt OC-potentiale og har behov for stærk OpenGL-ydelse (der særligt gør sig gældende på Linux eller BSD) bør man helt klart købe sig et Gigabytes GTX-295, da det hos os har vist et meget flot potentiale og virkelig god brugsværdi - og særligt excellerer indenfor OpenGL.

Gigabyte GTX-295 1 GB koster som sagt en hel del, sådan som markedet er pt. Men man får hvad man betaler for - rå og brutal ydelse, uden kompromisser. Kortet viser flot potentiale indenfor DirectX og særligt OpenGL, samt OC-området. Da AMD's nye serie lige er landet, er det dog klart, at kortet ikke er det bedste pris/ydelsesmæssigt. Men GTX295 ser fortsat ud til, at være lidt i front - og så er HD5870 fortsat svært at få fat på.

Så gå liiige hjem og "dæk" folkens, dér tak med de fanbooiii postulater I kommer med - og læs og forhold Jer til testens udførelse, som den rent teknisk er - og her lyver hardware jo ikke - eller gør det?... 😉

Faktum er, at jeg har testet 7 AMD/ATi grafikkort siden jeg startede på HwT.dk og 3 NVIDIA kort. Og hvorfor 7 AMD/ATi og 3 NVIDIA? Simpelthen fordi NVIDIA IKKE har noget nyt på tapetet pt. De støtter end ikke DirectX 10.1, som AMD har gjort længe, siden HD4000-serien. Men STADIG kører jeg end på DE ALLERNYSTE KORT FRA NVIDIA AF DirectX 10-tests for at sammenligne med AMD/ATI.

Og for at "pisse" på NVIDIA's helt store "kronjuvel" - OpenGL - så kører jeg sgu også de samme OpenGL-tests på AMD/ATI-kortene.

Ret citeret fra MSI AMD/ATI HD4890-artiklen:

Vi kan her kun hæfte os ved én enkelt ting - og det er, at i OpenGL-testen får alle AMD/ATI-kortene fuldstændigt baghjul af det NVIDIA-baserede Zotac GTX-285 AMP!. Og det i voldsom grad endda. Dette kan selvfølgelig, som altid, have en del at gøre med drivere og pågældende benchmark benyttet. Jeg konkluderer, at dette kan have haft en vis indspil i denne test. Da det er testens eneste OpenGL benchmark har vi desværre intet, at sammenligne med. Men jeg finder stadig FurMark kommer til sin ret i denne test. Den fandt i hvertfald ret hurtigt smertegrænserne for kortets overclockningsevner.

Vi ser her, at MSI R4890 ligger i toppen af AMD/ATi-kortene med meget flotte resultater - men er langt fra Zotac GTX-285 AMP! Bare i Entry-testen er der hele 20.000 points til forskel. Men dette skyldes alene, at Zotac GTX-285 kan gennemføre 3Dmarks PhysX deltest. Og denne teknologi understøtter AMD/ATI altså ikke (endnu).

Så hvem dér er det lige der vil påstå, at jeg som specialtester af grafikkort ikke er journalistisk uafhængig? Fordi dem af jer - som jeg kan høre/læse det - ikke kan komme Jer over, at AMD/ATi for en gangs skyld ligger helt oppe i front og siger "baghjul" til NVIDIA skal vel for helvede ikke være ensbetydende med, at jeg er AMD/ATi fanboooiii???, eller hvad?

For så havde jeg NOK IKKE SIDDET HER badet i min røvsved og bedt Steen -The Boss-, om at sende mig ALLE NVIDIA-kortene til GENTEST til refernce med de HEAVEN og STALKER:COp DX 11 så det kunne komme med i min baseline for grafikkortestene, vel?

Det tager ca. 20 timers koncetretet arbejde, at OC og benhcmarkteste bare ET grafikkort.

og tror I selv jeg gad sidde her og voldteste hele lortet, imellem mine deadlines og releasedatoer på NVIDIA HVIS IKKE det var fordi jeg RESERVERER MIG min uforbeholdne JOURNALISTISKE FRIHED til, at skrive følgende:

X kort fra Y producent scorer "røv" i forhold til Z producents model af X's nye GPU.

Og da jeg er helt ubetalt, frivillig tester så er der absolut INGEN grund til, at tro jeg fucker med konklusioner eller benchmarkers for den sags skyld for de lyver ikke, fordi jeg har et forbehold for en given producent.

Jeg glæder mig rent faktisk til, at få et Fermikort fra NVIDIA af når de releaser dette så jeg kan "rape" det of hoved og røv og så fortælle JER LÆSERE, hvad der skubber mest i front pt. - AMD/ATi eller NVIDIA.

For personligt er jeg dybt ligeglad. Den mest effektive, højstydende og evt. miljømæssigt korrekte teknologi er den der for mig er den anden konkurrents overlegen. Om denne så hedder NVIDIA, AMT/ATI eller YffenGnyf GPU Technologies er jeg dybt ligeglad med.

Jeg formidler til Jer af egen vilje og hjerte de korrekte fakta for de kort jeg tester - uanset disses labels/navne/mærker/producenter. Og hvis ikke jeg ville oprigtigt gøre dette, så havde jeg sgu nok ikke brugt så faens meget tid, på re.baseline af NVIDIA på Heaven og STALKER:COP, vel?

Her er svaret meget enkelt - pt. "ruler" AMD/ATI over NVIDIA - og jeg håber og ser frem til, at NVIDIA snart kommer frem med deres nye teknologi - for som mig at se som tester, så drejer det sig, om at have et valg. Og pt. er der INTET andet valg, end AMD/ATI og derved ingen konkurrence. Og med ingen konkurrence så ved VI ikke som forbrugere, hvad der er bedst, eller får tilbudt de bedste og nyeste og BILLIGSTE teknologier til OS som brugere...

WinterSilence out...

Svaret blev redigeret 1 gang, sidst af WinterSilence d. 04-12-2009 07:58:49.

#26

Jeg er også spændt på hvad det er for nogle NV kort folk savner, at der bliver testet op i mod? 😕

WS kunne vel ikke udelade: 5870 eller 5850 i testen, og 295 er et absolut must, da det er topkortet. Er der andet der er interessant i en artikel, hvor ATI's dual GPU kort bliver testet?

Alle (der savner flere NV kort) ved jo hvordan 285 osv. yder i forhold til 295?

Jeg synes at WS har valgt de helt rigtige kort at medtage i testen for at give et øjebliksbillede af high-end grafikkortene i de 'to lejre'. Flere kort vil kun forplumre graferne og give hovedpine til testeren, som skal lave endnu mere arbejde.

Svaret blev redigeret 1 gang, sidst af scheea2000 d. 04-12-2009 08:08:21.

WS kunne vel ikke udelade: 5870 eller 5850 i testen, og 295 er et absolut must, da det er topkortet. Er der andet der er interessant i en artikel, hvor ATI's dual GPU kort bliver testet?

Alle (der savner flere NV kort) ved jo hvordan 285 osv. yder i forhold til 295?

Jeg synes at WS har valgt de helt rigtige kort at medtage i testen for at give et øjebliksbillede af high-end grafikkortene i de 'to lejre'. Flere kort vil kun forplumre graferne og give hovedpine til testeren, som skal lave endnu mere arbejde.

Svaret blev redigeret 1 gang, sidst af scheea2000 d. 04-12-2009 08:08:21.

#27

0#

syntes det var en enorm flot test, dækkede mange områder 🙂 specielt med strømforbrug er jeg glad for. det koster jo faens meget på et år hvis man ikke er opmærksom hAHA 🙂 Fik en ekstra bong på 6000kr til dong energi. satans ps3 ^^ og gamle stationære pc!

anyway

men helt sikkert 5\5 point 🙂 i min verden. og fatter ikke at nvidia drengene opfører sig sådan, i må da indse at det er en god test om så jeres "favor card" er slået. det er jo kun godt for os allesammen at der er så tæt løb på ydelsen, så knokler de røven ud af bukserne for at slå konkurrenterne 🙂

me like competition. me hate fan boys, hehe

og bliv endelig ved med at lave disse test. kanon lækkert. og hva faen gør det at du ikke har alle spil med. har jo stadig et godt overblik, forståeligt at du ikke gider spendere egne penge på at tilfredsstille en flok unknown nørder 🙂

syntes det var en enorm flot test, dækkede mange områder 🙂 specielt med strømforbrug er jeg glad for. det koster jo faens meget på et år hvis man ikke er opmærksom hAHA 🙂 Fik en ekstra bong på 6000kr til dong energi. satans ps3 ^^ og gamle stationære pc!

anyway

men helt sikkert 5\5 point 🙂 i min verden. og fatter ikke at nvidia drengene opfører sig sådan, i må da indse at det er en god test om så jeres "favor card" er slået. det er jo kun godt for os allesammen at der er så tæt løb på ydelsen, så knokler de røven ud af bukserne for at slå konkurrenterne 🙂

me like competition. me hate fan boys, hehe

og bliv endelig ved med at lave disse test. kanon lækkert. og hva faen gør det at du ikke har alle spil med. har jo stadig et godt overblik, forståeligt at du ikke gider spendere egne penge på at tilfredsstille en flok unknown nørder 🙂

#28

Hold kæft hvor er det her åndsvagt..

#29

#28 Gripen90:

Helt enig med dig dér 🙂

Helt enig med dig dér 🙂

#30

#25 well said, keep up the good work.

Svaret blev redigeret 1 gang, sidst af (FIH) The Don d. 06-12-2009 02:59:19.

#31

#30 Mange tusinde tak 🙂

#32

nu får jeg sku også lyst til at bakke dig lidt op Wintertstilhed 🙂

Jeg ville heller ikke kunne få armene ned hvis jeg kunne få et gfx der yder max til billige penge og som ikke bruger ret meget strøm. 🙂

Og til jer wanebe kælingetudetøser wanker benchbither, det kan da godt være at ATI i mange bench mangler 2-4 fps, men når hjernens og øjets anatomi er opbygget sådan at vi mennesker max kan se ca. 60 fps, så kan det undskyld være fukking lige meget om et gfx giver 150 fps. eller 152 fps. og til den der påstår noget andet kan men nok ikke tage så seriøst. 😎

Jeg ville heller ikke kunne få armene ned hvis jeg kunne få et gfx der yder max til billige penge og som ikke bruger ret meget strøm. 🙂

Og til jer wanebe kælingetudetøser wanker benchbither, det kan da godt være at ATI i mange bench mangler 2-4 fps, men når hjernens og øjets anatomi er opbygget sådan at vi mennesker max kan se ca. 60 fps, så kan det undskyld være fukking lige meget om et gfx giver 150 fps. eller 152 fps. og til den der påstår noget andet kan men nok ikke tage så seriøst. 😎

#33

"Withdrawn".... 😕

Svaret blev redigeret 2 gange, sidst af OdysseDK d. 06-12-2009 12:50:56.

Svaret blev redigeret 2 gange, sidst af OdysseDK d. 06-12-2009 12:50:56.

#34

WinterSilence har lavet et mega godt arbejde i mine øjne. Jeg vil bare enten have det bedste, det bedste til prisen eller den med bedst strømøkonomi. PT er ATI(Kan ikke få mig selv til at skrive AMD/ATI) foran på alle punkterne. Om det bedste kort for eftertiden hedder ATI, Nvidia eller I'MAFANBOY er jeg totalt ligeglad med.

WinterSilence just keep swinging. Vi er mange det syntes det var et fedt stykke arbejde du lavede og sikkert vil blive ved med, hvis da ikke "fanboysene" får dig til at miste modet. Hvilket jeg absolut ikke håber. Hvis Fermi sparker røv i forhold til ATI, når det kommer(Hvilket sandsynligvis er tilfældet på ydelsen), så skal de da roses for det.

Forresten har selv sværget til AMDs CPUer, men min næste er fra Intel. Hvorfor? Fordi jeg tror, de kommer til at holde længere. Jeg er en rigtig dårlig fanboy 🤣

Som Drunken skrev "me like competition. me hate fan boys" :yes:

WinterSilence just keep swinging. Vi er mange det syntes det var et fedt stykke arbejde du lavede og sikkert vil blive ved med, hvis da ikke "fanboysene" får dig til at miste modet. Hvilket jeg absolut ikke håber. Hvis Fermi sparker røv i forhold til ATI, når det kommer(Hvilket sandsynligvis er tilfældet på ydelsen), så skal de da roses for det.

Forresten har selv sværget til AMDs CPUer, men min næste er fra Intel. Hvorfor? Fordi jeg tror, de kommer til at holde længere. Jeg er en rigtig dårlig fanboy 🤣

Som Drunken skrev "me like competition. me hate fan boys" :yes:

#35

#34, det kan vist have lange udsigter, før den sammenligning kan finde sted: http://www.fudzilla.com/conten...

#37

Tak for rosen alle sammen 🙂

#38

1. hold kæft hvor en bærnehave det er herinde ....en vigtig årsag til jeg ikke længere søger hjælp herinde, hvilket egentligt er ret sørgeligt da denne hjemmeside var den første danske hardware side og forum jeg overhovedet havde med at gøre.

2. hvorfor kan folk (både læsere og testere) ikke skrive evt. kritik på en måde der hverken er personlig eller barnlig.......der flyver altid personlige beskyldninger om folk der er fanboys, dårlige til at teste osv osv.....OG JEG ER FANME TRÆT AF AT DET LIGNER HOL.DK! ..fix jeres attituder derude.

2. hvorfor kan folk (både læsere og testere) ikke skrive evt. kritik på en måde der hverken er personlig eller barnlig.......der flyver altid personlige beskyldninger om folk der er fanboys, dårlige til at teste osv osv.....OG JEG ER FANME TRÆT AF AT DET LIGNER HOL.DK! ..fix jeres attituder derude.

#39

G.N.U Fragman -det kan jeg godt følge dig i. Men hvis folk de angriber min journalistiske integritet/uafhænggihed (som foroven) så vil jeg gerne fremligge beviser herfor, at de tager fejl.

For som jeg siger - jeg er teknisk tester - jeg tester ting. Er noget bedre, end andet skriver jeg det. Er det ikke skriver jeg det. Meget simpelt. Og så gider jeg ikke anklages for, at jeg er "fanboooiiii".

Og jeg vil på ingen måde anklages - som uafhængig journalist - eller finde mig i, at folk skriver jeg som tester konkluderer det jeg gør, fordi fordi jeg, er "fanboooiii" af et vist mærke, eller teknologi.

Som jeg har skrevet før, så formidler jeg til Jer det der er "sandheden". Og den såkaldte "sandhed" hér skal ses, som de resultater jeg opnår på den specificerede testrig jeg bruger. Og her er det "sjovt",at se folk kritisererer mig/HwT.dk for at jeg tester på AMD - og IKKE Intel i7 "super performance" platform.

Men min platform er AMD-baseret pt. Og jeg gengiver intet andet, end de rå resultater. Og herfra tager jeg som tester min konklusion.

At folk så ikke pt. kan leve med, at AMD/ATI pt. overgår NVIDIA pt. er ikke mit problem - resultaterne taler for sig selv - og dem kan enhver gøre efter på sin egen maskine og evt. skalere op, til sin egen maskines specifikationer.

Når - eller hvis - NVIDIA kommer med et 40 nm grafikkort der overgår HD5970 eller HD5870 der pt. "ruler" de teknologisker formåender på markedet, udfra performance og tekniske kompatible evner med seneste teknolgi (læs:DX11 fra MS af) så skal jeg meget gerne skrive det til Jer, som læsere, at dette så langt overgpr AMD/ATI 🙂

Men at man pisser på min integritet -som foroven- som uafhængig journalist - det vil jeg sgu ikke finde mig i...

Mvh.

WinterSilence/Kim F.

For som jeg siger - jeg er teknisk tester - jeg tester ting. Er noget bedre, end andet skriver jeg det. Er det ikke skriver jeg det. Meget simpelt. Og så gider jeg ikke anklages for, at jeg er "fanboooiiii".

Og jeg vil på ingen måde anklages - som uafhængig journalist - eller finde mig i, at folk skriver jeg som tester konkluderer det jeg gør, fordi fordi jeg, er "fanboooiii" af et vist mærke, eller teknologi.

Som jeg har skrevet før, så formidler jeg til Jer det der er "sandheden". Og den såkaldte "sandhed" hér skal ses, som de resultater jeg opnår på den specificerede testrig jeg bruger. Og her er det "sjovt",at se folk kritisererer mig/HwT.dk for at jeg tester på AMD - og IKKE Intel i7 "super performance" platform.

Men min platform er AMD-baseret pt. Og jeg gengiver intet andet, end de rå resultater. Og herfra tager jeg som tester min konklusion.

At folk så ikke pt. kan leve med, at AMD/ATI pt. overgår NVIDIA pt. er ikke mit problem - resultaterne taler for sig selv - og dem kan enhver gøre efter på sin egen maskine og evt. skalere op, til sin egen maskines specifikationer.

Når - eller hvis - NVIDIA kommer med et 40 nm grafikkort der overgår HD5970 eller HD5870 der pt. "ruler" de teknologisker formåender på markedet, udfra performance og tekniske kompatible evner med seneste teknolgi (læs:DX11 fra MS af) så skal jeg meget gerne skrive det til Jer, som læsere, at dette så langt overgpr AMD/ATI 🙂

Men at man pisser på min integritet -som foroven- som uafhængig journalist - det vil jeg sgu ikke finde mig i...

Mvh.

WinterSilence/Kim F.

#40

#39

kan jeg sku godt forstå

kan jeg sku godt forstå

#42

#39 har selv skrevet en test eller 2 for jer, så kan sagtens følge dig, og det er nu ikke fordi jeg tror at testerne ikke gør deres bedste og er så objektive som de kan være. Det er mere tonen i de ting der bliver skrevet, der ofte meget hurtigt bliver direkte personlig, og ½ af de ting kunne evt være klaret i en pm personerne imellem.

#43

så mangler vi bare at man kan få kortet.. jeg har opgivet min bestilling efter 1.5 måned hvor leverance datoen hele tiden blev udskudt fordi leverandøren udskyd leverancen.. har så fået at vide at det simpelthen er fordi der ikke er chip's nok til at lave kort nok til efterspørgslen... men om det passer skal jeg ikke lige kunne sige andet end jeg vel kun kan tro på hvad man har læst sig til. :(( så jeg må bare vente i tålmodighed da min nye super computer kun mangler et nyt gfx kort for at være oppe og kører :) men ellers ontopic... så fed test og review af 5970 du fik det i hvert fald solgt det til mig ! :)

#44

#43: Mange tak det glæder mig :)

![[G.N.U.]](/images/users/profile/36302.jpg)