Test

Følgende test setup/maskine er benyttet til testen af kortet:

| |

Model |

Hastighed/Driver

|

| Operativsystem |

Windows 10 Pro |

|

| Processor |

Intel i5 6600K |

4500 MHz |

| Bundkort |

GIGABYTE G1 GAMING Z170 |

|

| RAM |

Crucial Ballistix 4x4GB |

2400 MHz |

| Strømforsyning |

Corsair AX1200i |

1200 watt |

| Kabinet |

Corsair Carbide 600Q |

|

| CPU Køler |

NZXT Kraken X61 |

|

| SSD |

OCZ Vector 180 – 240 GB |

|

| Fan Controller |

NZXT GRID+ V2 |

|

| Blæsere |

Noctua NF P14s |

|

| |

|

|

| Grafikkort |

GIGABYTE AORUS 2080 Ti Xtreme |

ForceWare 416.94 |

| Sammenlign. |

GIGABYTE RTX 2070 Gaming OC |

ForceWare 416.34 |

| |

GIGABYTE RTX 2080 Gaming OC |

ForceWare 411.51 |

| |

GIGABYTE AORUS 1080 Ti |

ForceWare 382.53 |

| |

MSI GTX 1080 Ti Lightning |

ForceWare 388.31 |

| |

MSI GTX 1080 Ti GAMING X |

ForceWare 381.65 |

| |

MSI RX 570 Gaming X |

Crimson v.17.10.10 |

| |

MSI RX 580 Gaming X |

Crimson v.17.10.10 |

| |

GIGABYTE G1 GTX 1050 Ti |

ForceWare 378.78 |

| |

ASUS STRIX GTX 1050 |

ForceWare 378.49 |

| |

ASUS STRIX GTX 1060 6GB |

ForceWare 376.33 |

| |

GIGABYTE G1 Gaming GTX 1060 |

ForceWare 372.70 |

| |

Palit GameRock GTX 1070 |

ForceWare 368.81 |

| |

GIGABYTE GTX 1080 Xtreme Gaming |

ForceWare 368.81 |

| |

ASUS GTX 970 Mini |

ForceWare 364.72 |

| |

AMD Radeon R9 Nano |

Crimson v. 16.5.1 |

Test software:

OBS:

Bemærk at grafikkortene er testet med forskellige drivers, da benchmarks er kørt ved hver enkel anmeldelse. Der kan derfor være afvigelser i den målte ydelse kontra de tal, der ville komme, hvis alle kort var testet med samme driver.

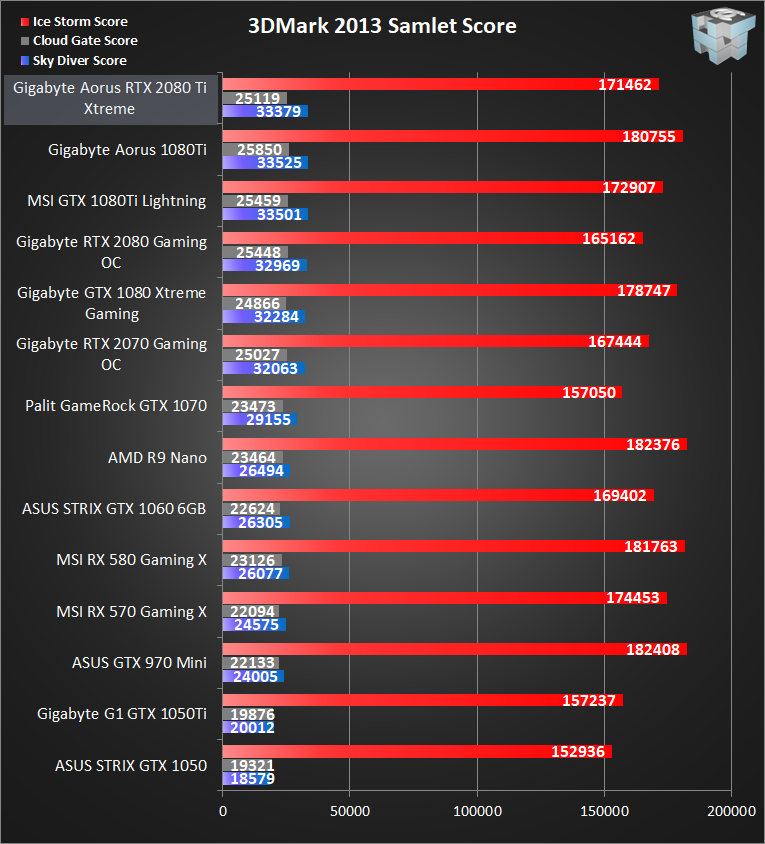

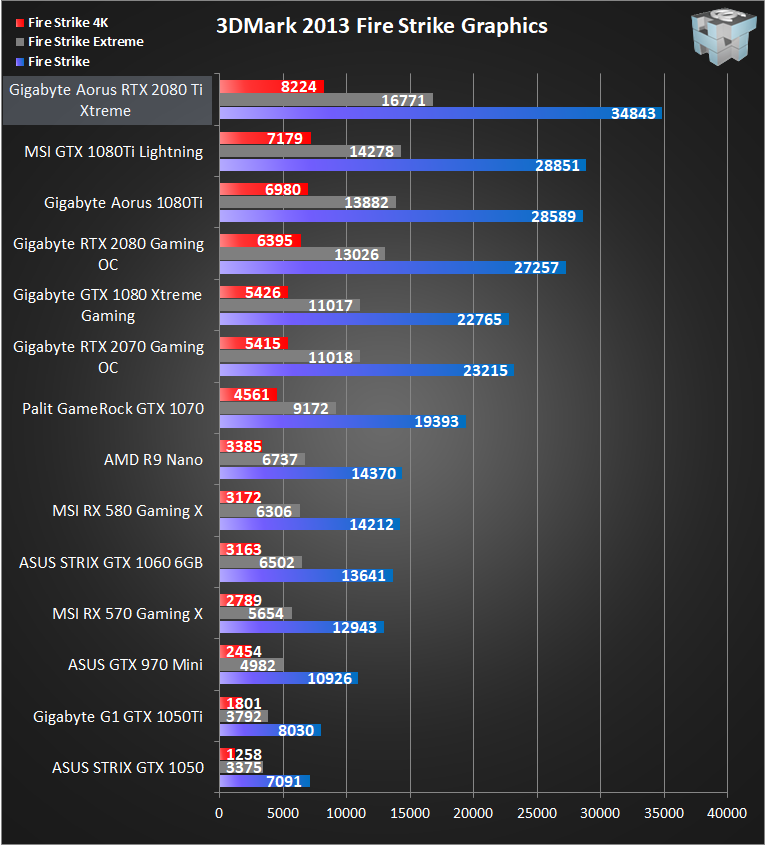

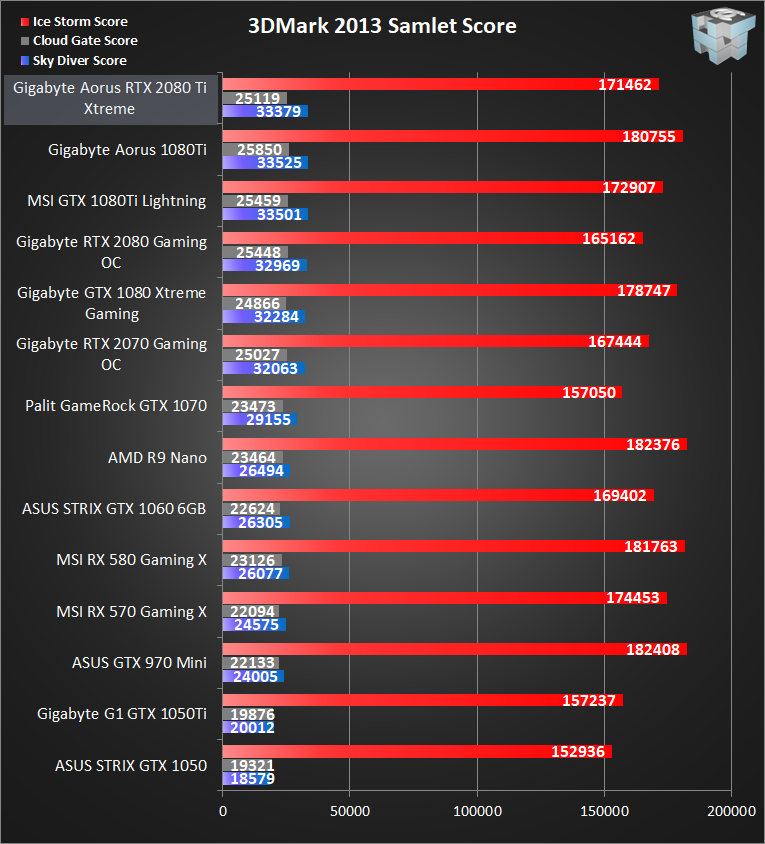

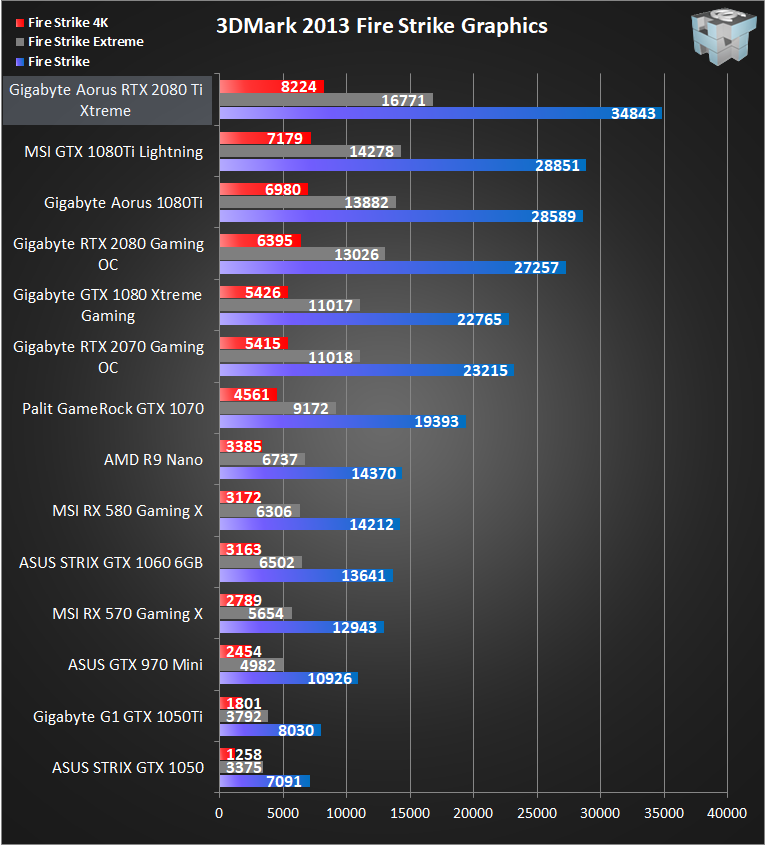

3DMark 2013:

En ny version af Windows ledsages gerne af en ny version af 3DMark. Denne gang har Futuremark fokuseret på at lave en benchmark, der kan bruges på alle platforme. Derfor er der 3 individuelle tests: Ice Storm, som er til tablets og langsomme computere. Cloud Gate, der er lavet til den almindelige PC og bærbar og sidst Fire Storm, som er lavet til at teste gamer PC'en til 20.000 kr. Vi tester i standard indstillingerne for alle benchmarks.

Der er testet i de forudkonfigurerede indstillinger, inklusive den nye Time Spy DirectX 12 test.

Unigine Heaven benchmark 4.0 tool:

Heaven benchmark var den første benchmark til at benytte DirectX 11 - få dage efter udkom STALKER: COP og de tilhørende nye features som Tessellation og Shader Model 5.0.

Testen er baseret på Unigine-motoren og kan tvinge alle de testede grafikkort i knæ.

1: DirectX 11 - Quality: High - Tesselation: Moderate - Anti-aliasing: 2x - Resolution: 1920x1080

2: DirectX 11 - Quality: Ultra - Tesselation: Extreme - Anti-aliasing: 4x - Resolution: 1920x1080

3: DirectX 11 - Quality: High - Tesselation: Normal - Anti-aliasing: 2x - Resolution: 2560x1440

4: DirectX 11 - Quality: Ultra - Tesselation: Extreme - Anti-aliasing: 8x - Resolution: 2560x1440

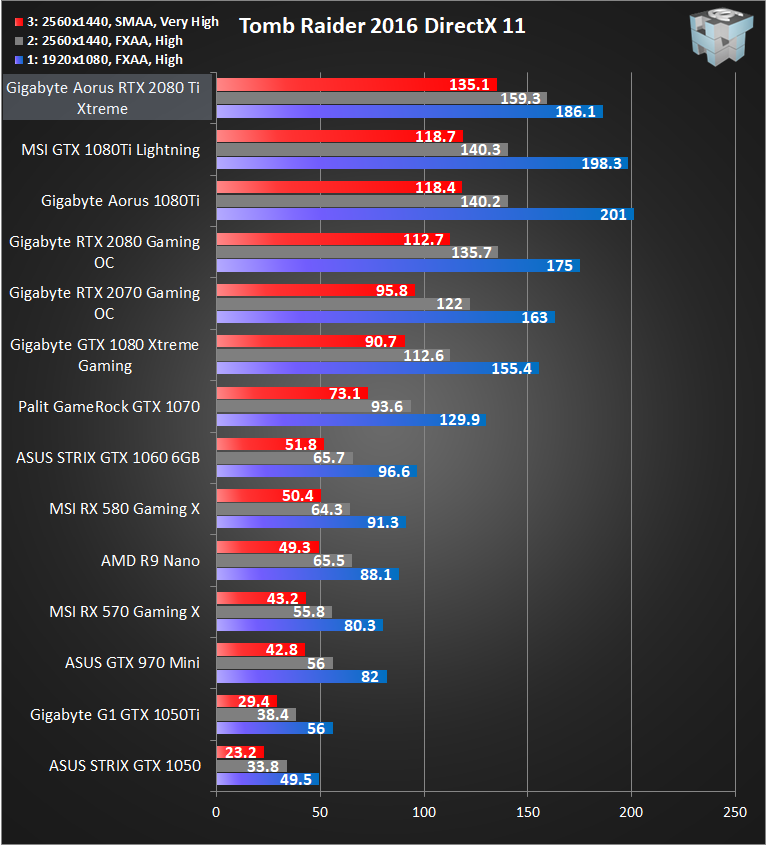

Tomb Raider 2013:

Det evigt klassiske Tomb Raider er tilbage, denne gang med flot grafik og moderne gameplay.

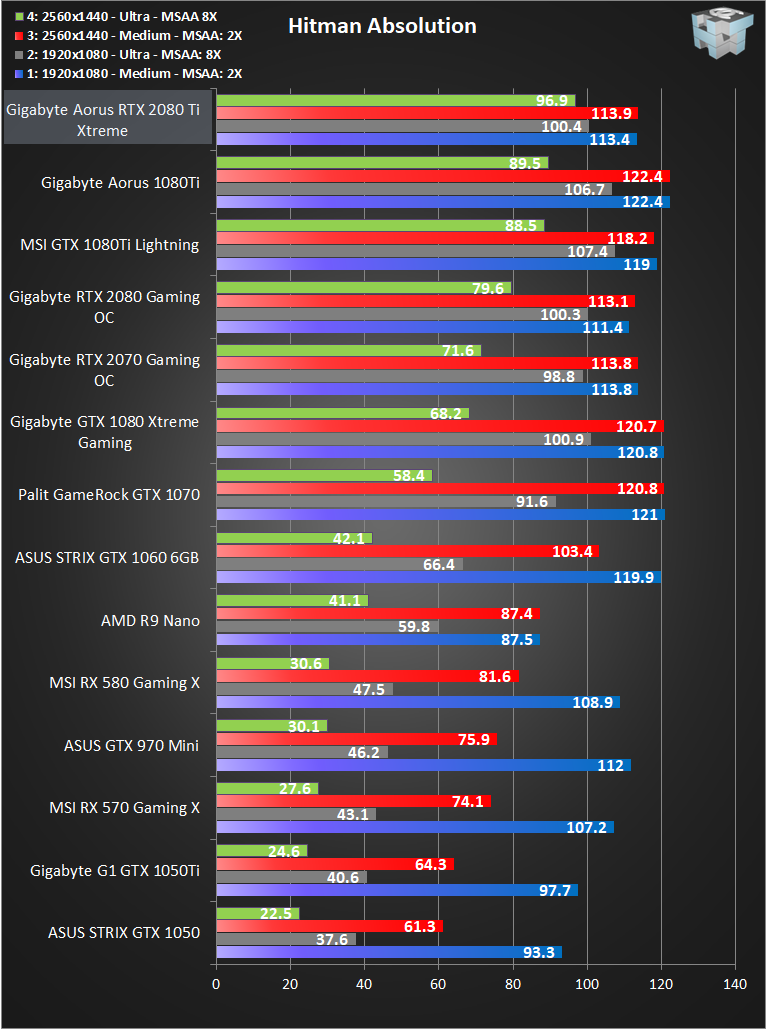

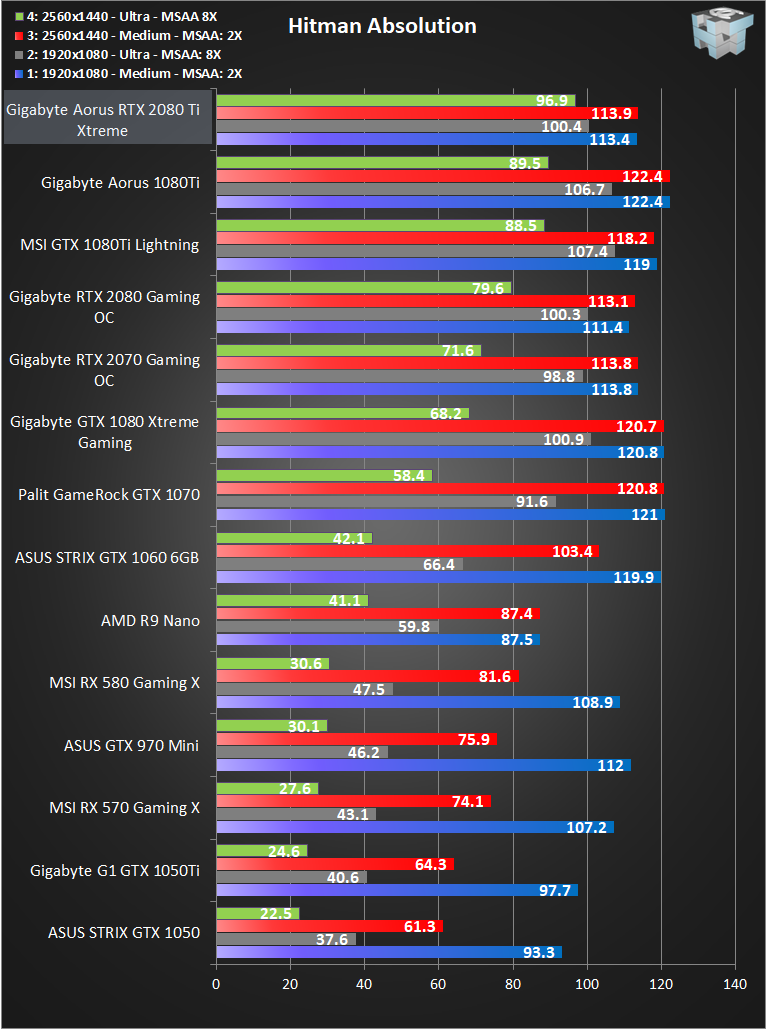

Hitman Absolution:

Hitman Absolution er et spil, hvor det mest af alt gælder om at gå i skyggen og være stille. Absolution er 5. spil i Hitman serien, og kører på IO Interactive's Glacier 2 engine, som gør brug af DirectX 11 API'en og ser rigtig flot ud. Derudover er det dansk, og en bedre argumentation for at benytte det til benchmark kan vi ikke komme på.

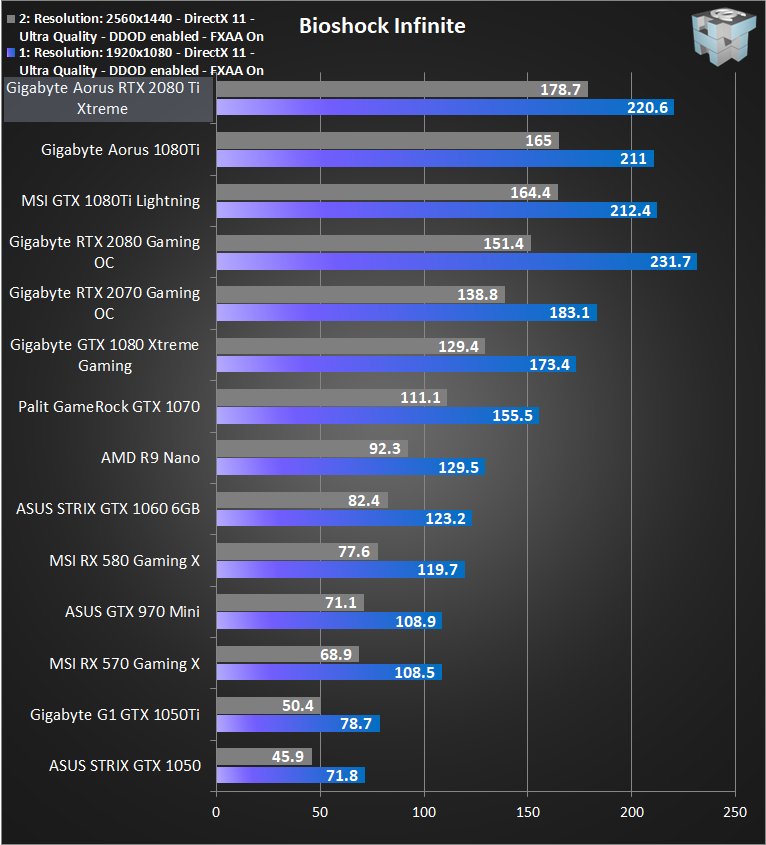

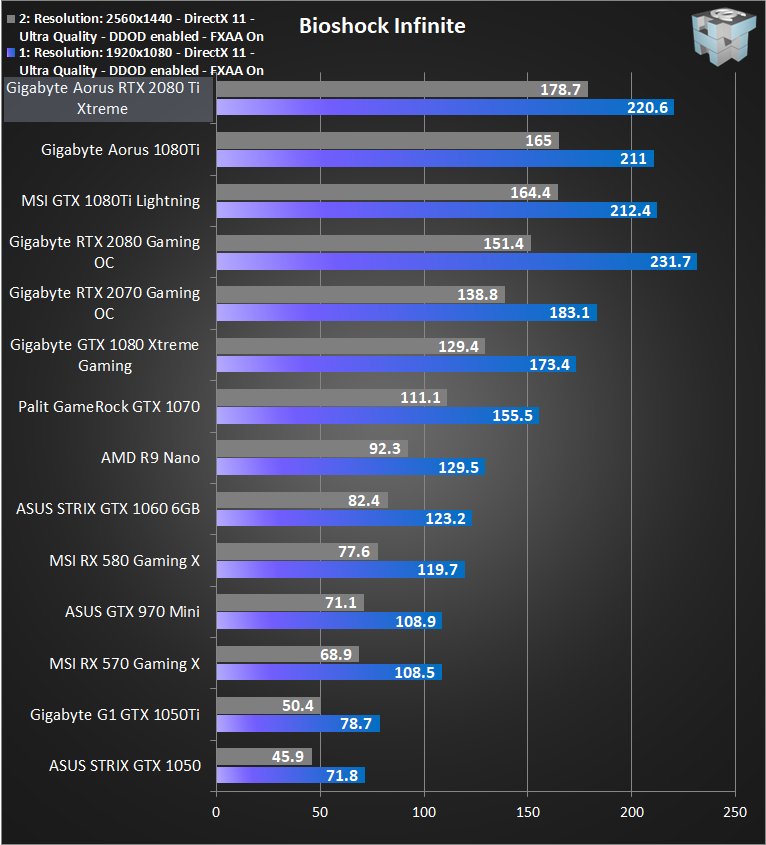

Bioshock Infinite:

Udgivet af 2K Games som også udgav Duke Nukem Forever og Borderlands. Bioshock Infinite bruger den velkendte Unreal Engine 3, der gør brug af DirectX 11 API'en.

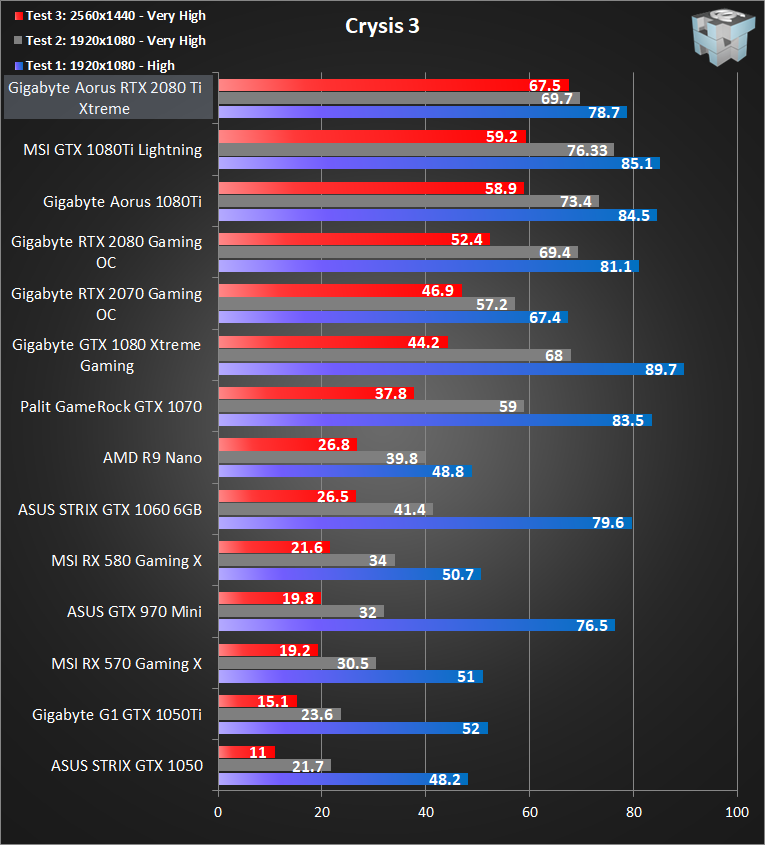

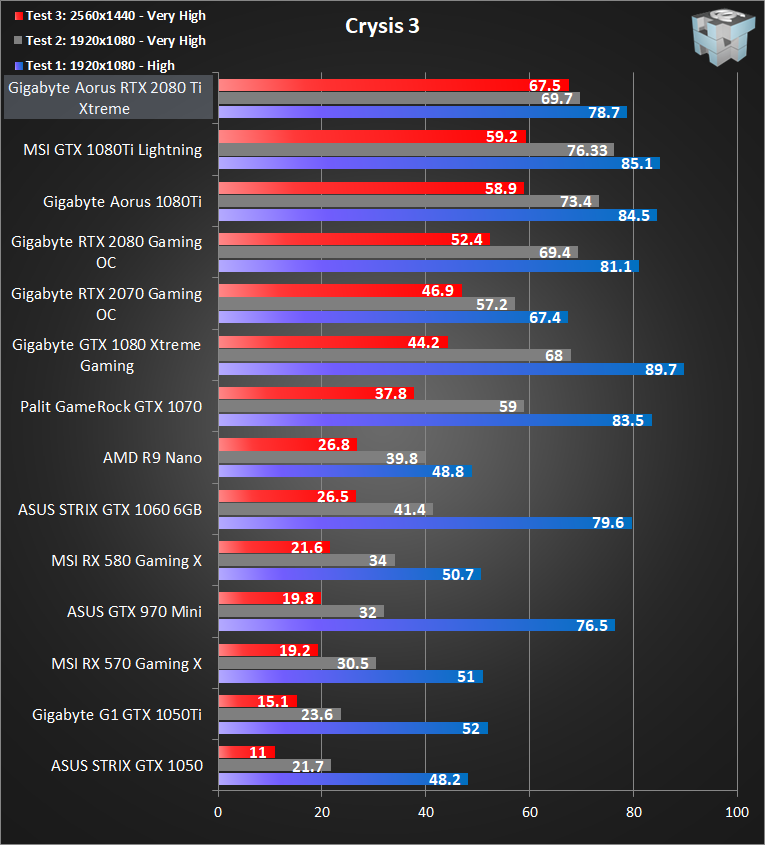

Crysis 3:

Crysis er tilbage og ligesom i de forrige spil er grafikken banebrydende. Med indstillingerne på Very High er Crysis 3 det computerspil på markedet, som er flottest. Dette gør også spillet meget krævende og derfor ideelt til benchmark. Vi tester i High og den meget krævende Very High setting.

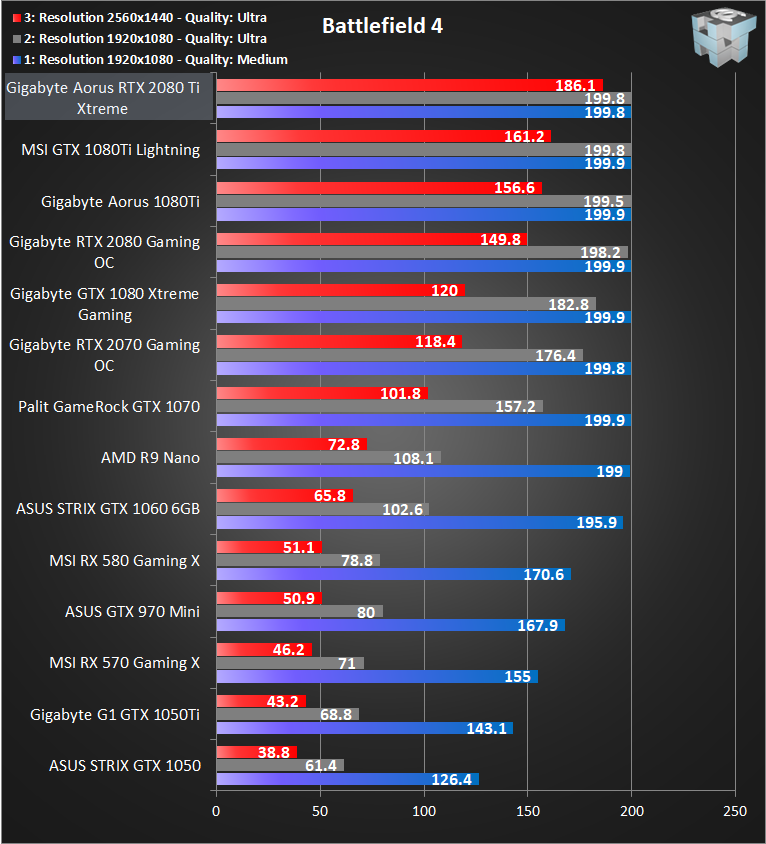

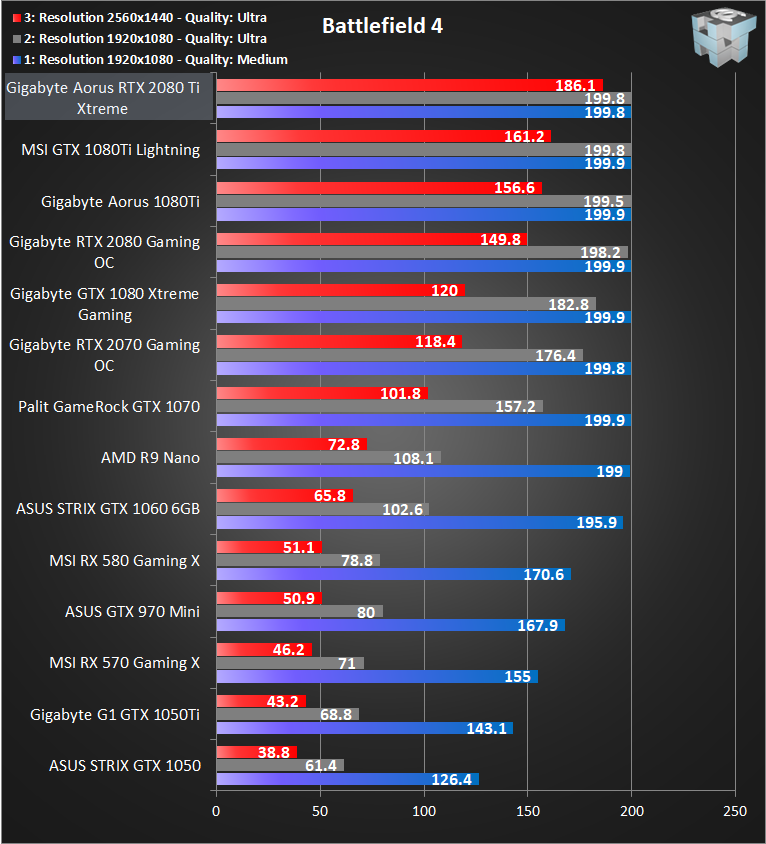

Battlefield 4:

Et spil der næppe kræver nogen introduktion. Vi ser endnu mere imponerende grafik end Battlefield 3, der leverede en fantastisk grafik. Den brugte spilmotor er Frostbite 3, som er en af de mest flotte på markedet.

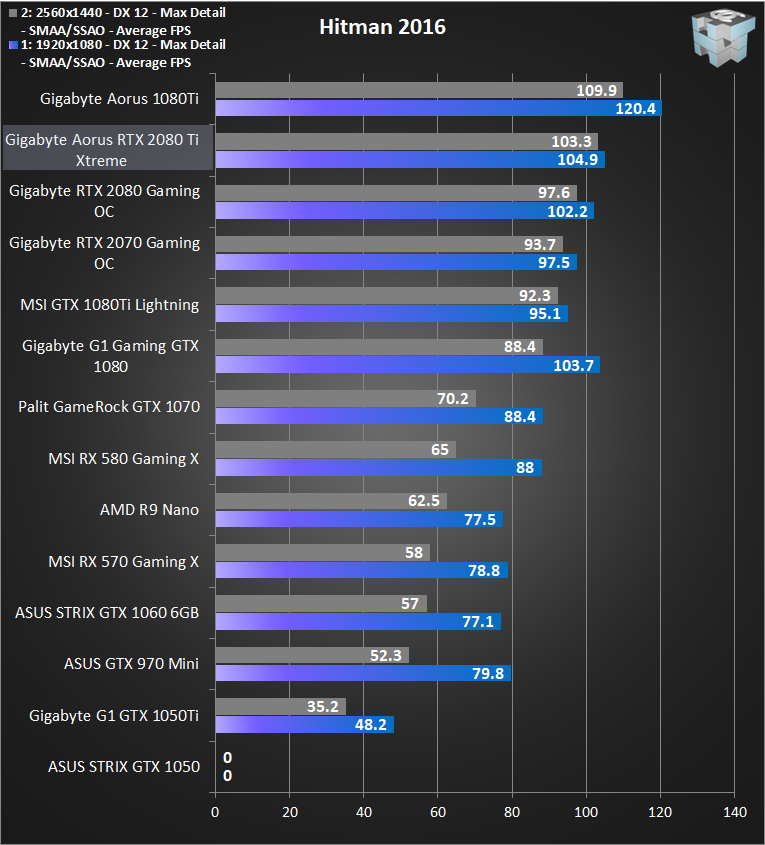

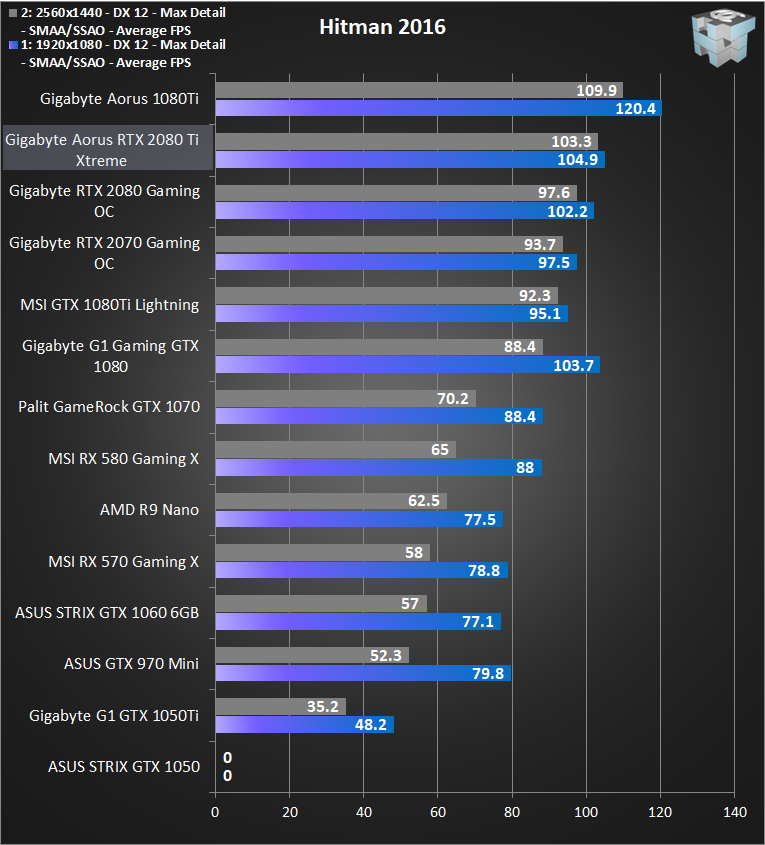

Hitman 2016:

Hitman er gået tilbage til rødderne og det nye spil minder mest af alt om bestselleren Blood Money. Nåh ja og så er der naturligvis DirectX 12 understøttelse.

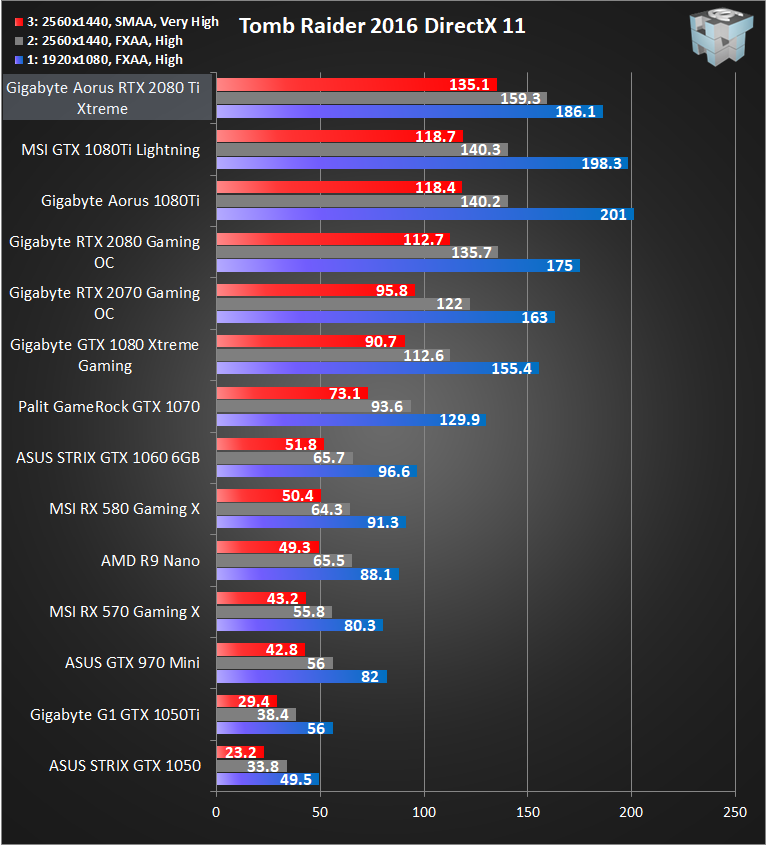

Rise of The Tomb Raider:

Tomb Raider fylder 20 i år, siden da er den originale Playstation gået ud af produktion og Croft er blevet yngre. Men grafikken har aldrig været bedre og spillet er blandt de første med en smule DirectX 12 understøttelse.

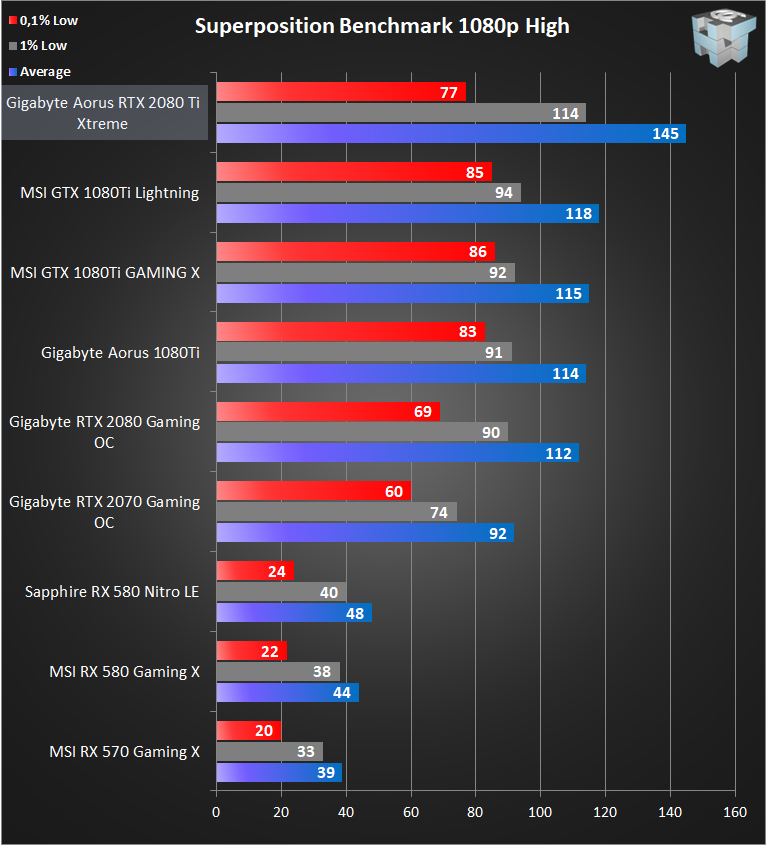

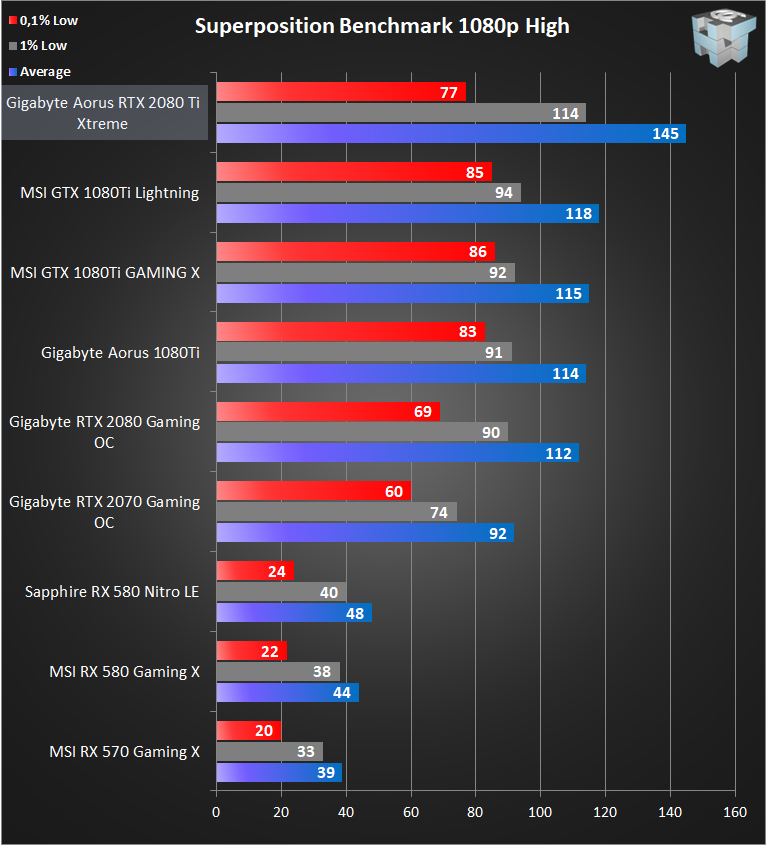

Unigine Superposition

Superposition er den nye benchmark fra Unigine, som også står bag Heaven benchmark programmet. Superposition benytter sig af en helt ny grafikmotor, imponerende ray-tracing i DirectX 12. Mens benchmark programmet kører, flyttes der rundt på 900 meget detaljerede objekter og derfor er superposition en utrolig krævende benchmark.

Opsummering af benchmarks

Med undtagelse af nogle få resultater er AORUS 2080 Ti langt det hurtigste kort vi har testet. Med det sagt hænger sidste generations GTX 1080 Ti godt med i mange benchmarks og er godt 20% langsommere end storebror. Nogle af vores resultater lugter lidt af manglende driveroptimeringer, (Se Tomb Raider 2016). Derudover begrænser den ellers overclockede 6600K også hastigheden i flere tests.

Med et fabriksoverclocket 2080 Ti, som dette AORUS Xtreme, får du ikke flere heste under hjelmen.

Overclocking:

På trods af at kortet er fabriksoverclocket, er der stadig performance at trække ud af kortet. Dog ramte jeg en mur ved alt over 1935 MHz, som fik hele systemet til at fryse. Derudover bliver blæserstøjen ved dette overclock også for meget. Vil du virkelig overclocke et topkort som dette, er custom vandkøling vejen frem. Som altid sammenligner jeg clockhastighederne som kortet faktisk kører under load. Den maximale clockhastighed ved mit overclock var 2010 MHz.

På trods af at kortet er fabriksoverclocket, er der stadig performance at trække ud af kortet. Dog ramte jeg en mur ved alt over 1935 MHz, som fik hele systemet til at fryse. Derudover bliver blæserstøjen ved dette overclock også for meget. Vil du virkelig overclocke et topkort som dette, er custom vandkøling vejen frem. Som altid sammenligner jeg clockhastighederne som kortet faktisk kører under load. Den maximale clockhastighed ved mit overclock var 2010 MHz.

GPU: Overclocket fra 1770 MHz til 1935 MHz (Faktisk Boost Hastighed under vedvarende load)

RAM: Overclocket fra 1803 MHz til 1890 MHz

Dette bliver et overclock på 9,3% på GPU'en og 4,8% på RAM, lad os så se på, hvad det gør:

Varme:

Idle temperatuen er målt ude på skrivebordet uden nogen programmer kørende. Load temperaturen er taget med Heaven Benchmark. Jeg har fravalgt FurMark, fordi nogle NVIDIA kort clocker ned i dette program og derfor giver forkerte resultater.

AORUS kortet er noget varmere end jeg forventede. Med en load temperatur på 83 grader bliver kortet overraskende varmt. Støjniveauet er gennemsnitligt, og mens det ikke direkte larmer havde jeg håbet på bedre.

AORUS kortet er noget varmere end jeg forventede. Med en load temperatur på 83 grader bliver kortet overraskende varmt. Støjniveauet er gennemsnitligt, og mens det ikke direkte larmer havde jeg håbet på bedre.

Måske er den nye TU102 chip bare svær at køle, men imponerende er disse tal ikke.

Strømforbrug:

Nedenstående målinger gælder for hele systemet eksklusiv skærm højttalere mv. og måles fra kontakten og ikke efter strømforsyningen.

Idle målingen er foretaget på skrivebordet uden programmer åbnet. Load testen er foretaget i Heaven Benchmark med højeste grafikindstilling. Peak målingen er det højeste strømforbrug noteret under testen.

Som ventet er strømforbruget meget højt. Vi når ikke det overclock orienterede MSI Lightning kort fra sidste generation, men sammenlignet med GIGABYTEs eget AORUS 1080 Ti, er forbruget steget 43 watt eller godt 12 %.

Som ventet er strømforbruget meget højt. Vi når ikke det overclock orienterede MSI Lightning kort fra sidste generation, men sammenlignet med GIGABYTEs eget AORUS 1080 Ti, er forbruget steget 43 watt eller godt 12 %.