Test: ASUS EAH4870X2 GDDR5

Grafikkort, AMD/ATI d. 05. september. 2008, skrevet af Emillos 22 Kommentarer. Vist: 21297 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: ASUS

DK distributør: Rosenmeier

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: ASUS

DK distributør: Rosenmeier

#1

Kanon go' gennemført test 😀

Der er dog et problem med CoD4 grafen - den passer vist ikke ind.

Der er dog et problem med CoD4 grafen - den passer vist ikke ind.

#2

Hovsa - det var vidst en gammel graf, der lå og lurede. Den er skiftet ud nu. 🙂

#3

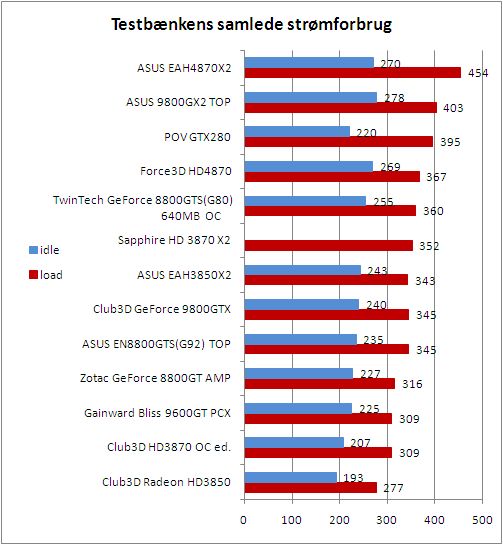

Lækkert at se, at 9800GX2 stadig følger godt med, HD4870X2 er ikke SÅ ondt igen 🙂

#4

kan godt være det bare er mig, men ud fra de fleste af spil-graferne, så ser det jo ud som om at nvidia tæsker amd's nye kort 😐 men alligevel bliver det rost i konklusionen. eller er det bare mig der trænger til nye briller ? 😛

#3 You got a point imo. 😉

#6

4# det kommer jo and på om spilet er glad for CF man kan jo lave en test kun med spil som ikke kan lig cf og spil der kan så få man 2 rasultater så det kommer and på hvad man spiler om vilket kort man skal have 🙂

#7

#5

Jep, denne test sammenholdt med testen på Tweakup.dk giver det billede, at 9800GX2 stadig er helt i top, og så bliver jeg jo bare endnu mere glad for, at jeg ikke har udskiftet det 😀

Jep, denne test sammenholdt med testen på Tweakup.dk giver det billede, at 9800GX2 stadig er helt i top, og så bliver jeg jo bare endnu mere glad for, at jeg ikke har udskiftet det 😀

#8

Det her er det første review, jeg har læst, hvor hd 4870x2 ikke massakrerer alt. Men hey, det fortæller måske noget om multi-gpu setups generelt :).

#9

4870x2 begynder også for alvor at vise muskler ved høje opløsninger - men tror størstedelen spiller ikke ved 2560x1600?

#10

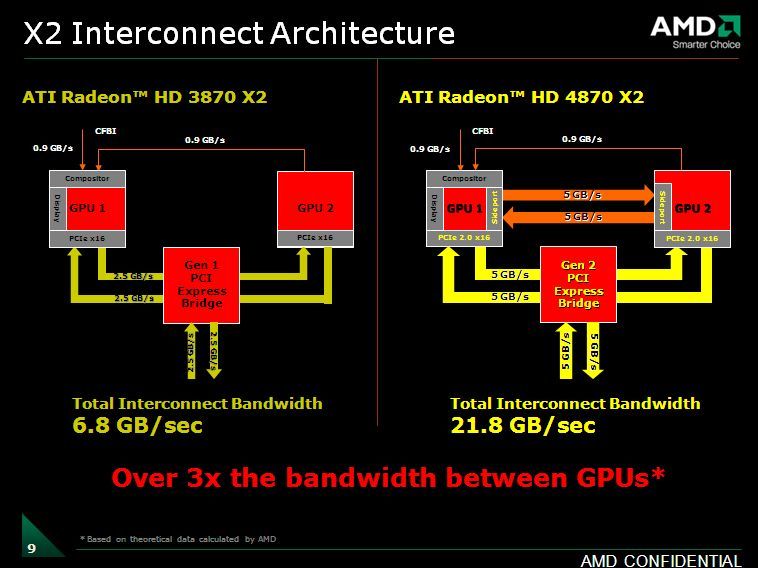

Jeg synes nu (uden at skamrose) at Emillos flere gange i testen piontere at potentialet så sandelig findes i HD4870x2, men Crossfire understøttelsen er simplethen ikke på højde med SLi i kompabilitet endnu - derfor finder man at Hd4870x2 ryger op og ned af skalaen.

Men når det er sagt, så passer det også fint med det jeg har "prædiket" vedr. mine oplevelser med HD4870x2 vs 9800GX2 og hvor det endte med at HD4870x2 kom retur. Det er et superkort - men de ting der skal gøre det superb halter lidt. Det er bedre end sidste forsøg med HD3870x2, men stadig ikke helt godt nok.

Men når det er sagt, så passer det også fint med det jeg har "prædiket" vedr. mine oplevelser med HD4870x2 vs 9800GX2 og hvor det endte med at HD4870x2 kom retur. Det er et superkort - men de ting der skal gøre det superb halter lidt. Det er bedre end sidste forsøg med HD3870x2, men stadig ikke helt godt nok.

#11

Det irritere mig virkelig at det er testet på en 22" skærm!

Det kort viser virkelig sin styrke i 1920x1200 med AA og AF!! :no: 😕

Det kort viser virkelig sin styrke i 1920x1200 med AA og AF!! :no: 😕

#12

Vi har desværre ikke en 24" skærm liggende.

Ja, kortet er bedre ift. konkurrenterne, des højere opløsninger og AA/AF man smider efter det. Men vi er nød til, at teste med de midler vi har. :yes:

Endvidere er det min vurdering, at de fleste sidder med en 21-22" skærm.

#10 got the point. 🙂

Ja, kortet er bedre ift. konkurrenterne, des højere opløsninger og AA/AF man smider efter det. Men vi er nød til, at teste med de midler vi har. :yes:

Endvidere er det min vurdering, at de fleste sidder med en 21-22" skærm.

#10 got the point. 🙂

#13

Jeg spiller selv i 1920x1200 og som Overbuary siger så er det virkelig der man kan se forskellen.

#14

#0

rigtig god og gennemført test. Godt at se at du har fået en god håndfuld spil og benchmarks med. Det manglede godt nok i en af de sidste gfx tests med kun 3 spil. Det var sgu for ringe.

Men godt gået Emillos 🙂

rigtig god og gennemført test. Godt at se at du har fået en god håndfuld spil og benchmarks med. Det manglede godt nok i en af de sidste gfx tests med kun 3 spil. Det var sgu for ringe.

Men godt gået Emillos 🙂

#15

Hvis de nye spil der er på vej understøtter crossfire ordentligt smadrer dette kort nvidia fuldstændigt på ydensen.

#16

Kunne nu godt tænke mig at se hvordan det performer mod GTX260 i SLI. De ligger jo i omtrent samme prisleje, og så er det multi-gpu vs. multi-gpu. Desuden synes jeg at kunne forstå, at ingen quad-SLI/CF løsninger virker ordentligt, så der er ingen pointe i at smide et ekstra 4870X2 i en maskine? Så ville man osse vide om det kunne betale sig, at købe et 4870X2, hvis man sidder ned et SLI-board.

#17

->#16

GTX260 havde jeg desværre ikke liggende, at teste kortet op imod. Og skulle jeg teste SLi, skulle jeg jo også skifte bundkort mv.

Men nej, jeg vil mene, at 4 GPU'er i et setup, aldrig er pengene værd. Det er kun hvis man går ekstremt meget op i benchmarking, at det for alvor giver noget, efter min mening.

Jeg prøvede faktisk at køre 2 HD4870X2 sammen, på mit X38-baserede bundkort. Desværre fik jeg det aldrig op at køre, trods jeg har kørt CrossFireX på det før. Der har været forlydener om, at nogle bundkort har problemer med lige HD4870X2 i CrossFireX.

GTX260 havde jeg desværre ikke liggende, at teste kortet op imod. Og skulle jeg teste SLi, skulle jeg jo også skifte bundkort mv.

Men nej, jeg vil mene, at 4 GPU'er i et setup, aldrig er pengene værd. Det er kun hvis man går ekstremt meget op i benchmarking, at det for alvor giver noget, efter min mening.

Jeg prøvede faktisk at køre 2 HD4870X2 sammen, på mit X38-baserede bundkort. Desværre fik jeg det aldrig op at køre, trods jeg har kørt CrossFireX på det før. Der har været forlydener om, at nogle bundkort har problemer med lige HD4870X2 i CrossFireX.

#18

Utrolig god test Emil ❤ - nok den bedste du har skrevet 😳

#19

Ja, flot og godt skrevet test. Dog savnes der spil baseret på OpenGL, Quake 4 f.eks?

Lige et tillægsspm. Du skriver, at din testPC kører Vista Ultimate 32 bits og at du har 2x2 Gb ram i denne PC. Hvor meget ram kan Windows rent faktisk bruge af dine 4 Gb, når også grafikkortet har 2 Gb?

Man kunne måske få dig til lige at vise et screenshot af Video memory watcher (gratis program), for at se fordelingen af ramforbruget under heftig grafisk aktivitet?

(se eksempel her:

)

Se nærmere beskrivelse af programmet her: http://forums.legitreviews.com...

Lige et tillægsspm. Du skriver, at din testPC kører Vista Ultimate 32 bits og at du har 2x2 Gb ram i denne PC. Hvor meget ram kan Windows rent faktisk bruge af dine 4 Gb, når også grafikkortet har 2 Gb?

Man kunne måske få dig til lige at vise et screenshot af Video memory watcher (gratis program), for at se fordelingen af ramforbruget under heftig grafisk aktivitet?

(se eksempel her:

)

Se nærmere beskrivelse af programmet her: http://forums.legitreviews.com...

#20

->#19

Jeg plejer at teste i PREY, men det er droppet, da jeg mener det er forældet. Når FPS er på omkring 3-400, synes jeg det er ret irellevant. Quake 4 er en meget fin ide - det skal jeg helt bestemt overveje. 🙂

Mht. den reelle udnyttelse af RAM, er jeg faktisk ikke sikker - jeg tror det er 3GB af systemrammene der udnyttes, grundet måden grafikkortets ram bliver benyttet - men det kan også være 2GB.

Dog burde det ikke gøre nogen forskel mht. benchmarking, da 4GB ram kontra 2GB mest af alt gør en forskel i minimum FPS - men ikke det store gennemsnitligt.

Jeg har dog overvejet, at gå over til Vista64 snart, grundet problematiken med de store Rambuffere på nutidens og de kommende grafikkort. :yes:

Fedt program i øvrigt.

Jeg plejer at teste i PREY, men det er droppet, da jeg mener det er forældet. Når FPS er på omkring 3-400, synes jeg det er ret irellevant. Quake 4 er en meget fin ide - det skal jeg helt bestemt overveje. 🙂

Mht. den reelle udnyttelse af RAM, er jeg faktisk ikke sikker - jeg tror det er 3GB af systemrammene der udnyttes, grundet måden grafikkortets ram bliver benyttet - men det kan også være 2GB.

Dog burde det ikke gøre nogen forskel mht. benchmarking, da 4GB ram kontra 2GB mest af alt gør en forskel i minimum FPS - men ikke det store gennemsnitligt.

Jeg har dog overvejet, at gå over til Vista64 snart, grundet problematiken med de store Rambuffere på nutidens og de kommende grafikkort. :yes:

Fedt program i øvrigt.

#21

Nu er kortets ydelse snart gennemtestet i forskellige fora. Dejligt kort.

Men....synes ikke jeg har set nogle sammenligningsgrafer for støjen (og egentligt også varme), hvilke alle test alligevel prioriterer.

Jeg kunne rigtig godt tænkte mig at vide hvor meget kortet støjer mere end andre. Især sammenlignet med mit gamle 8800gtx. Nogen der netop har denne erfaring/udskiftning?????

Er lidt bekymret for støjniveauet, men kan alligevel leve med en del, så jer der har et kort skriv lige hvor voldsomt det egentligt er, please....

Men....synes ikke jeg har set nogle sammenligningsgrafer for støjen (og egentligt også varme), hvilke alle test alligevel prioriterer.

Jeg kunne rigtig godt tænkte mig at vide hvor meget kortet støjer mere end andre. Især sammenlignet med mit gamle 8800gtx. Nogen der netop har denne erfaring/udskiftning?????

Er lidt bekymret for støjniveauet, men kan alligevel leve med en del, så jer der har et kort skriv lige hvor voldsomt det egentligt er, please....

#22

->#21

Jeg lavede i sin tid støjgrafer udfra støjmålinger, foretaget med mikrofon, samt lavede støjvideoer. Støjmålinger angivet på grafer er dog en sjov størrelse, da det er lidt svært at bedømme støj udfra en graf.

Videoerne er egentlig meget rare at have, men de var rimelig tidskrævende at lave, og jeg havde ikke indtrykket af, at folk rent faktisk brugte dem.

Og skal de laves rigtig godt, skulle jeg køre med en bordopstilling, så man kunne filme fra den rigtige vinkel - men det kræver så, at jeg skal pille mit hardware ud af kabinettet hele tiden.

Men er det noget folk efterspørger, skal jeg da overveje at begynde at lave dem igen? 🙂

Jeg lavede i sin tid støjgrafer udfra støjmålinger, foretaget med mikrofon, samt lavede støjvideoer. Støjmålinger angivet på grafer er dog en sjov størrelse, da det er lidt svært at bedømme støj udfra en graf.

Videoerne er egentlig meget rare at have, men de var rimelig tidskrævende at lave, og jeg havde ikke indtrykket af, at folk rent faktisk brugte dem.

Og skal de laves rigtig godt, skulle jeg køre med en bordopstilling, så man kunne filme fra den rigtige vinkel - men det kræver så, at jeg skal pille mit hardware ud af kabinettet hele tiden.

Men er det noget folk efterspørger, skal jeg da overveje at begynde at lave dem igen? 🙂