Test: HiS HD5970

Grafikkort, AMD/ATI d. 30. december. 2009, skrevet af WinterSilence 41 Kommentarer. Vist: 15897 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: HIS

DK distributør: HIS

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: HIS

DK distributør: HIS

#1

Hvor kan det købes, vil have 2

#2

Kig på edbpriser, det er ikke ret mange steder kortet er en lagervare, hvis nogen overhovedet har det, så det er bare at bestille et sted og vente..

Du vil i øvrigt ikke rigtig få noget ud af at have to kort, da et længe er nok til at klare stort set alt, OC hellere din cpu som vil være flaskehals uanset og hent noget ydelse der.

Svaret blev redigeret 1 gang, sidst af noxon d. 30-12-2009 10:30:44.

Du vil i øvrigt ikke rigtig få noget ud af at have to kort, da et længe er nok til at klare stort set alt, OC hellere din cpu som vil være flaskehals uanset og hent noget ydelse der.

Svaret blev redigeret 1 gang, sidst af noxon d. 30-12-2009 10:30:44.

#3

#0

Udmærket test, dog synes jeg stadig at i mangler en Crysis benchmark, eller Modern Warfare, men måske er det bare en smagssag? 🙂

Udmærket test, dog synes jeg stadig at i mangler en Crysis benchmark, eller Modern Warfare, men måske er det bare en smagssag? 🙂

#4

Synes også at hvis det skal være helt rigtig, så skal PPU slås fra i 3DMark test 😐

#5

#4

PPU hvad er det ???...

PPU hvad er det ???...

#7

Synes der mangler forrige generations topkort, som også var et dualkort.

#8

#4

Helt enig, ingen grund til at grafikkortet skal beregne den ene CPU test for så at give en latterlig høj CPU score, hvilket så ikke giver et ordentlig sammenligning for selve 3D testen...

Helt enig, ingen grund til at grafikkortet skal beregne den ene CPU test for så at give en latterlig høj CPU score, hvilket så ikke giver et ordentlig sammenligning for selve 3D testen...

#9

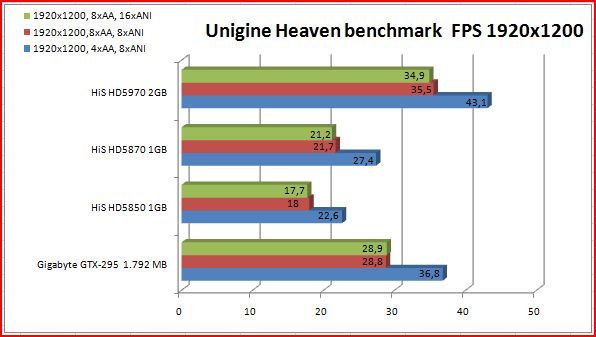

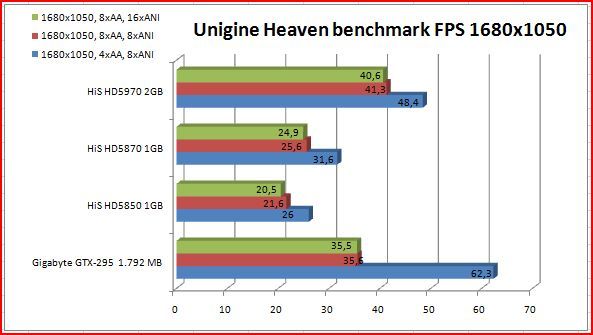

Windows Vista m. SP2 understøtter Direct X 11 API'en, so hvorfor kun køre Unigine Heaven under windows 7 ?

Anyhow fin anmeldelse. Kunne dog godt have tænkt mit Crysis, Far Cry 2 eller. Resident Evil V benchmark med inde over.

Nåh men jeg glæder mig vildt til at få mit TriFire setup op og køre ASAP (PowerColor HD5970 & XFX HD5850 Black Edition (725@765mhz,4000@4500mhz)) .. så skal der bare spilles MW2.

Anyhow fin anmeldelse. Kunne dog godt have tænkt mit Crysis, Far Cry 2 eller. Resident Evil V benchmark med inde over.

Nåh men jeg glæder mig vildt til at få mit TriFire setup op og køre ASAP (PowerColor HD5970 & XFX HD5850 Black Edition (725@765mhz,4000@4500mhz)) .. så skal der bare spilles MW2.

#10

Diverse svar:

Heaven kørt på Windows 7 fordi den kategorisk går ned i Vista hele tiden.

Crysis udgået fordi vi ofte har mange problemer med, at få den til at virke - jeg har ikke brugt den i et halvt år.

De andre kan vi måske overveje, men så er der så bare intet referencegrundlag, at sammenligne med.

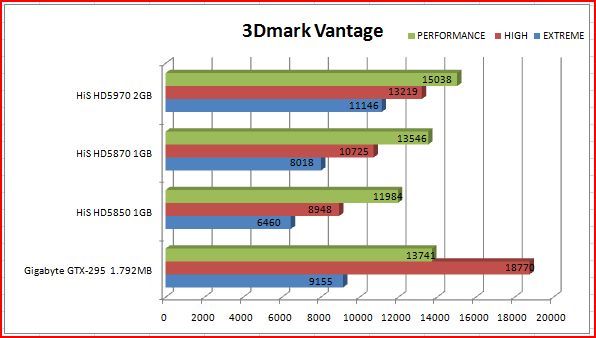

PPU-diskussion har vi haft før og den gider jeg ikke gentage. Men da mange ofter klager over jeg kører med PPU ON så tester jeg rent faktisk også kortene med det slået fra. Og for at illusterere hvor irrrelevant det egentlig kan være, så er resultaterne for HiS HD5970 2GB sådan hér:

3DMark Vantage Extreme: X11146 PPU = ON

3DMark Vantage Extreme: X11319 PPU = OFF

Forskel: 173 points i mest relevante deltest af 3DMark Vantage - derved langt indenfor rammerne på ca. 2.5-3% afvigelse.

Godt Nytår til Jer alle! 😀

Heaven kørt på Windows 7 fordi den kategorisk går ned i Vista hele tiden.

Crysis udgået fordi vi ofte har mange problemer med, at få den til at virke - jeg har ikke brugt den i et halvt år.

De andre kan vi måske overveje, men så er der så bare intet referencegrundlag, at sammenligne med.

PPU-diskussion har vi haft før og den gider jeg ikke gentage. Men da mange ofter klager over jeg kører med PPU ON så tester jeg rent faktisk også kortene med det slået fra. Og for at illusterere hvor irrrelevant det egentlig kan være, så er resultaterne for HiS HD5970 2GB sådan hér:

3DMark Vantage Extreme: X11146 PPU = ON

3DMark Vantage Extreme: X11319 PPU = OFF

Forskel: 173 points i mest relevante deltest af 3DMark Vantage - derved langt indenfor rammerne på ca. 2.5-3% afvigelse.

Godt Nytår til Jer alle! 😀

#11

#10 Det med PPU slået fra var nu heller ikke for at sammenligne ATI tests...

Det var nu med hensyn til den store forskel mellem nVidia og ATI i Vantage 😉

Svaret blev redigeret 1 gang, sidst af Micks d. 30-12-2009 19:36:59.

Det var nu med hensyn til den store forskel mellem nVidia og ATI i Vantage 😉

Svaret blev redigeret 1 gang, sidst af Micks d. 30-12-2009 19:36:59.

#12

lækkert at have 2 af dette kort :D

#13

#11 vil du så også stoppe DX11 test på 5850 og op, for de så kan du jo heller ikke sammenligne dem med Nvidia da de jo kun kan køre DX 10 🤡

Jeg er også træt af at høre om PPU m.m.

kort skal testes med alt det de er bygget til og så skal de ha hele armen, så stop det der tøsetudefjæs.

Der ud over må i ha et godt nyt år.

Jeg er også træt af at høre om PPU m.m.

kort skal testes med alt det de er bygget til og så skal de ha hele armen, så stop det der tøsetudefjæs.

Der ud over må i ha et godt nyt år.

#14

#13 Hvorfor tror du at f. eks en side som Guru3D ikke godtager testscores der indeholder PPU aktiveret - Netop fordi det ikke er sammenligneligt.

Derfor ville det heller ikke være rimeligt f.eks at lave en sammenligning af de forskellige kort på tværs af DX versioner, da nogle kort ikke kan være med i DX11.

De rigtige tests til de rigtige kort og lad folk bedømme på tværs af tests.

Skal kort testes med det de er bygget til skal et ATI kort da nemlig IKKE testes på physx - dette er jo ikke sagligt iorden... ikke i min bog ihvertfald.

På samme måde skal nVidia ikke testes i DX11 da det ikke ville være rimeligt - dette kan ske når Fermi engang kommer.

Tøsetudefjæs ?? Fedt at se en mand på 42 kaste med mudder øøeehh og spejl til dig mester 🤡

Derfor ville det heller ikke være rimeligt f.eks at lave en sammenligning af de forskellige kort på tværs af DX versioner, da nogle kort ikke kan være med i DX11.

De rigtige tests til de rigtige kort og lad folk bedømme på tværs af tests.

Skal kort testes med det de er bygget til skal et ATI kort da nemlig IKKE testes på physx - dette er jo ikke sagligt iorden... ikke i min bog ihvertfald.

På samme måde skal nVidia ikke testes i DX11 da det ikke ville være rimeligt - dette kan ske når Fermi engang kommer.

Tøsetudefjæs ?? Fedt at se en mand på 42 kaste med mudder øøeehh og spejl til dig mester 🤡

#15

Har forslag til rettelse i den engelske oversættelse:

"...However the noise under OC with the fan/cooler set to max. performance is intolerable. And here we talk "real vaccumer noise". My girlfriend walke out and went to herself and I thought of using my noise supressor hearing guards that I use for 6.5x55/.22 rifle and 9mm pistol shooting, normally"

Skal dette sidste stykke af "Performance" ikke klippes og sættes ind oppe ved Design/Layout. Og lige tilføje på engelsk at "Performance" karakteren landede på 3.

🙂

"...However the noise under OC with the fan/cooler set to max. performance is intolerable. And here we talk "real vaccumer noise". My girlfriend walke out and went to herself and I thought of using my noise supressor hearing guards that I use for 6.5x55/.22 rifle and 9mm pistol shooting, normally"

Skal dette sidste stykke af "Performance" ikke klippes og sættes ind oppe ved Design/Layout. Og lige tilføje på engelsk at "Performance" karakteren landede på 3.

🙂

#16

#14 du skal sku da ikke fortælle mig at hvis du vil køre flere spil der kræver PPU at du så gør ud og køber et ATI kort bare fordi på rå basis køre bedre end Nvdia.

Hvis jeg har en formodning om at de næste 10 spil vil være til DX11, så køber jeg sku ikke et Nvidia og du skal heller ikke fortælle mig at hvis du sider med et Nvidia kort at du så har slået ppu'ern fra, svarer lidt til at man køber en Amerikaner V8'er og så hiver 4 tendrør ud af motoren bare for at sammen ligne den med en Fiat Uno, nu stopper du. 🤡

Desuden kan du jo bare hoppe over på Guru3D, hvis du syntes deres test er så meget bedre.

Hvis jeg har en formodning om at de næste 10 spil vil være til DX11, så køber jeg sku ikke et Nvidia og du skal heller ikke fortælle mig at hvis du sider med et Nvidia kort at du så har slået ppu'ern fra, svarer lidt til at man køber en Amerikaner V8'er og så hiver 4 tendrør ud af motoren bare for at sammen ligne den med en Fiat Uno, nu stopper du. 🤡

Desuden kan du jo bare hoppe over på Guru3D, hvis du syntes deres test er så meget bedre.

#17

#16 Tror ikke på du er 42...

HWT og Guru3D er et godt mix for mig.

Dine sammenligningsgrundlag KAN simpelthen bare ikke komme fra en der er 42 - så har du været umådelig heldig at blive så gammel (du kunne jo gå hen og glemme at trække vejret).

Du lyder jo som en der lige er startet på teknisk skole og ikke ved om du skal starte som frisør eller mekaniker 🤡

Men skal vi derud hvor du bimler rundt bornholmer, så lad os da se nogle sammenligningstests med DX11 - der ville ATI jorde nVidia FULDSTÆNDIGT fordi der har ATI 28 tÆndrør mere end nVidia 🤡 wwooaaahh v8 - muskelbiler og alt det der 🤣

Svaret blev redigeret 4 gange, sidst af Micks d. 31-12-2009 13:44:39.

HWT og Guru3D er et godt mix for mig.

Dine sammenligningsgrundlag KAN simpelthen bare ikke komme fra en der er 42 - så har du været umådelig heldig at blive så gammel (du kunne jo gå hen og glemme at trække vejret).

Du lyder jo som en der lige er startet på teknisk skole og ikke ved om du skal starte som frisør eller mekaniker 🤡

Men skal vi derud hvor du bimler rundt bornholmer, så lad os da se nogle sammenligningstests med DX11 - der ville ATI jorde nVidia FULDSTÆNDIGT fordi der har ATI 28 tÆndrør mere end nVidia 🤡 wwooaaahh v8 - muskelbiler og alt det der 🤣

Svaret blev redigeret 4 gange, sidst af Micks d. 31-12-2009 13:44:39.

#18

hehe godt nytår. sygt kort. nasty.. noget nyt om næste generation egentligt `? syntes der stod noget om 2010 medd noget nyt. hmm.. spændende denne udvikling ihvertfaldet, måske priserne snart kommer ned i en 2000 kr så man kan være med., hehe, 🙂 thumbs up!! fed test

#19

#16

"og du skal heller ikke fortælle mig at hvis du sider med et Nvidia kort at du så har slået ppu'ern fra, svarer lidt til at man køber en Amerikaner V8'er og så hiver 4 tendrør ud af motoren"

Med al respekt er det jo derfor at wankermark bør tages med et gran salt.

Hele pointen er, at med et single NV kort og brug af Physx, er det en ulempe (lavere FPS), da kortet ikke kan bruge 100% på spillets grafik og skal context switche. (Det sammer gælder til en mindre grad dual GPU grafikkort, men da det er svært at udnytte en GPU 100%, så er problemet mindre udtalt her.)

Den ulempe ser du dog aldrig i Wankermark; her vil resultatet blive langt højere/bedre end for en 100% tilsvarende GPU, som dog ikke understøtter Physx, da CPU/fysik-testen er ISOLERET og derfor ser man aldrig problemet!

...så din analogi svarer mere til at man bruger to cylindre på physx, og kun seks bruges på grafik i stedet for 8. 🙂

Dertil kommer at physx kun er en fordel når der skal beregnes fysik for absurd mange objekter - de fleste multikernede CPU´er gør et fint og tilstrækkeligt job, da spillets udviklere nok nødigt vil bruge tiden på physx eller skærer ATI folkene fra.

Og endeligt: hvor mange spil understøtter Physx?

Mvh. Scheea (som har et NV grafikkort 😛)

Svaret blev redigeret 2 gange, sidst af scheea2000 d. 31-12-2009 13:07:17.

"og du skal heller ikke fortælle mig at hvis du sider med et Nvidia kort at du så har slået ppu'ern fra, svarer lidt til at man køber en Amerikaner V8'er og så hiver 4 tendrør ud af motoren"

Med al respekt er det jo derfor at wankermark bør tages med et gran salt.

Hele pointen er, at med et single NV kort og brug af Physx, er det en ulempe (lavere FPS), da kortet ikke kan bruge 100% på spillets grafik og skal context switche. (Det sammer gælder til en mindre grad dual GPU grafikkort, men da det er svært at udnytte en GPU 100%, så er problemet mindre udtalt her.)

Den ulempe ser du dog aldrig i Wankermark; her vil resultatet blive langt højere/bedre end for en 100% tilsvarende GPU, som dog ikke understøtter Physx, da CPU/fysik-testen er ISOLERET og derfor ser man aldrig problemet!

...så din analogi svarer mere til at man bruger to cylindre på physx, og kun seks bruges på grafik i stedet for 8. 🙂

Dertil kommer at physx kun er en fordel når der skal beregnes fysik for absurd mange objekter - de fleste multikernede CPU´er gør et fint og tilstrækkeligt job, da spillets udviklere nok nødigt vil bruge tiden på physx eller skærer ATI folkene fra.

Og endeligt: hvor mange spil understøtter Physx?

Mvh. Scheea (som har et NV grafikkort 😛)

Svaret blev redigeret 2 gange, sidst af scheea2000 d. 31-12-2009 13:07:17.

#20

#19: Og endeligt: hvor mange spil understøtter Physx?

Flere end du nok lige regner med. Det er ihvertfald 50+ 😉

Flere end du nok lige regner med. Det er ihvertfald 50+ 😉

#21

#19 Der står i din profil at du er 3D udvikler, så burde du også bare af interesse have fundet ud af, at det efterhånden er sværere at finde et spil, der ikke understøtter Physx...

#22

Er det denne overdådige liste af top AAA spil, som I indirekte refererer til?

http://www.nzone.com/object/nz...

Altså bare lige for at få det rene og så jeg ikke træder nogle fanboys over tærerne:

jeg mener ikke at Physx er en dårlig idé eller at det ikke i nogle tilfælde kan lave nogle virkelig fede effekter, som ellers har været umulige på CPU´en.

Jeg kommenterede udelukkensde på physx vs. Vantage, som imo giver et forkert billede af ydelsen.

mvh. Scheea 🙂

http://www.nzone.com/object/nz...

Altså bare lige for at få det rene og så jeg ikke træder nogle fanboys over tærerne:

jeg mener ikke at Physx er en dårlig idé eller at det ikke i nogle tilfælde kan lave nogle virkelig fede effekter, som ellers har været umulige på CPU´en.

Jeg kommenterede udelukkensde på physx vs. Vantage, som imo giver et forkert billede af ydelsen.

mvh. Scheea 🙂

#23

den diskussion kunne satme da hurtigt løses:

lav en test i dx10 og 11, så man kan se forskellen, og lav en med ppu on og en med den off, så bliver ingen snydt, og man kan sammenligne ydelserne........så svært er det sq heller ikke.

lav en test i dx10 og 11, så man kan se forskellen, og lav en med ppu on og en med den off, så bliver ingen snydt, og man kan sammenligne ydelserne........så svært er det sq heller ikke.

#24

#23 That's what I'm talking about 😀

#25

#23 hvilket spil vil du foreslå?

#26

#25

Unigine Heaven benchmark som er DX11 og 3DMark Vantage

Unigine Heaven benchmark som er DX11 og 3DMark Vantage

#27

#9 Gripen90:

Vi er ved at evaluere, om Resident Evil V benchmark skal indgå i testsuiten udfra dit udemærkede input 🙂

Vi er ved at evaluere, om Resident Evil V benchmark skal indgå i testsuiten udfra dit udemærkede input 🙂

#28

Jeg kan virkelig godt lide hvordan AMDs reklamemateriale er reproduceret/oversat her, fuldstændigt ukritisk og ubehandlet. Jeg kan fremhæve ting som:

"Og som det ses, har AMD fordoblet brugernes værdi per dollar/krone de sidste år" der tilføjes et uskyldigt "iflg. deres egne data" på trods af at skribenten tydligvis sælger det videre som gode varer med "Og som det ses, har...".

"HD5970 er verdens absolut hurtigste dual-GPU, single-PCB grafikkort med DirectX 11 kompatibilitet og 40nm procesteknologi". Hvilket vel ikke er så svært hvis man er den eneste, dette kan selvfølgelig bare være et eksempel på manglende copy editing, skribenten hensigt var muligvis at sige noget ala: "Det er verdens hurtigste dual-gpu grafikkort. Som derudover også..." men det er langt fra det der bliver sagt.

"Nedenfor hér ses AMD/ATI's "roadmap"/plan for den kommende serie af Radeon HD 5000 grafikkort". Og det får man så, hverken mere eller mindre, ikke engang en forklaring kan det blive til.

"skærmopløsninger på 2560x1600, i hele 24 megapixels High Definiton opløsning". Her går det først helt galt, 24 megapixel hvad for noget? Er det en skærm eller et kamera vi snakker om? Popordene kommer galt i halsen på vores skribent, og han glemmer at checke sine tal, 2560*1600 giver så vidt vides ikke 24 nogetsomhelst. Og hvad er en High Definition opløsning nu? Hvis det er 720p eller endda 1080p så har vi da skudt noget under målet, men irrelevante floskler er jo kærkomne hos alle marketingafdelinger og kan åbenbart fint blive regurgiteret af HwT.

"en markant reducering i antallet af trekanter/triangles og polygoner, hvilket muliggør en højere billedkvalitet". Ehm... Hvad? Sikkert ganske fin reproducering af et eller andet salgsmateriale, men det giver ingen mening, en reduktion af polygoner kan aldrig give bedre kvalitet, det kan fint give bedre performance, men kvalitet? Den må vores kære skribent vist hellere forklare.

"AMD har rent faktisk overskredet Moores lov" "og det er faktisk lidt af en bedrift". ??? Øhmm, en IT skribent der ikke kender Moores lov? Om ikke andet så ihvertfald yderst pinligt! Moores lov siger mere eller mindre: Antallet af transistorer som man på økonomisk vis kan lægge på en IC fordobles ca. hvert andet år. Hvilket inden for mange IT relaterede ting betyder at der også der er en eksponentiel vækst (så som CPU hastighed, RAM kapacitet etc.). Den fine graf som AMD har, illustrerer meget fint at dette også gælder inden for GPU'er; der er en eksponentiel vækst i FLOPS.

"fremtidssikret langt frem i tiden." Øh? En IT skribent der ikke har lagt mærke til at INTET i IT verdenen er "fremtidssikret langt frem i tiden." for slet ikke at nævne de næste 6 måneder.

"og her fremgår det at der klart er meget, at vinde ved at benytte DirectX 11". Klart, my foot! Hvad er der at vinde? Hvad er fordelen for mig ved at der er tesselation i DX11, og hvilke fordele er der ved SM5? Og DirectCompute 11? Hvad med HDR texture tingen? Informer dog lidt istedet for bare at regurgitere. Det lyder vitterligt som: "Jamen, det har et højere versionsnummer så det er da klart bedre!", Yeah right, som vista's klare overlegenhed over XP, n'est-ce pas?

"vil angiveligt tilbyde slutbrugeren 240% mere ydelse gennemsnitligt". I forhold til hvad? Ja, jeg kan godt selv læse grafen, men kan skribenten? Og hvis vi kan bruge producentens egne benchs til noget som helst, hvad skal vi så med HwT?

"Her er en række billeder der illustrerer"... Hvordan jeg har copy pastet?

Hele den laaange sektion om "Innovation / Teknologi" kunne IMHO sagtens være erstattet af et direkte link til noget HiS/AMD salgsmateriale.

Der er da vist også brug for lidt copy editing! Jeg kan fremhæve guldklumper som:

"...bedst ydende teknologi lagt fast.",

"kontinuerligt og vedholdende konstant skiftet til nye typer teknologier" (der er yderst ekstremt komplet virkelig mange sætninger af denne type).

"kodenavn Hemlock - der betyder Skarntyde på engelsk!" Kommer på hvad? Side 4 - Specifikationer, efter det er blevet nævnt, hvad, 50 gange?

"er kortet dog rent ulideligt" dudez!

Og så vil jeg råde læseren til at tage en dyb indånding inden denne:

"Rent fotografisk er det lykkedes, at lave fokus på og gengive en del, af den enorme køleprofil - der er udført i rent kobberi bunddelen og aluminium i topdelen - der udgør hovedkernen i det AMD/ATI kalder for "Vapour Chamber" - der oversat til forståeligt dansk betyder "dampkammer" - altså det sted varmen skal mikses med den koldere luft der blæses igennem dette." P.S. Du sagde forståeligt dansk; dampkammer? Damp? Really?

Og så alle de kære "idiotkommaer"; altså ", at", hvis ikke man kan bekoste en korrekturlæser, så lær dog i det mindste skribenterne den gamle læresætning "Der skal være komma foran 'at', når der IKKE kommer et udsagnsord efter." Så slipper vi da i det mindste for 90% af disse fejl. Se evt. http://sproget.dk/raad-og-regl... (Jeg har sikkert begået en masse grammatiske fejl i denne kommentar, men jeg prøver heller ikke på at være en seriøs publikation).

"den ene GPU monteret spejlvendt af den anden - hvorfor vides ikke" Kæphøj much? I ved det måske ikke, men det er jo ikke ensbetydende med at ingen ved det. Jeg ville foreksempel formode at det er for at have så korte I/O paths som muligt/lige lange I/O paths. Da path length er begyndt at blive signifikant i forhold til GPU/IO/Memory clock.

"strømforsyningen/PSU'en", "default/standard" Julemanden/Santa Claus'en?

"placeret i toppen af kortet, bagerst så..."

"Længden på kortet er hele 31 CM (knap 4-5 CM længere end HD4870X2 og GTX-295).

Her skal man hæfte sig meget ved længden af kortet" Det er altså ikke her man skal hæfte sig meget ved vægten? Pudsigt.

Puha Midten af side 5, nu må det være nok.

Men hvis man skal kunne tage dette seriøst, mangler der, set fra mit synspunkt, helt klart en masse kritisk distance, og en ordentlig editoriel indsats.

P.S. Da de færreste danskere kan håndtere kritik, constructive or otherwise, er dette skrevet af anonyme Bob.

"Og som det ses, har AMD fordoblet brugernes værdi per dollar/krone de sidste år" der tilføjes et uskyldigt "iflg. deres egne data" på trods af at skribenten tydligvis sælger det videre som gode varer med "Og som det ses, har...".

"HD5970 er verdens absolut hurtigste dual-GPU, single-PCB grafikkort med DirectX 11 kompatibilitet og 40nm procesteknologi". Hvilket vel ikke er så svært hvis man er den eneste, dette kan selvfølgelig bare være et eksempel på manglende copy editing, skribenten hensigt var muligvis at sige noget ala: "Det er verdens hurtigste dual-gpu grafikkort. Som derudover også..." men det er langt fra det der bliver sagt.

"Nedenfor hér ses AMD/ATI's "roadmap"/plan for den kommende serie af Radeon HD 5000 grafikkort". Og det får man så, hverken mere eller mindre, ikke engang en forklaring kan det blive til.

"skærmopløsninger på 2560x1600, i hele 24 megapixels High Definiton opløsning". Her går det først helt galt, 24 megapixel hvad for noget? Er det en skærm eller et kamera vi snakker om? Popordene kommer galt i halsen på vores skribent, og han glemmer at checke sine tal, 2560*1600 giver så vidt vides ikke 24 nogetsomhelst. Og hvad er en High Definition opløsning nu? Hvis det er 720p eller endda 1080p så har vi da skudt noget under målet, men irrelevante floskler er jo kærkomne hos alle marketingafdelinger og kan åbenbart fint blive regurgiteret af HwT.

"en markant reducering i antallet af trekanter/triangles og polygoner, hvilket muliggør en højere billedkvalitet". Ehm... Hvad? Sikkert ganske fin reproducering af et eller andet salgsmateriale, men det giver ingen mening, en reduktion af polygoner kan aldrig give bedre kvalitet, det kan fint give bedre performance, men kvalitet? Den må vores kære skribent vist hellere forklare.

"AMD har rent faktisk overskredet Moores lov" "og det er faktisk lidt af en bedrift". ??? Øhmm, en IT skribent der ikke kender Moores lov? Om ikke andet så ihvertfald yderst pinligt! Moores lov siger mere eller mindre: Antallet af transistorer som man på økonomisk vis kan lægge på en IC fordobles ca. hvert andet år. Hvilket inden for mange IT relaterede ting betyder at der også der er en eksponentiel vækst (så som CPU hastighed, RAM kapacitet etc.). Den fine graf som AMD har, illustrerer meget fint at dette også gælder inden for GPU'er; der er en eksponentiel vækst i FLOPS.

"fremtidssikret langt frem i tiden." Øh? En IT skribent der ikke har lagt mærke til at INTET i IT verdenen er "fremtidssikret langt frem i tiden." for slet ikke at nævne de næste 6 måneder.

"og her fremgår det at der klart er meget, at vinde ved at benytte DirectX 11". Klart, my foot! Hvad er der at vinde? Hvad er fordelen for mig ved at der er tesselation i DX11, og hvilke fordele er der ved SM5? Og DirectCompute 11? Hvad med HDR texture tingen? Informer dog lidt istedet for bare at regurgitere. Det lyder vitterligt som: "Jamen, det har et højere versionsnummer så det er da klart bedre!", Yeah right, som vista's klare overlegenhed over XP, n'est-ce pas?

"vil angiveligt tilbyde slutbrugeren 240% mere ydelse gennemsnitligt". I forhold til hvad? Ja, jeg kan godt selv læse grafen, men kan skribenten? Og hvis vi kan bruge producentens egne benchs til noget som helst, hvad skal vi så med HwT?

"Her er en række billeder der illustrerer"... Hvordan jeg har copy pastet?

Hele den laaange sektion om "Innovation / Teknologi" kunne IMHO sagtens være erstattet af et direkte link til noget HiS/AMD salgsmateriale.

Der er da vist også brug for lidt copy editing! Jeg kan fremhæve guldklumper som:

"...bedst ydende teknologi lagt fast.",

"kontinuerligt og vedholdende konstant skiftet til nye typer teknologier" (der er yderst ekstremt komplet virkelig mange sætninger af denne type).

"kodenavn Hemlock - der betyder Skarntyde på engelsk!" Kommer på hvad? Side 4 - Specifikationer, efter det er blevet nævnt, hvad, 50 gange?

"er kortet dog rent ulideligt" dudez!

Og så vil jeg råde læseren til at tage en dyb indånding inden denne:

"Rent fotografisk er det lykkedes, at lave fokus på og gengive en del, af den enorme køleprofil - der er udført i rent kobberi bunddelen og aluminium i topdelen - der udgør hovedkernen i det AMD/ATI kalder for "Vapour Chamber" - der oversat til forståeligt dansk betyder "dampkammer" - altså det sted varmen skal mikses med den koldere luft der blæses igennem dette." P.S. Du sagde forståeligt dansk; dampkammer? Damp? Really?

Og så alle de kære "idiotkommaer"; altså ", at", hvis ikke man kan bekoste en korrekturlæser, så lær dog i det mindste skribenterne den gamle læresætning "Der skal være komma foran 'at', når der IKKE kommer et udsagnsord efter." Så slipper vi da i det mindste for 90% af disse fejl. Se evt. http://sproget.dk/raad-og-regl... (Jeg har sikkert begået en masse grammatiske fejl i denne kommentar, men jeg prøver heller ikke på at være en seriøs publikation).

"den ene GPU monteret spejlvendt af den anden - hvorfor vides ikke" Kæphøj much? I ved det måske ikke, men det er jo ikke ensbetydende med at ingen ved det. Jeg ville foreksempel formode at det er for at have så korte I/O paths som muligt/lige lange I/O paths. Da path length er begyndt at blive signifikant i forhold til GPU/IO/Memory clock.

"strømforsyningen/PSU'en", "default/standard" Julemanden/Santa Claus'en?

"placeret i toppen af kortet, bagerst så..."

"Længden på kortet er hele 31 CM (knap 4-5 CM længere end HD4870X2 og GTX-295).

Her skal man hæfte sig meget ved længden af kortet" Det er altså ikke her man skal hæfte sig meget ved vægten? Pudsigt.

Puha Midten af side 5, nu må det være nok.

Men hvis man skal kunne tage dette seriøst, mangler der, set fra mit synspunkt, helt klart en masse kritisk distance, og en ordentlig editoriel indsats.

P.S. Da de færreste danskere kan håndtere kritik, constructive or otherwise, er dette skrevet af anonyme Bob.

#29

Puha sikke da en smøre 😩

Jeg svarer ikke på skribentens vegne, men vil nu alligevel kommenterer lidt på din kritik.

Formuleringer kan vi altid snakke om og jeg er også ligeglad med alle de andre flueknep som kommafejl, dobbeltbenævnelser, hvornår benævnelser er nævnt, og det faktum at du ikke engang tør stå ved din egen kritik. 😕

"Her går det først helt galt, 24 megapixel hvad for noget? Er det en skærm eller et kamera vi snakker om?"

En pixel er vel en pixel og en million eller 1024^2 af dem er en MegaPixel uanset om det er en skærm eller et kamera.

Igen ingen er ufejlbarlige - og slet ikke vi - så det hænder jo engang imellem at der mangler lidt ord, så betydningen kan ændre sig, men jeg synes, at det er åbenlyst for alle som kender lidt til ATI's 5-serie, at skribenten snakker om EyeFinity, så man kan slutte 3 højopløste skærme til grafikkortet, hvilket giver total set 24 MP's skærmopløsning.

Ehm... Hvad? Sikkert ganske fin reproducering af et eller andet salgsmateriale, men det giver ingen mening, en reduktion af polygoner kan aldrig give bedre kvalitet, det kan fint give bedre performance, men kvalitet?

Det virker som om du ved hvad du snakker om - og så ikke alligevel. For du ved vel at han snakker om de nye tesselation-muligheder i dx11, så antallet af polygoner i en højpoly (højere end normalt) model reduceres løbende, så modellen effektivt kan renderes - altså bedre kvalitet og performance. Og nej, kvaliteten reduceres ikke nødvendigvis, når man reducerer antallet af polygoner, hvis man gør det intelligent - fx i forhold til afstanden fra modellen til kameraet, store 'flade' overflader eller for polygoner, som ikke giver en visuel forskel i billedet.

Og selv hvis det var ren performance, så kunne det jo gøre at man kunne skrue på nogle kvalitetsparametre andre steder.

"Da de færreste danskere kan håndtere kritik, constructive or otherwise, er dette skrevet af anonyme Bob"

....øøh...helle på træet? 😛

Mvh. Scheea 🙂

Svaret blev redigeret 1 gang, sidst af scheea2000 d. 04-01-2010 21:48:30.

Jeg svarer ikke på skribentens vegne, men vil nu alligevel kommenterer lidt på din kritik.

Formuleringer kan vi altid snakke om og jeg er også ligeglad med alle de andre flueknep som kommafejl, dobbeltbenævnelser, hvornår benævnelser er nævnt, og det faktum at du ikke engang tør stå ved din egen kritik. 😕

"Her går det først helt galt, 24 megapixel hvad for noget? Er det en skærm eller et kamera vi snakker om?"

En pixel er vel en pixel og en million eller 1024^2 af dem er en MegaPixel uanset om det er en skærm eller et kamera.

Igen ingen er ufejlbarlige - og slet ikke vi - så det hænder jo engang imellem at der mangler lidt ord, så betydningen kan ændre sig, men jeg synes, at det er åbenlyst for alle som kender lidt til ATI's 5-serie, at skribenten snakker om EyeFinity, så man kan slutte 3 højopløste skærme til grafikkortet, hvilket giver total set 24 MP's skærmopløsning.

Ehm... Hvad? Sikkert ganske fin reproducering af et eller andet salgsmateriale, men det giver ingen mening, en reduktion af polygoner kan aldrig give bedre kvalitet, det kan fint give bedre performance, men kvalitet?

Det virker som om du ved hvad du snakker om - og så ikke alligevel. For du ved vel at han snakker om de nye tesselation-muligheder i dx11, så antallet af polygoner i en højpoly (højere end normalt) model reduceres løbende, så modellen effektivt kan renderes - altså bedre kvalitet og performance. Og nej, kvaliteten reduceres ikke nødvendigvis, når man reducerer antallet af polygoner, hvis man gør det intelligent - fx i forhold til afstanden fra modellen til kameraet, store 'flade' overflader eller for polygoner, som ikke giver en visuel forskel i billedet.

Og selv hvis det var ren performance, så kunne det jo gøre at man kunne skrue på nogle kvalitetsparametre andre steder.

"Da de færreste danskere kan håndtere kritik, constructive or otherwise, er dette skrevet af anonyme Bob"

....øøh...helle på træet? 😛

Mvh. Scheea 🙂

Svaret blev redigeret 1 gang, sidst af scheea2000 d. 04-01-2010 21:48:30.

#30

Og tjek lige fubar2 for anden IP adresse 😎

Førstegangs poster og sådan en smøre - lige til at blive mistænkt for dobbeltprofil (det samme som små nosser og ikke at kunne stå ved en sådan smørre med sin rigtige profil) :yes:

Førstegangs poster og sådan en smøre - lige til at blive mistænkt for dobbeltprofil (det samme som små nosser og ikke at kunne stå ved en sådan smørre med sin rigtige profil) :yes:

#31

well det skriver han jo også direkte 🙂

#32

Hej Scheea

Hermed mine forhåbentligt ikke helt vidensforladte svar på dine kommentarer.

"så antallet af polygoner i en højpoly (højere end normalt) model reduceres løbende, så modellen effektivt kan renderes - altså bedre kvalitet og performance."

Du har renderet den "effektivt" (ifølge dine egne ord) og slutter derfor at dens kvalitet er højere? Det var da noget af en non sequitur. Du har renderet en model med færre polygoner ergo med mindre information, mindre detalje, altså kan den objektive kvalitet udelukkende være dårligere. At du og jeg så ville have svært ved at se forskel, er noget helt andet, kvaliteten er IKKE blevet bedre.

"Og nej, kvaliteten reduceres ikke nødvendigvis, når man reducerer antallet af polygoner, hvis man gør det intelligent - fx i forhold til afstanden fra modellen til kameraet, store 'flade' overflader eller for polygoner, som ikke giver en visuel forskel i billedet. "

Den objektive kvalitet vil reduceres, den subjektive vil muligvis ikke. Den reducerende algoritme vil aldrig blive lige så god som selve rendering algoritmen (så ville man jo bare bruge den) ergo vil du have et kvalitetstab.

Det kan da godt være at det er pissefedt, og fanboys vil sidde og flå sig selv i bananen over det i flere timer, det ændrer bare ikke på den faktuelle fejl, som derfra hvor jeg sidder, ser ud til at være opstået fordi der har været stor hast med at forfatte noget uden rigtigt at forstå hvad det drejer sig om. Som så heller ikke har været igennem nogen som helst form for redaktionelt filter. Polygon reduktion = Performance gain IKKE kvalitetsgain, lige gyldigt hvor meget du gerne vil rædde en eller anden forskruet idé om ære.

"Og selv hvis det var ren performance, så kunne det jo gøre at man kunne skrue på nogle kvalitetsparametre andre steder." Ja okay, men så lad os da lede med lys og lygte efter den logiske slutning. Hvis noget er designet til at give bedre performance, så er det det den velinformerede/researchede vil nævne ikke at det via bagvejen så også kan give noget andet...

"En pixel er vel en pixel" Ja da "og en million eller 1024^2 er vel af dem er en MegaPixel" Skal vi sige en million? Lad os det da termen "megapixel" helt klart er en marketing (og marketing afdelingen har stadig ikke forstået hvad bit er for noget) floskel som er blevet opfundet til digital kameraerne, derfor min klare skepsis overfor at indføre dette lamme, tamme floskel ord i IT verdenen (og mindre på en teknisk orienteret side). Og endnu engang, hvordan kommer du frem til de 24 megapixel? Det kan godt være at nogle marketing hoveder kan sige "vi lægger da bare alle skærmenes opløsning sammen" (Eller kamera producenten siger "den kan tage 24 billeder rigtigt hurtigt efter hindanden lad os da lægge deres opløsning sammen så de bliver 100 megapixel!!!) men der er det jo så at jeg ville mene at en IT skribent ville være lidt mere kritisk end bare at reproducere sådan noge mundgejl verbatim. N.B. 2560x1600x3 giver stadig ikke 24 "megapixels".

Postdata: Jeg har det helt fint med størrelsen på alt hvad jeg har mellem benene, på trods af den debatniveauløftende mudderkastning og "namecalling", der nærmest nødvendigvis følger af enhver kritik, især her på vort kære internet...Ærgeligt at vi ikke er mødtes på gaden, så kunne man bare slå mig ned (og sparke mig i hovedet når nu jeg lå ned) og glemme alt om den hæslige kritik den vemmelige lille person havde at komme med.

Hermed mine forhåbentligt ikke helt vidensforladte svar på dine kommentarer.

"så antallet af polygoner i en højpoly (højere end normalt) model reduceres løbende, så modellen effektivt kan renderes - altså bedre kvalitet og performance."

Du har renderet den "effektivt" (ifølge dine egne ord) og slutter derfor at dens kvalitet er højere? Det var da noget af en non sequitur. Du har renderet en model med færre polygoner ergo med mindre information, mindre detalje, altså kan den objektive kvalitet udelukkende være dårligere. At du og jeg så ville have svært ved at se forskel, er noget helt andet, kvaliteten er IKKE blevet bedre.

"Og nej, kvaliteten reduceres ikke nødvendigvis, når man reducerer antallet af polygoner, hvis man gør det intelligent - fx i forhold til afstanden fra modellen til kameraet, store 'flade' overflader eller for polygoner, som ikke giver en visuel forskel i billedet. "

Den objektive kvalitet vil reduceres, den subjektive vil muligvis ikke. Den reducerende algoritme vil aldrig blive lige så god som selve rendering algoritmen (så ville man jo bare bruge den) ergo vil du have et kvalitetstab.

Det kan da godt være at det er pissefedt, og fanboys vil sidde og flå sig selv i bananen over det i flere timer, det ændrer bare ikke på den faktuelle fejl, som derfra hvor jeg sidder, ser ud til at være opstået fordi der har været stor hast med at forfatte noget uden rigtigt at forstå hvad det drejer sig om. Som så heller ikke har været igennem nogen som helst form for redaktionelt filter. Polygon reduktion = Performance gain IKKE kvalitetsgain, lige gyldigt hvor meget du gerne vil rædde en eller anden forskruet idé om ære.

"Og selv hvis det var ren performance, så kunne det jo gøre at man kunne skrue på nogle kvalitetsparametre andre steder." Ja okay, men så lad os da lede med lys og lygte efter den logiske slutning. Hvis noget er designet til at give bedre performance, så er det det den velinformerede/researchede vil nævne ikke at det via bagvejen så også kan give noget andet...

"En pixel er vel en pixel" Ja da "og en million eller 1024^2 er vel af dem er en MegaPixel" Skal vi sige en million? Lad os det da termen "megapixel" helt klart er en marketing (og marketing afdelingen har stadig ikke forstået hvad bit er for noget) floskel som er blevet opfundet til digital kameraerne, derfor min klare skepsis overfor at indføre dette lamme, tamme floskel ord i IT verdenen (og mindre på en teknisk orienteret side). Og endnu engang, hvordan kommer du frem til de 24 megapixel? Det kan godt være at nogle marketing hoveder kan sige "vi lægger da bare alle skærmenes opløsning sammen" (Eller kamera producenten siger "den kan tage 24 billeder rigtigt hurtigt efter hindanden lad os da lægge deres opløsning sammen så de bliver 100 megapixel!!!) men der er det jo så at jeg ville mene at en IT skribent ville være lidt mere kritisk end bare at reproducere sådan noge mundgejl verbatim. N.B. 2560x1600x3 giver stadig ikke 24 "megapixels".

Postdata: Jeg har det helt fint med størrelsen på alt hvad jeg har mellem benene, på trods af den debatniveauløftende mudderkastning og "namecalling", der nærmest nødvendigvis følger af enhver kritik, især her på vort kære internet...Ærgeligt at vi ikke er mødtes på gaden, så kunne man bare slå mig ned (og sparke mig i hovedet når nu jeg lå ned) og glemme alt om den hæslige kritik den vemmelige lille person havde at komme med.

#33

Nå ja, nu er det jo også HELT det samme som at slå på folk og sparke dem når de ligger ned - undskyld men nu må jeg sgu grine lidt 🤣

Offerrollen blev bare lige påduttet dig (jeg hører en meget lille violin i baggrunden her).

Men du påråbte dig altså kritikken af din person og dit indlæg da du valgte at kritisere "anonymt"

Havde du nu valgt at kritisere og stå ved dine udtalelser, så havde du pr automatik fået en DEL mere respekt fra min side af.

Da dette ikke er tilfældet + at du nu selv synes det er synd for dig... ja så hæver du ikke niveauet for min mening om dig (som du sikkert også er ligeglad med alligevel 😛 )

Jeg synes stadig du har små nosser 🤣

Svaret blev redigeret 1 gang, sidst af Micks d. 05-01-2010 06:01:39.

Offerrollen blev bare lige påduttet dig (jeg hører en meget lille violin i baggrunden her).

Men du påråbte dig altså kritikken af din person og dit indlæg da du valgte at kritisere "anonymt"

Havde du nu valgt at kritisere og stå ved dine udtalelser, så havde du pr automatik fået en DEL mere respekt fra min side af.

Da dette ikke er tilfældet + at du nu selv synes det er synd for dig... ja så hæver du ikke niveauet for min mening om dig (som du sikkert også er ligeglad med alligevel 😛 )

Jeg synes stadig du har små nosser 🤣

Svaret blev redigeret 1 gang, sidst af Micks d. 05-01-2010 06:01:39.

#34

Nå sidste indlæg fra mig - det er allerede way off topic

"Du har renderet den "effektivt" (ifølge dine egne ord) og slutter derfor at dens kvalitet er højere?"

Ja læs hvad jeg skriver.

Lad mig pensle det lidt mere ud for dig med et simpelt, forenklet eksempel:

Tag en model - lad os sige et træ - med 30.000 vertices. Du har 4 træer i scenen. Et træ tæt på kameraet og tre langt væk fra kameraet.

Hvis du intelligent og meget effektivt kan reducere antallet af polygoner, så træerne der er langt væk, har få polygoner (lad os sige 3000 vertices - bemærk ingen 'kvalitetstab' da objektet er 'lille'), mens træer, der er tæt på har alle 30.000 vertices, så har du reduceret det samlede antal polygoner, der skal renderes til 39.000 polygoner - uden kvalitetstab.

Hvis du ikke havde den mekanisme (LoD), og grafikkortet eksempelvis kun havde tid til at rendere 40.000 vertices, så kunne dine træer kun bestå af 10.000 vertices - altså dårligere kvalitet, men næsten samme renderingstidsforbrug.

Tesselation mulighederne er så lidt mere indviklet. Du kan bl.a. 'kunstigt' eller vha. textures (mig bekendt) tilføje polygondetaljer til en ellers lowpoly model, igen: højne kvaliteten med et minimum af performance impact.

Jeg håber beskrivelsen er så lidt fanboy og marketingssnak-agtigt, så din hjerne ikke går helt i kludder halvvejs. 😛

Nu har tesselation intet med ATI at gøre (bortset fra det har været igennem marketingsmølllen hos ATI), men det har noget med DirectX API´et at gøre.

Det kan da godt være at det er pissefedt, og fanboys vil sidde og flå sig selv i bananen over det i flere timer

Flot formuleret, men folk glemmer nogle gange, at Directx ikke er til for brugerene (jo i sidste ende), men det er til for udviklerne. DirectX 10, men også DirectX 11 byder i den grad på nogle svært lækre 'værktøjer' for spiludviklere - Tesselationmulighederne er bare én af dem.

Subjektiv vs. objektiv kvalitet? Hvornår har vi nogensinde været interesseret i 'objektivt' kvalitet?!?!?! 😕 Hvis du vidste hvor meget spiludviklere og computer grafik prøver at snyde dit øje, så kunne du jo ikke lavet andet end at pointere at det er ikke kvalitetsmæssigt forsvarligt - objektivt set. 🤣

Mht. megapixels diskussion, så er begrebet jo validt nok - fordi kameraproducenterne misbruger det ændrer det jo ikke på at 24 megapixels er en pæn, spiselig fremstilling af opløsningen 7680 x 3200.

Jeg synes skam du har store nosser. Bare ærgeligt at dine programmørnosser ikke tør stå ved sine troll-agtige kritik...

Hvis der er mere du er i tvivl, så skal jeg se om jeg kan hjælpe, men lad os tage det i en anden tråd eller pm. 🙂

Og sidst: Du går meget op i, at du tror, at vi nu synes at du er en meget væmmelig person. Det lader jeg stå ukommenteret... 😉

Men tak for nogle fornøjelige indlæg 🙂

Mvh. Scheea 🙂

Svaret blev redigeret 2 gange, sidst af scheea2000 d. 05-01-2010 09:39:48.

"Du har renderet den "effektivt" (ifølge dine egne ord) og slutter derfor at dens kvalitet er højere?"

Ja læs hvad jeg skriver.

Lad mig pensle det lidt mere ud for dig med et simpelt, forenklet eksempel:

Tag en model - lad os sige et træ - med 30.000 vertices. Du har 4 træer i scenen. Et træ tæt på kameraet og tre langt væk fra kameraet.

Hvis du intelligent og meget effektivt kan reducere antallet af polygoner, så træerne der er langt væk, har få polygoner (lad os sige 3000 vertices - bemærk ingen 'kvalitetstab' da objektet er 'lille'), mens træer, der er tæt på har alle 30.000 vertices, så har du reduceret det samlede antal polygoner, der skal renderes til 39.000 polygoner - uden kvalitetstab.

Hvis du ikke havde den mekanisme (LoD), og grafikkortet eksempelvis kun havde tid til at rendere 40.000 vertices, så kunne dine træer kun bestå af 10.000 vertices - altså dårligere kvalitet, men næsten samme renderingstidsforbrug.

Tesselation mulighederne er så lidt mere indviklet. Du kan bl.a. 'kunstigt' eller vha. textures (mig bekendt) tilføje polygondetaljer til en ellers lowpoly model, igen: højne kvaliteten med et minimum af performance impact.

Jeg håber beskrivelsen er så lidt fanboy og marketingssnak-agtigt, så din hjerne ikke går helt i kludder halvvejs. 😛

Nu har tesselation intet med ATI at gøre (bortset fra det har været igennem marketingsmølllen hos ATI), men det har noget med DirectX API´et at gøre.

Det kan da godt være at det er pissefedt, og fanboys vil sidde og flå sig selv i bananen over det i flere timer

Flot formuleret, men folk glemmer nogle gange, at Directx ikke er til for brugerene (jo i sidste ende), men det er til for udviklerne. DirectX 10, men også DirectX 11 byder i den grad på nogle svært lækre 'værktøjer' for spiludviklere - Tesselationmulighederne er bare én af dem.

Subjektiv vs. objektiv kvalitet? Hvornår har vi nogensinde været interesseret i 'objektivt' kvalitet?!?!?! 😕 Hvis du vidste hvor meget spiludviklere og computer grafik prøver at snyde dit øje, så kunne du jo ikke lavet andet end at pointere at det er ikke kvalitetsmæssigt forsvarligt - objektivt set. 🤣

Mht. megapixels diskussion, så er begrebet jo validt nok - fordi kameraproducenterne misbruger det ændrer det jo ikke på at 24 megapixels er en pæn, spiselig fremstilling af opløsningen 7680 x 3200.

Jeg synes skam du har store nosser. Bare ærgeligt at dine programmørnosser ikke tør stå ved sine troll-agtige kritik...

Hvis der er mere du er i tvivl, så skal jeg se om jeg kan hjælpe, men lad os tage det i en anden tråd eller pm. 🙂

Og sidst: Du går meget op i, at du tror, at vi nu synes at du er en meget væmmelig person. Det lader jeg stå ukommenteret... 😉

Men tak for nogle fornøjelige indlæg 🙂

Mvh. Scheea 🙂

Svaret blev redigeret 2 gange, sidst af scheea2000 d. 05-01-2010 09:39:48.

#35

Hej Scheea

Jeg vil påpege min originale konklusion for ikke at drifte for meget off-topic (kritik af artiklen er vel on-topic i tråden om artiklen?) der mangler kritisk distance fra skribenten, marketing termer bliver copy pasted uden overvejelse (så som megapixel), og ingen del af artiklen er røget igennem nogen form for redaktionel behandling, end ikke korrekturlæsning. Alt dette ville jeg sige nok var 90% redaktionelt og 10% skribent. At skribenten så ikke ved hvad en polygon er...

Hvis man så vil forsvare skribentens tekniske kunnen / validiteten af hans udsagn, så er det jo fint nok og den kan vi tage andetsteds... men du starter 😛

Med hensyn til tesselation: Det er klart at det at frigøre GPU tid kan give bedre kvalitet. Det kan det at køre med hurtigere RAM også. Det har bare ikke noget med min kritik af artiklen at gøre, min kritik gik på at der stod: lavere trekant og polygon (ja både og!) tal -> bedre kvalitet. Og det er jo så lige modsat virkeligheden. Altså den generaliserede version som skribenten tilslutter sig, at et lavere poly count vil, logisk set, føre til bedre kvalitet. Og hvis du vil forsvare det, har jeg en rigtig fin trekant du kan klistre på din skærm, som du så kan kalde HiS Ultra-Poly-Redux-Engine og sige det er top-dollar 3d grafik-kvalitet (Green version, som bruger 0watt!).

"bortset fra det har været igennem marketingsmølllen hos ATI" Ja, og det er "afmøllificeringen" som jeg venter af en IT publikation, ellers kunne jeg som sagt bare læse marketing materialet.

"men det er til for udviklerne" (De har da openGL 😛) Nu er det så næppe udviklerne denne artikel er skrevet for?

"prøver at snyde dit øje" enough said. (hvor LoD er et super eksempel på hvor meget de kan fejle, det kan da godt være at tesselation er guds næste komme, men det nævner skribenten intet om, han nævner ikke engang at det er tessalation han mener da han siger at lavere poly count=bedre kvalitet)

"24 megapixels er en pæn, spiselig fremstilling af opløsningen 7680 x 3200." Joda, du ville jo sikkert også svare "1.3 megapixel" hvis der var nogen der spurgte hvilken opløsning din skærm kørte med og du kørte 1280*1024, ikke? At least, don't BS me.

Jeg vil påpege min originale konklusion for ikke at drifte for meget off-topic (kritik af artiklen er vel on-topic i tråden om artiklen?) der mangler kritisk distance fra skribenten, marketing termer bliver copy pasted uden overvejelse (så som megapixel), og ingen del af artiklen er røget igennem nogen form for redaktionel behandling, end ikke korrekturlæsning. Alt dette ville jeg sige nok var 90% redaktionelt og 10% skribent. At skribenten så ikke ved hvad en polygon er...

Hvis man så vil forsvare skribentens tekniske kunnen / validiteten af hans udsagn, så er det jo fint nok og den kan vi tage andetsteds... men du starter 😛

Med hensyn til tesselation: Det er klart at det at frigøre GPU tid kan give bedre kvalitet. Det kan det at køre med hurtigere RAM også. Det har bare ikke noget med min kritik af artiklen at gøre, min kritik gik på at der stod: lavere trekant og polygon (ja både og!) tal -> bedre kvalitet. Og det er jo så lige modsat virkeligheden. Altså den generaliserede version som skribenten tilslutter sig, at et lavere poly count vil, logisk set, føre til bedre kvalitet. Og hvis du vil forsvare det, har jeg en rigtig fin trekant du kan klistre på din skærm, som du så kan kalde HiS Ultra-Poly-Redux-Engine og sige det er top-dollar 3d grafik-kvalitet (Green version, som bruger 0watt!).

"bortset fra det har været igennem marketingsmølllen hos ATI" Ja, og det er "afmøllificeringen" som jeg venter af en IT publikation, ellers kunne jeg som sagt bare læse marketing materialet.

"men det er til for udviklerne" (De har da openGL 😛) Nu er det så næppe udviklerne denne artikel er skrevet for?

"prøver at snyde dit øje" enough said. (hvor LoD er et super eksempel på hvor meget de kan fejle, det kan da godt være at tesselation er guds næste komme, men det nævner skribenten intet om, han nævner ikke engang at det er tessalation han mener da han siger at lavere poly count=bedre kvalitet)

"24 megapixels er en pæn, spiselig fremstilling af opløsningen 7680 x 3200." Joda, du ville jo sikkert også svare "1.3 megapixel" hvis der var nogen der spurgte hvilken opløsning din skærm kørte med og du kørte 1280*1024, ikke? At least, don't BS me.

#36

""men det er til for udviklerne" (De har da openGL smile) Nu er det så næppe udviklerne denne artikel er skrevet for? "

Netop! - og derfor bruger vi ikke 'spalteplads' på at ævle alt for meget om trekanter, LoD, Tesselation, Geometry eller Compute-shaders eller kvalitetsperception for den sags skyld.

Igen: vi er frivillige på sitet, bestemt ikke journalist-uddannet, ikke alle kan være lige uddannet/vidende i alt - slet ikke i denne branche, så fejl og mistolkninger kan forekomme, men det er bestemt tilladt at tænke selv (men det kræver måske en brugerprofil (for du har jo en på hol, ikke? 🤣))

Mvh. Scheea 🙂

Netop! - og derfor bruger vi ikke 'spalteplads' på at ævle alt for meget om trekanter, LoD, Tesselation, Geometry eller Compute-shaders eller kvalitetsperception for den sags skyld.

Igen: vi er frivillige på sitet, bestemt ikke journalist-uddannet, ikke alle kan være lige uddannet/vidende i alt - slet ikke i denne branche, så fejl og mistolkninger kan forekomme, men det er bestemt tilladt at tænke selv (men det kræver måske en brugerprofil (for du har jo en på hol, ikke? 🤣))

Mvh. Scheea 🙂

#37

Jeg vil så også lige sige, at hvis i har det fint med sådanne publikationer på jeres hjemmeside, så er det da honky-dory, det er bare fuldstændigt umuligt for mig at tage det seriøst, jeg fik tilsendt et link til denne artikel, læste den, og følte så jeg burde sige min ærlige mening. Hvis det kan bruges til noget, så er det fint, jeg mener man relativt nemt kunne højne niveauet af en sådan artikel, jeg er sikker på at skribenten kunne skrive mere informerende. Hvis en anden læste artiklen med en kritisk tilgang (som jeg gjorde ved anden, halve gennemlæsning) så ville det ikke være svært at finde faldgruberne og få ham til at redigere dem. Årsagen til at jeg nævner ting som kommaer er at der er så mange grammatiske og ortografiske fejl at det er tydeligt at man ikke engang har læst korrektur på artiklen, hvilket gør det blændende tydeligt at der ingen redaktionel process har været. Jeg vil også vove at påstå at enhver skribent lynhurtigt vil blive meget doven hvis han ved at hans artikler går direct to print...

#38

"men det er bestemt tilladt at tænke selv (men det kræver måske en brugerprofil (for du har jo en på hol, ikke?"

Jo at tænke selv er fint...

Det ville være så dejligt nemt at kunne feje enhver kritik væk på den måde; "Nååå men han er jo bare en xxx fra yyy konkurerende site"

xxx kan du så erstatte med hvad du vil, troll, hater, idiot, ballless, &c.

og hvis jeg var inde i verdenen med hardware ting så kunne jeg også give dig en liste med hw sites (nu kender jeg desværre kun toms hardware og anand, og de er vel ikke direkte konkurenter? Men jeg vil da lige benytte lejligheden til at anbefale begge)

P.S. Nu gik jeg så ind på hol for at se om det så var supergodt, men der er der da vist ikke publiceret noget i lang tid (siden 2k7!)!?

Svaret blev redigeret 1 gang, sidst af fubar2 d. 05-01-2010 11:21:51.

Jo at tænke selv er fint...

Det ville være så dejligt nemt at kunne feje enhver kritik væk på den måde; "Nååå men han er jo bare en xxx fra yyy konkurerende site"

xxx kan du så erstatte med hvad du vil, troll, hater, idiot, ballless, &c.

og hvis jeg var inde i verdenen med hardware ting så kunne jeg også give dig en liste med hw sites (nu kender jeg desværre kun toms hardware og anand, og de er vel ikke direkte konkurenter? Men jeg vil da lige benytte lejligheden til at anbefale begge)

P.S. Nu gik jeg så ind på hol for at se om det så var supergodt, men der er der da vist ikke publiceret noget i lang tid (siden 2k7!)!?

Svaret blev redigeret 1 gang, sidst af fubar2 d. 05-01-2010 11:21:51.

#39

Det er 1. gang jeg har set MJensen lave så lange indlæg. 😀

PS.: I vælger selv! 😛

Svaret blev redigeret 1 gang, sidst af bornholm d. 05-01-2010 16:06:15.

PS.: I vælger selv! 😛

Svaret blev redigeret 1 gang, sidst af bornholm d. 05-01-2010 16:06:15.

#40

ved ikke om jeg er en gennemsnitlig bruger her på sitet, men nej hvor har jeg nydt jeres lange slagsmål her i tråden, for på trods af rettelserne i kritikken, ved langt de fleste nok hvad der bliver skrevet om i artiklen, og noget helt korrekt ville muligvis forvirre mere end det gavner.....men underholdning har det bestemt givet......

#41

"men nej hvor har jeg nydt jeres lange slagsmål her i tråden"

Velbekommen... 😳 😛

Velbekommen... 😳 😛

![[G.N.U.]](/images/users/profile/36302.jpg)