Test: Asus 9800GX2 TOP QuadSLI

Grafikkort, NVIDIA d. 06. juni. 2008, skrevet af JacobHL 12 Kommentarer. Vist: 13260 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: ASUS

DK distributør: Hasee.dk

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: ASUS

DK distributør: Hasee.dk

#1

Utroligt det ikke giver mere i spil. Er det mon cpu begrænset? Skal man op i en 8´kernet 4ghz cpu før det tæsker igennem i spil.

#edit# jacob, du har vel ikke prøvet med mere end 3.2ghz på cpu´en med quad sli vel?

#edit# jacob, du har vel ikke prøvet med mere end 3.2ghz på cpu´en med quad sli vel?

#2

Så vidt huskes, skal man op i højere opløsninger før et af de gfx's for alvor bider fra sig, og med to skal man formentlig endnu længere op. Selv ikke i 16x10 tror jeg at man kan se noget reelt, da cpu'en stadig nemt bliver en for begrænsende faktor. Vi skal imo op over 19x12 før det for alvor giver mening.

Men der ud over: Man ser rundt omkring på nettet at folk har gevaldigt bøvl med quad sli, så enten er driverne ikke gode nok endnu, eller også er fire kerner bare for meget pt.

Men der ud over: Man ser rundt omkring på nettet at folk har gevaldigt bøvl med quad sli, så enten er driverne ikke gode nok endnu, eller også er fire kerner bare for meget pt.

#3

Når nu en at der for en skribent er så store problemer med at få det til at virke, så giver det da slet ikke nogen mening for andre at prøve sådan som verden ser ud i øjeblikket.

Det skulle da kun være hvis man har købt alt hvad der findes af hw ellers og samtidig har en 30" dell

Det skulle da kun være hvis man har købt alt hvad der findes af hw ellers og samtidig har en 30" dell

#4

#3 skribenter er jo ikke nødvendigvis bedre end dig 😉 alle kan jo opleve driver fuck up osv... 🙂

#0 synd du fik så mange problemer, dog vil jeg gerne påpege igen at med så meget GPU kræft kan man ikke regne med en cpu der ikke render hurtigere kan føde dem nok 😉

og som nævnt før, opløsningen er for lav 😴

#0 synd du fik så mange problemer, dog vil jeg gerne påpege igen at med så meget GPU kræft kan man ikke regne med en cpu der ikke render hurtigere kan føde dem nok 😉

og som nævnt før, opløsningen er for lav 😴

#5

#3 Hvorfor skal det være dell?

#6

God test, men igen. Det giver godt nok ikke meget, prøv med en nogle højere opløsninger, nu skal vi jo bare overhovedet være glad for han har ville bruge sin tid på at skrive den. 🙂

#7

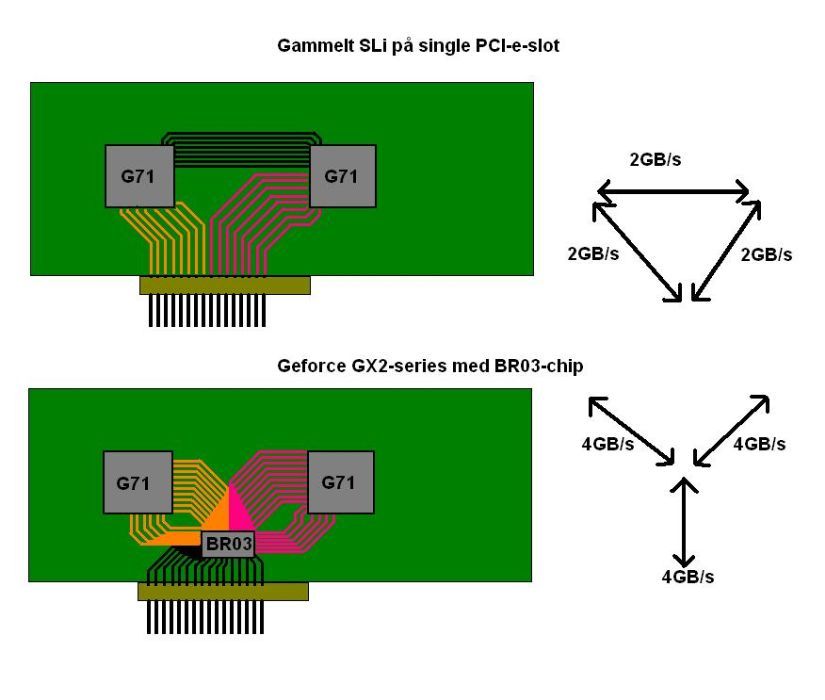

jeg syntes det er utroligt at nvidia intet har lært,de havde samme problemer med dengang man prøvede at sætte 2 stk 7950gx2 i sli

#8

Kan de kun 2 GB system RAM samt Windows Vista 32 bit (pga RAM) ikke være en flaskehals i systemet ?

#9

#1 - Systemet var som nævnt ret ustabilt, og i starten da computeren var overclocket ganske pænt troede jeg at det var grundet overclocket.. Så jeg returnerede til standard clocks hvor det faktisk kørte fint et lille stykke tid indtil den begyndte at crashe og agere sjovt igen. Af den grund valgte jeg at køre stock fordi jeg ville være sikker på at det ikke var pga clocket at den blev ustabil. Længere inde i test-processen kunne jeg dog godt se at det sandsynligvis ikkev ar CPUen der gjorde rod, men snarere en kombination af 790i chipsættet, Vista og quad-SLI driverne.

#2 - I XP kan man let teste i højere opløsninger end skærmen understøtter via et mindre system tweak, men så simpelt er det desværre ikke i Vista. Jeg har desværre kun adgang til en 1280x1024 skærm her og da jeg sagde ja til at teste systemet havde jeg desværre overset at man ikke kan benche i højere opløsninger end skærmen understøtter i Vista.

#8 - 2GB ram burde ikke være den begrænsende faktor når vi taler så relativt små opløsninger. Muligvis kan det godt begrænse en smule i Crysis, men jeg må indrømme at jeg faktisk ikke ved det.

#alle - Jeg må indrømme at jeg krummede lidt tæer da denne artikel skulle frigives, for selvom jeg har smidt meget mere blod, sved og tårer i denne test end jeg normalt gør er resultatet desværre ikke som jeg havde håbet. Jeg er glad for at "blot" kommer med forslag til hvordan artiklen kunne være bedre i stedet for at slagte mig for at lave en dårlig artikel 🙂

Jeg var over adskillige formateringer, installationer, forsøg på driverinstallationer og lignende og der var bare intet der lod til at virke. Selv hvis ydelsen havde været bedre så ville jeg nok ikke anbefale QuadSLI af den ene grund at det ganske enkelt ikke fungerer optimalt. Om det er chipsæt/vista komboen eller hvad skal jeg ikke sige, men der går i hvert fald lang tid før jeg nogensinde får et nVidia chipsæt samt Vista i mine maskiner igen 😉

#2 - I XP kan man let teste i højere opløsninger end skærmen understøtter via et mindre system tweak, men så simpelt er det desværre ikke i Vista. Jeg har desværre kun adgang til en 1280x1024 skærm her og da jeg sagde ja til at teste systemet havde jeg desværre overset at man ikke kan benche i højere opløsninger end skærmen understøtter i Vista.

#8 - 2GB ram burde ikke være den begrænsende faktor når vi taler så relativt små opløsninger. Muligvis kan det godt begrænse en smule i Crysis, men jeg må indrømme at jeg faktisk ikke ved det.

#alle - Jeg må indrømme at jeg krummede lidt tæer da denne artikel skulle frigives, for selvom jeg har smidt meget mere blod, sved og tårer i denne test end jeg normalt gør er resultatet desværre ikke som jeg havde håbet. Jeg er glad for at "blot" kommer med forslag til hvordan artiklen kunne være bedre i stedet for at slagte mig for at lave en dårlig artikel 🙂

Jeg var over adskillige formateringer, installationer, forsøg på driverinstallationer og lignende og der var bare intet der lod til at virke. Selv hvis ydelsen havde været bedre så ville jeg nok ikke anbefale QuadSLI af den ene grund at det ganske enkelt ikke fungerer optimalt. Om det er chipsæt/vista komboen eller hvad skal jeg ikke sige, men der går i hvert fald lang tid før jeg nogensinde får et nVidia chipsæt samt Vista i mine maskiner igen 😉

#10

Folkens i glemmer altså selve supporten Det er naivt at tro man kan smække flere kort sammen og så forvente den 4dobbelte ydelse. For at det skal kunne udnyttes skal det understøttes eller er det komplet ligemeget hvor meget power man end sidder inde med.

Spilproducenter mv. sætter ikke mange ressourcer i at optimere spil til Quad-SLi eller Triple-SLi da det er så lille en målgruppe der har de økonomiske midler til det. Nej de sparer pengene til andre optimeringer og rettelser. Som der nævnes kan vi bare se tilbage på 7950GX2 i Quad-SLi, det gav intet andet end en blær-effekt. Spilproducenterne yder simplethen ikke supporten i det omfang Quad-SLi kræver. Det eneste spil der ser ud til at drage nytte af Quad-SLi er Call of Duty 4.

Fokus er stadig på almindelig SLi som de fleste kan betale sig fra. Det er nøjagtigt som Dual vs Quad-core CPU'erne - der skal noget understøttelse til det før det dur.

Spilproducenter mv. sætter ikke mange ressourcer i at optimere spil til Quad-SLi eller Triple-SLi da det er så lille en målgruppe der har de økonomiske midler til det. Nej de sparer pengene til andre optimeringer og rettelser. Som der nævnes kan vi bare se tilbage på 7950GX2 i Quad-SLi, det gav intet andet end en blær-effekt. Spilproducenterne yder simplethen ikke supporten i det omfang Quad-SLi kræver. Det eneste spil der ser ud til at drage nytte af Quad-SLi er Call of Duty 4.

Fokus er stadig på almindelig SLi som de fleste kan betale sig fra. Det er nøjagtigt som Dual vs Quad-core CPU'erne - der skal noget understøttelse til det før det dur.

#11

#9 Det ville da ha været unfair at forsøge at tvære dig ud, når du tydeligvis har gjort en kæmpe indsats for at får det %&¤&&%# crap til at køre ordentligt. Vi har vel alle på et tidspunkt siddet og været tæt på at flå håret af os, når en pc spiller rigtig godt gammeldags dum, så mon ikke flertallet føler med dig i stedet 🤡

Jeg er med dig i din konklusion; at tiden ikke er moden til quad sli endnu. Man ser også en del der har købt sådan to størrelser sælge det ene, så de ikke videre imponerende resultater, er du næppe ene om at have opnået.

Mht opløsningen: Vidste faktisk ikke en gang at man ku lave det trick med xp, ups 😳

Jeg er med dig i din konklusion; at tiden ikke er moden til quad sli endnu. Man ser også en del der har købt sådan to størrelser sælge det ene, så de ikke videre imponerende resultater, er du næppe ene om at have opnået.

Mht opløsningen: Vidste faktisk ikke en gang at man ku lave det trick med xp, ups 😳

#12

#9

Ja din indsats har da været helt udover det sædvanlige her og det skal du have tak for!

Ja din indsats har da været helt udover det sædvanlige her og det skal du have tak for!