Test: Gigabyte GV-NX88S640H-RH

Grafikkort, NVIDIA d. 14. december. 2006, skrevet af red_martians 23 Kommentarer. Vist: 11381 gange.

Korrekturlæser:

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Gigabyte

DK distributør: Conta

Billed behandling:

Oversættelse:

Pristjek på http://www.pricerunner.dk

Produkt udlånt af: Gigabyte

DK distributør: Conta

#1

Lækker test, kunne godt være det blev mit næste gfx :P

Hvordan var temps under oc?

Hvordan var temps under oc?

#2

Ahhh... Det næste OC-vidunder er landet... Minder mig om de første Winchester CPUer og 5900XT, for ikke at forglemme 7900GT og Conroe :P

MVH.

Toke :)

MVH.

Toke :)

#3

#1: Tjekkede det ikke, men kortet var stabilt. :e

#4

Tak for en god test :)

Fedt overclock. Måske man skulle tage det her kort i stedet for GTX.

Fedt overclock. Måske man skulle tage det her kort i stedet for GTX.

#5

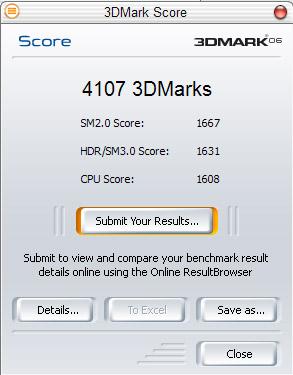

#4: det ligger som overclocket lige røven af GTX... Det må da siges at være gode 1500kr at spare... Men jeg garanterer virkelig ikke for kvaliteten af chipsne. Dette gigabyte viste utrolig gode OC-egenskaber. Andre chips er nok ikke så villige, men tror ikke det er et problem at runde 600Mhz med nogle af dem, og det er alligvel godt 15-20% som stadig er ganske flot

#6

hmm når det kommer ned på en 2800kr er det værd at overveje :p

#7

Cool 8) + er der er muligheder for lidt oc sjov, så man kan spare lidt penge:e

Og godt at se GX2 ikke er afsporet helt :i

Og godt at se GX2 ikke er afsporet helt :i

#8

#5

Ja det er da en fin besparelse. Plus det er sjovere at have et kort der er villigt til at lade sig oc. De GTX'er jeg har læst om har ikke kunnet det store der.

Håber der kommer flere tests af GTS :e

Ja det er da en fin besparelse. Plus det er sjovere at have et kort der er villigt til at lade sig oc. De GTX'er jeg har læst om har ikke kunnet det store der.

Håber der kommer flere tests af GTS :e

#9

God test, der også går i dybden 🙂

Men jeg undrede mig lidt over denne formulering:"I modsætning til 8800GTX, så vi virkelig nogle flotte OC-resultater her. Faktisk overclockede grafikkortet op til samme frekvenser som 8800GTX i overclocket tilstand. Et overclocket 8800GTS nåede næsten at ramme hastigheden som et 8800GTX-standard."

Da kortet bliver overclocket når det så GTX standard eller overclocket hastighed?

Men jeg undrede mig lidt over denne formulering:"I modsætning til 8800GTX, så vi virkelig nogle flotte OC-resultater her. Faktisk overclockede grafikkortet op til samme frekvenser som 8800GTX i overclocket tilstand. Et overclocket 8800GTS nåede næsten at ramme hastigheden som et 8800GTX-standard."

Da kortet bliver overclocket når det så GTX standard eller overclocket hastighed?

#10

#9 Det når et 8800GTX @ Stock , næsten ;)

#11

#9:

8800GTS i oc'et tilstand når samme frekvenser som det mest oc-venlige 8800GTX (ASUS) jeg har haft. Altså omkring 660Mhz på kernen.

GTS versionen er så godt 30% langsommere per Mhz end GTX, så trods den høje frekvens, yder det kun som et standard GTX ville gøre.

8800GTS i oc'et tilstand når samme frekvenser som det mest oc-venlige 8800GTX (ASUS) jeg har haft. Altså omkring 660Mhz på kernen.

GTS versionen er så godt 30% langsommere per Mhz end GTX, så trods den høje frekvens, yder det kun som et standard GTX ville gøre.

#12

#11 Det skyldes vel et lavere antal pipes?

Shake

Shake

#13

Ligesom der findes CoreTemp til at overvåge temperaturen på CPU'en, findes der tilsvarende programmer til at overvåge GPU'en?

Når man OC GPU'en, anvender man et program så vidt jeg har forstået. Betyder det så, at man i princippet først OC sit gfx, når man åbner Windows og starter programmet (eller indtil programmet starter op)? ?:(

Når man OC GPU'en, anvender man et program så vidt jeg har forstået. Betyder det så, at man i princippet først OC sit gfx, når man åbner Windows og starter programmet (eller indtil programmet starter op)? ?:(

#14

->#13

Du kan se temperaturen på GPU'en inde i driveren :)

<i>"Når man OC GPU'en, anvender man et program så vidt jeg har forstået. Betyder det så, at man i princippet først OC sit gfx, når man åbner Windows og starter programmet (eller indtil programmet starter op)?"</i>

Ja, grafikkortet bliver først overclocket, når programmet er loadet i windows. Sletter på programmet, er grafikkortet ikke længere overclocket.

Man kan også redigere en BIOS og flashe den over på grafikkortet - så er kortet altid overclocket :)

Du kan se temperaturen på GPU'en inde i driveren :)

<i>"Når man OC GPU'en, anvender man et program så vidt jeg har forstået. Betyder det så, at man i princippet først OC sit gfx, når man åbner Windows og starter programmet (eller indtil programmet starter op)?"</i>

Ja, grafikkortet bliver først overclocket, når programmet er loadet i windows. Sletter på programmet, er grafikkortet ikke længere overclocket.

Man kan også redigere en BIOS og flashe den over på grafikkortet - så er kortet altid overclocket :)

#15

I driveren til grafikkortet? mht. temperaturen?

I den forbindelse har jeg læst mig frem til at det bundkort som jeg skal sidde og lege med (GA-965P-DS4), har mulighed for at øge hastighede på PCIe porten. Er det en dårlig ide at gøre det på den måde? Så i stedet for at sætte den på fx 100 mhz, hæver jeg den til 110 mhz?

I den forbindelse har jeg læst mig frem til at det bundkort som jeg skal sidde og lege med (GA-965P-DS4), har mulighed for at øge hastighede på PCIe porten. Er det en dårlig ide at gøre det på den måde? Så i stedet for at sætte den på fx 100 mhz, hæver jeg den til 110 mhz?

#16

Det er nok bedst, hvis du laver en tråd til dine spørgsmål, da denne tråd kun har til formål at kommentere artiklen :)

Mht PCI-Express frekvensen, får du i bund og grund ingenting ud af at hæve den - udover at det kan medføre ustabilitet.

Men lav en seperat tråd, så skal du nok få masser af svar ;)

Mht PCI-Express frekvensen, får du i bund og grund ingenting ud af at hæve den - udover at det kan medføre ustabilitet.

Men lav en seperat tråd, så skal du nok få masser af svar ;)

#14 tror næppe du kan se cpu'en iden i driveren ;)

lækker test, men kan 8800GTS overhovedet være inde i et almideligt kabinet f.eks mit kabinet?

lækker test, men kan 8800GTS overhovedet være inde i et almideligt kabinet f.eks mit kabinet?

#19

#18: det er jeg ret sikker på.. det kort har en den længde som de fleste ældre nvidia-kort og nyere ATi-kort.. Det er også kortere end et almindeligt bundkort.

#20

->#18

CPU/GPU..du ved hvad jeg mener :00..

AFAIK er 8800GTS lige så langt som geforce6800..altså 22CM. Så frem med tommestokken sømand ;)

Har ikke umiddelbart hørt om kabinettet, der ikke er dybe nok til det..

CPU/GPU..du ved hvad jeg mener :00..

AFAIK er 8800GTS lige så langt som geforce6800..altså 22CM. Så frem med tommestokken sømand ;)

Har ikke umiddelbart hørt om kabinettet, der ikke er dybe nok til det..

#21

Hej.. Jeg har selv lige bestilt sådan en satan her :e ..

Men kunne godt tænke mig og vide om den fantastiske OC test blev lavet med std. køler, eller om der er blevet brugt anden køling til testen :00

/NiKzEr/

Men kunne godt tænke mig og vide om den fantastiske OC test blev lavet med std. køler, eller om der er blevet brugt anden køling til testen :00

/NiKzEr/

#22

STock køler. altid stock køler!! De skal jo teste produkted som det er orginalt.. ;)

#23

Super heh :e .. Mit 8800GTS skulle komme først i næste uge (om et par dage), men mangler resten af mine dele :( De kommer først fredag (Hvis jeg er heldig)

Mit kommende system :p

CPU: C2D 1.86 Ghz

CPU Køler: Zalman 9500-LED

NEC DVD brænder

RAM: 2*1GB Corsair XMS PC-6400CL5

MoBo: Gigabyte DS3

GFX: Gigabyte 8800GTS

HDD: 320GB Hitachi SATAII + min "lagerdisk" på 250GB

PSU: 450W OCZ

Kabinet: Antec Nine Hundred

Mit kommende system :p

CPU: C2D 1.86 Ghz

CPU Køler: Zalman 9500-LED

NEC DVD brænder

RAM: 2*1GB Corsair XMS PC-6400CL5

MoBo: Gigabyte DS3

GFX: Gigabyte 8800GTS

HDD: 320GB Hitachi SATAII + min "lagerdisk" på 250GB

PSU: 450W OCZ

Kabinet: Antec Nine Hundred